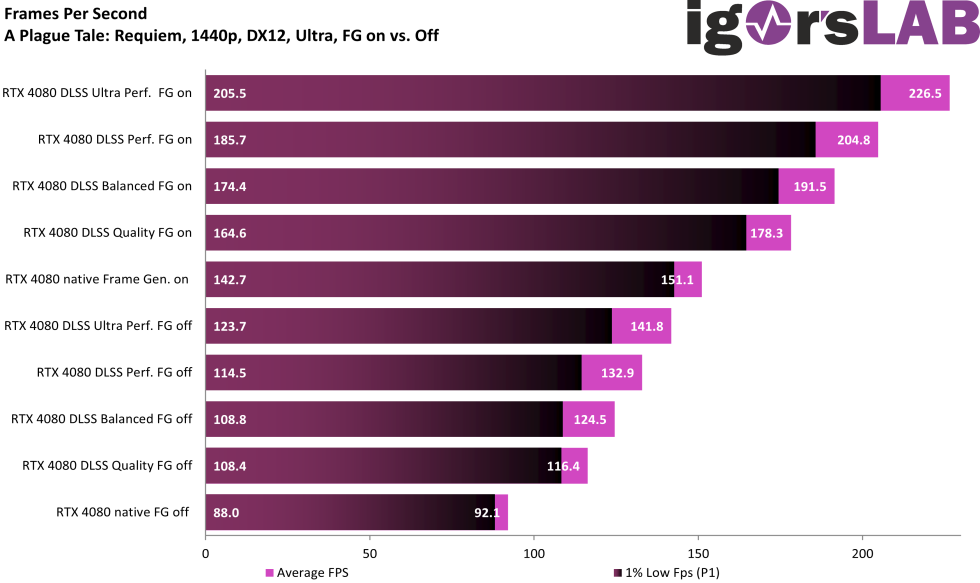

Average FPS

Das Spiel hat mich echt überrascht, denn bisher ist auch in 1440p – kein CPU-Flaschenhals zu finden. Wir müssen tatsächlich in 1080p testen. Eine Mehrleistung durch DLSS 3.0 FG um den Faktor 2,4. Nicht schlecht…

Frame Times, Varianzen und Percentile

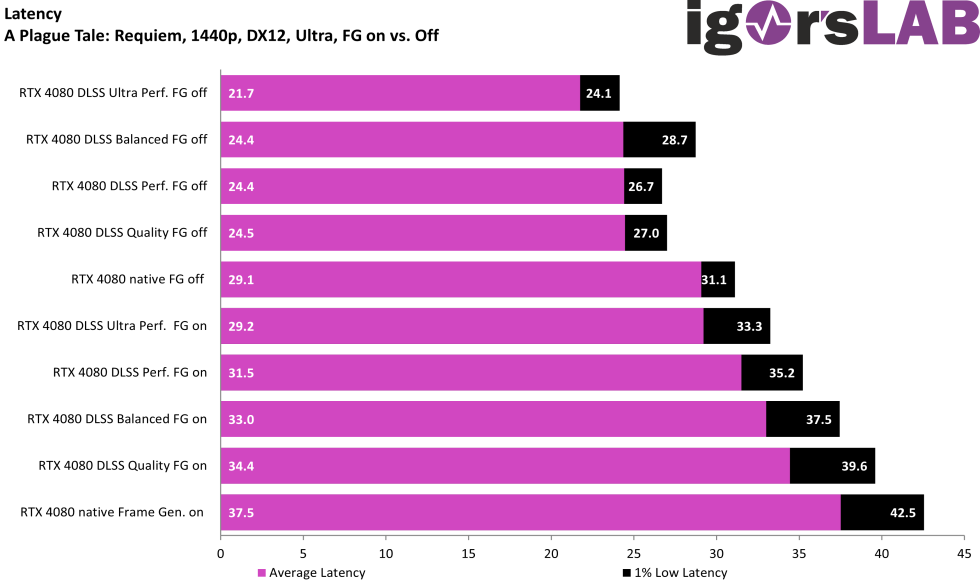

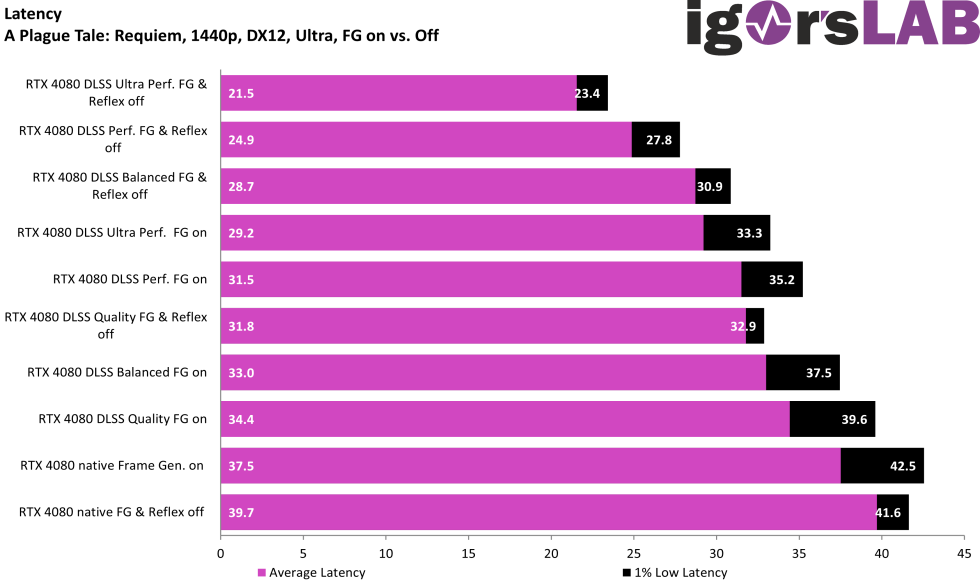

Latenzen

Eine Sache wollte ich euch grafisch dann doch zeigen. Auch DLSS hat so seine Probleme, es ist nicht alles Holz – was glänzt…

DLSS Performance @ 1440p

DLSS Ultra Performance @ 1440p

Ab der Stufe Ultra Performance, ist auch DLSS in fast keinem Spiel mehr empfehlenswert. Dieser Modus dient vermutlich nur dem Zweck, am Ende möglichst den längsten Balken zu haben. Aus meiner Sicht völlig sinnbefreit, da man so eh nicht spielen kann und will. Das sieht auch in UHD scheiße aus und in 1080p – lassen wir es lieber… An die Damen und Herren von NVIDIA: Einen unbrauchbaren DLSS-Modus sollte es aus meiner Sicht gar nicht erst geben. Meine Meinung: entweder brauchbar machen – oder weglassen!

Grüße gehen an der Stelle auch an AMD: der Modus FSR 2.1 Ultra Performance (z.B. in Cyberpunk oder Spider-Man) sieht auch so bescheiden aus. Auch hier gilt: besser machen – oder weglassen!

- 1 - Einführung und Testsystem

- 2 - Cyberpunk 2077 @ 2160p

- 3 - Cyberpunk 2077 @ 1440p

- 4 - Cyberpunk 2077 @ 1080p

- 5 - A Plague Tale: Requiem @ 2160p

- 6 - A Plague Tale: Requiem @ 1440p

- 7 - A Plague Tale: Requiem @ 1080p

- 8 - Bright Memory: Infinite @ 2160p

- 9 - Bright Memory: Infinite @ 1440p

- 10 - Bright Memory: Infinite @ 1080p

- 11 - Spider-Man Remastered @ 2160p

- 12 - Spider-Man Remastered @ 1440p

- 13 - Spider-Man Remastered DLSS vs. FSR vs. XeSS

- 14 - Zusammenfassung und Fazit

87 Antworten

Kommentar

Lade neue Kommentare

Mitglied

Mitglied

1

Moderator

Urgestein

Veteran

Urgestein

Veteran

Moderator

Veteran

Moderator

Veteran

Veteran

Mitglied

Veteran

Veteran

Alle Kommentare lesen unter igor´sLAB Community →