Blender mit verschiedenen Workloads

Blender ist eine leistungsstarke Open-Source-Software für 3D-Grafik, Animation, Rendering, Postproduktion, interaktive Erstellung und Wiedergabe. Es ermöglicht Benutzern das Erstellen, Bearbeiten und Rendern von 3D-Modellen und Animationen. Zusätzlich zu diesen 3D-Funktionen enthält Blender auch Werkzeuge für Videobearbeitung, Skulptur, UV-Mapping, Texturierung, Rigging, Partikel-Systeme, Physik- und Flüssigkeitssimulationen sowie Spielentwicklung. Wegen seiner umfangreichen Funktionspalette und da es kostenfrei ist, wird Blender sowohl von Amateuren als auch von Profis in der gesamten Medien- und Unterhaltungsindustrie genutzt. Doch ich muss vorab noch etwas zu CUDA, OptiX und HIP schreiben, um die Vergleiche besser einordnen zu können. Denn CUDA, OptiX und HIP sind Technologien, die speziell für den Bereich des parallelen und High-Performance-Computing (HPC) entwickelt wurden. Jede dieser Technologien hat ihre eigenen Vorteile, Zielanwendungen und zugrundeliegenden Technologien.

CUDA (Compute Unified Device Architecture) wird von NVIDIA entwickelt und unterstützt. Es ist eine parallele Computing-Plattform und Programmierschnittstelle, die den Entwicklern direkten Zugriff auf die virtuelle Maschine von NVIDIA-GPUs ermöglicht. Mit CUDA geschriebene Anwendungen können von der massiven parallelen Rechenleistung moderner GPUs profitieren, um performanceintensive Anwendungen zu beschleunigen.

OptiX stammt ebenfalls von NVIDIA und ist eine Raytracing-Engine, die für das Erstellen von Bildern durch das Verfolgen von Strahlen entwickelt wurde. Sie wird häufig für visuelle Anwendungen wie Rendering, wissenschaftliche Simulation und Spiele verwendet. OptiX betet spezialisierte Funktionen für das Raytracing und ermöglicht die Kombination von Raytracing mit traditionellen Rastermethoden in Echtzeit-Grafik-Anwendungen.

HIP (Heterogeneous-compute Interface for Portability) wurde von AMD initiiert und entwickelt. Sowohl NVIDIA-GPUs (über eine Kompatibilitätsschicht) als auch AMD-GPUs können angesprochen werden, jedoch ist HIP in Blender AMD-exklusiv. HIP ermöglicht es den Entwicklern, portablen GPU-Code zu schreiben, der sowohl auf NVIDIA als auch auf AMD-GPUs ausgeführt werden kann. Es wurde entwickelt, um eine Alternative zu CUDA für diejenigen zu bieten, die plattformübergreifende Portabilität benötigen. Denn HIP-Code kann in CUDA umgewandelt werden, wodurch Entwickler, die bereits in CUDA geschrieben haben, ihre Anwendungen leichter auf AMD-GPUs portieren können.

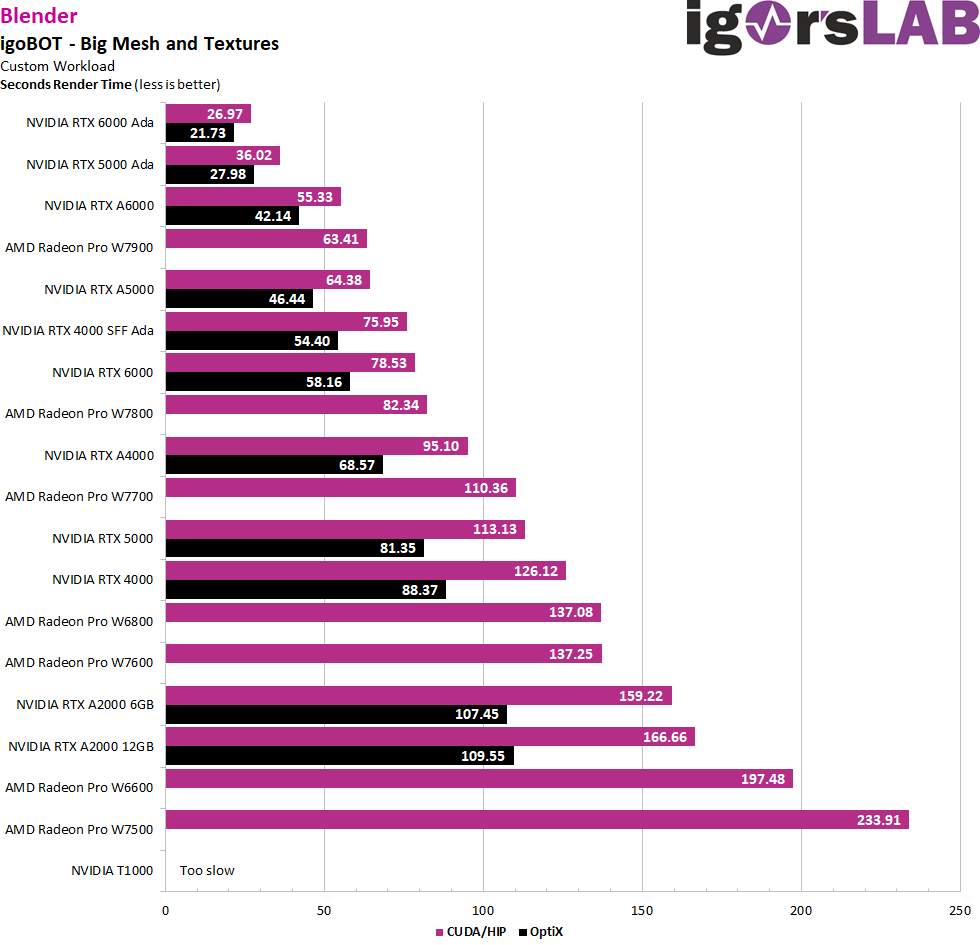

Das erste Modell ist mein altbekannter igoBOT, den man ja auch aus den YouTube-Videos und diversen Animationen kennt. Es ist zwar ein recht komplexes Mesh, aber die Szene ist eher simpel und auch die Texturen sind einfach gehalten. Spezielle Filter nutzt das Projekt ebenfalls nicht, so dass man hier die Karten als reine Number-Cruncher messen kann. Aber auch so etwas hat seinen Charme.

Die NVIDIA-Karten nutzen sowohl CUDA als auch OptiX, bei den AMD-Karten kommt HIP zum Einsatz. Man sieht, AMD hat durch den Umstieg von OpenCL zu HIP einen gewaltigen Leistungssprung hinlegen können! Allerdings liegt OptiX noch unereichbar vorn. Aber zu CUDA dürfte man bereits mehr als aufgeschlossen haben.

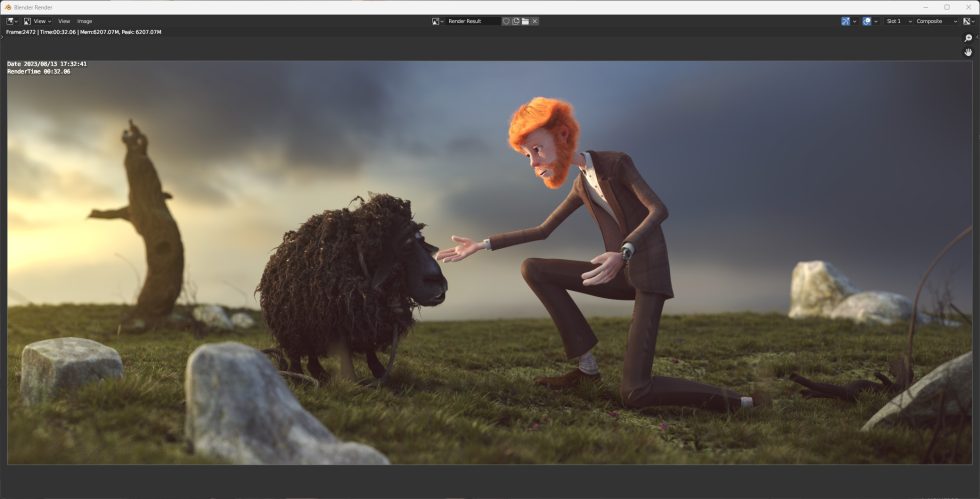

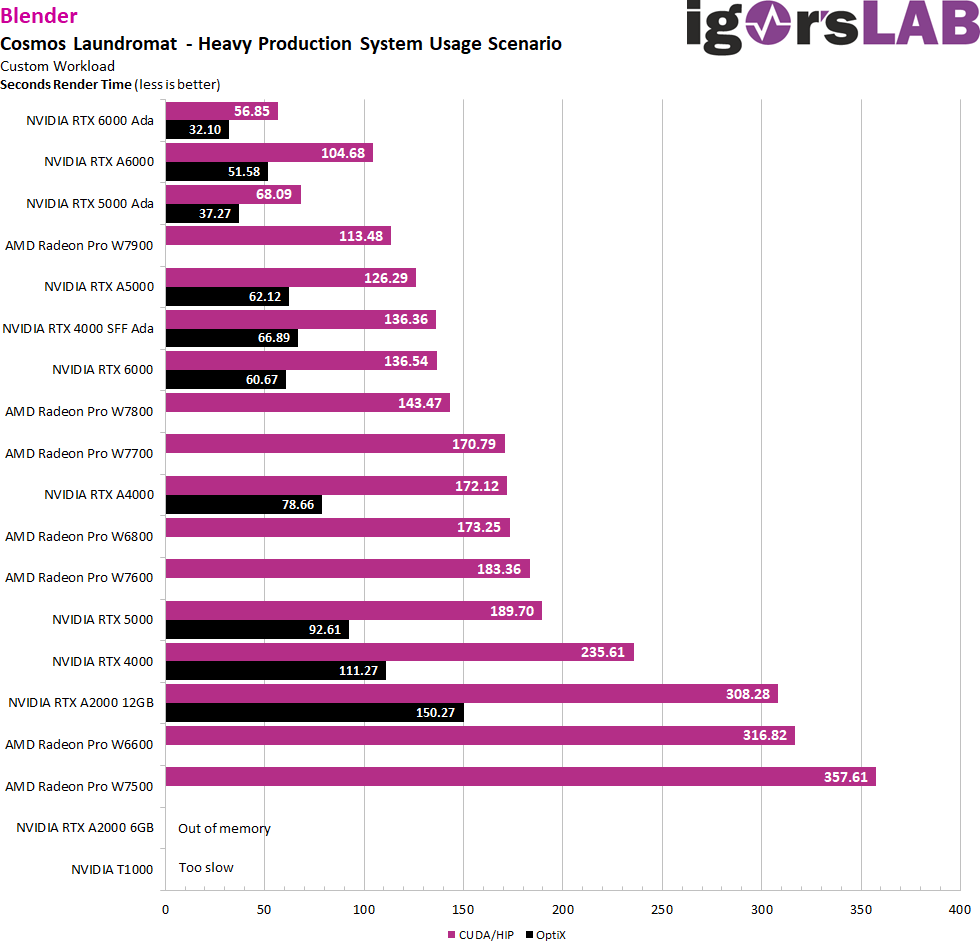

Doch wie sieht es aus, wenn man eine komplexere Aufgabe rendern möchte? Dieser Workload aus dem „Cosmos Laundromat“ nutzt die neuesten Algorithmen und Verbesserungen von Blender, um das volle Leistungspotenzial in einem Produktionssystem-Einsatzszenario zu messen. „Cosmos Laundromat“ ist nicht nur ein beeindruckendes Beispiel für die Fähigkeiten von Open-Source-Software im Bereich der 3D-Animation, sondern dient auch als Benchmark, um die Effizienz und Leistung von Hardware und Software in professionellen Produktionsumgebungen zu testen.

Die Algorithmen und Werkzeuge, die in Blender implementiert werden, sind ständig im Wandel und werden ständig verbessert, um den Anforderungen von Künstlern und Entwicklern gerecht zu werden. Mit solchen Dateien kann die Industrie die Performance ihrer Systeme in realen Produktionsbedingungen überprüfen und so sicherstellen, dass sie den ständig steigenden Anforderungen des 3D-Renderings und der Animation gewachsen sind. Während die RTX A2000 6GB am zu geringen Speicherausbau scheitert, ist die T1000 für diese Aufgabe schlicht zu langsam.

GPU Compute mit synthetischen Tests

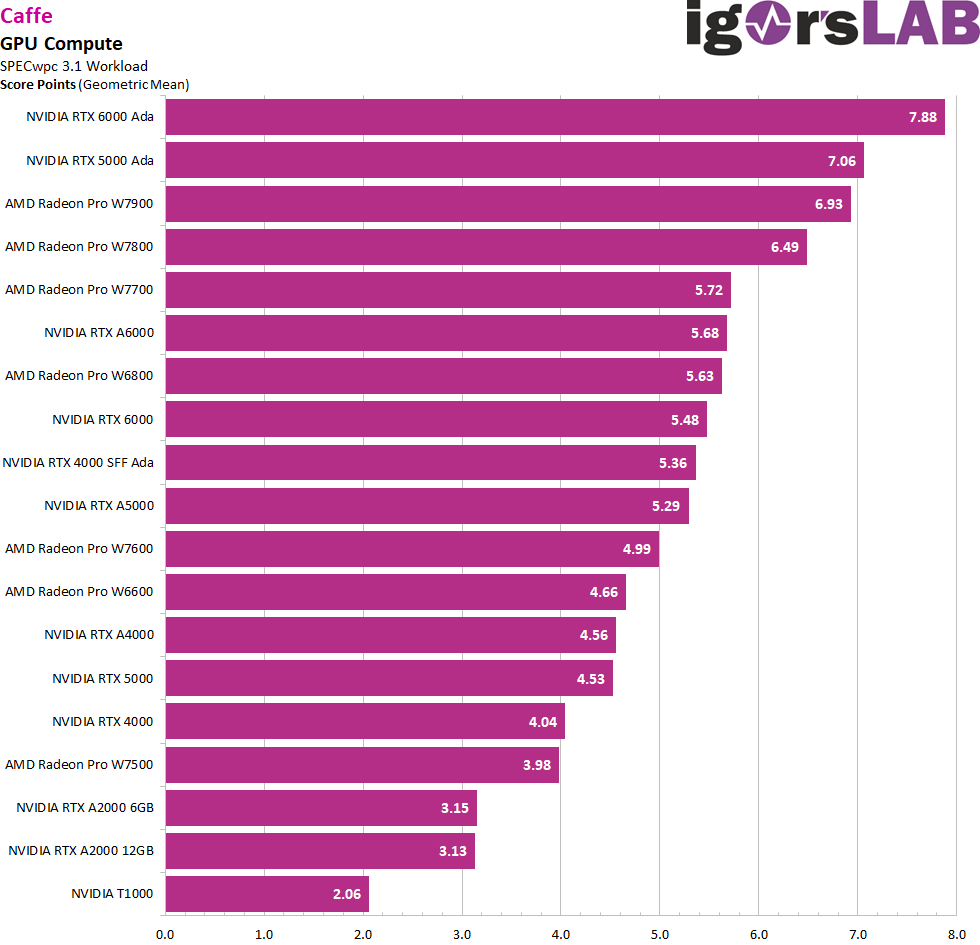

Ganz zum Schluss packe ich dann doch noch zwei der synthetischen Langweiler aus, aber irgendwie gehört es ja doch mit dazu. Caffe ist eine Open-Source-Deep-Learning-Bibliothek, die ursprünglich von Yangqing Jia an der UC Berkeley entwickelt wurde und später von der Berkeley Vision and Learning Center (BVLC) unterstützt wurde. Caffe ist besonders bekannt für seine Leistung bei Computer-Vision-Aufgaben, insbesondere bei der Arbeit mit Convolutional Neural Networks (CNNs).

Das Framework bietet auch Python- und MATLAB-Bindungen, die es den Benutzern erleichtern, mit ihren Modellen zu arbeiten. Obwohl es einst für seine Einfachheit und Geschwindigkeit bekannt war, haben andere neuere Deep-Learning-Frameworks wie TensorFlow und PyTorch in der Beliebtheit zugenommen, bieten jedoch flexiblere Optionen für eine breitere Palette von Deep-Learning-Aufgaben. Dennoch bleibt Caffe ein wichtiges Tool in der Deep-Learning-Community.

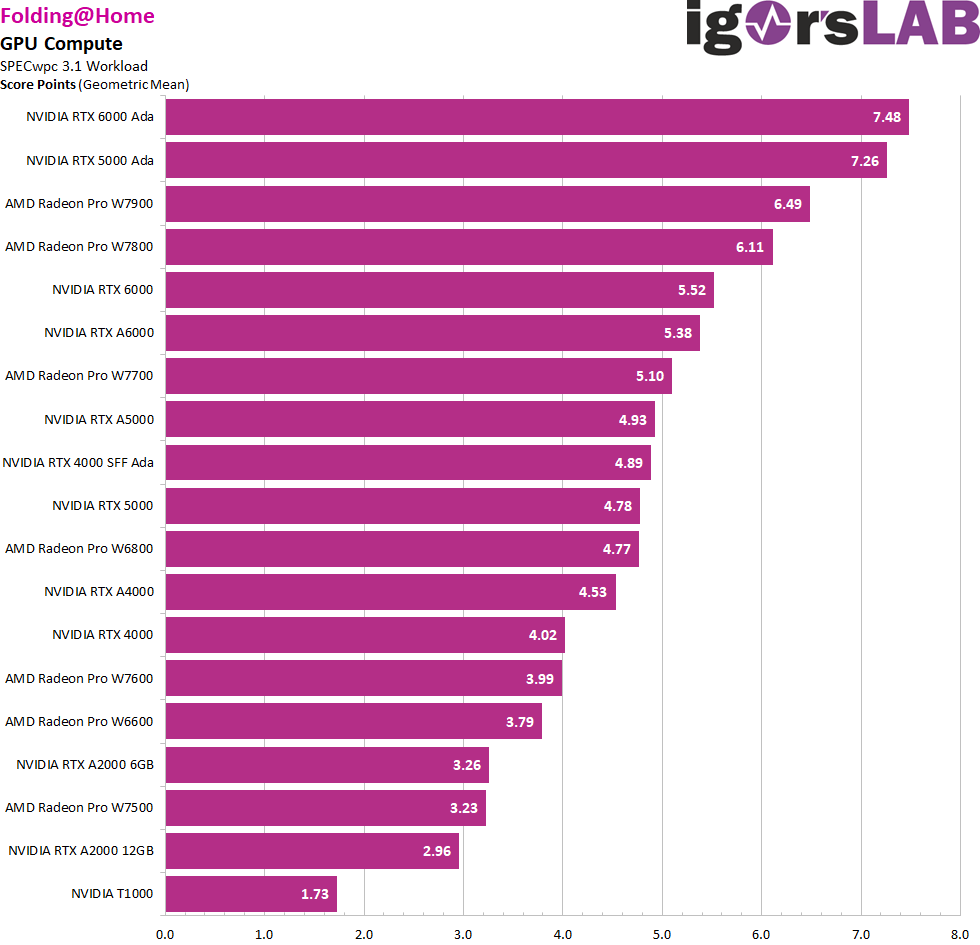

FAH, oder Folding@home, ist ein verteiltes Rechenprojekt, das darauf abzielt, Proteinfaltungsprozesse zu simulieren. Diese Simulationen sind wichtig, um das Verständnis von vielen biologischen Prozessen und Krankheiten zu vertiefen. Das Besondere an Folding@home ist, dass es die ungenutzte Rechenleistung von Computern von Freiwilligen aus der ganzen Welt nutzt. Indem Einzelpersonen die Software auf ihren Computern installieren, können sie dazu beitragen, komplexe wissenschaftliche Simulationen durchzuführen. Dieser gemeinschaftliche Ansatz ermöglicht es Folding@home, Rechenleistungen zu erreichen, die mit einigen der leistungsstärksten Supercomputer der Welt vergleichbar sind. Es wurde ursprünglich an der Stanford University entwickelt und hat sich im Laufe der Jahre zu einem bedeutenden Werkzeug für die biomedizinische Forschung entwickelt, insbesondere in Bereichen wie Alzheimer, Huntington oder verschiedenen Krebsformen.

Wir können anhand beider Anwendungen sehen, dass AMD auch hier Boden gut gemacht hat, auch wenn die RTX 6000 Ada das Maß aller Dinge ist.

- 1 - Einführung, Testsystem und Software

- 2 - Autodesk AutoCAD 2024

- 3 - Autodesk Inventor Pro 2021

- 4 - PTC Creo 9 - No FSAA vs. FSAA

- 5 - Dassault Systèmes Solidworks 2022 - No FSAA vs. FSAA

- 6 - SPECviewperf 2020

- 7 - Adobe CC: Photoshop

- 8 - Adobe CC: Premiere Pro

- 9 - Adobe CC: After Effects

- 10 - Rendering und GPU-Compute

- 11 - Leistungsaufnahme und Fazit

57 Antworten

Kommentar

Lade neue Kommentare

Mitglied

Mitglied

1

1

Urgestein

Mitglied

Veteran

Urgestein

Urgestein

1

Veteran

1

Mitglied

Mitglied

Neuling

Veteran

Mitglied

1

Neuling

Alle Kommentare lesen unter igor´sLAB Community →