Was sind Mikroruckler?

Erinnern wir uns kurz zurück, wie die einzelnen aufeinanderfolgenden Frames entstehen. Da die von uns angestrebte Konstanz in der Praxis nicht zu erreichen ist und man auch keine 30 Frames auf Vorrat als Puffer vorab rendern kann, wird im Allgemeinen das nachfolgende Szenario wohl am Ehesten auftreten:

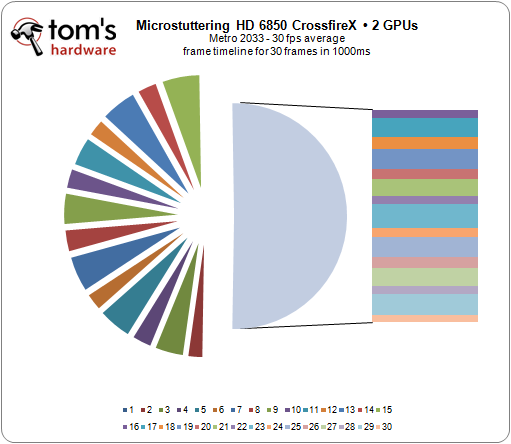

Wir sehen hier den Ausschnitt aus einer Sekunde Metro 2033 und der Arbeit zweier Radeon HD 6850, die uns deswegen als geeignet erschienen, weil wir uns exakt im Fenster um die 30 Frames pro Sekunde bewegen konnten, bei denen die Mikroruckler, wenn sie denn auftreten, angeblich am störendsten empfunden werden. Was uns bei der Betrachtung des Diagramms zuerst auffällt, ist die sehr ungleiche Länge in ms, die für die Erstellung der einzelnen Frames benötigt wird.

Im Diagramm sind alle 30 Teilbilder der dokumentierten Sekunde erfasst. Wir sehen in der Abfolge vor allem die Verzögerung einiger Frames, die als Stocken wahrgenommen werden. Da hilft es dann auch nichts, wenn der der nächste Frame dann alles zeitlich wieder aufholt. Man kann es mit einem stotternden Motor vergleichen. Man kann mit diesem genauso gut z.B. 30 km/h fahren, wie mit einem funktionierenden. Nur das man ordentlich durchgeschüttelt wird.

Wann nimmt man Mikroruckler wahr?

Kurz und knackig: immer. Je niedriger die mittlere Framrate liegt, um so mehr nimmt man durch die Ruckler den tatsächlichen Durchnittswert als gefühlt niedrigere Framerate wahr. So wirkt eine Framerate mit 30 fps mit etwas Pech schnell einmal wie nur eine mit 20-25 fps. Die jeweilgen Unterschiede in den Erstellungszeiten für die Frames nimmt ein geübtes Auge jedoch auch bei Frameraten jenseits der 60 fps noch deutlich wahr. Dies ist auch einer der Gründe, warum wir in den nachfolgenden Tests zur GPU-Skalierung einen Test mit hohen Frameraten vorziehen. Denn es ist geradezu erstaunlich, wie sich auch oberhalb der gern zitierten zitierten Grenze von ca. 40 fps das Grauen breit machen kann, wenn die Renderei einmal aus dem Takt kommt.

- 1 - Einführung und Übersicht

- 2 - Wir funktionieren Crossfire und SLI?

- 3 - Mikroruckler - so klein und doch so ärgerlich

- 4 - Stufe 1: CrossfireX mit 2 GPUs

- 5 - Stufe 1: CrossfireX mit 2 GPUs versus SLI

- 6 - Stufe 2: CrossfireX mit 3 GPUs

- 7 - Stufe 3: CrossfireX mit 4 GPUs versus SLI

- 8 - Testsystem und Benchmarkauswahl

- 9 - Benchmarks: 3DMark11 und Sanctuary

- 10 - Benchmarks: DirectX 11 Spiele

- 11 - Benchmarks: DirectX 10 Spiele

- 12 - Benchmarks: DirectX 9 Spiele

- 13 - Leistungsindex und Leistungsaufnahme

- 14 - Zusammenfassung und Fazit

9 Antworten

Kommentar

Lade neue Kommentare

Mitglied

Urgestein

Veteran

Urgestein

Urgestein

Mitglied

Veteran

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →