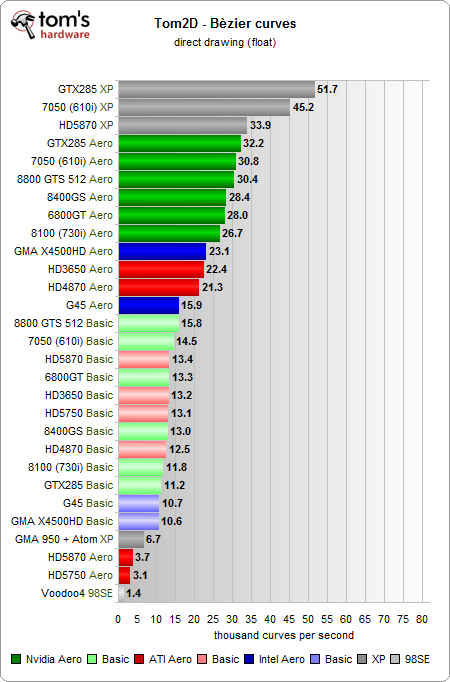

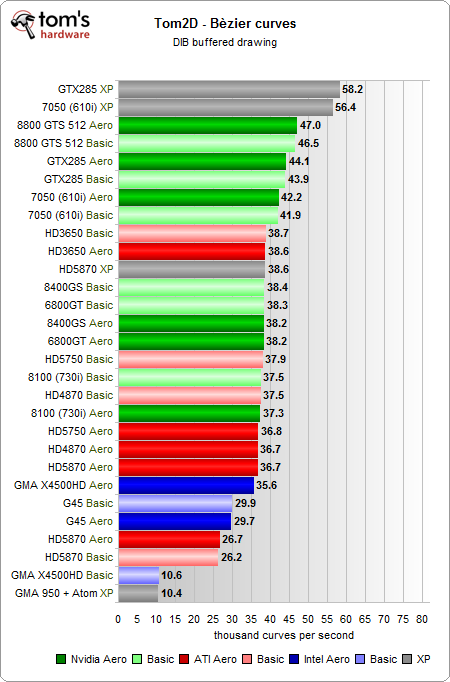

Nun testen wir die Ausgabe von Bézier-Kurven. Hier gab es bei den Tests im ersten Teil des Artikels ebenfalls sichtbare Differenzen. Bitte lesen Sie, wie bei den Linien, unbedingt unser Fazit zu diesem Test, denn die Probleme die im ersten Teil geschildert wurden, konnten mittlerweile ebenfalls auf über 40 Systemen unserer Tester und Leser im Vorab reproduziert werden.

Inhalt des Tests

Es werden insgesamt 100.000 Kurven zufälliger Länge, Beugung und Farbe an einer zufälligen Position gerendert. Der Initialwert für den Zufallsgenerator ist stets identisch, so dass alle Testläufe immer den gleichen Inhalt abbilden. Alle Objekte befinden sich innerhalb der Zeichenfläche, so dass kein Clipping benötigt wird.

Verwendete GDI-Funktionen

für den reinen Kurven-Benchmark:

- CreatePen

- PolyBezier

- SelectObject

- DeleteObject

zusätzlich für DIB-Puffer (Test mit Pufferung):

- CreateCompatibleDC

- CreateDIBSection

- CreateSolidBrush

- Rectangle

- BitBlt

Direktes Zeichnen ohne Puffer

Zeichnen mittels Puffer

Fazit

Im direkten Zeichnen ergibt sich das gleiche Bild wie bei den Linien. Das Paradox mit den Performanceschüben nach dem Öffnen eines Fensters konnte ebenfalls reproduziert werden. Die Intel-IGP agieren teilweise unter dem Durchschnitt, der Atom-Prozessor ist mit der Kurvenberechnung schlicht überfordert.

- 1 - Einführung: Die Relevanz der 2D-Grafikausgabe über das GDI

- 2 - Das 2D-GDI und dessen Grafikausgabe von XP bis Windows 7 im Detail

- 3 - 2D-Grafikausgabe über das GDI: direkt oder gepuffert?

- 4 - Die Symptome der HD 5xxx-Serie und deren Relevanz unter Windows 7

- 5 - Tom2D: Unser einfacher 2D-GDI-Benchmark

- 6 - Tom2D: Textausgabe

- 7 - Tom2D: Linien

- 8 - Tom2D: Kurven

- 9 - Tom2D: Polygone

- 10 - Tom2D: Rechtecke

- 11 - Tom2D: Ellipsen

- 12 - Tom2D: Blitting

- 13 - Tom2D: Stretching

- 14 - Fazit

16 Antworten

Kommentar

Lade neue Kommentare

Mitglied

Veteran

Urgestein

1

Urgestein

1

Urgestein

Urgestein

Urgestein

Urgestein

Mitglied

Urgestein

1

Urgestein

Mitglied

1

Alle Kommentare lesen unter igor´sLAB Community →