Lieber spät als nie, oder wie war das? Ja, leider bin ich spät dran mit dem heutigen Thema, denn der Start von AMDs FSR 2.0 war bereits am 12.05.2022. Zu diesem Zeitpunkt war ich beruflich im Ausland unterwegs und konnte somit keine Tests machen. Vermutlich haben sich viele von euch bereits auf diversen YouTube Kanälen oder anderen Seiten mit dem Thema beschäftigt. Auch ich habe mir das natürlich angeschaut, was die anderen Kollegen so getestet haben. Manche Informationen werden also heute nicht neu sein, andere aber schon!

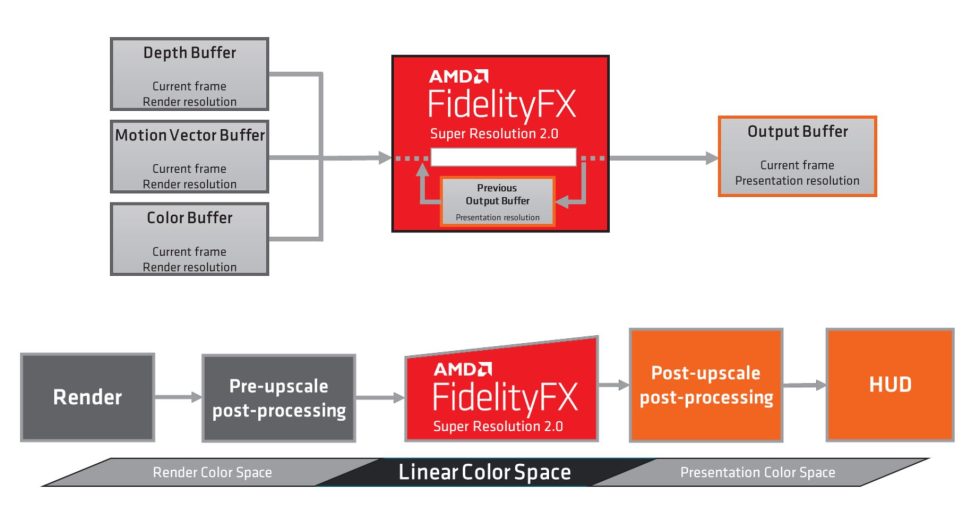

Was ich heute bewusst weglassen werde, ist die Erklär-Stunde wie FSR 2.0 im Detail funktioniert. Der wesentliche Unterschied zu FSR 1.0 ist, dass es sich um temporales Upscaling handelt. Somit können, ganz kurz und sehr vereinfacht gesagt, mehr Informationen über Bewegungsvektoren, künftige und bereits vergangener Pixel gewonnen werden. Gepaart mit AMD eigenem Anti-Aliasing und mittels Algorithmus auf dem Monitor gezaubert – soll es zu deutlich qualitativerem Upscaling führen als das noch mit FSR 1.0 der Fall war. AMD will damit die Lücke zu NVIDIAs DLSS schließen.

Bevor wir uns mit der Qualität von FSR 2.0 im Vergleich zu DLSS 2.3 sowie FSR 1.0 beschäftigen können, schauen wir uns heute nur die reinen Leistungssteigerungen an, die man mit den genannten Techniken erreichen kann. Dazu habe ich 3 verschiedene Grafikkarten und 3 verschiedene Auflösungen für euch getestet. Mehr war in der Kürze der Zeit nicht drin! Warum wir heute nur die Performance sehen, ist auch der Zeit geschuldet. Denn um die wirklichen Unterschiede zwischen DLSS 2.3 und FSR 2.0 zu sehen, muss man sich Zeit lassen. AMD hat gut aufgeholt, soviel kann ich euch sagen! Ich bitte um etwas Geduld und Verständnis, denn einfach nur hinschludern ist nicht mein Ding! Siehe meinen letzten Artikel zum Thema NIS vs. RSR – klick hier. Wenn, dann richtig!

Vorab mein Testsystem und ja, ich nutze noch immer Windows 10!

| CPU | Ryzen 7 5800X (PBO 2, CO negativ) |

| Mainboard | MSI MAG X570 ACE |

| RAM | 4×8 GB Crucial Ballistix RGB 3600 MHz CL16-17-16-36 (OC) |

| SSD 1 | Samsung 980 Pro 500 GB (System) |

| SSD 2 | Crucial P2 1000 GB (Spiele) |

| SSD 3 | Crucial P2 1000 GB (Spiele) |

| SSD 4 | Samsung 512 GB 840 Pro (Backup) |

| CPU Kühler | Aphpacool Eisbaear Aurora 360 |

| Netzteil | Seasonic Prime Platinum 1300 Watt |

| GPUs |

MSI GeForce RTX 3080 Ti Suprim X – wassergekühlt Eisblock GPX Aurora (GeForce Driver 512.77) MSI Radeon RX 6700 XT Gaming X (Radeon Driver 22.5.1) MSI GeForce RTX 3060 Ti Gaming X Trio (GeForce Driver 512.77) |

| Sound | SoundblasterX AE-5 Plus |

| Tastatur | Cooler Master SK 622 (Red Taster) via USB @1000 Hz Polling Rate |

| Maus | ASUS ROG Chakram Core @1000 Hz Polling Rate (NVIDIA Reflex Latency Analyzer Support) |

| Monitor 1 | ASUS ROG Swift PG279QM @240 Hz via DP (Nvidia G-SYNC mit Reflex Latency Analyzer) |

| Monitor 2 |

LG 27GN950-B @144 Hz via DP (AMD FreeSync Premium, G-SYNC Kompatibel) |

Alle Tests liefen auf dem LG 27GN950, was zum Ende hin als ich in 1080p getestet habe, schon fast an Körperverletzung meiner Augen grenzte. Denn 1080p auf einen UHD Monitor ist NICHT das Gleiche wie auf einem nativen 1080p Panel. Hinzu kam, dass man FSR 1.0 in der Performancestufe beim Upscalen auf 1080p nur schwer ertragen kann! Da muss man leider durch. Wenn das Thema FSR 1.0 interessiert, dazu hatte ich bereits ein Artikel: Klick hier!

Ihr wollt noch mehr zum Thema FSR/RSR/NIS/DLSS? Weiterführende Artikel findet ihr auf der Webseite: Unter der Suchfunktion – einfach das Schlagwort eingeben!

Ein Thema noch, solltet ihr im weiteren Verlauf 4K statt UHD lesen, dann bitte nicht kleinlich werden. Ich nutze 4K synonym für UHD! Mir ist bewusst, dass 4K und UHD im Grunde weder das Gleiche und schon gar nicht Dasselbe ist. Dann legen wir mal los…

30 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Urgestein

Urgestein

Urgestein

Moderator

Moderator

Veteran

Moderator

Veteran

Moderator

Urgestein

Veteran

Moderator

Veteran

Moderator

Urgestein

Moderator

Urgestein

Moderator

Alle Kommentare lesen unter igor´sLAB Community →