Intel in schnell UND sparsam? Ja, seit der 12. Generation, also Alder Lake S, passt auch das wieder zusammen. Und so wird der heutige Text faktisch zum Narrativ für eine Art Trendwende, zu der man Intel eigentlich nur gratulieren kann, wenn man es objektiv testet und alles richtig einordnet. Da dies mit einigen technischen Hürden verbunden war, werde ich auch nicht umhin können, ein etwas längeres Vorwort voranzustellen. Das wird helfen, das heute Präsentierte auch richtig einordnen zu können. Denn oft genug ist es nicht nur die Länge der zuerst betrachteten FPS-Balken, welche über die Qualität und Akzeptanz eines neuen Produktes entscheidet, sondern es sind die vielen Details in der Summe, die den eigentlichen Mehrwert bilden.

Wichtiges Vorwort und Vorschau auf die Follow-Ups

Wenn wir ehrlich sind, dann haben wir aktuell beim Gaming einen Stand erreicht, wo die CPU fast immer von der Grafikkarte limitiert wird. Das betrifft die Schnell-Klicker mit ihren 240-Hz-Monitoren genauso, wie eher entspannte Gamer im Ultra-HD-Bereich (z.B. mich), die ja schon froh sind, wenn sich ihr teurer 120-Hz-Monitor zumindest ansatzweise rechnet. Und dann kommt Intel mit einer neuen CPU, die alles (noch) besser machen soll? Sicher, es gibt E-Sports Titel, die es wirklich noch fertig bringen, auch eine CPU an die Grenzen des Machbaren zu treiben, nur wird genau diese Zielgruppe meist keine vielkernigen High-End-Boliden bei der CPU nutzen. Denn ich möchte schon gern den sehen, der noch einen Unterschied zwischen 500 oder 600 FPS erkennt. Das hört man maximal noch am Spulenfiepen der Grafikkarte. Da sind die Prozente der Balken schnell ein Fall für die Galerie, so dass ich das für den heutigen ersten Teil einmal bewusst aussortiert habe und eben nicht diese (meist Denuvo-verseuchten) Titel gewählt habe. Und der Reviewers-Guide, nun ja…

Es wird natürlich sicher den einen oder anderen geben, dem die heutigen Unterschiede bei den Balkenlängen in meinem Review nicht groß genug sind. Auch dafür gibt es, zumindest heute beim Gaming, eine recht einfache Erklärung (siehe unten). Wer jedoch wirklich sehen will, in welchen echten Real-World-Anwendungen der selbsternannte blaue Riese Core i9-12900K den Ryzen 9 5950X auch außerhalb der Propaganda-Folien zum roten Zwerg schrumpfen kann, der möge bitte morgen den Teil Zwei lesen, wenn es um den Produktiveinsatz geht. Denn da gab es auch auf meiner Seite echte Schockmomente und die so gern genommenen Balken mit dem X-Faktor auf der nach oben offenen Folter-Skala. Die gibt es heute übrigens auch, allerdings musste ich da schon meine ganzen Metriken und mehrere Gigabyte an Log-Files aufbieten, um das später noch zu veranschaulichen. Ich sage nur 1% Low und Leistungsaufnahme…

Kommen wir aber als erstes zur Geschichte mit den Balken. Das, was Intel als eigene Benchmarks aufgeführt hatte, ist gleichermaßen falsch und richtig. Falsch in der extremen Ausprägung und trotzdem richtig im Trend. Die meisten AMD-CPUs (vor allem die mit mehr als 8 Kernen) waren anfangs unter Windows 11 extrem gehandicapt. Während ich anfangs in 720p in der Summe aller Spiele über 15 Prozentpunkte und in 1080p noch über 10 Prozentpunkte Unterschied zwischen den beiden schnellsten Vertretern von Intel und AMD messen konnte, ist dieser Vorteil nach dem betreffenden Windows-Update (“L3-Bug”), dem nachgereichten AMD-Chipsatztreiber und in der Folge auch eines neuen BIOSes fürs Motherboard (das mich erst 7 Tage vor diesem Launch erreichte, aber noch einmal was brachte), doch erheblich geschrumpft. Hier bleibt die Sensation beim Average der FPS erst einmal aus, auch wenn wir Intels neue CPUs (fast) immer vorn sehen. Es wäre ja auch schlimm, wenn nicht.

Doch hinter der vermeintlich alles entscheidenden Performance gibt es noch eine zweite Seite, die ich im Hinblick auf die immer weiter ausufernden Leistungsaufnahmewerte neuer Hardware in ökologisch so fragilen Zeiten wie heute viel wichtiger finde. Dass Intel (als US-amerikanisches Unternehmen) solche Aspekte nicht in den Vordergrund stellt, ist zwar logisch (da Energie dort kein Kostentreiber ist), aber eigentlich eine grandios vertane Chance, ein gescheites Marketing auch abseits der Benchmarkbalken zu betreiben. Nun kann man sicher auf der Geschichte mit dem PL1 und der sehr hohen Ansetzung herumreiten, aber meine Messwerte belegen auch, dass selbst ein Setzen auf unendliche Werte an meinem heutigen Fazit nichts ändern wird.

Nein, Intel hat AMD heute nicht bei der Performance geschrumpft, wohl aber (das will ich schon mal spoilern) an der Steckdose. Und genau das ist es auch, worauf der heutige Artikel auch aufbaut. Die partielle Zerstörung einiger Ryzens im Produktivbereich hebe ich mir frecherweise dann für morgen auf, wo die Steckdose übrigens ebenfalls eine Rolle spielen wird. Und in Richtung Intel kann ich nur voranstellen: bitte etwas mehr Mut zur Gegenwart, es gibt nicht nur Gaming. Open World könnte man ja durchaus auch auch anders interpretieren.

NVIDIA oder AMD – Auf der Suche nach der richtigen Grafikkarte

Doch ich will nicht zu weit abschweifen, sondern komme nun auf das Testsystem und die zweckmäßigste Grafikkarte zurück. Dass Intel im Kampf gegen AMDs Ryzen lieber eine Grafikkarte von NVIDIA in Form der GeForce RTX 3090 nutzt, ist durchaus verständlich, wenn auch in 720p nicht zu 100% zielführend. Während ich alle Tests im professionellen Bereich (auch im Hinblick auf die zertifizierte Hardware) mit einer sehr schnellen RTX A6000 erstellt habe, sieht es beim Gaming in den niedrigeren Auflösungen stellenweise nicht ganz so rosig aus, weil hier der Overhead aus NVIDIAs Treibern stellenweise gnadenlos zuschlägt. Wie stark und in welchem Spiel, das werde ich gleich noch zeigen, denn es ist ja auch nicht permanent.

Die RTX A6000 lässt sich mit etwas OC als Vollausbau des GA102 durchaus auf das Level der RTX 3090 und darüber bringen, nur nützt einem das Ganze eigentlich nur in Ultra-HD, wo die Radeon-Karte ihre bekannten Schwächen zeigt. Allerdings ist in diesem Fall sogar auf der GeForce ein absolutes GPU-Bound zu verzeichnen, was den vermeintlichen Nachteil eher relativiert. Ja, es sind teilweise bis zu 12% Performanceunterschied zwischen beiden Karten zu verzeichnen, nur spielt dieser keine Rolle mehr. Der größte Performance-Unterschied lag hier bei weniger als 2% zwischen der langsamsten und der schnellsten CPU, also waren die Ergebnisse, wenn wann sie pro Karte verglich, wieder nahezu identisch.

Wichtiger ist hingegen, die echten Unterschiede im CPU-Bound herauszufinden, was uns in die niedrigen Auflösungen zwingt. Genau da aber deklassiert die von mir verwendete MSI RX 6900XT Gaming X die große RTX A6000 zum Teil erschreckend deutlich. Und genau so, wie bei Intel einige Spiele extrem aus dem Raster fallen, ist es auch bei meinem Test, wo es im Durchschnitt aller Spiele zwar “nur” reichlich 9 Prozentpunkte Unterschied zwischen beiden sind, aber manche Spiele bis zu 20 Prozentpunkte schneller agieren. Ich habe diese Benchmarks sehr bewusst auch nur mit der zweitschnellsten Intel-CPU erstellt und feststellen müssen, dass die Unterschiede beider Karten in der Summe ungefähr so hoch lagen, wie der Unterschied zwischen den beiden jeweils schnellsten CPUs von Intel und AMD.

Das Ganze sieht in Full-HD übrigens kaum anders aus, wenn auch nicht mehr ganz so krass. Aber Nachteile hat die RX 6900XT definitiv keine und nur darauf kam es mir an. Und am Ende war es mir auch wichtig, resizeable BAR, also die Nutzung und Adressierung des erweiterten Speicherbereiches zwischen X570 und Z690 zu testen. Das wiederum gestaltet sich mit einer GeForce eher schwierig, weil der mögliche Zugewinn eher marginal ist. Hier spielen also weder die Vorlieben für Hersteller noch irgendwelche Emotionen eine Rolle, sondern der gesunde Menschenverstand.

Sicher, es ist ein Mehraufwand, Gaming- und Workstation-Benchmarks getrennt vorzunehmen, aber damit lässt sich die Arbeit sogar etwas parallelisieren, wenn man sich den Aufwand redundanter Hardware antun kann. Und um es abschließend klarzustellen: Natürlich sind auch Benchmarks mit der GeForce RTX 3090 (oder der RTX A6000) definitiv nicht falsch, im Gegenteil. Aber Nuancen werden bei dem Test mit der Radeon in 720p sicher eher sichtbar und deutlicher. Und nur darum ging es mir, denn nach all den AMD-Patches und Treiber-Updates waren sich die Balken plötzlich viel zu ähnlich.

Womit wir mit der Einführung schon wieder durch wären. Die 720p sind bei meinen Tests also gesetzt, die höheren Auflösungen bis WQHD auch. Ich habe heute, also einen Tag vor dem Launch entschieden, auf Ultra-HD in den Charts trotz der ganzen Messungen zu verzichten. Denn es spielt absolut keine Rolle mehr, welche CPU im Hintergrund werkelt. Den Unterschied zwischen einem Ryzen 5 5600X und einem Core i9-12900K mit PL1 auf 241 Watt von unter 2% hatte ich ja bereits erwähnt. 100% GPU-Bound machen das möglich. Die Werte für die Leistungsaufnahme stimmen zudem mit denen aus WQHD fast zu 100% überein, so dass ich mir die ganzen Grafiken einfach sparen werde.

Benchmarks, Testsystem und Auswertungssoftware

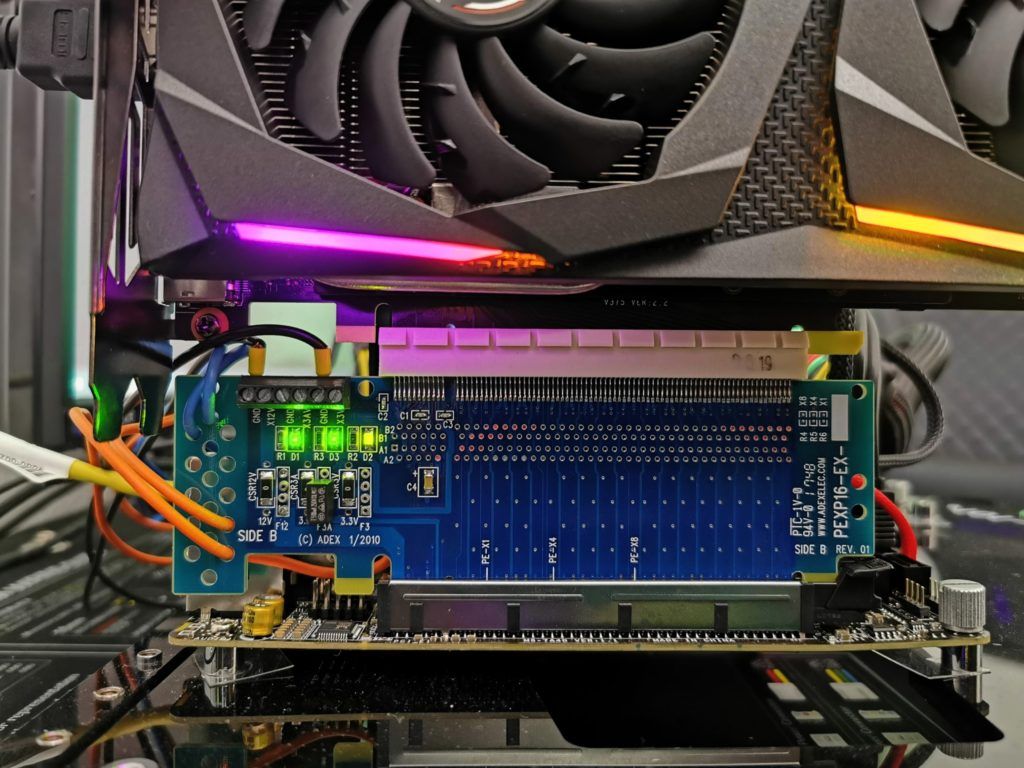

Die Messung der detaillierten Leistungsaufnahme und anderer, tiefergehender Dinge erfolgt hier im Speziallabor (wo am Ende im klimatisierten Raum auch die thermografischen Infrarot-Aufnahmen mit einer hochauflösenden Industrie-Kamera erstellt werden) zweigleisig mittels hochauflösender Oszillographen-Technik (Follow-Ups!) und dem selbst erschaffenen, MCU-basierten Messaufbau für Motherboards und Grafikkarten (Bilder unten).

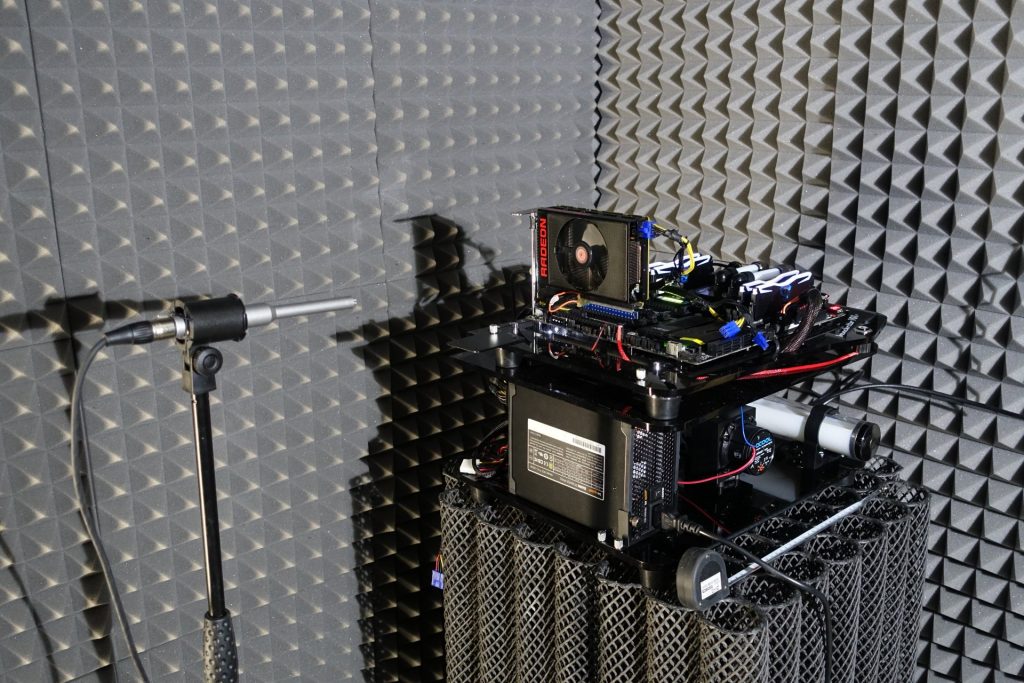

Die Audio-Messungen erfolgen außerhalb in meiner Chamber (Raum im Raum). Doch alles zu seiner Zeit, denn heute geht es ja (erst einmal) ums Gaming.

Die einzelnen Komponenten des Testsystems habe ich auch noch einmal tabellarisch zusammengefasst:

| Test System and Equipment |

|

|---|---|

| Hardware: |

Intel LGA 1700 Intel LGA 1200 AMD AM4 MSI Radeon RX 6900XT Gaming X OC 1x 2 TB MSI Spatium M480 |

| Cooling: |

Aqua Computer Cuplex Kryos Next, Custom LGA 1200/1700 Backplate (hand-made) Custom Loop Water Cooling / Chiller Alphacool Subzero |

| Case: |

Raijintek Paean |

| Monitor: | LG OLED55 G19LA |

| Power Consumption: |

Oscilloscope-based system: Non-contact direct current measurement on PCIe slot (riser card) Non-contact direct current measurement at the external PCIe power supply Direct voltage measurement at the respective connectors and at the power supply unit 2x Rohde & Schwarz HMO 3054, 500 MHz multichannel oscilloscope with memory function 4x Rohde & Schwarz HZO50, current clamp adapter (1 mA to 30 A, 100 KHz, DC) 4x Rohde & Schwarz HZ355, probe (10:1, 500 MHz) 1x Rohde & Schwarz HMC 8012, HiRes digital multimeter with memory function MCU-based shunt measuring (own build, Powenetics software) |

| Thermal Imager: |

1x Optris PI640 + 2x Xi400 Thermal Imagers Pix Connect Software Type K Class 1 thermal sensors (up to 4 channels) |

| Acoustics: |

NTI Audio M2211 (with calibration file) Steinberg UR12 (with phantom power for the microphones) Creative X7, Smaart v.7 Own anechoic chamber, 3.5 x 1.8 x 2.2 m (LxTxH) Axial measurements, perpendicular to the centre of the sound source(s), measuring distance 50 cm Noise emission in dBA (slow) as RTA measurement Frequency spectrum as graphic |

| OS: | Windows 11 Pro (all updates/patches, current certified or press VGA drivers) |

- 1 - Einführung, Vorbemerkung und Testsystem

- 2 - 720p - Gaming Performance

- 3 - 720p - Leistungsaufnahme und Effizienz

- 4 - 1080p - Gaming Performance

- 5 - 1080p - Leistungsaufnahme und Effizienz

- 6 - 1440p - Gaming Performance

- 7 - 1440p - Leistungsaufnahme und Effizienz

- 8 - Gesamtauswertung der Gaming Performance

- 9 - Gesamtauswertung der Leistungsaufnahme und Effizienz

- 10 - Zusammenfassung und Fazit fürs Gaming

163 Antworten

Kommentar

Lade neue Kommentare

Veteran

Urgestein

Urgestein

Urgestein

Veteran

Urgestein

Urgestein

Urgestein

Veteran

Urgestein

Veteran

Urgestein

1

Moderator

Urgestein

Urgestein

Mitglied

1

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →