Temperaturen und Boost-Takt

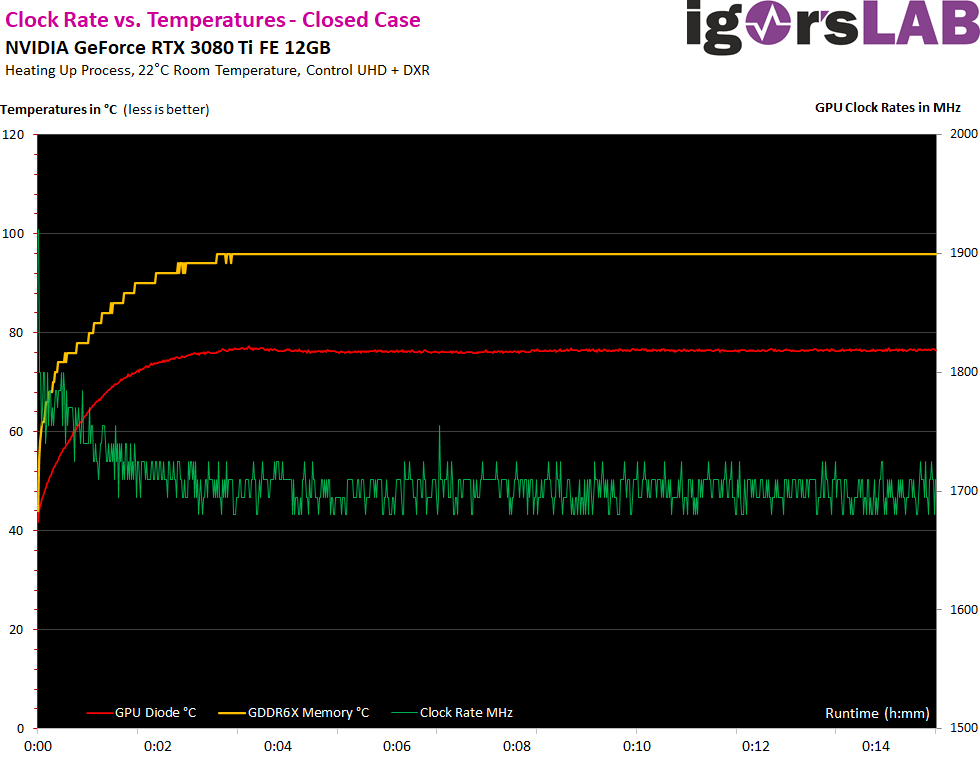

Die Karte boostet, wenn sie kühl genug ist und die GPU-Last die 50% nicht überschreitet, bis auf 1920 MHz (also etwa 200 MHz weniger als die RTX 3080). Allerdings ist dies eine Art Schönwetter-Boost, der bei meinem sehr extrem fordernden Testspiel dann bei steigender Temperatur von 1710 MHz bis auf ca. 1695 MHz einbricht. Damit liegt er nur noch 30 MHz über dem, was NVIDIA für den Boost auch offiziell angibt. Das lässt aber auch die Frage offen, ob hier NVIDIA nicht zu sehr an der Kühlung gespart hat. Bereits angetestete Custom-Modelle können das nämlich meist deutlich besser.

Den Speicher kann man locker auch auf über 20 Gb/s übertakten, büßt aber bereits vor dem Erreichen der Stabilitätsgrenze an Performance ein, was auf ein thermische Throttling zurückzuführen sein dürfte. Micron hat solche Mechanismen ja von Haus aus implementiert. Wer es wirklich drauf anlegt, sollte also knapp unter den 20 Gb/s bleiben, denn auch die GeForce RTX 3090 FE bleibt in diesem Rahmen. Sicher nicht ohne Grund. Das Power-Limit kann man jedoch voll ausreizen und auf einen maximalen Wert von 400 Watt setzen, also satte 50 Watt mehr. Es bringt nur leider nicht viel.

Nur ob man das wirklich will, sollte man bei diesem Kühler schon zweimal überlegen, denn so erträglich er auch im Normalbetrieb sein mag, mit 50 Watt mehr hat er wirklich echte Überlebenskämpfe zu absolvieren, die man dann auch sehr deutlich hört. Meine hier getestete GPU ließ sich noch nicht einmal mehr als 200 MHz stabil übertakten, was dann aber nach der Erwärmung in ca. 105 bis 120 MHz mehr Takt mündete. Aufwand und Nutzen? Naja – das übliche Hund-Schwanz-Prinzip, denn mehr Abwärme lässt den Boost-Takt ja auch wieder sinken.

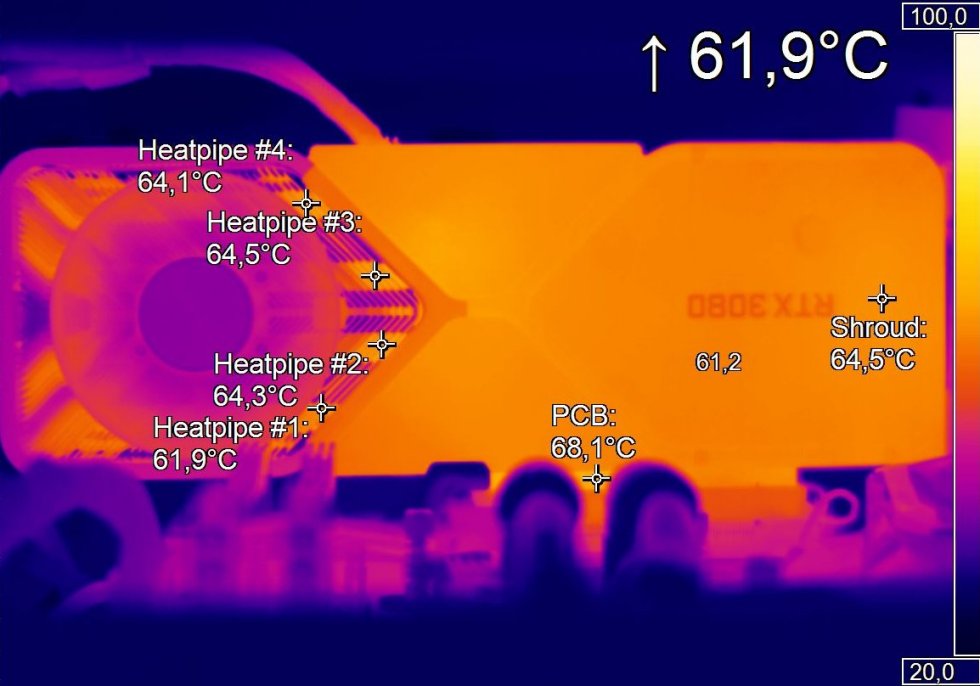

Kommen wir nun zu der Aufzeichnung mit der hochauflösenden Infrarot-Kamera. Die PI640 von Optris besitzt ein echtes 640 x 480 Pixel Bolometer und zeichnet mit bis zu 30 FPS auf. Ich nutze hier die Normallinse und kalibrierte Folie mit einem bekannten Transmissionsgrad, damit ich de facto in das geschlossene Gehäuse hineinsehen kann. Die Backplate lasse ich dran, denn auch die kühlt ja zumindest die Spannungswandler ordentlich mit und schützt damit auch indirekt den Speicher. Betrachten wir zunächst die GeForce RTX 3080 Ti FE von heute:

Vergleicht man das Bild oben nun mit der GeForce RTX 3080 vor meinem Pad-Mod (Bild unten), dann sieht man etwas sehr Interessantes! Die Backplate als Kühler der VRM-Bereiche funktioniert nämlich bei der RTX 3080 Ti FE (oben) richtig gut! Zusammen mit den bis zu 200 U/min mehr Lüfterdrehzahlen bleiben auch die Heatpipes ca. 3 Grad kühler, während die Karte im unteren Bild trotz 30 Watt weniger Abwärme ein etwas anderes Gesamtbild zeigt.

- 1 - Einführung und Testsystem

- 2 - Teardown, Platinenanalyse und Kühler

- 3 - Grafik-Performance: WQHD und Full-HD mit RTX On

- 4 - Grafik-Performance: Ultra-HD mit und ohne DLSS

- 5 - FPS, Perzentile, Frame Time & Varianzen

- 6 - Frametimes vs. Leistungsaufnahme

- 7 - Leistungsaufnahme: GPU und CPU in allen Spielen

- 8 - Leistungsaufnahme: Effizienz im Detail

- 9 - Leistungsaufnahme: Übersicht, Detailanalysen und Power Limits

- 10 - Normeinhaltung, Lastpitzen und Netzteilempfehlung

- 11 - Temperaturen und Infrarot-Tests

- 12 - Geräuschemission / Noise

- 13 - Zusammenfassung. Features und Fazit

57 Antworten

Kommentar

Lade neue Kommentare

Urgestein

1

Mitglied

Urgestein

Veteran

Veteran

1

Urgestein

Mitglied

1

Urgestein

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →