Platinenanalyse und Spannungsversorgung

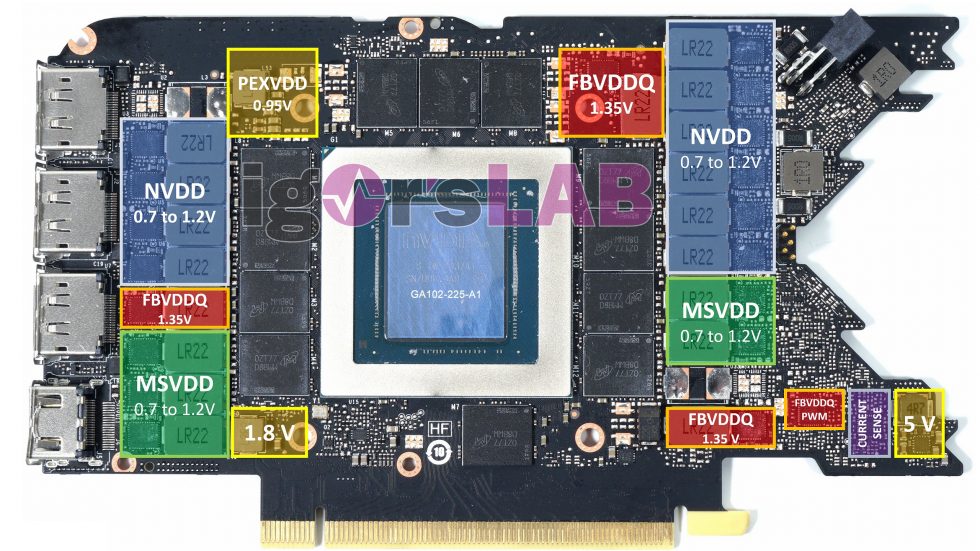

Die bei Foxconn assemblierte Karte besitzt die von mir bereits im Frühjahr 2020 beschriebene 12-Layer-Platine mit Backdrill-Verfahren. Auch die Art der Spannungsversorgung ist beim GA102-225 wieder analog zu den anderen Karten mit dem GA102 gestaltet. Werfen wir einmal einen Blick auf die Oberseite der Platine, dann erkennen wir sofort die Zweiteilung der Hauptspannungsversorgung. NVDD (Blau) steht für die herkömmliche Core-Voltage, also das, was wir gern als GPU- Spannung bezeichnen. Und doch unterscheidet sich diese Platine leicht von der Platine der GeForce RTX 3080, denn NVIDIA hat auch aus den thermischen Problemzonen die richtigen Schlüsse gezogen.

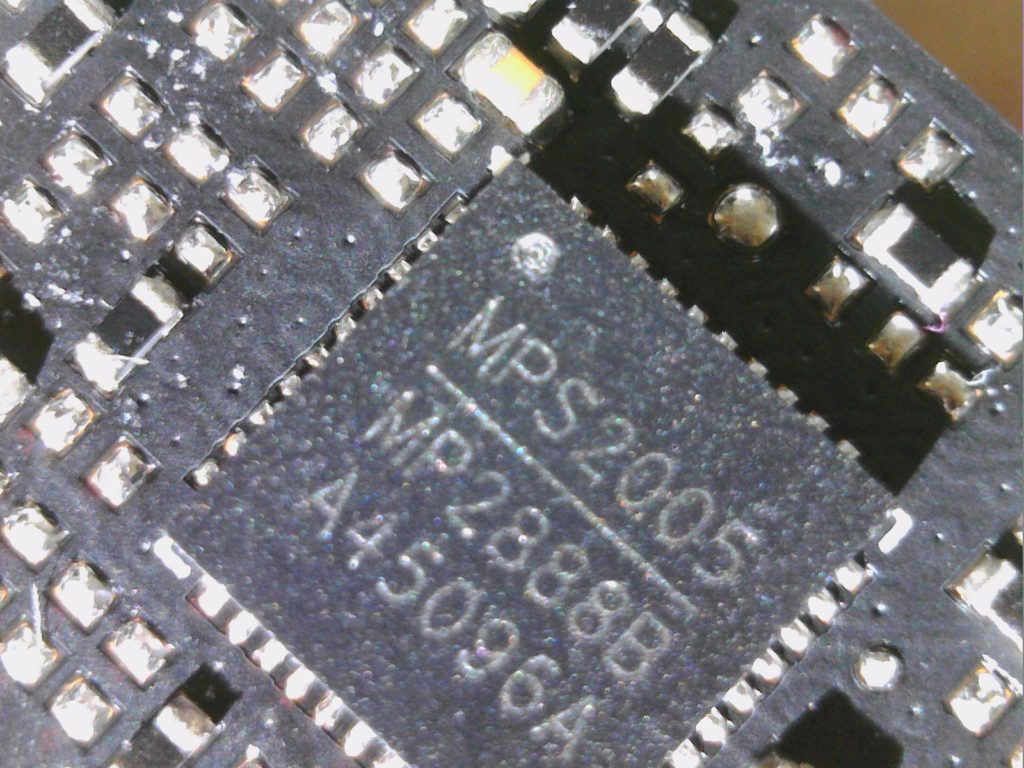

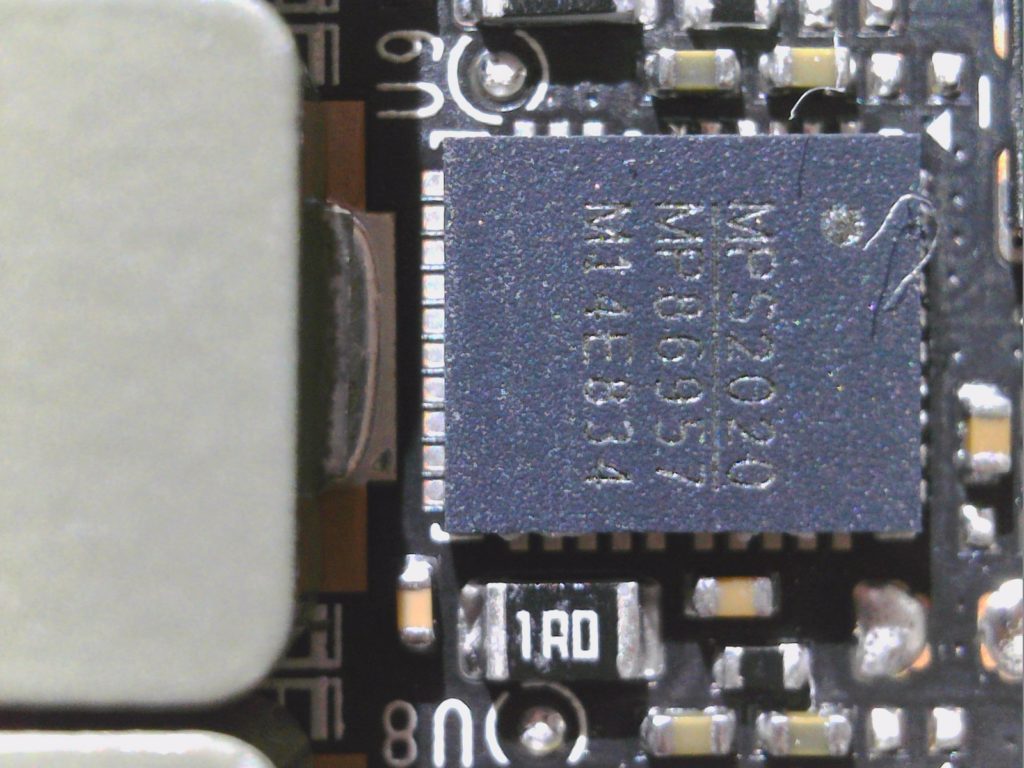

Hier sind es insgesamt jetzt 10 statt neun einzelne Phasen für NVDD, die von einem Monolith MP2888A auf der Rückseite (Blau) bzw. einem pin-kompatiblen Äquivalent bereitgestellt werden. Hier handelt es sich um einen digitalen PWM-Controller mit VID-Interface, kompatibel zu NVIDIAs Open VReg Spezifikation. Der MP2888A kann bis zu 10 Phasen generieren, ist also hier jetzt auch voll ausgelastet. Die 10 Phasen werden jeweils mit noch sehr spärlich dokumentierten Smart Power Stages (SPS) MP86957 des gleichen Herstellers realisiert, die auch eine MOSFET DCR ermöglichen.

Die Bestückung der Spannungsversorgung MSVDD (Grün), die ich als “Gedönsspannung” bezeichnet hatte und die für “Miscellaneous” steht, ist ähnlich aufgebaut. Wir finden insgesamt noch fünf (statt sechs bei der RTX 3080) einzeln angesteuerte Phasen, die von einem MP2886B von Monolith (Rückseite) erzeugt werden, also dem kleinen Bruder des MP2888A von eben. Die sechs SPS setzen wieder auf den MP85957 desselben Herstellers. Am Ende ergeben sich also 15 Phasen allein für die GPU und die verschiedenen Spannungen zur selbigen. Damit sollte auch das Power-Gating in der GPU etwas einfacher werden, wobei AMD mit VDDCI ja eine ähnliche, wenn auch viel kleinere Auslagerung nutzt. Der Spannungsspielraum beider Bereiche liegt zwischen 0.7 und maximal 1.2 Volt, wobei der Maximalwert ohne spezielle Firm- und Software vom Endanwender nie erreicht werden kann.

Die Verlagerung des hinzugekommenen Regelkreises für NVDD nach links macht auch thermisch durchaus Sinn, denn eine Phase mehr trägt nicht nur der um bis zu 30 Watt gestiegenen TBP im Power Limit Rechnung, sondern es reduziert auch die Verlustleistung jeder einzelnen Phase, denn auch die Schaltfrequenz scheint angepasst worden zu sein. Rechnet man für die zwei hinzugekommenen Speichermodule zusammen noch ca. 5 bis 6 Watt ab, dann entfallen mit Sicherheit so um die 20 Watt mehr auf NVDD, der Rest von 4 bis 5 Watt ist dann für MSVDD.

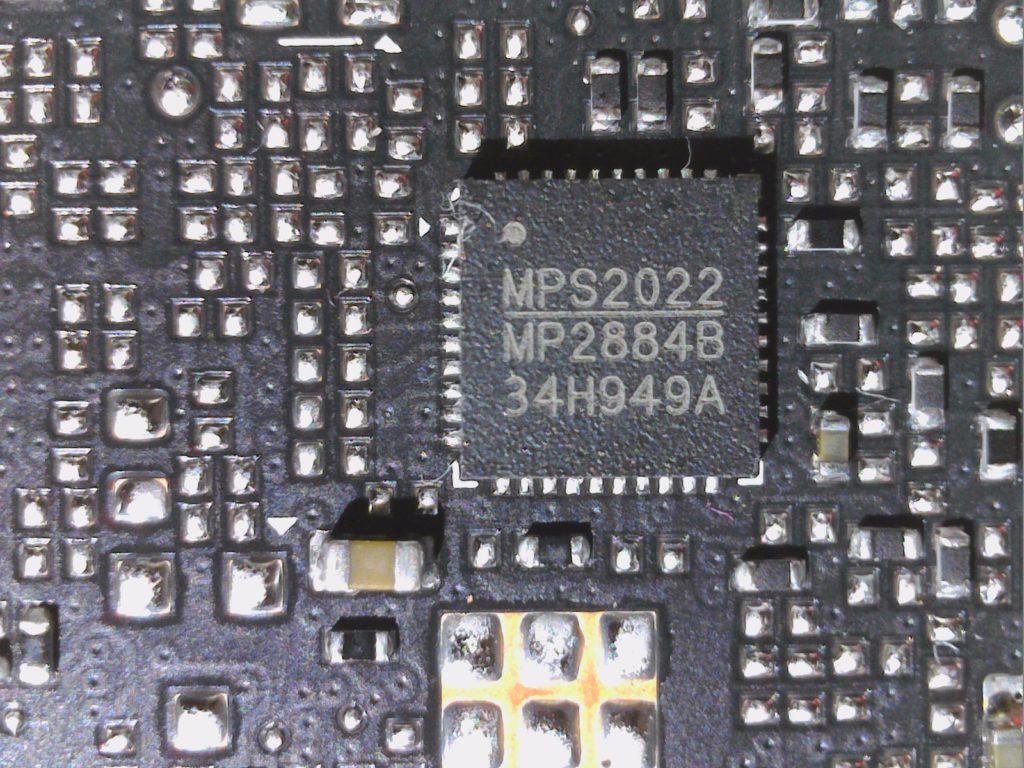

Für den Speicher nutzt NVIDIA drei Phasen, die ein noch weiter abgespeckter MP2884B von Monolith erzeugt, wobei auch hier die SPS von gleichen Typ sind, wie die bisherigen. Der PWM-Controller befindet sich jedoch auf der Vorderseite Die SPS der PCI-Express-Spannung PEXVDD und der 1,8 Volt befinden sich ebenfalls auf der Rückseite, die dazugehörigen Spulen vorn auf der Frontseite. Dort gibt es rechts unten auch noch eine 5V-Aufbereitung. Wir sehen hier auf der Rückseite auch noch mehrere Wärmeleitpads, vor allem ein großes auf den Caps von NVDD, was zeigt, das sich NVIDIA den Pad-Mod und meine Anmerkungen zum Hotspot auf der Platine recht aufmerksam durchgelesen haben muss.

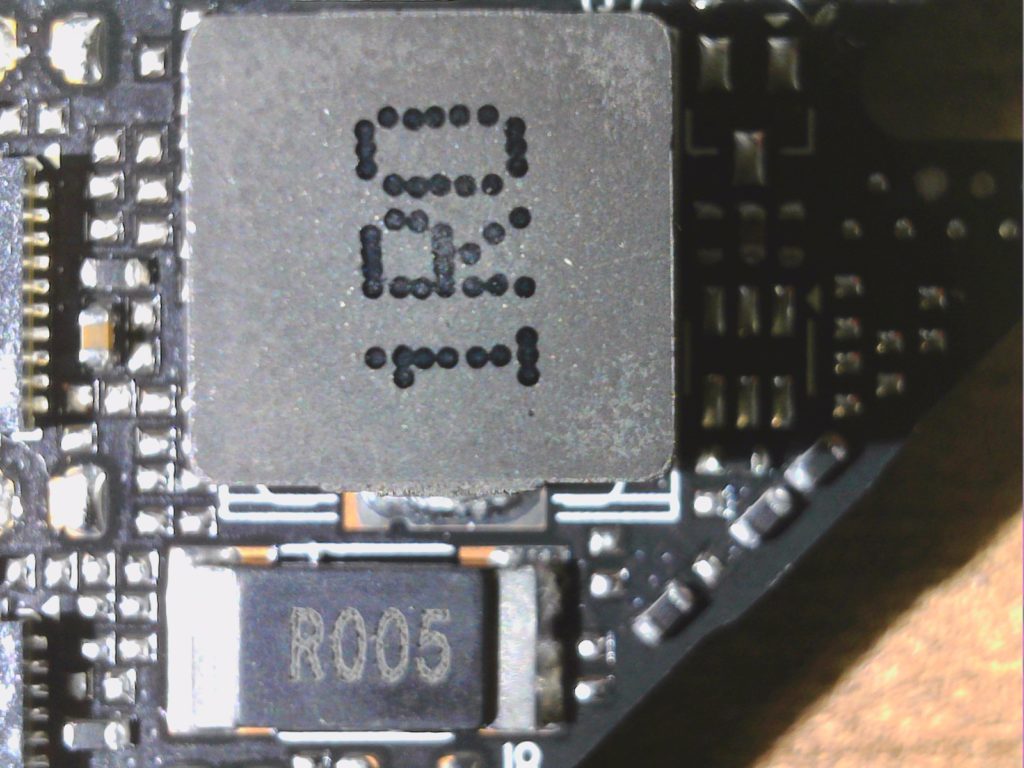

Zur Eingangsglättung nutzt man drei Spulen mit jeweils 1 µF hinter denen ein Shunt liegt, über dessen Spannungsabfall man die fließenden Ströme misst. Da aber die Firmware auch die MOSFET DCR der SPS auswerten kann, sind Shunt-Mods nicht mehr so ohne weiteres möglich. Rechts daneben sehen wir den großen PWM-Controller MP2880A von Monolith für NVDD auf der Rückseite.

Die beiden nachfolgenden Bildern zeigen stellvertretend für alle SPS einen der Power Stages vom Typ MP86957, der bei allen drei großen Versorgungskreisen eingesetzt wird, sowie exemplarisch eine der vielen 220 mH Spulen. Den MP2880A für MSVDD schenke ich mir hier mal als Bild, denn der sieht nicht viel anders aus als der MP2884B des Speichers.

Wir sehen unten den MP2884B für den Speicher und eines der Speichermodule von Micron. Die insgesamt 12 1-GB-Module des GDDR6X Speichers kommen von Micron. Der Speicher läuft mit nur 19 Gb/s, obwohl er eigentlich 21 Gb/s könnte. Inwieweit NVIDIA hier thermischen Problemen vorbeugen wollte, lässt sich natürlich nur spekulieren.

Kühler und Demontage

Das Auseinandernehmen des Kühler ist reichlich tricky, hier verweise ich gern auf das passende Video, das ich bereits für die GeForce RTX 3080 zweisprachig hochgeladen habe und das analog auch 1:1 für die RTX 3080 Ti gilt. Der Body ist überwiegend aus Leichtmetall mit einer recht cleveren Oberfläche, was mich auch beim Unboxing aufgrund des eingearbeiteten “GEFORCE RTX” Schriftzuges zunächst von einem mit Metallpulver beschichteten Kunststoff ausgehen ließ. Der eigentliche Kühler ist mehrteilig und besteht aus einem effizienten, vernickelten Heatsink an dessen Rückseite vier abgeflachte Heatpipes verlötet wurden, die sich dann längs bis zum Kartenende hinziehen.

Über dem Heatsink und dem offenen Aufbau sitzen insgesamt zwei PWM-geregelte 8.5-cm-Lüfter mit einer sehr interessanten Rotorblatt-Geometrie, die fast schon an das Design von Radial-Lüftern erinnert. Nun ja, fast. Aber auch die maximale Drehzahl der beiden getrennt geregelten Lüfter (Front bis zu 3800 U/min, Rückseide bis zu 3400 U/min) ist nicht gerade ein Ausdruck vornehmer Zurückhaltung. Wollen wir mal hoffen, dass es hier leiser bleibt, als die Karte könnte, wenn sie denn müsste.

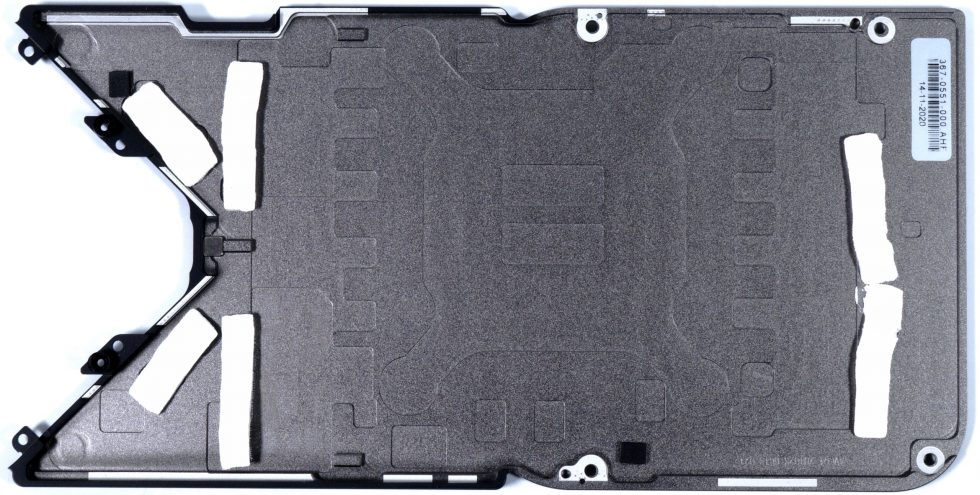

Die Backplate besteht ebenfalls aus Leichtmetall, das man außen mattschwarz beschichtet hat. Der Hersteller verbindet thermisch nur die Spannungswandler, sowie die PWM-Controller mit der Backplate. Die Bereiche unter dem Speicher und dem BGA bleiben rückseitig ohne Kühlung.

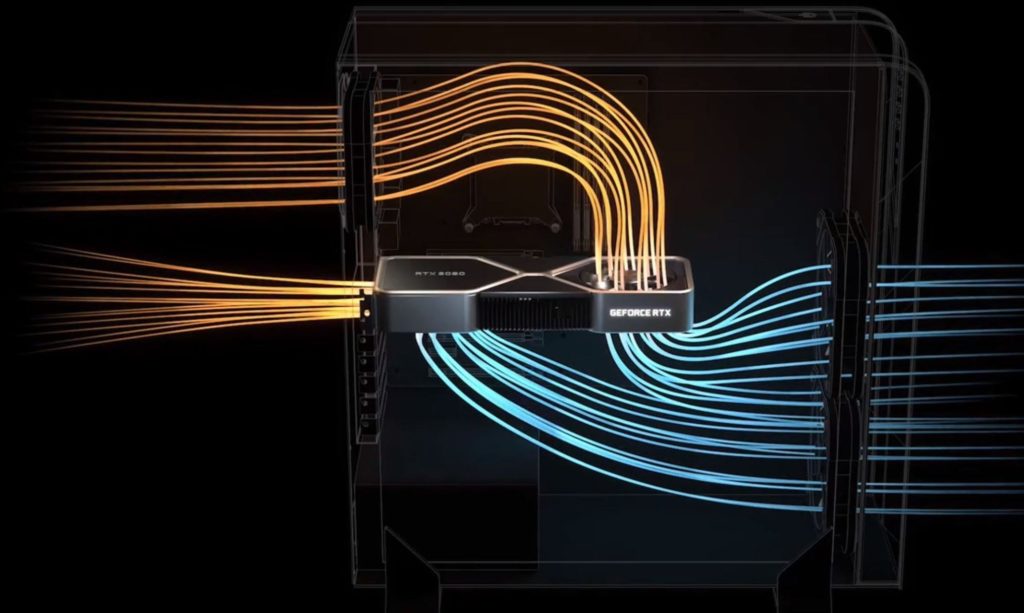

Über das Prinzip mit den verschiedenen Ansaug- und Ausblasrichtungen wurde ja schon ausgiebig spekuliert, so dass ich mich nicht mehr wiederhole, sondern nur noch einmal die Folie bemühe. Den Test im geschlossenen Gehäuse sehen wir dann ja eh noch.

- 1 - Einführung und Testsystem

- 2 - Teardown, Platinenanalyse und Kühler

- 3 - Grafik-Performance: WQHD und Full-HD mit RTX On

- 4 - Grafik-Performance: Ultra-HD mit und ohne DLSS

- 5 - FPS, Perzentile, Frame Time & Varianzen

- 6 - Frametimes vs. Leistungsaufnahme

- 7 - Leistungsaufnahme: GPU und CPU in allen Spielen

- 8 - Leistungsaufnahme: Effizienz im Detail

- 9 - Leistungsaufnahme: Übersicht, Detailanalysen und Power Limits

- 10 - Normeinhaltung, Lastpitzen und Netzteilempfehlung

- 11 - Temperaturen und Infrarot-Tests

- 12 - Geräuschemission / Noise

- 13 - Zusammenfassung. Features und Fazit

57 Antworten

Kommentar

Lade neue Kommentare

Urgestein

1

Mitglied

Urgestein

Veteran

Veteran

1

Urgestein

Mitglied

1

Urgestein

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →