Nach dem heißen Herbst 2020 und der nunmehr fast schon ewig scheinenden Grafik-Karten-Durststrecke, haben wir zwischenzeitlich auch viele neue Begriffe und diverse Nöte kennengelernt. Wer nicht gerade auf SM-Spielchen steht, also auf Scalper & Mining, der hat es gegenwärtig wirklich schwer, seinen Wunschtraum einer neuen, super-schnellen Pixelschleuder in einem vernünftigem Rahmen zu realisieren. Und dann kam die GeForce RTX 3080 Ti samt LHR. Ich will und kann keine Prognosen abgeben, wie wirkungsvoll die neue Gangart zumindest gegen die Casual-Miner auch in Zukunft sein wird, aber genau dieses neue Gaming-Produkt aus Jensens GeForce-Küche habe ich heute für Euch im Test.

Ohne es vorab zu spoilern, weil Ihr es ja noch lesen sollt, die Tests haben sich auch diesmal wirklich gelohnt. Ob es am Ende die Founders Edition für eine UVP von 1199 Euro oder eine Boardpartner-Karte wird (falls mal was im Angebot als bestellbar auftaucht), das muss jeder mit sich, seinen Präferenzen, seinem modischen Geschmack und natürlich auch dem Füllstand des Gelbeutels sowie der Marktlage ausmachen. Der Einzelhandel ist leider wie immer mit im Boot, denn Angebot und Nachfrage regeln leider wie immer den Preis, Weniger teurer zu verkaufen ist da auch keine Lösung im Sinne der Kunden, aber Knappheit weckt nun mal auch Begehrlichkeiten.

Die neue GeForce RTX 3080 Ti soll sich zwischen der GeForce RTX 3080 und der RTX 3090 einordnen. Doch ob sie genau in die Mitte fällt oder sich das Pendel vielleicht doch eher in Richtung der kleineren oder größeren Karte bewegt, dass muss heute noch herausgefunden werden. Denn am Ende möchte NVIDIA ja eine Gaming-Grafikkarte für höchste Ansprüche unters Volk bringen, was bei der GeForce RTX 3090 durch Preis und Verfügbarkeit, sowie den immensen Speicherausbau eher nicht so Massen-kompatibel ausschaute. Diese RTX 3090 ist und bleibt wohl auch ein Leuchtturm-Projekt. Doch man sinnt ja immer noch auf Rache wegen AMDs Radeon RX 6900XT, die der RTX 3090 schon oft recht nahe kam.

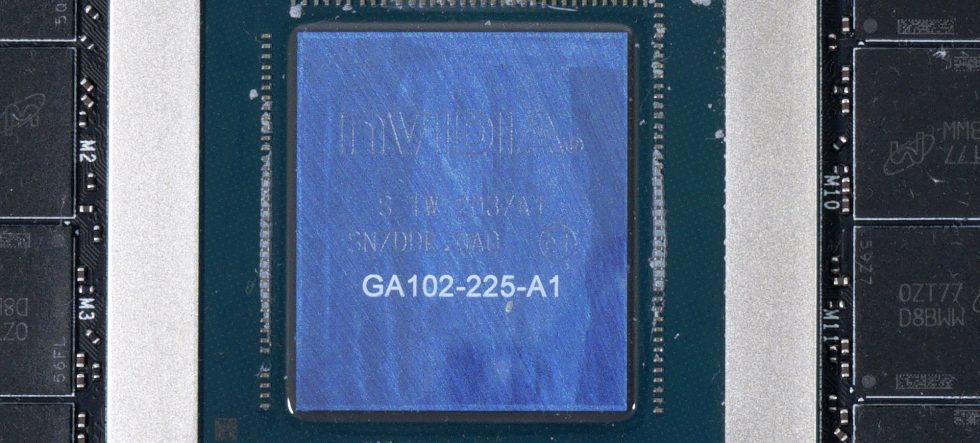

Und dann wären wir wieder beim unsäglichen Just buy it! eines gewissen Kollegen aus Übersee. Schön wär’s ja, wenn man es so könnte (wie man möchte) und es seinerzeit auch so bestellt wurde. Doch solcherart Vorschusslorbeeren gibt es hier keine, denn der neueste Spross aus NVIDIAs Hochglanz-Katalog muss erst mal zeigen, was er wirklich kann. Die Gene passen schon einmal, denn das Herzstück der GeForce RTX 3080 Ti ist der GA102-225 Grafikprozessor. Er basiert auf Samsungs speziell für NVIDIA entwickeltem 8-nm-Prozessknoten und verfügt über insgesamt 28 Milliarden Transistoren. Den kennen wir ja schon vom letzten Jahr.

Er misst knapp 628 mm², was ihn zum zweitgrößten jemals produzierten Gaming-Grafikprozessor direkt unter dem Turing TU102 Grafikprozessor macht. Für die GeForce RTX 3080 Ti hat NVIDIA immerhin 80 SM-Einheiten auf seinem Flaggschiff aktiviert, was zu insgesamt 10240 CUDA-Kernen führt. Zusätzlich zu den CUDA-Kernen ist NVIDIAs GeForce RTX 3080 Ti auch mit RT-Kernen der nächsten Generation (Ray-Tracing), Tensor-Kernen und den neuen SM- oder Streaming-Multiprozessoreinheiten ausgestattet. Was den Speicher betrifft, so ist die GeForce RTX 3080 Ti mit 12 GB GDDR6X Speicher ausgerüstet, der Speichergeschwindigkeiten von 19,0 Gbps liefern kann. Zusammen mit einem 384 Bit Interface wird dies eine kumulative Bandbreite von 912,4 Gbps liefern.

Alle GeForce-Karten wurden mittlerweile gepatcht, so dass alle Karten im Testfeld mit dem erweiterten Speicherbereich (Resizeable BAR) umgehen können, was die Charts deutlich vereinfacht und im Artikel auch nicht weiter erwähnt werden muss.

Die GeForce RTX 3080 Ti Founders Edition

Theorie, naja, nimmt man gern mit, aber jetzt geht es direkt und schnörkellos ans Eingemachte. Das Gehäuse der Karte ist ein ziemlich cleverer Mix aus Leichtmetall, Kunststoff und Eisenwaren, der sich toll und wertig anfasst und zudem auch optisch ordentlich was hermacht. Das Design mit den 3.8 cm Einbautiefe und der 4 mm Backplate macht diese Karte zu einem astreinen Dual-Slot-Design mit allen bekannten Vor- und Nachteilen. Man kann es lieben oder hassen, es schreckt in Form dieser Grafikkarte aber nicht ab, trotz den Leistungsaufnahme, die es zu bewältigen gilt.

Mit den 1372 Gramm ist die Karte beileibe kein Fliegengewicht und 20 Gramm schwerer als die RTX 3080 ohne Ti, was wohl auf die zwei hinzugekommenen Speichermodule zurückzuführen ist. Die Länge von 28,5 cm ist moderat auch die Einbauhöhe ist mit 10,5 cm ab der Oberkante des PCIe-Slots bei eingebauter Karte bis zur Oberseite der Abdeckung nichts, was Angst einflößen sollte. Der lustige 12-Pin Micro-Fit 3.0 an der Oberseite ist um 45° abgeschrägt und zeigt leicht nach hinten. Hier darf man dann den mitgelieferten 12-Pin Adapter anschließen, an den die zwei herkömmlichen 6+2-Pin Stecker passen, die man ja schon seit Jahren kennt. Ihr werdet auf der nächsten Seite noch die Platine sehen und verstehen, warum das so sein musste. Form follows Function, oder so. Zum Kühlerdesign gibt es dort dann gleich auch noch weitere Details.

NVIDIA verzichtet wieder auf den USB Type C am Slot-Panel, wohl auch deshalb, weil sich der VR-Hype mittlerweile wieder deutlich abgekühlt hat. Interessanterweise hat AMD dieses Feature bei Big-Navi mit aufgenommen, während man hier damit bereits abgeschlossen zu haben scheint. Der HDMI-2.1.-Anschluss darf nicht fehlen, die drei aktuellen 1.4-DisplayPorts natürlich auch nicht. Die großen Kühlöffnungen zeigen, woher (bzw. wohin) der Wind weht und damit wären wir mit den Äußerlichkeiten auch schon wieder komplett fertig. Es ist ja nichts komplett Neues.

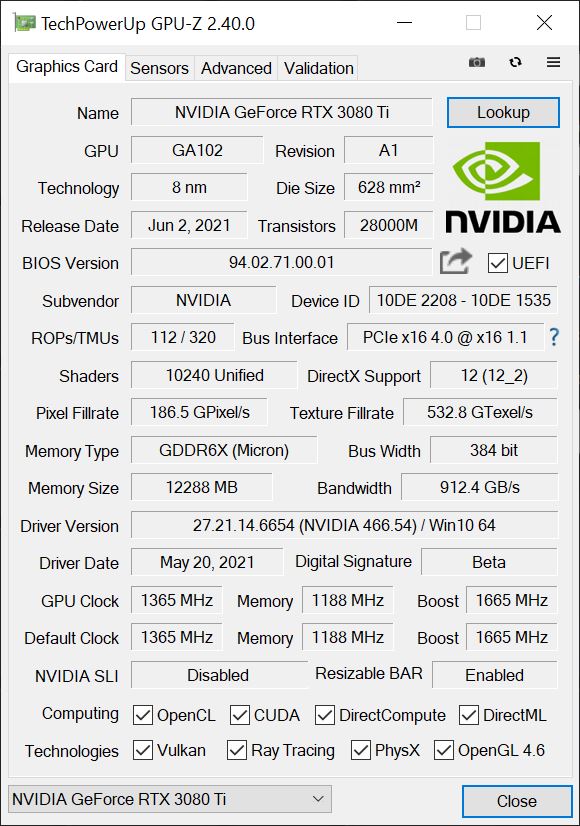

Die Daten der Founders Edition zeigt uns noch einmal der aktuelle GPU-Z Screenshot, den Rest hatte ich ja schon weiter oben aufgeführt. Die 1365 MHz Basis und die 1665 MHz Boost-Takt sind sind ja bereits genauso bekannt, wie die 1188 MHz Speichertakt und er Speicherausbau mit 12 GB am 384-Bit Interface. Man liegt beim Takt leicht unterhalb der beiden anderen Karten, was aber nicht verwundert. Kannibalisierung ist bei NVIDIA gerade nicht so sehr in Mode.

Im direkten Vergleich zu den anderen neuen Karten liegt die RTX 3080 Ti mit der 3090 am oberen Ende der Nahrungskette und der leistungsbezogene Abstand der 1199-Euro-Karte zur 1499 Euro teuren GeForce RTX 3090 ist deutlich kleiner als der Preisunterschied. Auch hier habe ich noch einmal eine Tabelle für alle Statistiker unter Euch, bevor es dann ab der nächsten Seite wirklich voll losgeht.

| GeForce RTX 3070 | GeForce RTX 3080 | GeForce RTX 3080 Ti |

GeForce RTX 3090 | |

|---|---|---|---|---|

| GPU | GA104-300 | GA102-200 | GA102-225 |

GA102-300 |

| Process Node | Samsung 8 nm | |||

| Die Size | 395.2 mm2 | 628.4 mm2 | ||

| Transistoren | 17.4 Mrd. | 28 Mrd. | ||

| CUDA Cores | 5888 | 8704 | 10496 | |

| TMUs/ROPs | TBA | 272 / 96 | 320/112 |

TBA |

| Tensor/RT | 184 / 46 | 272 / 68 | 320 / 80 | 328 / 82 |

| Basis-Takt |

1500 MHz | 1440 MHz | 1365 MHz |

1400 MHz |

| Boost-Takt |

1730 MHz | 1710 MHz | 1665 MHz |

1700 MHz |

| Speicher | 8 GDDR6 | 10 GB GDDR6X | 12 GB GDDR6X | 24 GB GDDR6X |

| Interface | 256-bit | 320-bit | 384-bit | 384-bit |

| Durchsatz | 14 Gbps | 19 Gbps | 19 Gbps |

19.5 Gbps |

| Bandbreite | 448 Gbps | 760 Gbps | 912.4 Gbps |

936 Gbps |

| TGP | 220W | 320W | 350 W |

350W |

| Launch | 15.10.2020 | 17.09.2020 | 02.06.2021 |

24.09.2020 |

Testsystem und Auswertungssoftware

Das Benchmarksystem ist neu und steht jetzt nicht mehr nur im Labor, sondern auch wieder als Doublette im Redaktionsraum. Ich setze auch auf PCIe 4.0, das passende X570 Motherboard in Form eines MSI MEG X570 Godlike (Gaming-Benchmarks) bzw. einem MSI MEG X570 Ace (Messlabor) und jeweils einen selektierten Ryzen 9 5900X, die beide wassergekühlt bis auf 4.7 GHz übertaktet wurden. Dazu kommen der passende DDR4 3800 RAM (Corsair, G.Skill) sowie mehrere schnelle NVMe SSDs. Für das direkte Loggen während aller Spiele und Anwendungen nutze ich NVIDIAs PCAD, was den Komfort ungemein erhöht.

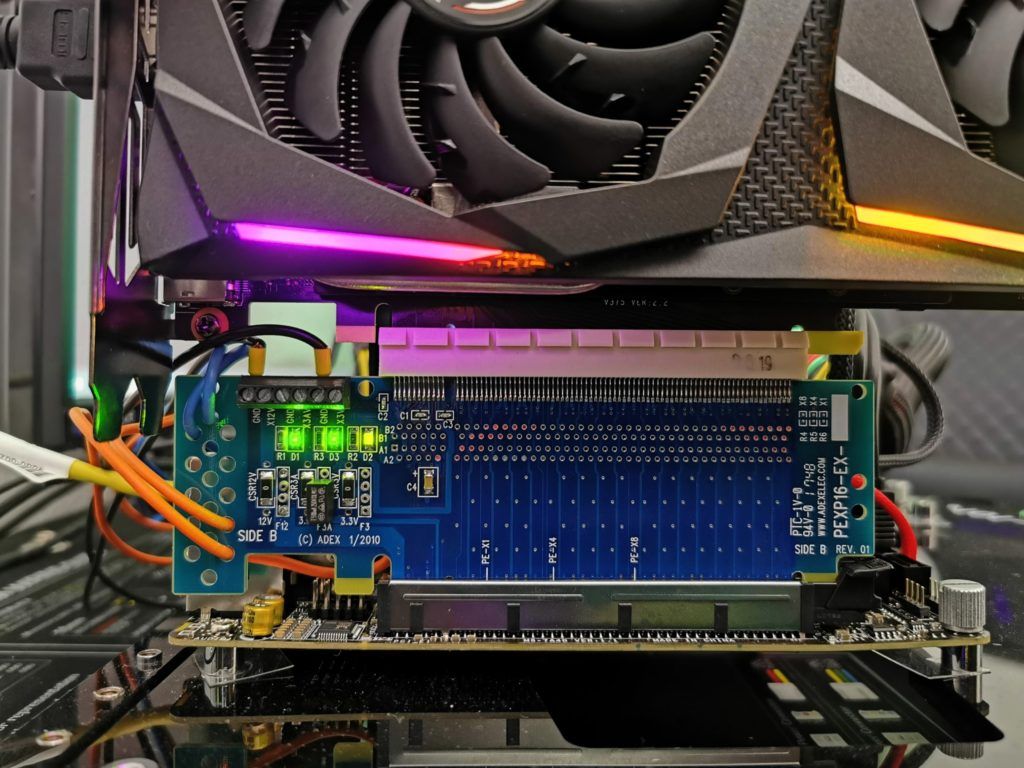

Die Messung der Leistungsaufnahme und anderer Dinge erfolgt hier im Speziallabor auf einem redundanten und fast identischem Testsystem dann zweigleisig mittels hochauflösender Oszillographen-Technik…

…und dem selbst erschaffenen, MCU-basierten Messaufbau für Motherboards Grafikkarten (Bilder unten), wo am Ende im klimatisierten Raum auch die thermografischen Infrarot-Aufnahmen mit einer hochauflösenden Industrie-Kamera erstellt werden. Die Audio-Messungen erfolgen außerhalb in meiner Chamber.

Die einzelnen Komponenten des Testsystems habe ich auch noch einmal tabellarisch zusammengefasst:

| Test System and Equipment |

|

|---|---|

| Hardware: |

AMD Ryzen 9 5900X @4.7 GHz MSI MEG X570 Godlike / X570 Ace 2x 16 GB DDR4 3800, CL16 Be Quiet! Dar Power Pro 1200W |

| Cooling: |

Alphacool Eisblock XPX Pro Alphacool Eiswolf (modified) Alphacool Subzero |

| Case: |

Raijintek Paean |

| Monitor: | BenQ PD3220U |

| Power Consumption: |

Oscilloscope-based system: Non-contact direct current measurement on PCIe slot (riser card) Non-contact direct current measurement at the external PCIe power supply Direct voltage measurement at the respective connectors and at the power supply unit 2x Rohde & Schwarz HMO 3054, 500 MHz multichannel oscilloscope with memory function 4x Rohde & Schwarz HZO50, current clamp adapter (1 mA to 30 A, 100 KHz, DC) 4x Rohde & Schwarz HZ355, probe (10:1, 500 MHz) 1x Rohde & Schwarz HMC 8012, HiRes digital multimeter with memory function MCU-based shunt measuring (own build, Powenetics software) NVIDIA PCAT and FrameView 1.1 |

| Thermal Imager: |

1x Optris PI640 + 2x Xi400 Thermal Imagers Pix Connect Software Type K Class 1 thermal sensors (up to 4 channels) |

| Acoustics: |

NTI Audio M2211 (with calibration file) Steinberg UR12 (with phantom power for the microphones) Creative X7, Smaart v.7 Own anechoic chamber, 3.5 x 1.8 x 2.2 m (LxTxH) Axial measurements, perpendicular to the centre of the sound source(s), measuring distance 50 cm Noise emission in dBA (slow) as RTA measurement Frequency spectrum as graphic |

| OS: | Windows 10 Pro (all updates, current certified drivers) |

- 1 - Einführung und Testsystem

- 2 - Teardown, Platinenanalyse und Kühler

- 3 - Grafik-Performance: WQHD und Full-HD mit RTX On

- 4 - Grafik-Performance: Ultra-HD mit und ohne DLSS

- 5 - FPS, Perzentile, Frame Time & Varianzen

- 6 - Frametimes vs. Leistungsaufnahme

- 7 - Leistungsaufnahme: GPU und CPU in allen Spielen

- 8 - Leistungsaufnahme: Effizienz im Detail

- 9 - Leistungsaufnahme: Übersicht, Detailanalysen und Power Limits

- 10 - Normeinhaltung, Lastpitzen und Netzteilempfehlung

- 11 - Temperaturen und Infrarot-Tests

- 12 - Geräuschemission / Noise

- 13 - Zusammenfassung. Features und Fazit

57 Antworten

Kommentar

Lade neue Kommentare

Urgestein

1

Mitglied

Urgestein

Veteran

Veteran

1

Urgestein

Mitglied

1

Urgestein

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →