Kommen wir nun zur Zusammenfassung und der Frage, wo sich die neue GeForce RTX 3080 Ti (in diesem Falle die Founders Edition) denn nun einordnet. Dazu habe ich alle Spiele analysiert, die Ergebnisse zunächst normalisiert und dann daraus ein geometrisches Mittel (GEOMAN) errechnet. Dieser Wert liegt, mathematisch begründet, nie höher und sogar meist niedriger als das normale arithmetische Mittel, das hier aber deutlich unzweckmäßiger wäre, da ich ja keine Absolutwerte aus nur einem Benchmark nutze und man dieses Verfahren auch bei den ganzen professionellen Benchmark-Bewertungen verwendet.

Spiele-Performance

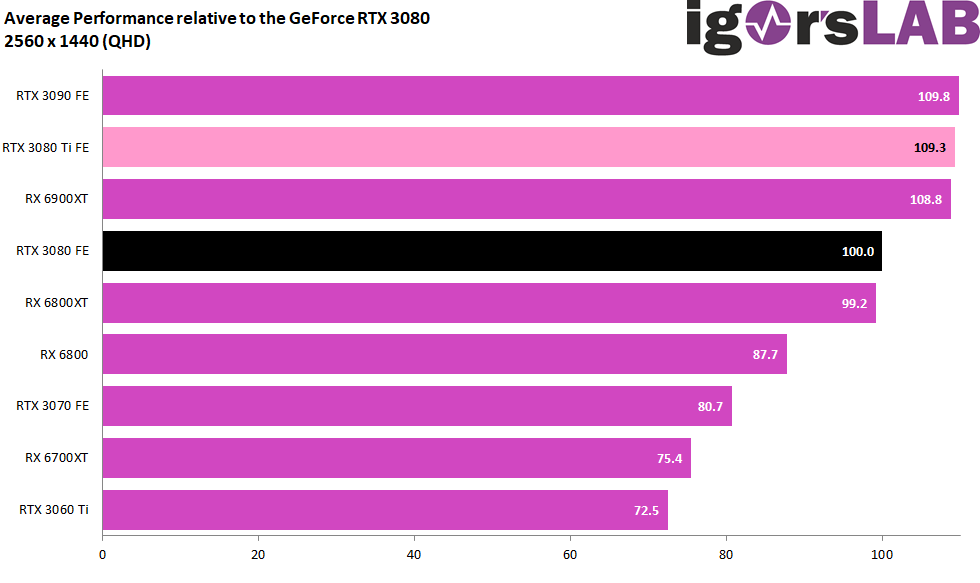

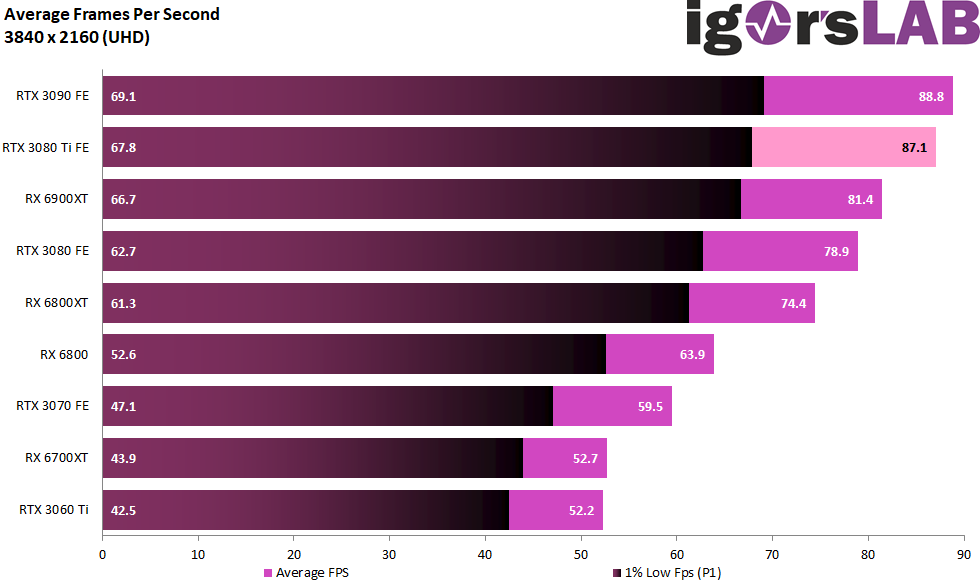

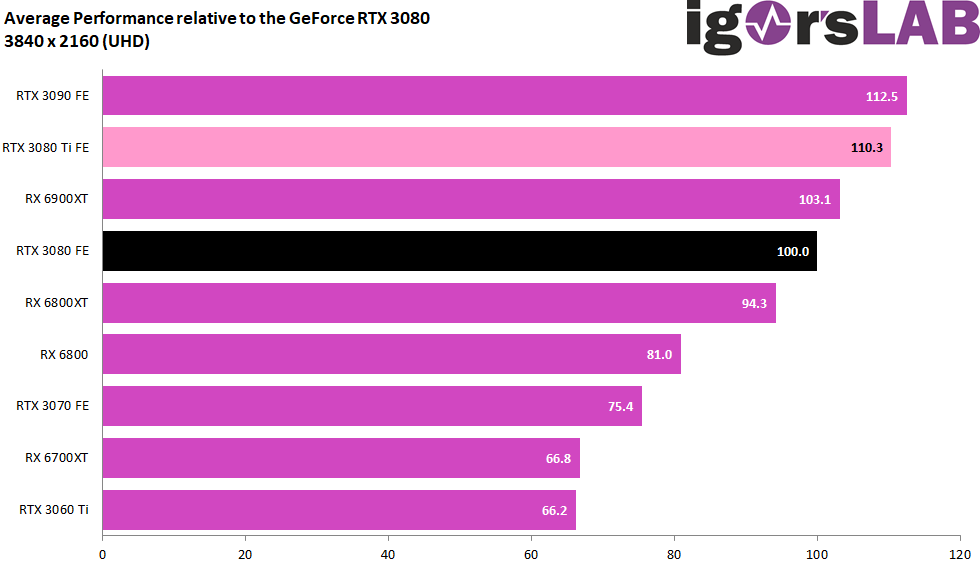

In den nachfolgenden Ergebnisübersichten habe ich einerseits die durchschnittlichen FPS aller Karten und in allen Spielen erfasst und dann andererseits noch einmal prozentual gegenübergestellt. Insgesamt 10 Spiele in drei Auflösungen hatte ich getestet, um dann am Ende doch die Full-HD-Auflösung bei den ganzen Einzelbenchmarks wegzulassen. Der Grund ist schnell erklärt, denn die Systeme waren durchgängig nicht in der Lage, diese schnellen Grafikkarten in dieser niedrigen Auflösung ohne ein CPU-Limit zu betreiben. In manchen Spielen waren die Balken dann überwiegend gleich lang. Da ich mir auf diese Weise ca. 240 einzelne Grafiken sparen kann, lasse ich Full-HD im Test einfach weg, denn es ist auch fürs Gesamturteil nicht zu gebrauchen.

In WQHD liegt die GeForce RTX 3090 FE nur hauchzart vor der 3080 Ti FE, wobei ich den Grund ja bereits im Verlaufe der Einzelbenchmarks genannt hatte. Mit 25 bis 30 Watt mehr Power für die GPU, da viel Speicher wegfällt, kann die RTX 3080 Ti nämlich Vieles wettmachen. Ich sehe beide Karten also durchaus auf Augenhöhe bzw. einem sehr ähnlichen Level.

In Ultra-HD geht dann die Post ab und wir dürfen nie vergessen, dass dies kein Cherry-Picking ist, sondern sich in jeder Situation Spiele in der Auswahl befinden, die die Schönwetterfront leicht durchbrechen können. Dann steigt auch der Vorsprung der GeForce RTX 3090 FE leicht an, wenn auch nur im sehr niedrigen Prozentbereich. Mit den reichlich 2 Prozentpunkten Rückstand (bei einer anderen Konstellation im Chip-Lotto hätten es sicher bis zu 4 sein können) ist die GeForce RTX 3080 Ti allerdings immer noch ein echter Gegenpart zur RTX 3090, denn man wird diesen eher kleinen Rückstand in der Praxis kaum spüren.

Je nach Chipgüte ist die Streuung sicher noch etwas größer, aber wenn Potato (RTX 3090) und ordentlicher Chip (RTX 3080 Ti) aufeinander treffen, dann verwischen sich die Unterschiede zwischen den preislich so unterschiedlich positionierten Karten recht schnell und man kann auch getrost zur RTX 3080 Ti greifen, wenn die RTX 3090 zu teuer und nicht verfügbar ist. Genau das dürfte NVIDIA mit diesem Modell ja auch erreichen wollen.

Zusammenfassung

Die GeForce RTX 3080 Ti ist kein Lückenfüller zwischen einer GeForce 3080 und der RTX 3090 im herkömmlichen Sinne, dazu wäre auch viel zu wenig Luft zwischen den Karten, um das wirklich genau hinzubekommen. Da man das gleiche Power Limit wie bei der GeForce RTX 3090 nutzt, der Karte aber durch den halbierten Speicherausbau fast 30 Watt mehr für die GPU zugesteht, ist die Zielstellung, einen „Ersatz“ für die RTX 3090 hinzubekommen, durchaus plausibel gelöst worden. Wäre der Kühler potenter, dann hätte man bei gleicher TBP die RTX 3090 sogar leicht überholen können. Das zeigen ja auch die Custom-Modelle, die oft genug auch schneller als eine GeForce RTX 3090 FE agieren. Aber wer kannibalisiert sich schon gern selbst das Spitzenmodell weg?

Und das Spielen in Ultra-HD? Es ist am Ende genau der Zuwachs, denn man z.B. beim Spielen in Ultra-HD schon immer eingefordert hat. Das klappt, vor allem mit Hilfe von DLSS (aber mittlerweile nicht nur!) in den passenden Spielen so gut, dass man mit einem 60-Hz-Monitor bereits wieder freiwillig den Frame-Limiter anwirft. was wiederum die Karte deutlich sparsamer agieren lässt. Aber die Reserven sind da, keine Frage. Dass der RAM mit seinen 12 GB spätestens in Ultra-HD in Zukunft auch mal knapp werden könnte, liegt auch an vielen Spieleherstellern, die mit Daten genau das zumüllen, was zuzumüllen geht. Was natürlich keine pauschale Entschuldigung und somit auch der einzige Knackpunkt wäre. Aber 12 GB sind zumindest schon einmal mehr als nur 10 GB, immerhin.

Abhilfe schafft da in jedem Fall DLSS 2.0, denn das, was man mit DLSS bei NVIDIA vorgelegt hat, ist fast schon eine Art Wunderwaffe, solange es denn sauber implementiert ist. Da sind natürlich auch die Spielehersteller gefragt, so dass man sich bei NVIDIA aktuell den DLSS und DXR-Turbo zündet und immer mehr Spiele (laut NVIDIA um die 130) unterstützt. Das gilt im Übrigen auch für den inflationären Einsatz der fordernden Raytracing-Features. Weniger ist mehr und wenn es zweckmäßig implementiert wird, dann muss auch keine Karte nach Luft schnappen. In Kombination mit DLSS und Brain 2.0 ist das Gesamtpaket sicher zukunftsweisend, wenn man denn auf solche Dinge steht. Schöner sterben kann Spaß machen, vor allem dann, wenn es nicht mehr in Zeitlupe geschieht. Was AMD am 22.06.2021 dann als quelloffenen DLSS-Konkurrenten anbieten wird, kann aktuell noch nicht beurteilt werden.

Für die Schnellklicker gibt es ja auch noch NVIDIA Reflex. Vorausgesetzt man besitzt eine Ampere-Karte, einen geeigneten G-Sync-Monitor und ein Spiel, wo das Feature im Spiel integriert ist. Dann kann man die Systemlatenzen durchaus noch minimieren. Dazu hatten wir ja unlängst auch einen längeren Artikel. Der Reflex Low Latency-Modus in Spielen wie Valorant oder Apex Legends ist durchaus eine Offerte, aber es wird sich noch durchsetzen müssen. Und dann sind ja auch noch dien fiesen Latenzen im Internet, für die NVIDIA nichts kann, die einem aber den Erfolg schon mal verhageln können. Nur ist die Summe immer kleiner, wenn man wenigsten den Haufen abträgt, der vor der eigenen Tür liegt. Das bringt oft auch schon was. Siehe Artikel.

Und erinnert sich noch wer an die geheimnisvolle SKU20 zwischen der GeForce RTX 3080 und RTX 3090, die ich seinerzeit vor fast einem Jahr mal „geleakt“ hatte ? Ich schrieb dann später beim Launch der GeForce RTX 3080: „Falls es AMD diesmal nicht wieder versemmelt, wird diese SKU20 sicher noch zum Tie-Break beim Pixel-Tennis. Abwarten“ . Und genau da hat sich heute nun die RTX 3080 Ti als Shooting-Star positioniert. Sie ist damit eine RTX 3090 Light mit Hash Light und Preis Light und als Gegenstück zur Radeon RX 6900XT bestens positioniert.

Die Boardpartner werden diesen Chip mit potenten Kühlern sicher noch einmal aufwerten und Power Limits von 440 Watt (wie hier bei einer MSI RTX 3080 Ti SUPRIM) sind dann erst recht der elektrische Sargnagel für die GeForce RTX 3090 FE als Referenz-Objekt.

GeForce RTX 3080 Ti Founders Edition

Die kompakte Founders Edition macht vieles richtig, auch wenn die heftigen Klimmzüge beim Dual-Slot-Design dann doch nicht ganz reichen, um die Karte thermisch und akustisch auf den Thron zu setzen. Optisch und haptisch ist das Teil allererste Sahne und relativ platzsparend dazu. Das mit dem 12-Pin-Stecker ist mittlerweile ein Running-Gag, aber tolerierbar. Außerdem gibt es Adapter-Alternativen, die nicht mal schlecht aussehen. Es ist aber, das muss man neidlos zugestehen, auch das Maximum dessen, was man bei 350 Watt TBP und mehr aus einem so kompakten Kühlerdesign überhaupt herausquetschen kann, ohne sich gleichzeitig das Trommelfell zu zerstören.

Genau deshalb wird auch sie ihre Freunde und Käufer finden, da bin ich mir sicher, falls es sie jemals ohne Glücksfee und Bot zu kaufen gibt. Aber ohne spoilern zu wollen, mit mehr Kühlfläche ginge sicher mehr. Doch die Umsetzung der FE ist smart und spätesten die Platine mit dem Shape-Design macht sie mit Sicherheit mal zu einem begehrten Sammlerstück. Die Größe der Karte liegt in ihrer Größe, der Rest ist zu verschmerzen. Kaufen? Gern. Umbau auf Wasserkühlung? Ginge auch. So gesehen passt das also und man kann bei den Wasserblöcken auch gern die Altkleiderbestände der RTX 3080 FR auftragen.

Der einzige kleine technische Fehler, den ich hier gefunden habe, liegt im Balancing und der sehr exzessiven Nutzung des PEG für die Spannungsversorgung. Das kann man nun tolerieren oder nicht, je nach Interpretation bestehender Normen. Es ist nicht so viel, dass Motherboards gleich Schaden nehmen werden, aber es ist – spätestens nach einem stärkeren OC, auch nichts, das man in den Bereich von Messtoleranzen schieben kann. Dramatisch ist es nicht, aber eben auch nicht kommentarlos zu übergehen.

Fazit und Schlussbemerkung

Einen Kauftipp würde ich gern geben, verkneife ihn mir jedoch fairerweise aufgrund der unklaren Marktsituation. Sagen wir es mal so: Wer die Karte zu einem vernünftigen Preis irgendwo sieht und zufällig auch eine braucht, der darf gern und guten Gewissens zugreifen. Für die UVP von 1199 Euro wäre ein Kauf sogar schon so etwas wie ein Muss. Ich befürchte nur, es wird genauso ein begehrtes Zwischenhandels-Objekt werden, wie schon die anderen aktuellen Grafikkarten. Nur kann hier NVIDIA wieder nichts dafür. Auch die Hersteller haben mit steigenden Preisen und Komponentenverknappung zu kämpfen, wobei der Hauptanteil der überzogenen Preise im nichtproduzierenden Gewerbe zu suchen sein wird.

Die Leistungsaufnahme ist noch einmal gestiegen, die Performance allerdings auch, so dass man nun einer GeForce RTX 3090 FE wohl weniger hinterherträumt als noch vor dem Launch. Warten wir also mal auf die Boardpartnerkarten und das, was die jeweilige Interpretation der Hersteller noch so bietet. Getestet wird das alles natürlich auch noch, Step-by-Step. Langeweile? Eher kaum.

- 1 - Einführung und Testsystem

- 2 - Teardown, Platinenanalyse und Kühler

- 3 - Grafik-Performance: WQHD und Full-HD mit RTX On

- 4 - Grafik-Performance: Ultra-HD mit und ohne DLSS

- 5 - FPS, Perzentile, Frame Time & Varianzen

- 6 - Frametimes vs. Leistungsaufnahme

- 7 - Leistungsaufnahme: GPU und CPU in allen Spielen

- 8 - Leistungsaufnahme: Effizienz im Detail

- 9 - Leistungsaufnahme: Übersicht, Detailanalysen und Power Limits

- 10 - Normeinhaltung, Lastpitzen und Netzteilempfehlung

- 11 - Temperaturen und Infrarot-Tests

- 12 - Geräuschemission / Noise

- 13 - Zusammenfassung. Features und Fazit

57 Antworten

Kommentar

Lade neue Kommentare

Urgestein

1

Mitglied

Urgestein

Veteran

Veteran

1

Urgestein

Mitglied

1

Urgestein

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →