Spiele-Performance

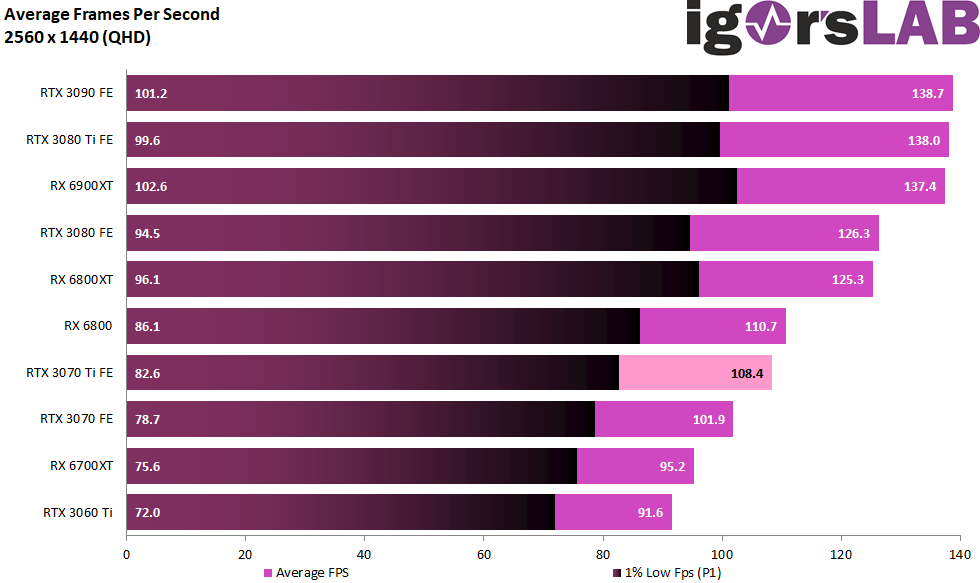

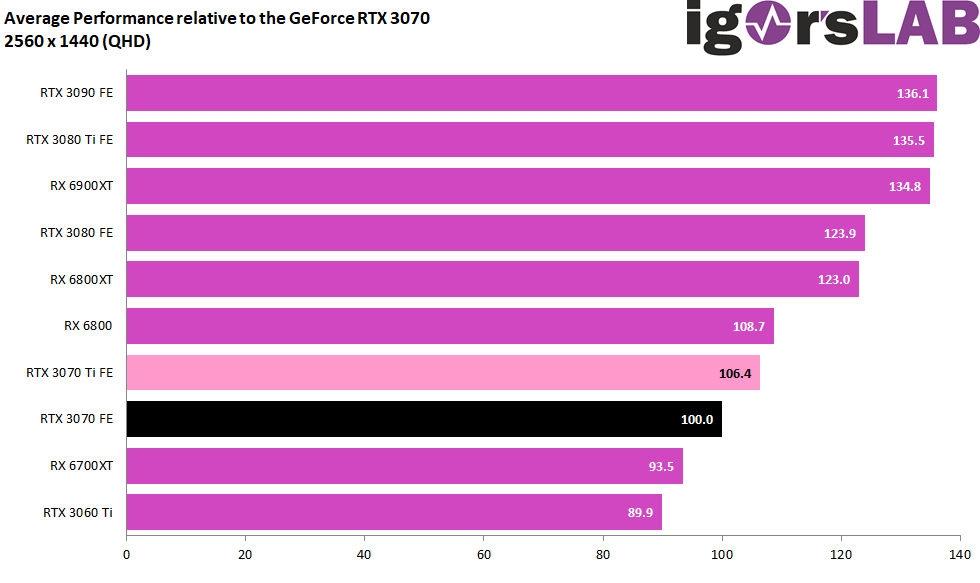

Ohne um den heißen Brei herumzureden: ich war von der Gesamtperformance, vor allem in Anbetracht der doch extrem hohen Leistungsaufnahme, erst einmal enttäuscht. Immer sind es bis zu 65 Watt in WQHD, was so eine GeForce RTX 3070 Ti mehr an Leistung aufnimmt, als eine GeForce RTX 3070 FE. In WQHD erkauft man sich so mit dieser Brechstange einen Vorsprung von nur 6.4 Prozentpunkten, was diese neue Karte im Blick auf die Effizienz soweit zurückwirft, dass selbst manche Turing-Karten nur müde lächeln.

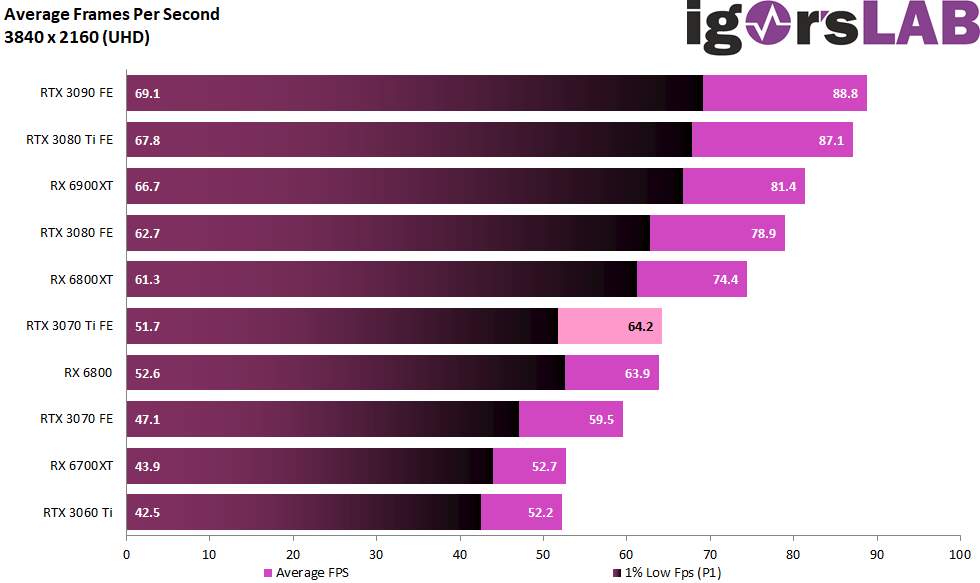

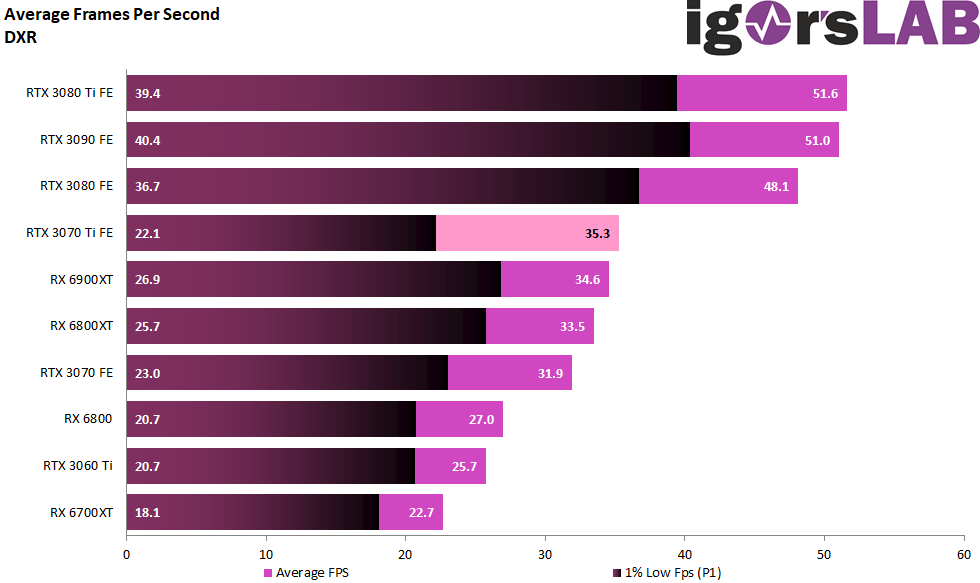

In Ultra-HD schafft man mit deutlich über 70 Watt mehr dann magere 8 Prozentpunkte Vorsprung, was auch nicht wirklich besser ist. Man ist damit so schnell wie eine Radeon RX 6800 ohne XT unterwegs, benötigt aber die gleiche elektrische Energie wie eine Radeon RX 6800XT bzw. RX 6900XT. Gerettet wird die GeForce RTX 3070 Ti nur durch DLSS und in Settings mit DXR, wo die Karte gegenüber den Radeon-Pendants derzeit punkten kann.

Mit aktiviertem Raytracing steigt der Vorsprung auf knapp 11 Prozentpunkte, da lassen die 2 SM mehr nichts anbrennen. Aber wirklich begeistern kann auch das nicht. Der Vollausbau ist mit seinen 48 SM viel zu nah an der GeForce RTX 3070 mit 46 SM, das spürt man auch hier. Die Lücke zur GeForce 3080 FE bleibt auch hier weiterhin schemrzlich bestehen.

Zusammengefasst: Die GeForce RTX 3070 ist nicht in der Lage, die riesige Lücke zwischen der GeForce RTX 3070 und RTX 3080 zu füllen, dazu liegt sie immer noch viel zu nah an der vermeintlich kleineren Karte, die aber unterm Strich das vernünftigere Produkt ist. Der verbaute GDDR6X-Speicher samt seiner höheren Bandbreite wird in keiner einzigen Situation auch nur annähernd benötigt und er ist im Gegenzug mit seinen weit über 20 Watt mehr Leistungsaufnahme ein übler Treiber bei der Leistungsaufnahme.

Der einfache GDDR6 hätte bei den tatsächlich benötigten Bandbreiten locker gereicht und die eher mageren 8 GB Speicherausbau hätte man mit 2-GB-Modulen auch locker vergessen machen können. Dann hätte man ein deutlich runderes Produkt auf den Markt bringen können, dem ein ambitionierter Gamer sicher auch die erhöhte Leistungsaufnahme nachgesehen hätte. Ob es am exklusiven GDDR6X-Deal mit Micron und dem generellen Mangel an „normalem“ GDDR6-Speicher lag, bleibt auch noch offen. Ein abgespeckter GA102 wäre als echter Lückenfüller deutlich sinnvoller gewesen als dieser extrem ausgequetschte Vollausbau.

Die restlichen bis zu 50 Watt mehr gegenüber einer GeForce RTX 3070 sind nicht mit einfacher Logik zu erklären. Es bleibt zu vermuten, dass die Yield an voll funktionsfähigen Chips mittlerweile recht hoch ist und man mit etwas geänderten Spannungs-/Frequenzkurven möglichst viele Chips in den Warenkreislauf überführen wollte. Das wiederum könnte eine Chance für ein sehr erfolgreiches Untervolten eröffnen, wenn man per Zufall einen der besseren Chips erwischt hat. Naja, falls. Stabil konnte ich hier immerhin bis zu 20 Watt einsparen, allerdings ist der Aufwand aus stundenlangem Try & Error kaum einem normalen Kunden aufzuerlegen. Und man muss zudem ja auch Glück haben, denn garantiert wird nichts.

Und selbst mit knapp 280 Watt fällt die Karte dann immer noch aus dem Rahmen. Was sie aus den Augen eines Gamers jedoch etwas rettet, sind die etwas bessere DXR-Performance und am Ende auch DLSS, was einmal mehr zum Matchwinner in Ultra-HD wird. Mit diesen Features kann ein Miner wiederum nichts anfangen, wenn er auf seinem Rig nicht auch noch ab und an selbst spielt.

GeForce RTX 3070 Founders Edition

Die hauseigene Founders Edition ist solide gefertigt, für ein Dual-Slot-Design noch akzeptabel leise bzw. laut und relativ kühl. Optisch und haptisch ist das Teil eine tadellose Offerte, nur der 12-Pin-Adapter sieht immer noch potthässlich aus. Der Kühler macht seinem Namen alle Ehre und es ist beruhigend zu wissen, dass er sogar die 300 Watt noch stemmt. Die Leistungsaufnahme hatte wir ja bereits, wobei die neu gestaltete Platine der hohen TBP sicher Rechnung trägt und durchaus überzeugen kann. Die Original-Platine der RTX 3070 hätte das Mehr an zugeführter Leistung genauso wenig stemmen können, wie der kleinere Kühler die dann nötige Kühlperformance. NVIDIA hat somit genau gewusst, was mit dieser Karte an Leistung wirklich verschleudert wird, warum auch immer.

Fazit und Schlussbemerkung

Generell betrachtet, ist die GeForce RTX 3070 Ti sicher eine Bereicherung des Marktes, auch wenn sie auf den ersten Blick eher überflüssig wirkt. Die Hash-Bremse funktioniert ja nur bei Etherum wirklich und so gesellt sich eine zweite, viel wirksamere und nicht so einfach auszuhebelnde Mining-Bremse hinzu: die mangelnde Effizienz dieser Karte. Das wiederum eröffnet die Chance, dass diese Karten dann vielleicht sogar eher zu kaufen sein werden als eine GeForce RTX 3070. Gamer sind leidensfähig und oft genug begleicht die Energiekosten ja eh die Elternschaft.

Ansonsten lässt mich diese Karte etwas ratlos zurück. Wenn das alles wirklich so geplant und gewollt war, dann frage ich mich wirklich nach den Gründen. Will NVIDIA mit der GeForce RTX 3070 Ti wirklich alles an die Front werfen, was noch als Reserve taugt? Last man standing in Grafikhardware oder geniale Resteverwertung? Die Zeit wird es sicher zeigen.

- 1 - Einführung und Testsystem

- 2 - Teardown, Platinenanalyse und Kühler

- 3 - Gaming Performance WQHD + FHD/RTX

- 4 - Gaming Performance Ultra-HD/DLSS

- 5 - Detailauswertungen alle Spiele

- 6 - Frame Times vs. Power Draw

- 7 - Leistungsaufnahme und Effizienz der Einzelspiele

- 8 - Leistungsaufnahme: Übersicht & Detailansichten

- 9 - PEG, Lastspitzen und Netzteil-Empfehlung

- 10 - Temperaturen und Infrarot-Tests

- 11 - Geräuschemission / Noise

- 12 - Zusammenfassung. Features und Fazit

15 Antworten

Kommentar

Lade neue Kommentare

Veteran

Veteran

Veteran

Mitglied

Urgestein

Mitglied

Veteran

Veteran

Veteran

Mitglied

Urgestein

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →