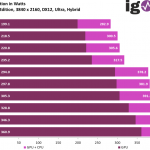

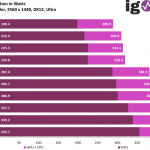

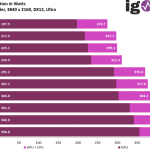

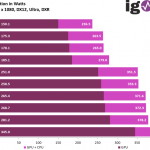

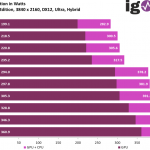

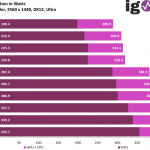

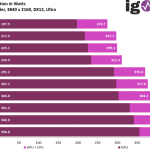

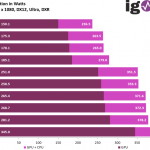

Summe aus CPU und GPU-Leistungsaufnahme

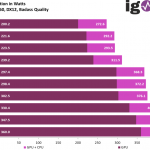

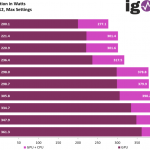

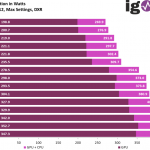

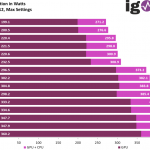

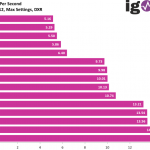

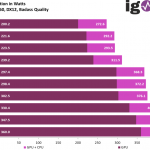

Das muss man wirklich so in der Summe sehen, denn mehr Draw-Calls treiben natürlich auch die CPU-Leistung nach oben und damit auch die Package Power. Im Vergleich sehen wir die gemessene Leistungsaufnahme der GPU als Durchschnittswert für den jeweiligen Benchmark im direkten Vergleich zur Summe aus GPU und der Package Power der CPU:

Borderlands 3 - GPUCPUPower - 2560 x 1440, DX12 Badass Quality

Borderlands 3 - GPUCPUPower - 3840 x 2160, DX12 Badass Quality

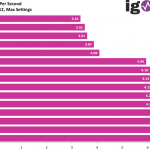

Control - GPUCPUPower - 2560 x 1440, DX12 Max Settings

Control - GPUCPUPower - 3840 x 2160, DX12 Max Settings, DXR

Control - GPUCPUPower - 3840 x 2160, DX12 Max Settings

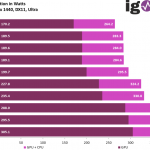

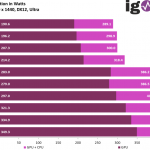

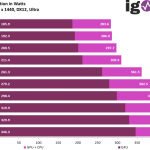

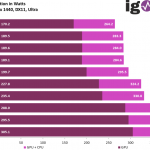

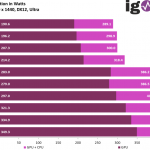

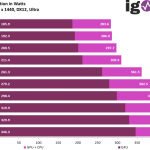

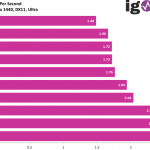

Far Cry New Dawn - GPUCPUPower - 2560 x 1440, DX11 Ultra

Far Cry New Dawn - GPUCPUPower - 3840 x 2160, DX11 Ultra

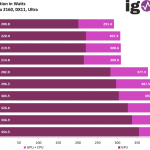

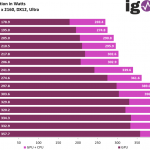

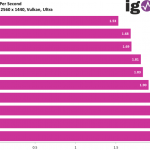

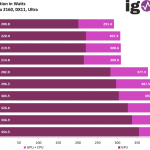

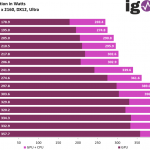

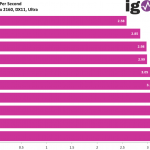

Ghost Recon Breakpoint - GPUCPUPower - 2560 x 1440, Vulkan Ultra

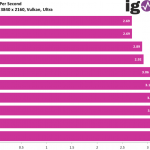

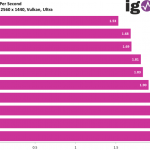

Ghost Recon Breakpoint - GPUCPUPower - 3840 x 2160, Vulkan Ultra

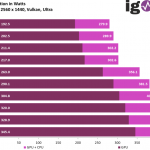

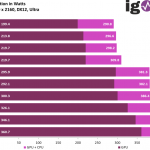

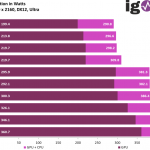

Horizon Zero Dawn - GPUCPUPower - 2560 x 1440, DX12 Ultra

Horizon Zero Dawn - GPUCPUPower - 3840 x 2160, DX12 Ultra

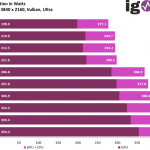

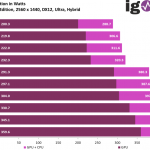

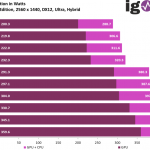

Metro Exodus Enhanced Edition - GPUCPUPower - 2560 x 1440, DX12 Ultra, Hybrid

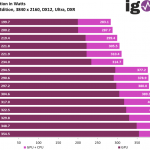

Metro Exodus Enhanced Edition - GPUCPUPower - 3840 x 2160, DX12 Ultra, DXR

Metro Exodus Enhanced Edition - GPUCPUPower - 3840 x 2160, DX12 Ultra, Hybrid

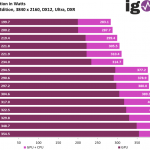

Shadow of the Tomb Raider - GPUCPUPower - 2560 x 1440, DX12 Ultra

Shadow of the Tomb Raider - GPUCPUPower - 3840 x 2160, DX12 Ultra

Watch Dogs Legion - GPUCPUPower - 1920 x 1080, DX12 Ultra, DXR

Watch Dogs Legion - GPUCPUPower - 2560 x 1440, DX12 Ultra

Watch Dogs Legion - GPUCPUPower - 3840 x 2160, DX12 Ultra

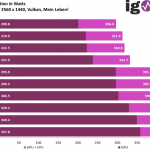

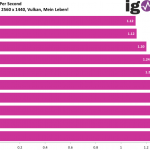

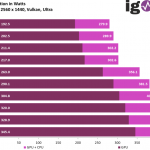

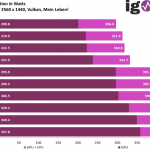

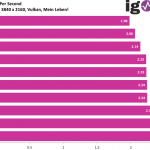

Wolfenstein Youngblood - GPUCPUPower - 2560 x 1440, Vulkan Mein Leben_

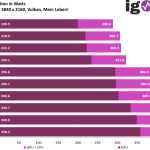

Wolfenstein Youngblood - GPUCPUPower - 3840 x 2160, Vulkan Mein Leben_

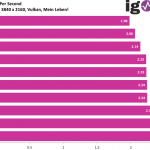

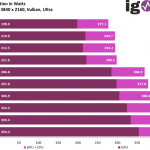

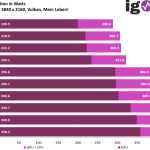

World War Z - GPUCPUPower - 2560 x 1440, Vulkan Ultra

World War Z - GPUCPUPower - 3840 x 2160, Vulkan Ultra

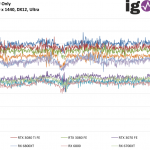

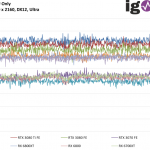

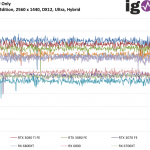

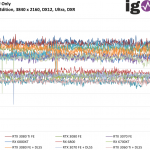

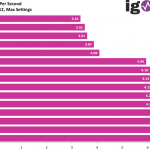

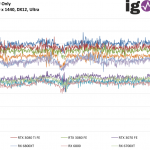

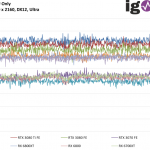

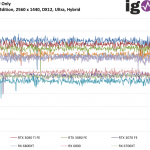

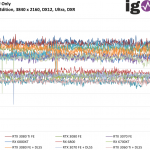

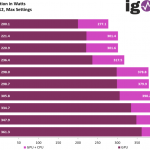

Das geht auch als GPU-only:

Borderlands 3 - GPUPower - 2560 x 1440, DX12 Badass Quality

Borderlands 3 - GPUPower - 3840 x 2160, DX12 Badass Quality

Control - GPUPower - 2560 x 1440, DX12 Max Settings

Control - GPUPower - 3840 x 2160, DX12 Max Settings, DXR

Control - GPUPower - 3840 x 2160, DX12 Max Settings

Far Cry New Dawn - GPUPower - 2560 x 1440, DX11 Ultra

Far Cry New Dawn - GPUPower - 3840 x 2160, DX11 Ultra

Ghost Recon Breakpoint - GPUPower - 2560 x 1440, Vulkan Ultra

Ghost Recon Breakpoint - GPUPower - 3840 x 2160, Vulkan Ultra

Horizon Zero Dawn - GPUPower - 2560 x 1440, DX12 Ultra

Horizon Zero Dawn - GPUPower - 3840 x 2160, DX12 Ultra

Metro Exodus Enhanced Edition - GPUPower - 2560 x 1440, DX12 Ultra, Hybrid

Metro Exodus Enhanced Edition - GPUPower - 3840 x 2160, DX12 Ultra, DXR

Metro Exodus Enhanced Edition - GPUPower - 3840 x 2160, DX12 Ultra, Hybrid

Shadow of the Tomb Raider - GPUPower - 2560 x 1440, DX12 Ultra

Shadow of the Tomb Raider - GPUPower - 3840 x 2160, DX12 Ultra

Watch Dogs Legion - GPUPower - 1920 x 1080, DX12 Ultra, DXR

Watch Dogs Legion - GPUPower - 2560 x 1440, DX12 Ultra

Watch Dogs Legion - GPUPower - 3840 x 2160, DX12 Ultra

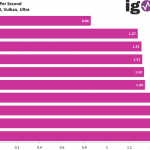

Wolfenstein Youngblood - GPUPower - 2560 x 1440, Vulkan Mein Leben_

Wolfenstein Youngblood - GPUPower - 3840 x 2160, Vulkan Mein Leben_

World War Z - GPUPower - 2560 x 1440, Vulkan Ultra

World War Z - GPUPower - 3840 x 2160, Vulkan Ultra

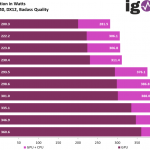

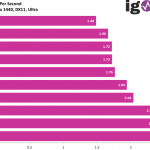

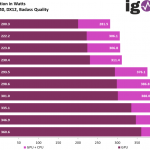

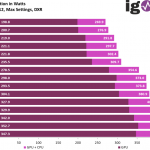

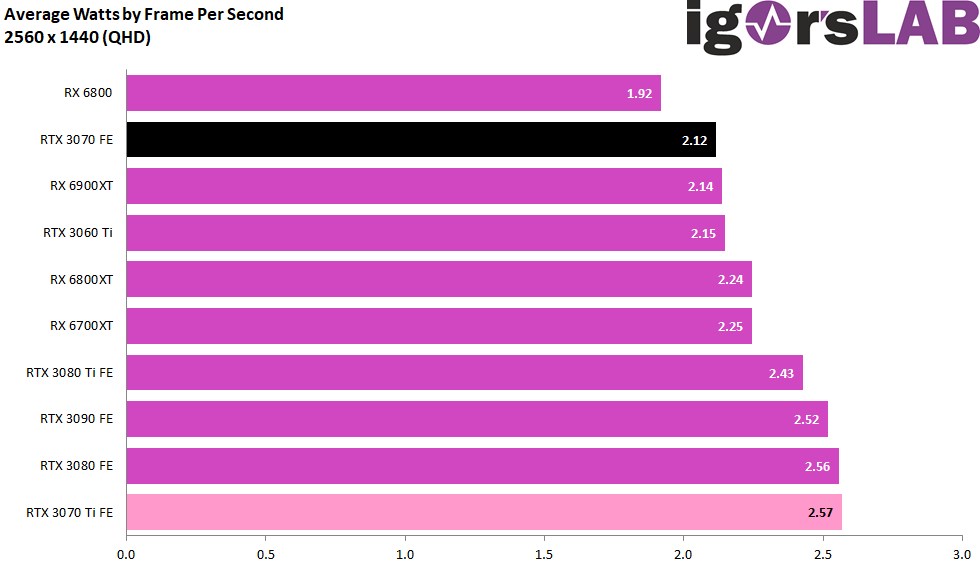

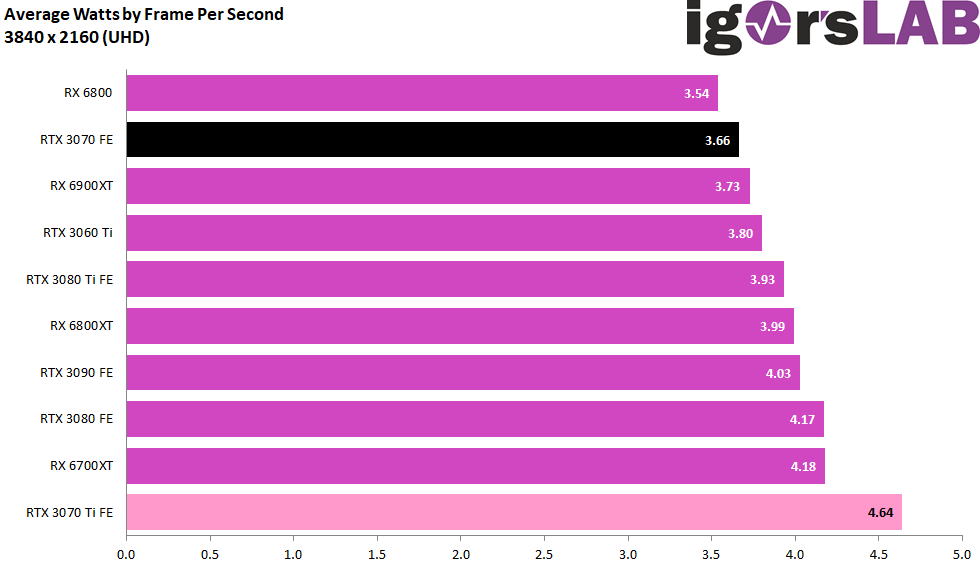

Die Balken sind in der Summe natürlich übersichtlicher:

Borderlands 3 - AvWatt_DE - 2560 x 1440, DX12 Badass Quality

Borderlands 3 - AvWatt_DE - 3840 x 2160, DX12 Badass Quality

Control - AvWatt_DE - 2560 x 1440, DX12 Max Settings

Control - AvWatt_DE - 3840 x 2160, DX12 Max Settings, DXR

Control - AvWatt_DE - 3840 x 2160, DX12 Max Settings

Far Cry New Dawn - AvWatt_DE - 2560 x 1440, DX11 Ultra

Far Cry New Dawn - AvWatt_DE - 3840 x 2160, DX11 Ultra

Ghost Recon Breakpoint - AvWatt_DE - 2560 x 1440, Vulkan Ultra

Ghost Recon Breakpoint - AvWatt_DE - 3840 x 2160, Vulkan Ultra

Horizon Zero Dawn - AvWatt_DE - 2560 x 1440, DX12 Ultra

Horizon Zero Dawn - AvWatt_DE - 3840 x 2160, DX12 Ultra

Metro Exodus Enhanced Edition - AvWatt_DE - 2560 x 1440, DX12 Ultra, Hybrid

Metro Exodus Enhanced Edition - AvWatt_DE - 3840 x 2160, DX12 Ultra, DXR

Metro Exodus Enhanced Edition - AvWatt_DE - 3840 x 2160, DX12 Ultra, Hybrid

Shadow of the Tomb Raider - AvWatt_DE - 2560 x 1440, DX12 Ultra

Shadow of the Tomb Raider - AvWatt_DE - 3840 x 2160, DX12 Ultra

Watch Dogs Legion - AvWatt_DE - 1920 x 1080, DX12 Ultra, DXR

Watch Dogs Legion - AvWatt_DE - 2560 x 1440, DX12 Ultra

Watch Dogs Legion - AvWatt_DE - 3840 x 2160, DX12 Ultra

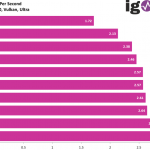

Wolfenstein Youngblood - AvWatt_DE - 2560 x 1440, Vulkan Mein Leben_

Wolfenstein Youngblood - AvWatt_DE - 3840 x 2160, Vulkan Mein Leben_

World War Z - AvWatt_DE - 2560 x 1440, Vulkan Ultra

World War Z - AvWatt_DE - 3840 x 2160, Vulkan Ultra

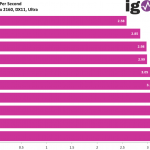

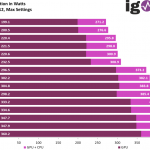

CPU-Leistungsaufnahme

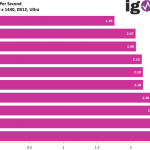

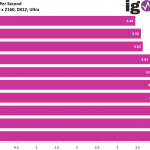

Die CPU-Leistungsaufnahme habe ich noch einmal extra gemacht, weil sie eigentlich hochinteressant ist und auch ein gutes Feeling über Bottlenecks vermittelt. Auch hier wieder alles im Detail, die jeweiligen Settings seht Ihr ja in der Chartsgrafik. Im Verlauf über die Benchmarkzeit sieht das dann so aus:

Borderlands 3 - AvWattCPU_DE - 2560 x 1440, DX12 Badass Quality

Borderlands 3 - AvWattCPU_DE - 3840 x 2160, DX12 Badass Quality

Control - AvWattCPU_DE - 2560 x 1440, DX12 Max Settings

Control - AvWattCPU_DE - 3840 x 2160, DX12 Max Settings, DXR

Control - AvWattCPU_DE - 3840 x 2160, DX12 Max Settings

Far Cry New Dawn - AvWattCPU_DE - 2560 x 1440, DX11 Ultra

Far Cry New Dawn - AvWattCPU_DE - 3840 x 2160, DX11 Ultra

Ghost Recon Breakpoint - AvWattCPU_DE - 2560 x 1440, Vulkan Ultra

Ghost Recon Breakpoint - AvWattCPU_DE - 3840 x 2160, Vulkan Ultra

Horizon Zero Dawn - AvWattCPU_DE - 2560 x 1440, DX12 Ultra

Horizon Zero Dawn - AvWattCPU_DE - 3840 x 2160, DX12 Ultra

Metro Exodus Enhanced Edition - AvWattCPU_DE - 2560 x 1440, DX12 Ultra, Hybrid

Metro Exodus Enhanced Edition - AvWattCPU_DE - 3840 x 2160, DX12 Ultra, DXR

Metro Exodus Enhanced Edition - AvWattCPU_DE - 3840 x 2160, DX12 Ultra, Hybrid

Shadow of the Tomb Raider - AvWattCPU_DE - 2560 x 1440, DX12 Ultra

Shadow of the Tomb Raider - AvWattCPU_DE - 3840 x 2160, DX12 Ultra

Watch Dogs Legion - AvWattCPU_DE - 1920 x 1080, DX12 Ultra, DXR

Watch Dogs Legion - AvWattCPU_DE - 2560 x 1440, DX12 Ultra

Watch Dogs Legion - AvWattCPU_DE - 3840 x 2160, DX12 Ultra

Wolfenstein Youngblood - AvWattCPU_DE - 2560 x 1440, Vulkan Mein Leben_

Wolfenstein Youngblood - AvWattCPU_DE - 3840 x 2160, Vulkan Mein Leben_

World War Z - AvWattCPU_DE - 2560 x 1440, Vulkan Ultra

World War Z - AvWattCPU_DE - 3840 x 2160, Vulkan Ultra

Effizienzbetrachtung

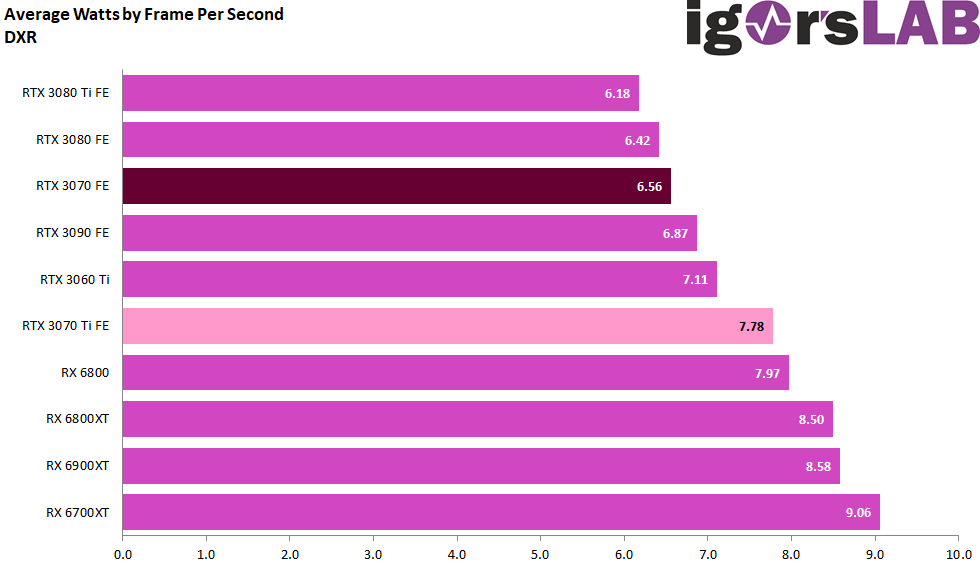

Um die Effizienz wirklich sauber beurteilen zu können, habe ich für jeden einzelnen Benchmark, dessen Ergebnisse wir ja schon kennen, auch die Leistungsaufnahme detailliert gemessen, die wir im Detail auf der vorigen Seite ebenfalls schon sehen konnten. Doch was erwartet uns, wenn wir die beiden Werte nun sinnvoll zueinander ins Verhältnis setzen? Wieviel Watt an Leistungsaufnahme kostet mich ein einzelner Frame pro Sekunde (mehr oder weniger)? Die Erkenntnis ist durchaus verblüffend.

Das kann man nun für alle Spiele zusammenrechnen und ein kumuliertes Ergebnis ausweisen. Die neue GeForce RTX 3070 Ti ist im Test die mit Abstand ineffizienteste Karte, das ließ sich aus der Leistungsaufnahme in den einzelnen Spielen bereits erahnen:

Hier sind als Beleg noch einmal alle Spiele als Einzeldiagramm:

Borderlands 3 - AvWattFPS_DE - 2560 x 1440, DX12 Badass Quality

Borderlands 3 - AvWattFPS_DE - 3840 x 2160, DX12 Badass Quality

Control - AvWattFPS_DE - 2560 x 1440, DX12 Max Settings

Control - AvWattFPS_DE - 3840 x 2160, DX12 Max Settings, DXR

Control - AvWattFPS_DE - 3840 x 2160, DX12 Max Settings

Far Cry New Dawn - AvWattFPS_DE - 2560 x 1440, DX11 Ultra

Far Cry New Dawn - AvWattFPS_DE - 3840 x 2160, DX11 Ultra

Ghost Recon Breakpoint - AvWattFPS_DE - 2560 x 1440, Vulkan Ultra

Ghost Recon Breakpoint - AvWattFPS_DE - 3840 x 2160, Vulkan Ultra

Horizon Zero Dawn - AvWattFPS_DE - 2560 x 1440, DX12 Ultra

Horizon Zero Dawn - AvWattFPS_DE - 3840 x 2160, DX12 Ultra

Metro Exodus Enhanced Edition - AvWattFPS_DE - 2560 x 1440, DX12 Ultra, Hybrid

Metro Exodus Enhanced Edition - AvWattFPS_DE - 3840 x 2160, DX12 Ultra, DXR

Metro Exodus Enhanced Edition - AvWattFPS_DE - 3840 x 2160, DX12 Ultra, Hybrid

Shadow of the Tomb Raider - AvWattFPS_DE - 2560 x 1440, DX12 Ultra

Shadow of the Tomb Raider - AvWattFPS_DE - 3840 x 2160, DX12 Ultra

Watch Dogs Legion - AvWattFPS_DE - 1920 x 1080, DX12 Ultra, DXR

Watch Dogs Legion - AvWattFPS_DE - 2560 x 1440, DX12 Ultra

Watch Dogs Legion - AvWattFPS_DE - 3840 x 2160, DX12 Ultra

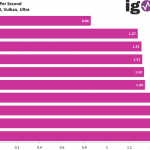

Wolfenstein Youngblood - AvWattFPS_DE - 2560 x 1440, Vulkan Mein Leben_

Wolfenstein Youngblood - AvWattFPS_DE - 3840 x 2160, Vulkan Mein Leben_

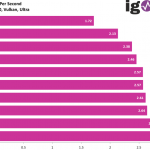

World War Z - AvWattFPS_DE - 2560 x 1440, Vulkan Ultra

World War Z - AvWattFPS_DE - 3840 x 2160, Vulkan Ultra

15 Antworten

Kommentar

Lade neue Kommentare

Veteran

Veteran

Veteran

Mitglied

Urgestein

Mitglied

Veteran

Veteran

Veteran

Mitglied

Urgestein

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →