Platinenanalyse und Spannungsversorgung

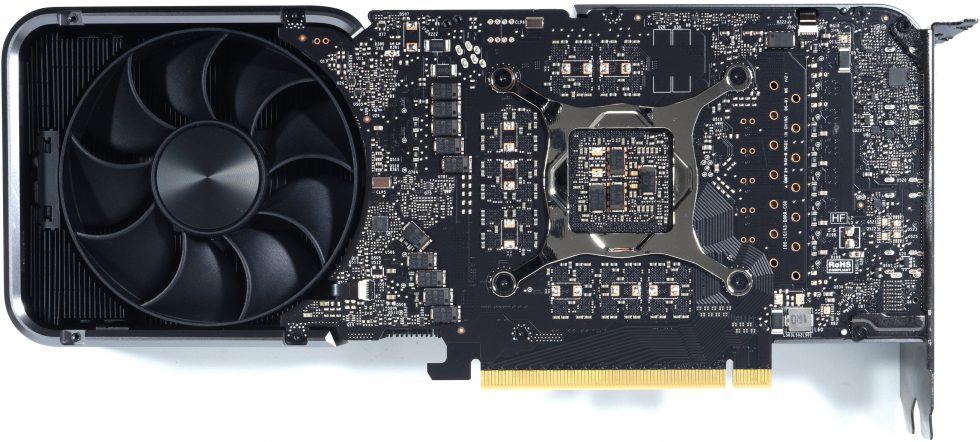

Die Founders Edition besitzt mit der PG143A eine komplett neu gestaltete Platine. Während die Boardpartner meist die Platinen der eigenen RTX 3070 Custom Modelle weiternutzen, hat NVIDIA für die FE alles neu gemacht. Diese Platine ist ein Mittelding des Shaped Designs der RTX 3080 und der eher biederen Variante für die RTX 3070. Eine sicher interessante Randnotiz dazu ist auch, dass die AIC speziell zu dieser Platine keine Design-Vorlagen bekamen und nicht wissen, welches Eigendesign NVIDIA da genau plante.

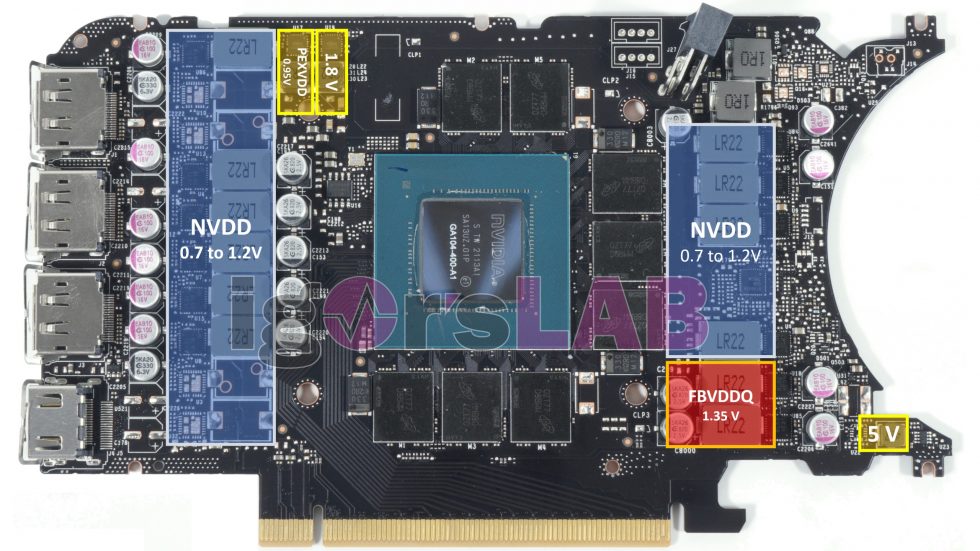

Und sonst? Die Art der Spannungsversorgung für die GPU ist wieder eingleisig und man verzichtet auf die Zweiteilung der Hauptspannungsversorgung. MSVDD entfällt also und es verbleibt nur noch NVVDD (Blau). Hierbei handelt es sich um die herkömmliche Core-Voltage, also das, was wir gern als GPU- Spannung bezeichnen. Es sind insgesamt nur 5 einzelne Phase, die entweder von einem uP9511P oder dem Pin-kompatiblen NCP81610 (je nach Verfügbarkeit) erzeugt werden. Jede der 5 Phasen kann dabei zwei Spannungswandler gleichzeitig, also parallel ansteuern, so dass wir für NVDD auf insgesamt 10 Spannungswandler an nur 5 Phasen kommen.

Diese 10 Regelkreise werden jeweils mit den etwas günstigeren 50-A Powerstages AOZ5311NQI von Alpha & Omega bestückt, die keine echte MOSFET DCR ermöglichen, jedoch eine Temperatur-Schutzschaltung und einen Auslese-Ausgang bieten. Der Spannungsspielraum bei NVVDD liegt zwischen 0.7 und maximal 1.2 Volt, wobei der Maximalwert ohne spezielle Firm- und Software vom Endanwender eh nie erreicht werden kann. Für den leistungshungrigen GDDR6X-Speicher (FBVDDQ) nutzt NVIDIA insgesamt 2 Phasen, die von einem günstigen Step-Down-Converter in Form des RT8845A generiert werden. Die Powerstages sind die gleichen wie bei NVDD.

Zur Eingangsglättung nutzt man jeweils eine Spule mit 1 µH hinter denen ein Shunt liegt sowohl für den 12-Pin-Anschluss, als auch für den PEG Motherboard-Slot (auf der Rückseite). Über den Spannungsabfall des Shunts misst man die fließenden Ströme. Dafür kommt ein uS5650Q von UPI zum Einsatz (Rückseite). Auf Vorderseite neben der GPU sieht man noch die 8, jeweils 1 GB großen GDDR6X-Module von Micron mit 19 Gbps. Mehr Aufreger gibt es nicht.

Zur Eingangsglättung nutzt man jeweils eine Spule mit 1 µH hinter denen ein Shunt liegt sowohl für den 12-Pin-Anschluss, als auch für den PEG Motherboard-Slot (auf der Rückseite). Über den Spannungsabfall des Shunts misst man die fließenden Ströme. Dafür kommt ein uS5650Q von UPI zum Einsatz (Rückseite). Auf Vorderseite neben der GPU sieht man noch die 8, jeweils 1 GB großen GDDR6X-Module von Micron mit 19 Gbps. Mehr Aufreger gibt es nicht.

Kühler und Demontage

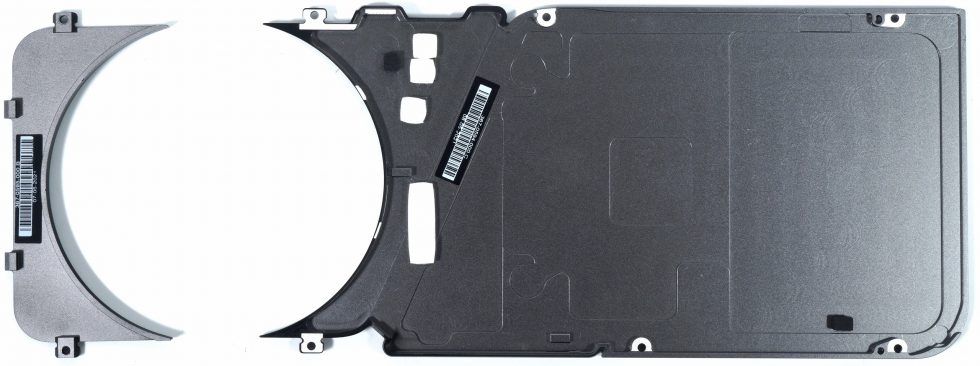

Das Auseinandernehmen des Kühler ist diesmal einfach. Neun knuffige Torx 8 Schräubchen lösen und weg ist die zweiteilige Backplate, vier weitere und die Slot-Blende fällt auch. Der Rest ist dann schnell erledigt, nur die Befestigung mit dem Spannkreis ist nicht mehr quadratisch, sondern rechteckig. Torx 6 und fertig. Der Body ist überwiegend aus Leichtmetall mit einer recht cleveren Oberfläche gefertigt und fasst sich wertig an. Der eigentliche Kühler ist mehrteilig und besteht aus einem effizienten Vollkupfer-Heatsink an dessen Rückseite fünf Heatpipes verlötet wurden, von denen sich dann vier längs bis zum Kartenende hinziehen und eine zur Slotblende führt.

Über dem Heatsink und dem offenen Aufbau sitzen insgesamt zwei PWM-geregelte 8,5-cm-Lüfter mit einer sehr interessanten Rotorblatt-Geometrie, die fast schon an das Design von Radial-Lüftern erinnert. Nun ja, fast. Aber auch die maximale Drehzahl der beiden getrennt geregelten Lüfter von bis zu 3800 bzw. 3400 U/min lässt erst einmal Böses vermuten, es kann aber auch leise bleiben. Je nachdem, was wirklich abgerufen wird. Wollen wir mal hoffen, dass es hier deutlich leiser bleibt, als die Karte könnte, wenn sie denn müsste.

Die Backplate besteht ebenfalls aus Leichtmetall, das man außen mattschwarz beschichtet hat. Der Hersteller verbindet thermisch einen begrenzten Bereich unter den Spulen der NVVDD-Phasen mit der Backplate, hat aber einige Bereiche (leider) ausgelassen.

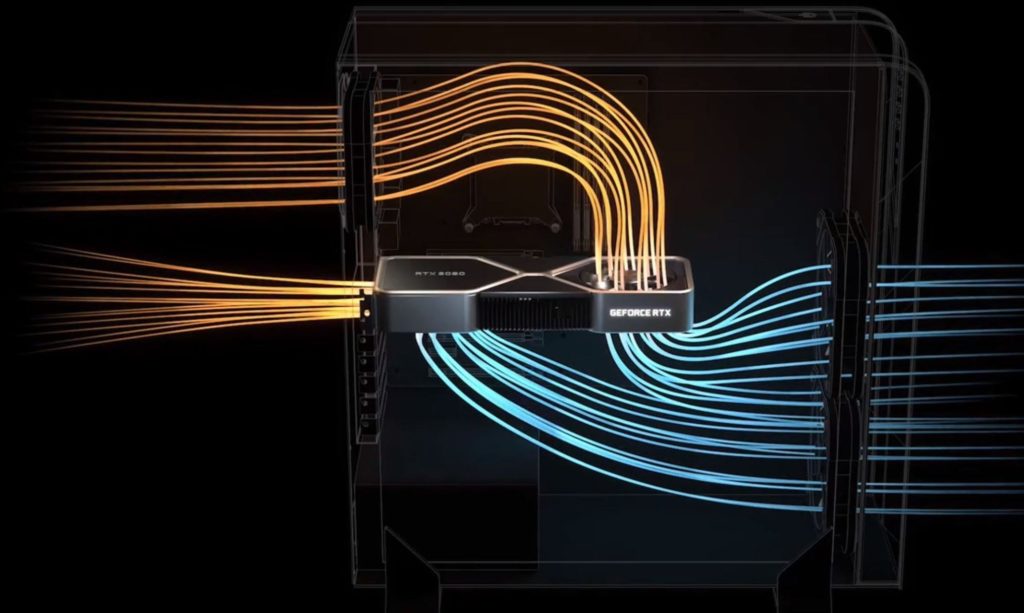

Über das Prinzip mit den verschiedenen Ansaug- und Ausblasrichtungen wurde ja schon ausgiebig spekuliert, so dass ich mich nicht mehr wiederhole, sondern nur noch einmal die Folie bemühe. Den Test im geschlossenen Gehäuse sehen wir dann ja eh noch.

- 1 - Einführung und Testsystem

- 2 - Teardown, Platinenanalyse und Kühler

- 3 - Gaming Performance WQHD + FHD/RTX

- 4 - Gaming Performance Ultra-HD/DLSS

- 5 - Detailauswertungen alle Spiele

- 6 - Frame Times vs. Power Draw

- 7 - Leistungsaufnahme und Effizienz der Einzelspiele

- 8 - Leistungsaufnahme: Übersicht & Detailansichten

- 9 - PEG, Lastspitzen und Netzteil-Empfehlung

- 10 - Temperaturen und Infrarot-Tests

- 11 - Geräuschemission / Noise

- 12 - Zusammenfassung. Features und Fazit

15 Antworten

Kommentar

Lade neue Kommentare

Veteran

Veteran

Veteran

Mitglied

Urgestein

Mitglied

Veteran

Veteran

Veteran

Mitglied

Urgestein

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →