Rückgabewerte und Telemetrie

Bei einigen Rückgabewerte in Drittanbieterprogrammen muss man aufmerksam beobachten, was angezeigt wird. Denn auch die Taktraten werden beispielsweise nicht immer sauber wiedergegeben. Auch wenn es zwischen 2448 MHz und 2450 MHz kaum einen Unterschied gibt hier sollte es sich eher um Umrechnungsfehler handeln, denn ab und an wurde auch schon mal null zurückgeliefert, auch wenn es keine Framedrops gab. Auch der gemeldeten Leistungsaufnahme traue ich nicht wirklich, da sich der Wert einerseits nur exklusiv auf die GPU (und nicht die ganze Karte) bezieht und andererseits nicht immer genau mit dem korreliert (Lastwechsel), was man direkt am PCIe-Anschluss messen konnte.

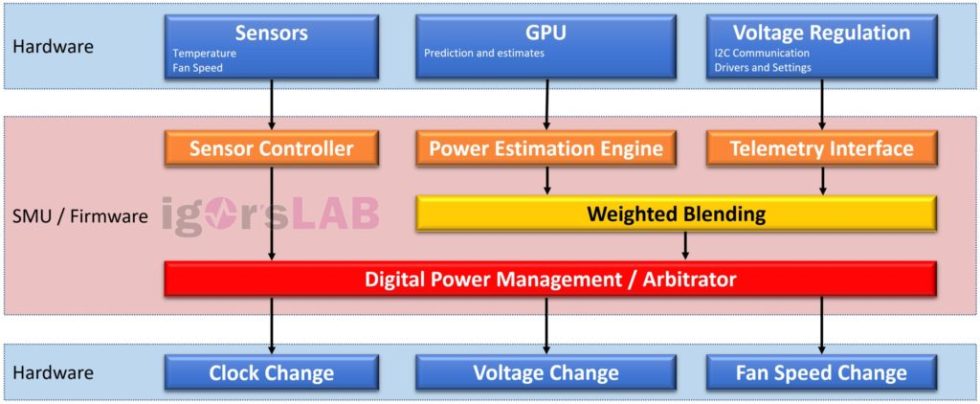

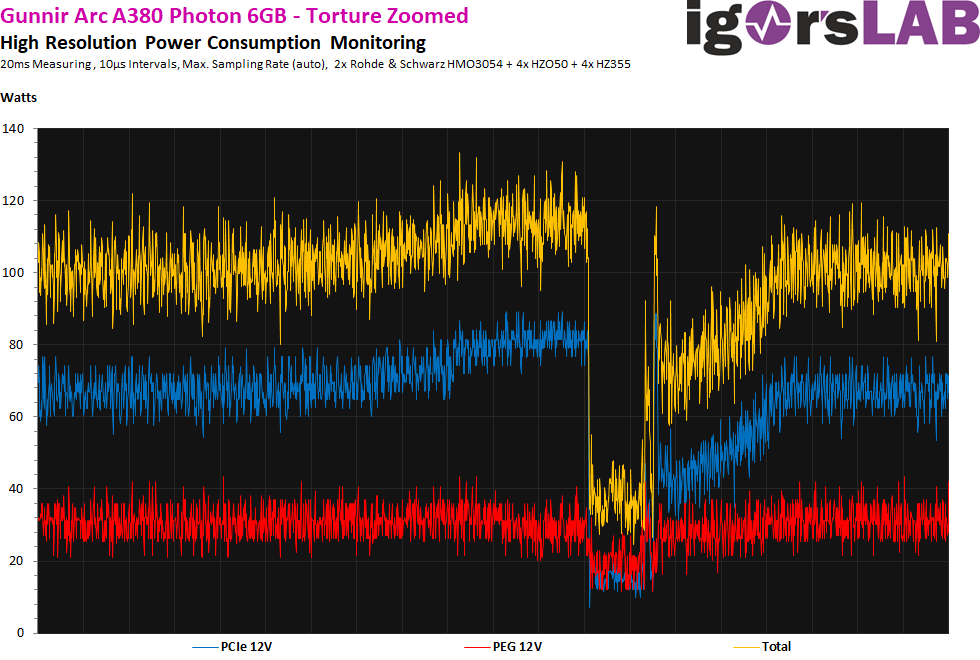

Generell scheint der Arbitrator deutlich granulärer zu arbeiten (also viel gröber als bei AMDs Power Tune oder NVIDIAs Boost) und eine echte Power-Estimation findet scheinbar auch nicht statt. Das erklärt dann sicher auch die explodierende Leistungsaufnahme bei Dauerlasten wie Compute oder in Stresstests. Im Gegensatz zur Radeon RX 6400 ist der Einbruch bei zu hoher Last mehr als zehnmal so lang und auch der Kurvenverlauf bis zum Einbruch ist aufsteigend und nicht absteigend. Das erinnert dann schon an einen gewissen Schluckauf und könnte auch eine (von mehreren) Ursachen für die eher bescheidene Bildausgabe sein.

Resizeable Bar (rBAR)

Ohne dieses im Motherboard aktivierte Feature für den direkten Zugriff auf den erweiterten Adressbereich, ist die Karte quasi hilflos und extrem langsam. Das trifft eigentlich immer zu, selbst wenn Spiele oder sogar Workstation-Anwendungen laufen, die rBAR offiziell gar nicht nutzen bzw. dahingehend optimiert wurden. Ich erwähnte beim Teardown ja bereits den MX25U6432F von Macronix und die Vermutung, dass hier Intel-Microcode nachgeladen werden muss, der sich nicht auf aktuellen Ryzen-Systemen befindet. Das erklärt dann zumindest auch, warum ein Ryzen 7 5800 X3D auf einem MSI MEG X570 Godlike mit allerneuestem BIOS genauso schlechte Resultate in Benchmarks generiert, wie das verwendete Z690-Board mit deaktiviertem rBAR. Das deckte sich bei den Resultaten manchmal sogar bis fast auf die Nachkommastelle.

Sollte sich das bei den größeren Karten analog fortsetzen, dann hat Intel hier bewusst eine knallharte Trennung von anderen (und eigenen älteren) Plattformen implementiert, die in dieser Form für den nichtsahnenden Kunden völlig inakzeptabel ist. Intel-Karten performen somit nur auf einigen aktuellen Intel-Motherboards? Das sollte, wenn es sich so fortsetzt, unbedingt öffentlich ausdiskutiert werden.

Übertaktung

Das Arc Control Center ermöglicht eine Übertaktung um maximal 100 MHz. Schiebt man den Regler weiter noch rechts, landet man statt bei den maximal möglichen 2550 MHz wieder auf den 2450 MHz und noch weiter rechts (falls man sich mal vertut) friert das komplette System unrettbar ein, weil alles in Echtzeit übernommen wird und man sich den Übernehmen-Knopf gespart hat. Sinnlos, zumal das ganze GUI eher den Charakter einer unfertigen Frickelware besitzt, der wichtige Funktionen abgehen. Man fragt sich, was seit der Ankündigung der Software vor drei Jahren (!) und heute wirklich passiert ist.

Die 2550 MHz bekommt man bei ca. 20% voreingestellter Leistungssteigerung, wenn man VORHER den Offset für die Spannung angehoben hat. Vergisst man das aus Versehen mal, gibt es mit etwas Pech auch gleich wieder ein eingefrostetes System. Hat man dann noch den Haken gesetzt, dass die Werte beim Windows-Start automatisch übernommen werden sollen, dann Gute Nacht. Da hilft nur eine zweite artfremde Grafikkarte und das Entfernen des Arc Control Centers nach dem Reboot.

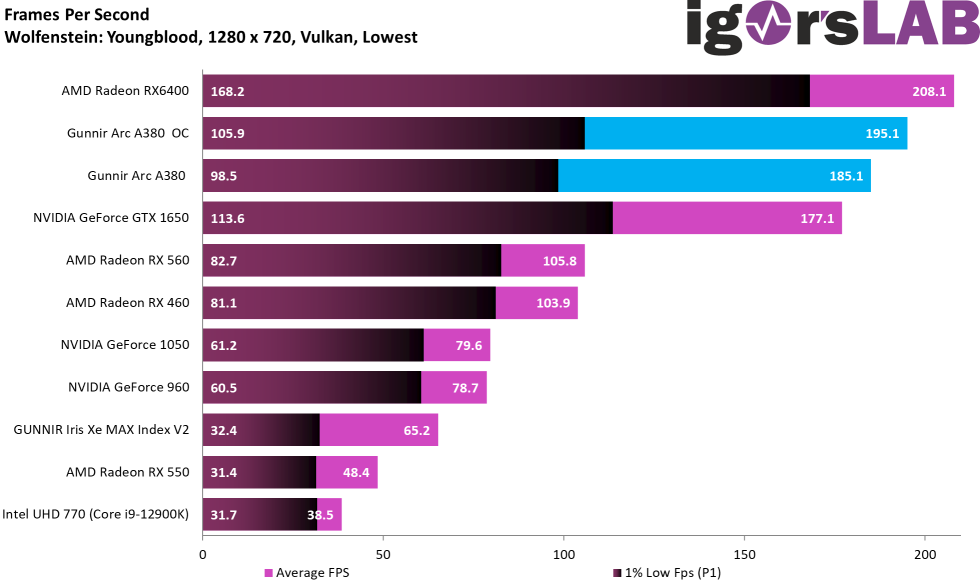

Dann gab es z.B. eine russischen YouTuber, welcher der Arc A380 ein „gewaltiges“ Übertaktungspotential bescheinigte, wobei bei ihm der prozentuale Leistungszuwachs bei den Durchschnitts-FPS sogar weit über über dem Taktzuwachs lag. Auch das P1 (die Min-FPS als Perzentil mit dem 1% Low) soll zugelegt haben. Ja, das stimmt (in gewissen Grenzen), aber es ist viel zu oberflächlich betrachtet, da die Karte noch eine Eigenheit besitzt, die man mit dem P1 so einfach nicht immer erfassen kann. Genau dazu komme ich jetzt. Auch im Vergleich zur Radeon RX 6400 (danke an CAPACYTOR für die Unterstützung!) im Bild unten links und eine GTX 1650 Gaming von MSI (nicht im Bild).

Extrem schlechte Frame Times und Varianzen

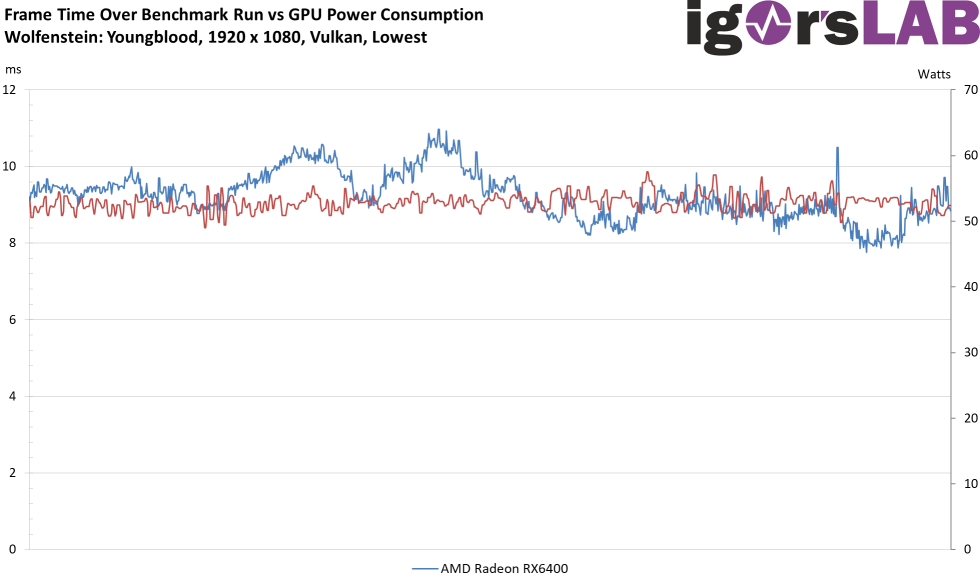

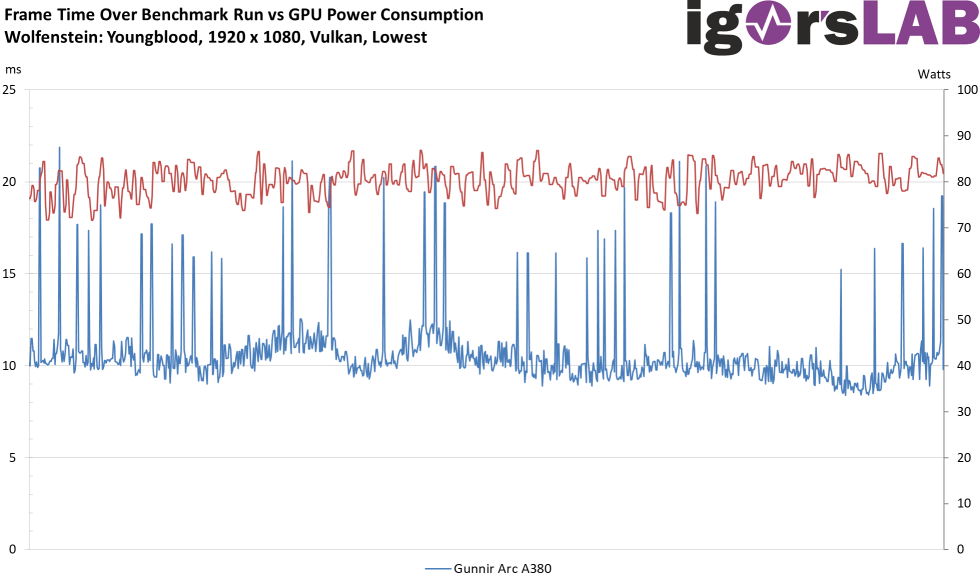

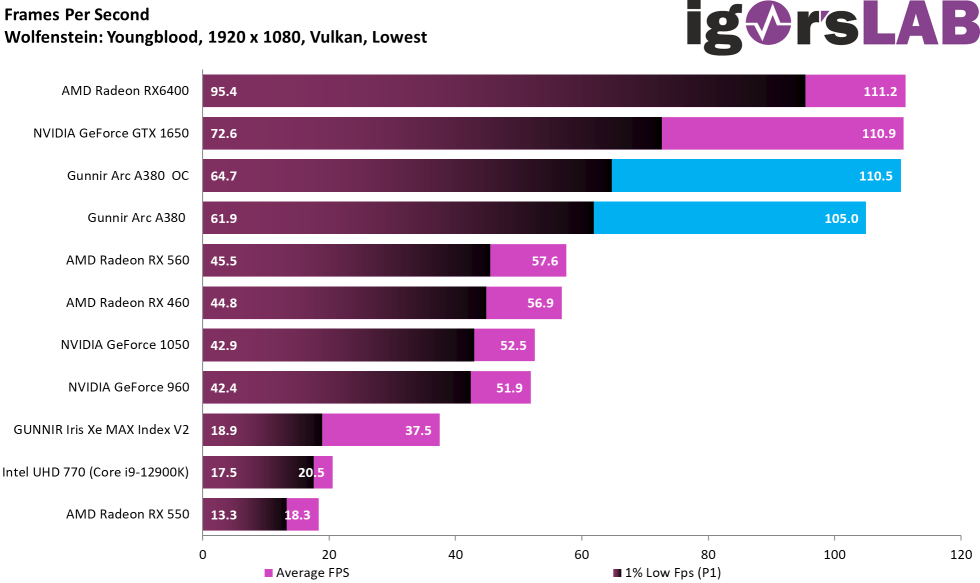

Ich stelle jetzt hier bewusst ein Spiel einmal exemplarisch voran, damit Ihr Euch auf den nächsten Seiten nicht von den Benchmarkbalken blenden lasst. Bereits das P1 zeigt zwar, dass die Frame Times bei Intels Arc A380 deutlich schlechter ausfallen als bei den beiden anderen Karten, aber das ist so schnell nicht ersichtlich. Außerdem leidet die Arc A380 auch am Treiber-Flaschenhals, wenn auch nicht ganz zu schlimm wie die GeForce GTX 1650. Das ist die erste Erkenntnis, doch es kommt noch viel schlimmer.

Generell ist es egal, ob die Arc A380 nun in 720p oder 1080p läuft, die Frame Times, also die Renderzeit der Einzelbilder, und es hoppelt (je nach Spiel mehr oder weniger) wie verrückt. Ich habe allerdings die 1080p-Messung genommen, weil ich den Flaschenhals nicht noch mit inkludieren wollte. Man kann trotzdem immer noch einen in der Summe deutlich unrunderen Bildlauf erkennen (Micro-Ruckler). Dafür muss man nur einmal die smooth agierende Radeon RX 6400 mit der Arc A380 jeweils ohne und mit OC vergleichen. Ich denke, die Bilder sprechen hier klar für sich!

Wer das noch nicht glaubt, muss sich einfach nur mal die Varianzen ansehen, denn das wird nicht besser und sogar die iGP des Core i9-12900K performt ausgeglichener:

Wer das noch nicht glaubt, muss sich einfach nur mal die Varianzen ansehen, denn das wird nicht besser und sogar die iGP des Core i9-12900K performt ausgeglichener:

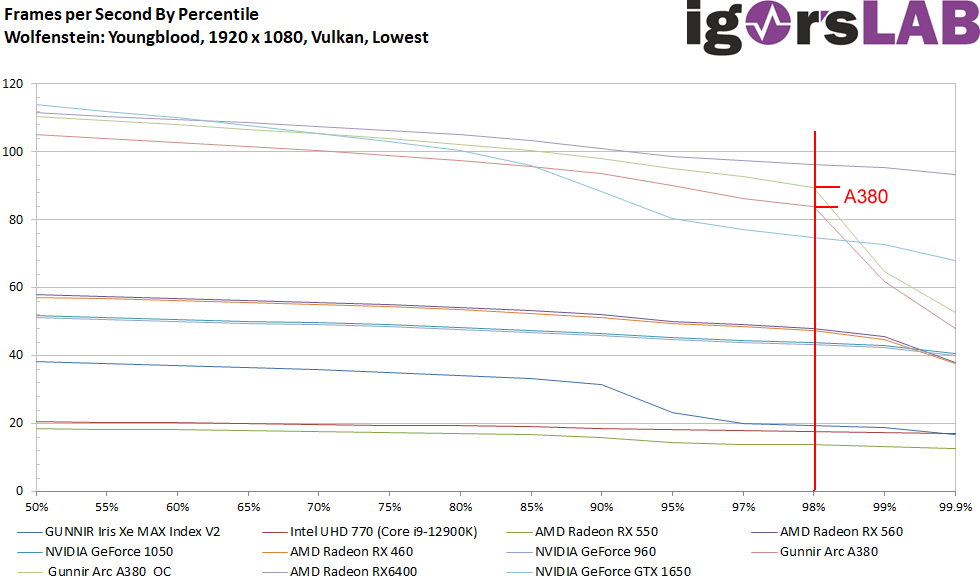

Stellt man die Perzentile mal als Kurve dar, dann sehen wir auch, dass man die Min-FPS durch die Menge an Spikes eigentlich sogar als 2% Low darstellen müsste, um objektiv zu bleiben und nicht nur als 1% Low („99th percentile“). Womit spätestens jetzt klar ist, warum Influencer oftmals weit unterhalb der nötigen Sorgfalt agieren. Entweder können sie es nicht besser oder wollen/dürfen es nicht.

- 1 - Einführung, Vorbemerkung, technische Daten und Testsystem

- 2 - Unboxing und Karten-Details

- 3 - Teardown: PCB und Kühler

- 4 - Telemetrie, Übertaktung, Bottleneck und Mikroruckler

- 5 - FPS - Frames Per Second

- 6 - FPS - Curves

- 7 - Percentiles - Curves

- 8 - Frame Times - Percentage shares as a bar chart

- 9 - Frame Times - Curves

- 10 - Variances - Percentage shares as a bar chart

- 11 - AutoCAD 2021 und Inventor Pro 2021

- 12 - 3ds Max, Catia, Creo, Energy

- 13 - Maya, Medical, Siemens NC, SW 2017

- 14 - Leistungsaufnahme als Gesamtbetrachtung, Messungen

- 15 - Lastspitzen und Netzteil-Empfehlung

- 16 - Leistungsaufnahme einzeln für alle Spiele

- 17 - Eifizienzbetrachtung für jedes einzelne Spiel

- 18 - Takt, Temperaturen, Lüfter, Lautstärke

- 19 - Zusammenfassung und Fazit

97 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Urgestein

1

Urgestein

Moderator

Mitglied

Veteran

1

Mitglied

Mitglied

Urgestein

1

Urgestein

Urgestein

Mitglied

Veteran

Urgestein

1

Alle Kommentare lesen unter igor´sLAB Community →