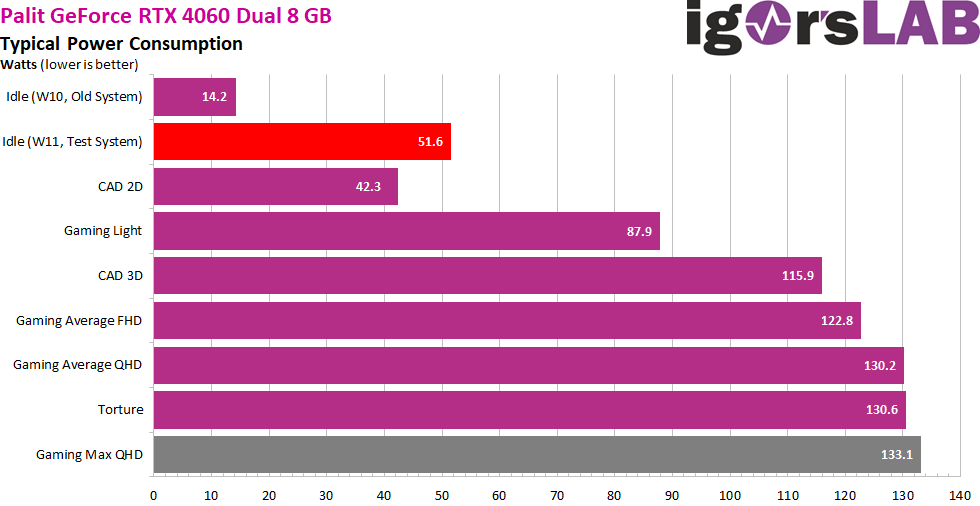

Leistungsaufnahme im Werkszustand als Zusammenfassung

Die rund 52 Watt im Idle sind eine Zumutung. Ich habe die gesamte Problematik der Leistungsaufnahme, also sowohl das mit den deutlich höheren Werten im Gaming (bis zu 133 Watt z.B. in Cyberpunk 2077 oder Horizon Zero Dawn) mit der Nicht-OC-Karte als auch die irrsinnig hohen Werte im Idle, bereits letzte (!) Woche an NVIDIA kommuniziert, jedoch bis heute keine befriedigende Antwort erhalten. Es scheint sich jedoch um hausgemachtes ein Treiber-Problem zu handeln, den auf einem meiner ältesten Systeme und Windows zeigte sich die Karte mit 14 Watt zufrieden.

Wobei es sicher auch 10 oder 11 Watt hätten sein können, wenn die Spannungswandler der Palit-Karte etwas effizienter gewesen wären und der PWM-Controller auch Phasen abschalten könnte. Ich habe mit vielen Kollegen kommuniziert und alle hatten das gleiche Problem im Idle. Ich bin also keine Ausnahme, sondern leider die Regel. Denn es gab auch Situationen auf den aktuellen Systemen, wo plötzlich wieder 14 watt gemessen wurden, aber immer noch 52 Watt in der NVAPI angezeigt wurden. Muss man das verstehen? Wohl eher nein!

Wir sehen übrigens sehr schön, dass die volle TBP von 115 fast immer überschritten wird, sogar beim eher anspruchslosen AutoCAD. Selbst die Messwerte von NVIDIAs PCAT und Powenetics V2 bestätigen meine Ergebnisse und widerlegen eindeutig NVIDIAs eigene Werte über die NVAPI Schnittstelle. Wer sich das ausgedacht hat, hätte doch wissen müssen, das so etwas auffällt. Aber es passt gut zur PR-Folie mit dem lustigen Stromsparplan.

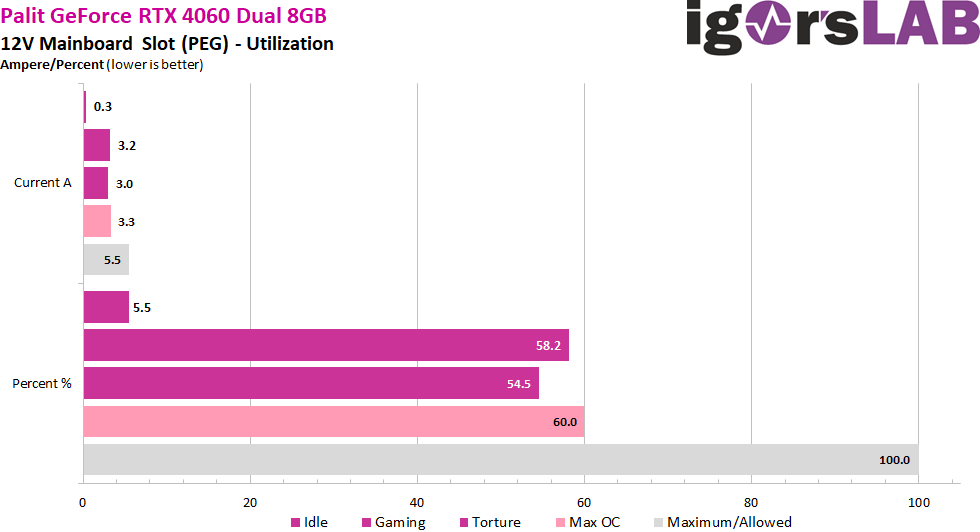

Lastverteilung zwischen PCIe-Slot und den PCIe-Buchsen

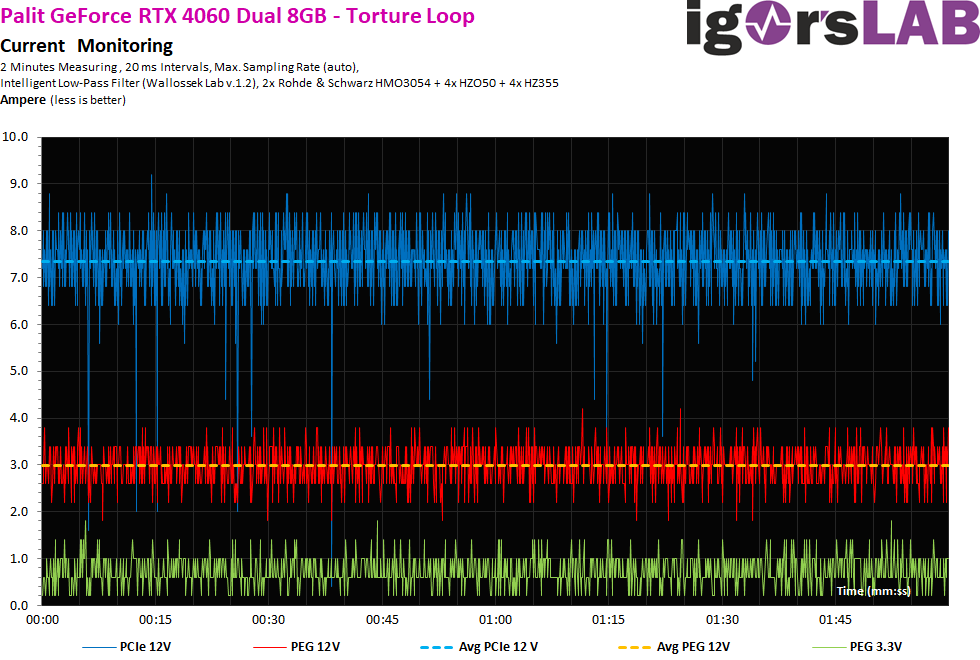

NVIDIA nutzt vor allem beim Gaming den PCIe-Slot ein wenig mit. Aber man liegt bei den fließenden Strömen noch weit unter dem, was mit 5.5 Ampere maximal erlaubt ist, auch beim erhöhten Power Limit.

Während NVIDIA die Versorgung über den PEG deutlich zurückgefahren hat, nutzt AMD diese Schiene weiterhin recht exzessiv.

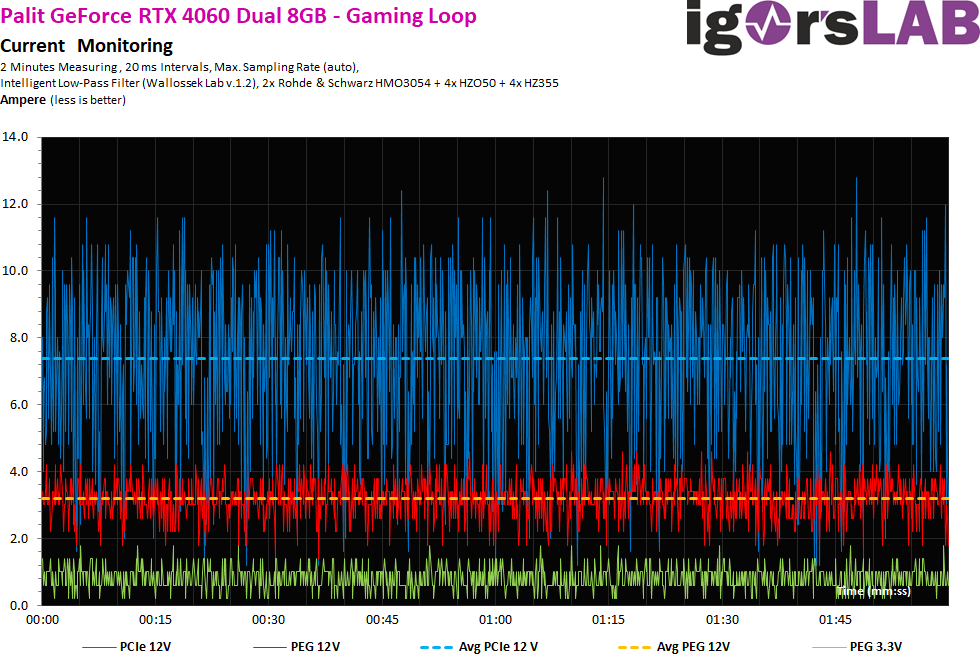

Grobe 20-ms-Intervalle

Schauen wir uns zunächst einmal die fließenden Ströme an. Gemessen wurde in gröberen 20-ms-Intervallen, also rund 50 Mal pro Sekunde, um die Last am Supervisor-Chip der Netzteile zu simulieren (Abschaltung). Wir sehen, dass auch kurze Lastspitzen bei spätestens 13 A abgekappt werden. aber eine wirkliche Begrenzung sieht anders aus.

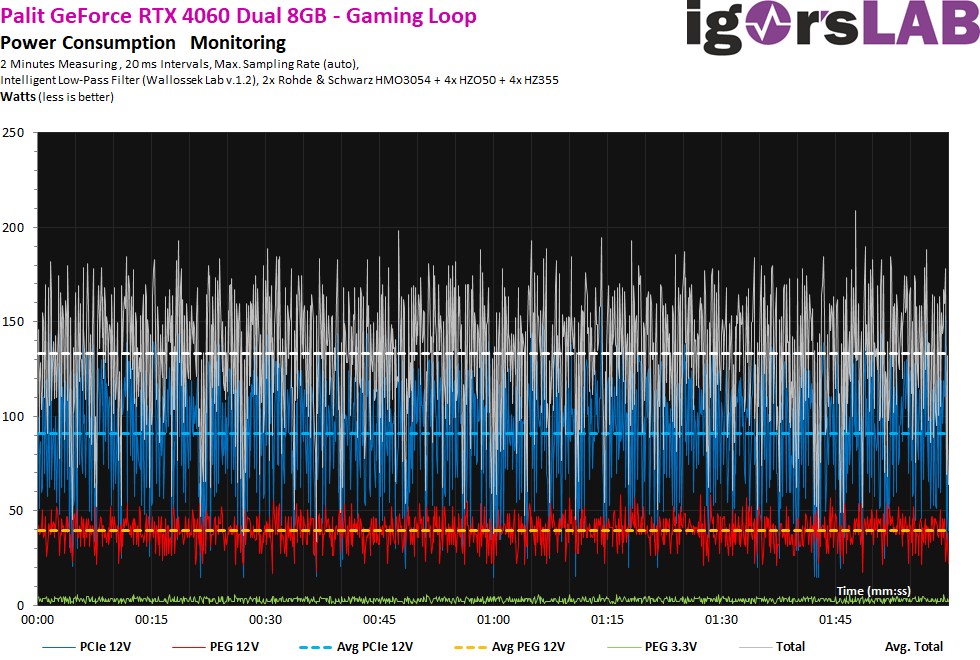

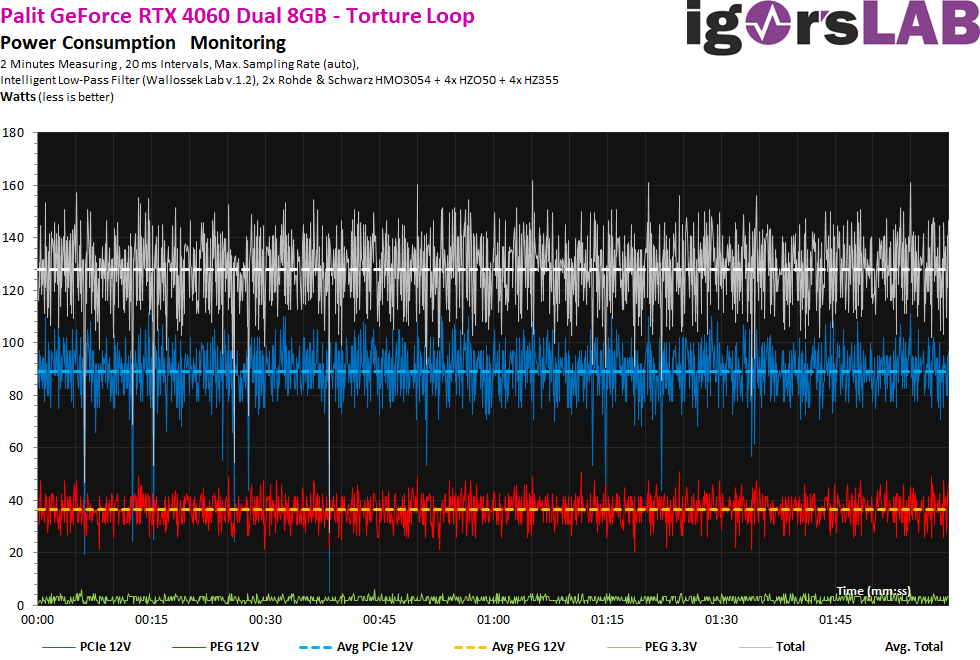

Trotzdem müssen wir noch einen Blick auf die Spannungen werfen, bzw. das Produkt aus Spannung und Stromfluss. Ich schrieb ja bereits, dass ich hier an verschiedenen Netzteilanschlüssen gemessen habe, auch wenn sich am Ende auf der Platine der Grafikkarte alle Anschlüsse wieder irgendwie treffen. Das, was wir hier jetzt als viel deutlichere Schwankungen und Spitzen erkennen können, liegt am partiell ein klein wenig übervoltenden Netzteil und somit an der Spannung und nicht den Strömen. Das ist technisch bedingt, jedoch kein Beinbruch. Wir sehen jedoch auch, dass die wenigen Spitzen bei etwas über 200 Watt nicht durch den fließenden Strom bedingt ist (Grafikkarte), sondern eigentlich vom Netzteil her resultieren! Das liegt auch an der Topologie und vor allem dem eher mickrigen Eingangsfilter mit nur einer Spule auf der einzelnen Rail.

Beim Torture-Test sieht es kaum anders aus.

Nimmt man jetzt wieder die Spannung mit hinzu, dann sieht man eine stärkere Welligkeit (Ripple), die sich wiederum aus der etwas hibbeligen Betriebsspannung ergibt. Allerdings muss man zur Ehrenrettung des Netzteils auch sagen, dass dies alle aktuellen Produkte aller Hersteller betrifft und sicher auch kaum zu vermeiden ist.

- 1 - Einführung, technische Daten und Technologie

- 2 - Test System im igor'sLAB MIFCOM-PC

- 3 - Teardown: PCB und Komponenten

- 4 - Gaming Performance FHD (1920 x 1080)

- 5 - Gaming-Performance WQHD (2560 x 1440)

- 6 - Gaming Performance DLSS vs. DLSS3 vs. FSR

- 7 - Latenzen und DLSS 3.0

- 8 - Details: Leistungsaufnahme und Lastverteilung

- 9 - Lastspitzen, Kappung und Netzteilempfehlung

- 10 - Temperaturen, Taktraten, Lüfter und Geräuschentwicklung

- 11 - Zusammenfassung und Fazit

44 Antworten

Kommentar

Lade neue Kommentare

Neuling

1

Neuling

Neuling

Urgestein

Moderator

Urgestein

1

Urgestein

Urgestein

Veteran

Mitglied

1

Mitglied

Urgestein

Urgestein

Urgestein

Mitglied

1

Alle Kommentare lesen unter igor´sLAB Community →