We are familiar with assisted living, which definitely has a deeper meaning. Assisted benchmarking, on the other hand, makes less sense. And I admit it, I was thoroughly pissed off after a few hand-picked noble influencers held hands with NVIDIA (and certainly against their better judgment) and delivered the ordered praise for a product that serious testers and media, on the contrary, have tested for days and whose results can only be made public today. Manufacturers who resort to such means and deliberately flatten the suspense curve are probably also aware of where their product could perhaps be positioned in reality, and are supposedly building ahead. That would certainly not even have been necessary in this form, but oh well.

I’ll still publish the tests largely without emotion, because I simply owe that to my readers and the graphics card itself can’t do anything about it. However, I deliberately put the focus on exactly those areas that were not allowed to appear in the videos. Because somehow you have to (a) stand out from the rash contemporaries in terms of content and (b) present the reality to the hopefully not yet completely confused audience. By the way, this will also be done objectively, because I will consciously stick to my own rules.

I tested the Palit GeForce RTX 4060 Dual as a representative for the so-called MSRP cards, i.e. what corresponds to the MSRP of 329 Euros in terms of price. And not quite by chance, AMD also officially lowered the prices for the Radeon RX 7600 yesterday. The fact that the market now produces even lower values is certainly no coincidence either. Price-wise, the card is just hitting a certain vacuum, but whether it correlates with that performance-wise, we’ll find out in the course of the test.

Important preface

I’m splitting the whole thing of course NDA compliant into two reviews, so one article each for today and tomorrow. today there is the MSRP card quasi “out of the box” and tomorrow then the OC card with the maximum possible OC in all situations. And I just spoil boldly: there is still something. However, I will also have to address some points that I really disliked not only from a technical point of view, but also lead to completely wrong values in reality.

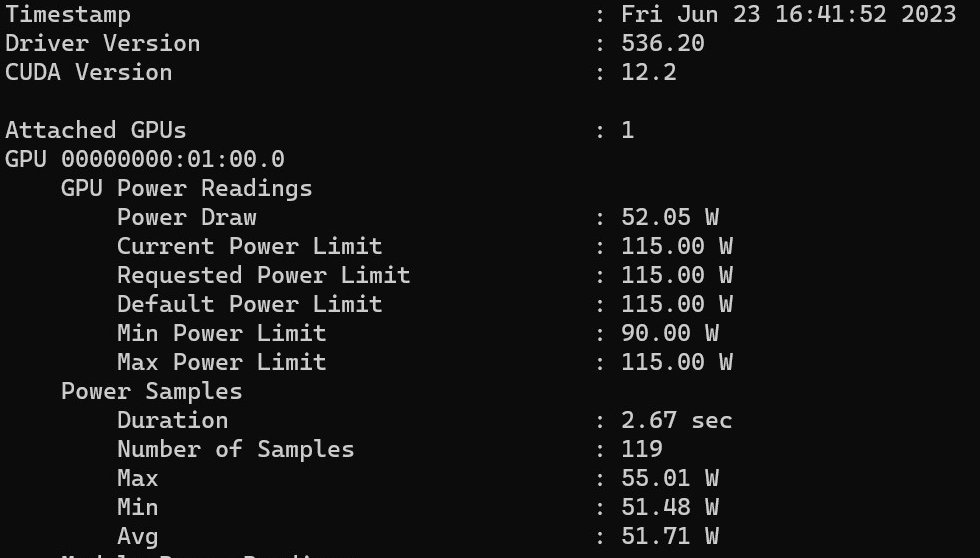

I won’t go into detail about NVIDIA’s silly power-saving chart, which can’t be true because of the estimated energy prices alone; others have already done that. Only the underlying value of the power consumption is also a gross misinformation, which I will also prove in the course of the review. And seriously, over 50 watts at idle is the premature death of any propaganda film anyway. But more on that later as well. Let’s first look at the initial situation: 115 watts of maximum board power on the MSRP card without the chance of an increase and quite obviously a Bin 1 chip, because not much more was possible here. But for that I will have a longer review tomorrow.

Of course, as usual, there are also many benchmarks, the comprehensive teardown (very important!), a very elaborate board and cooler analysis with some reverse engineering, as well as the analysis of power consumption and load peaks including a suitable power supply recommendation (just as interesting). Since I know that many colleagues will also repeat all the technical details including theory, which have already been presented in various tidbits, I’ll spare myself that today on a large scale and only briefly refer to the already known data. This also includes NVIDIA’s explanation about the cache and why this should relieve the memory expansion. And I’ll also test the DLSS3 and the frame generation, but not only. We are not on YouTube.

The AD 107 and the new Ada architecture

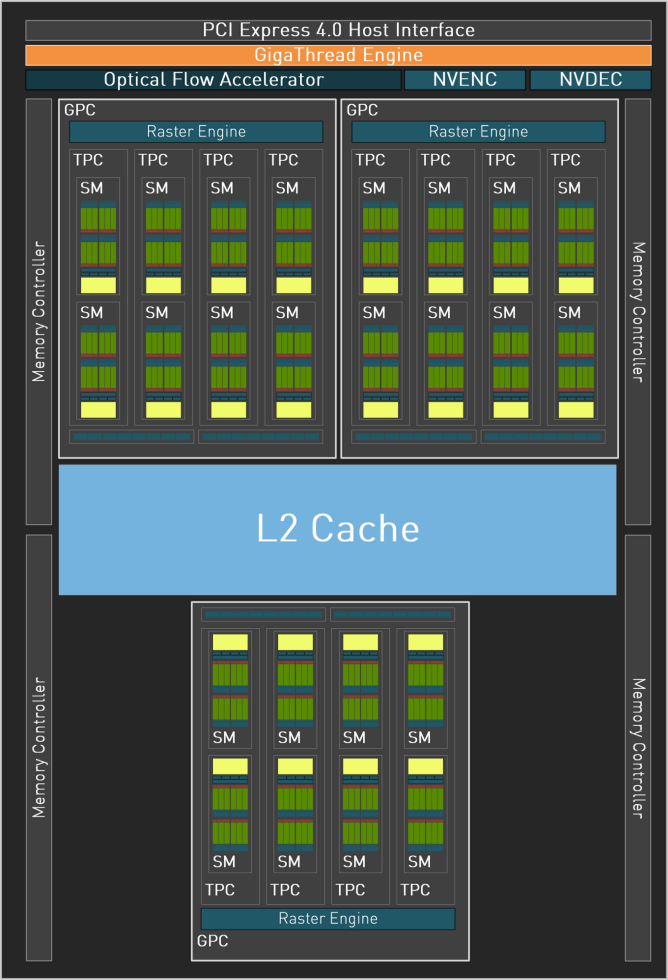

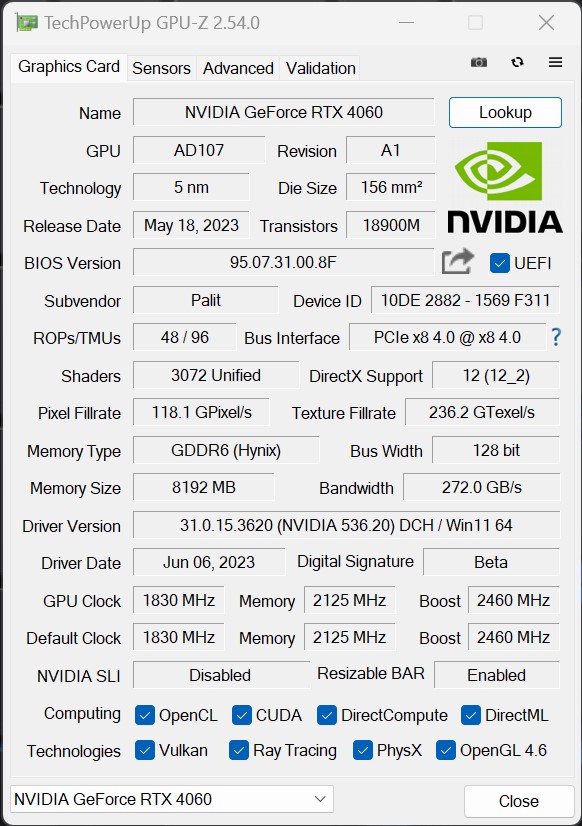

The AD107 chip from NVIDIA, based on the Ada Lovelace architecture and manufactured in the TSMC 4N process. Thanks to its small size of 146 mm², this is quite a small chip. The AD107 supports DirectX 12 Ultimate (Feature Level 12_2) and for GPU computing applications, OpenCL version 3.0 and CUDA 8.9 can be used. Additionally, DirectX 12 Ultimate compatibility promises support for hardware ray tracing, variable shading rates, and more for future video games. The AD107 still has three Graphic Processing Clusters (GPC) and thus 3072 shader units, 96 texture units and 48 ROPs. Also integrated are 96 Tensor cores, which help accelerate machine learning applications. Furthermore, the GPU includes 24 cores for ray tracing acceleration. The AD107 of the GeForce RTX 4060 only offers one NVDEC (decoder) and a single NVENC (encoder) in total. The AV1 encoder is supposed to work up to 40 more efficiently than H.264.

The already mentioned 18 Gbps GDDR6 128-bit memory seems a bit sparse when you consider the bandwidths of 488 GB/s or 608 GB/s of the older GeForce RTX 3060 Ti. However, the significantly expanded L2 cache in Ada Lovelace compared to Ampere should be taken into account here: While the GeForce RTX 3060 Ti still has 4 MB of L2 cache, the RTX 4060 has a 28 MB L2 cache. This reduces the data traffic over the memory bus and thus enables the most efficient combination of performance and energy efficiency for gaming in 1080p resolution.

Compared to a 128-bit amped GPU, Ada’s L2 cache architecture thus provides a 16x capacity increase. In addition, the bandwidth of the L2 cache in Ada GPUs has been significantly increased compared to previous GPUs. This enables the fastest possible data transfer between the cores and the L2 cache. Ada’s larger L2 cache results in significantly more cache hits in the L2 area while reducing traffic over the memory bus. We’ll see if this works in the end in a moment.

The Palit GeForce RTX 4060 Dual 8 GB in detail

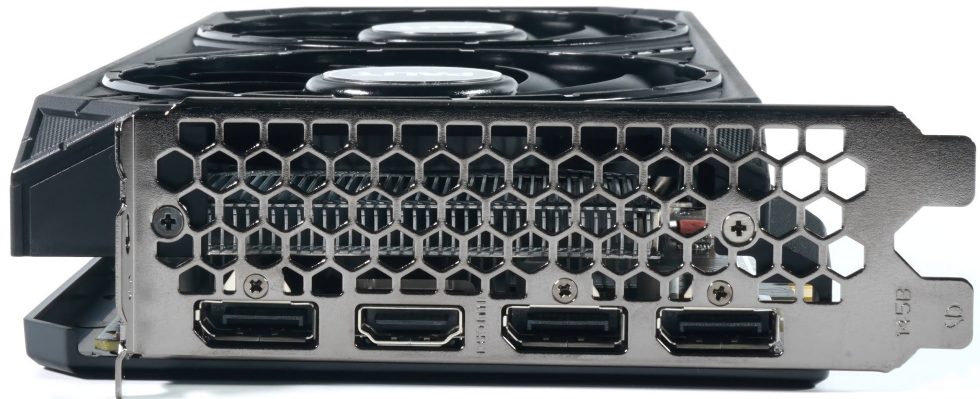

The card only weighs 649 grams, a flyweight. The length of 25 cm is moderate and the height of 11.5 cm is on par with normal. There is no need for a trum of housing especially since the card gets along with a single 6 2-pin. The installation depth is 3.8 cm plus the 4 mm for the backplate attachment on the back. This makes it a true dual-slot card. The single-silver plastic cover is well-known and the design language including fan and slot bezel isn’t new either. Only that everything looks richly simple. Palit uses a single BIOS and those who want to overclock have to use a suitable tool. The feel is rather cheap, which is also due to the cost pressure.

You can, after all, not only put power into the card, but also video connections. There are four of them, to be exact: three DisplayPort 1.4a and one HDMI 2.1a. That’s a shame, especially with the DisplayPort, when it comes to the new specifications. A missed opportunity, unfortunately. And with HDMI, you have to trick with the compression from 4K onwards if you want it to go above 120 Hz.

The screenshot from GPU-Z shows us standard specifications of the RTX 4060, which are identical for all 115 watt cards:

| RTX 4060 Ti | RTX 4060 | RTX 3060 Ti | RTX 3060 | |

| Architecture | Ada Lovelace | Ada Lovelace | Amps | Ampere |

| Process node | TSMC N4 | TSMC N4 | Samsung 8 nm | Samsung 8 nm |

| CUDA cores | 4352 | 3072 | 4864 | 3584 |

| Ray tracing cores | 32 cores (3rd-gen) | 24 (3rd-gen) | 38 cores (2nd-gen) | 28 cores (2nd-gen) |

| Tensor cores | 128 cores (4th-gen) | 96 (4th-gen) | 152 cores (3rd-gen) | 112 cores (3rd-gen) |

| Base clock speed | 2.31 GHz | 1.83 GHz | 1.41 GHz | 1.32 GHz |

| Boost clock speed | 2.54 GHz | 2.46 GHz | 1.76 GHz | 1.78 GHz |

| VRAM | 8 / 16 GB GDDR6 | 8 GB GDDR6 | 8 GB GDDR6/6X | 8 / 12 GB GDDR6 |

| L2 cache | 32MB | 28 MB | 4 MB | 3MB |

| Bus width | 128-bit | 128-bit | 256-bit | 192-bit |

| Total Graphics Power (TGP) | 160 W/165 W | 115 W | 200 W | 170 W |

With that, this first page is done and we’re slowly getting ready for the test.

- 1 - Introduction, technical data and technology

- 2 - Test system in the igor'sLAB MIFCOM PC

- 3 - Teardown: PCB, components and cooler

- 4 - Gaming performance FHD (1920 x 1080)

- 5 - Gaming performance WQHD (2560 x 1440)

- 6 - Gaming performance DLSS vs. DLSS3 vs. FSR

- 7 - Latency and DLSS 3.0

- 8 - Power consumption and load balancing

- 9 - Transients, cutting and PSU recommendation

- 10 - Temperatures, clock speeds, fans and noise

- 11 - Summary and conclusion

44 Antworten

Kommentar

Lade neue Kommentare

Neuling

1

Neuling

Neuling

Urgestein

Moderator

Urgestein

1

Urgestein

Urgestein

Veteran

Mitglied

1

Mitglied

Urgestein

Urgestein

Urgestein

Mitglied

1

Alle Kommentare lesen unter igor´sLAB Community →