Betreutes Wohnen kennen wir, das hat durchaus einen tieferen Sinn Sinn. Betreutes Benchmarken dagegen eher weniger. Und ich gebe es zu, ich war gediegen angefressen, nachdem ein paar handverlesene Edel-Influencer händchenhaltend mit NVIDIA (und sicher auch wider besseres Wissen) die bestellten Lobeshymnen für ein Produkt lieferten, das seriöse Tester und Medien im Gegensatz dazu über Tage aufwändig getestet haben und deren Ergebnisse erst heute öffentlich gemacht werden dürfen. Wer als Hersteller zu solchen Mitteln greift und die Spannungskurve damit bewusst abflacht, der ahnt wohl auch, wo sich sein Produkt in der Realität vielleicht positionieren könnte, und baut vermeintlich vor. Das hätte man in dieser Form sicher noch nicht einmal nötig gehabt, aber nun ja.

Ich werde die Tests trotzdem weitgehend emotionslos veröffentlichen, denn das bin ich meinen Lesern einfach schuldig und die Grafikkarte selbst kann ja auch nichts dafür. Allerdings habe ich den Fokus bewusst auf genau die Bereiche gelegt, die in den Videos nicht vorkommen durften. Denn irgendwie muss man sich ja (a) von den voreiligen Zeitgenossen inhaltlich auch abheben und (b) dem hoffentlich noch nicht komplett verwirrten Publikum die Realität präsentieren. Im Übrigen wird auch das objektiv erfolgen, denn ich werde mich bewusst an meine eigenen Regeln halten.

Ich habe stellvertretend für die sogenannten MSRP-Karten, also das, was preislich der UVP von 329 Euro entspricht, die Palit GeForce RTX 4060 Dual getestet. Und nicht ganz zufällig hat AMD gestern auch offiziell die Preise für die Radeon RX 7600 gesenkt. Dass der Markt mittlerweile sogar noch niedrigere Werte hervorbringt, ist sicher auch kein Zufall. Preislich stößt die Karte gerade in ein gewissen Vakuum, aber ob es damit auch leistungstechnisch korreliert, werden wir im Laufe des Tests noch herausfinden.

Wichtige Vorbemerkung

Ich splitte das ganze natürlich NDA-konform in zwei Reviews, also in jeweils einen Artikel für heute und morgen. Heute gibt es die MSRP-Karte quasi “Out of the Box” und morgen dann die OC-Karte mit dem maximal möglichen OC in allen Lebenslagen. Und ich spoilere einfach mal frech: da geht noch was. Allerdings werde ich auch noch einige Punkte ansprechen müssen, die mir nicht nur aus technischer Sicht wirklich missfallen haben, sondern auch in der Realität zu völlig falschen Werten führen.

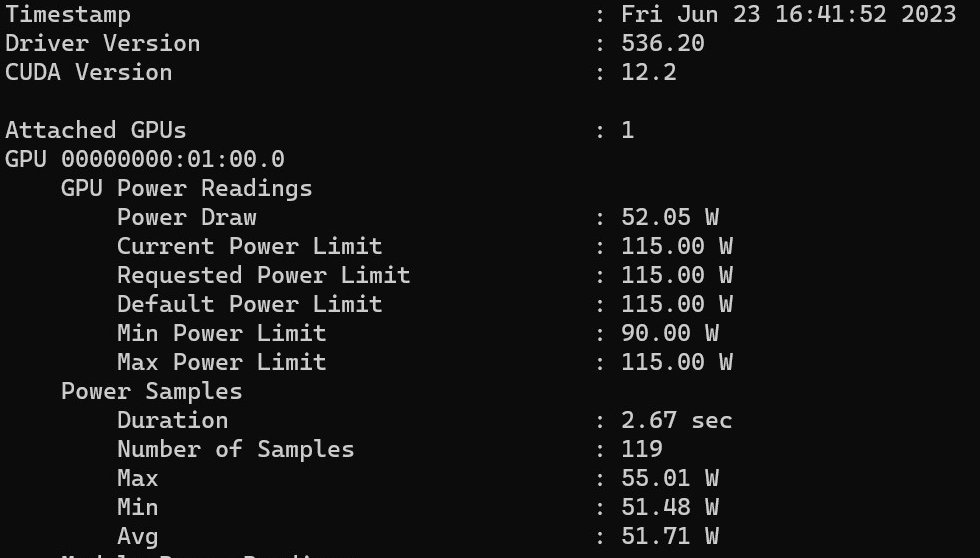

Ich werde zwar nicht im Detail auf NVIDIAs alberne Stromspar-Folie eingehen, die allein schon wegen der veranschlagten Energiepreise so nicht stimmen kann, das haben bereits andere getan. Nur ist auch der zugrunde liegende Wert der Leistungsaufnahme eine grobe Fehlinformation, was ich im Laufe des Reviews auch beweisen werde. Und ganz im Ernst: über 50 Watt im Idle sind sowieso der frühzeitige Tod jeder Propaganda-Folie. Doch auch dazu später noch mehr. Schauen wir zunächst einmal auf die Ausgangslage: 115 Watt maximale Board-Power auf der MSRP-Karte ohne die Chance einer Erhöhung und ganz offensichtlich ein Bin 1 Chip, denn viel mehr ging hier auch nicht. Doch dafür habe ich ja morgen noch einmal ein längeres Review.

Natürlich gibt es wie gewohnt auch viele Benchmarks, den umfassenden Teardown (sehr wichtig!), eine sehr aufwändige Platinen- und Kühler-Analyse mit einigem Reverse-Engineering, sowie die Analyse der Leistungsaufnahme und der Lastspitzen samt passender Netzteilempfehlung (genauso interessant). Da ich weiß, dass viele Kollegen auch noch einmal die ganzen technischen Details samt Theorie wiederholen, die ja bereits vorab schon in diversen Häppchen dargereicht wurden, spare ich mir das heute im ganz großen Umfang und verweise nur noch einmal kurz auf die bereits bekannten Daten. Dazu gehört auch NVIDIAs Erklärung zum Cache und warum dies den Speicherausbau entlasten soll. Und das mit dem DLSS3 bzw. der Frame Generation teste ich auch mal mit, aber eben nicht nur. Wir sind ja nicht auf YouTube.

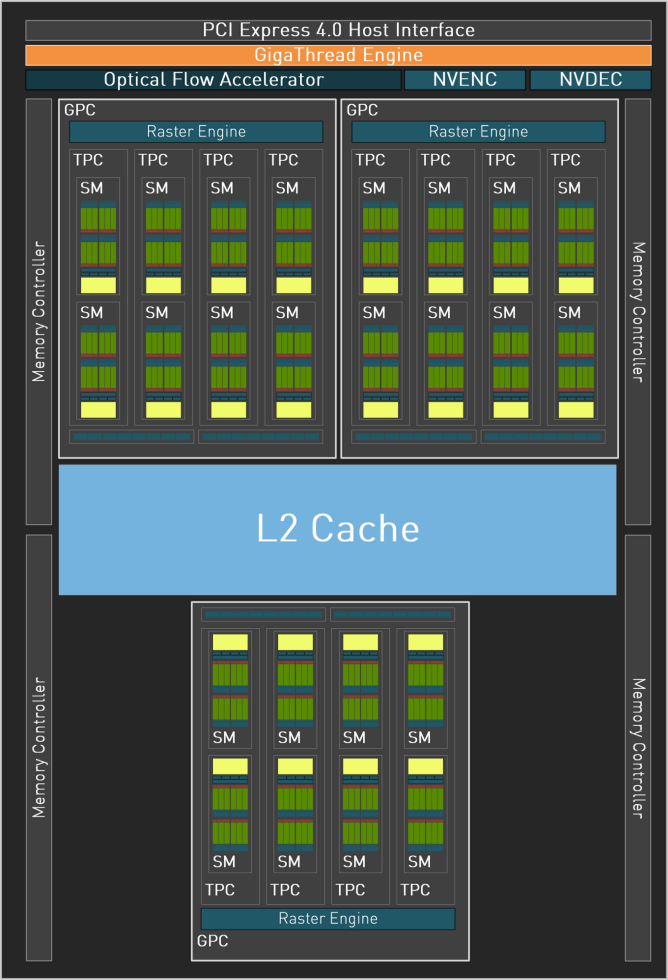

Der AD 107 und die neue Ada-Architektur

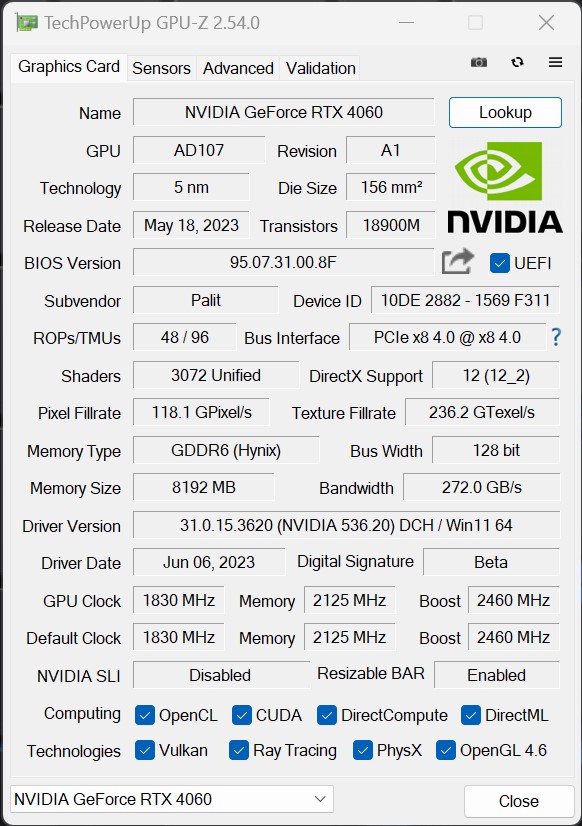

Der AD107 Chip von NVIDIA, basierend auf der Ada Lovelace Architektur und wird im TSMC 4N Prozess hergestellt. Dank ihrer geringen Größe von 146 mm² handelt es sich hierbei um einen recht kleinen Chip. Der AD107 unterstützt DirectX 12 Ultimate (Feature Level 12_2) und für GPU-Computing-Anwendungen können OpenCL Version 3.0 sowie CUDA 8.9 verwendet werden. Zusätzlich verspricht die DirectX 12 Ultimate Kompatibilität Unterstützung für Hardware-Raytracing, variable Schattierungsraten und vieles mehr für zukünftige Videospiele. Der AD107 verfügt noch über drei Graphic Processing Clusters (GPC) und somit über 3072 Shadereinheiten, 96 Textureinheiten und 48 ROPs. Ebenso integriert sind 96 Tensor-Kerne, die zur Beschleunigung von Machine Learning-Anwendungen beitragen. Zudem beinhaltet die GPU 24 Kerne für Raytracing-Beschleunigung. Der AD107 der GeForce RTX 4060 bietet in der Summe nur noch einen NVDEC (Decoder) und einen einzelnen NVENC (Encoder). Der AV1 Encoder soll bis zu 40% effizienter als H.264 arbeiten.

Die bereits genannten 18 Gbps GDDR6 128-Bit-Speicher wirken etwas spärlich, wenn man die Bandbreiten von 488 GB/s oder 608 GB/s der älteren GeForce RTX 3060 Ti berücksichtigt. Hier sollte allerdings der bei Ada Lovelace im Vergleich zu Ampere deutlich erweiterte L2-Cache beachtet werden: Während die GeForce RTX 3060 Ti noch über 4 MB L2-Cache verfügt, verfügt die RTX 4060 über einen 28 MB großen L2-Cache. Dieser reduziert den Datenverkehr über den Speicherbus und ermöglicht so die effizienteste Kombination aus Leistung und Energieeffizienz für Spiele in 1080p-Auflösung.

Verglichen mit einer 128-Bit-Ampere-GPU bietet die L2-Cache-Architektur von Ada somit eine 16-fache Kapazitätssteigerung. Darüber hinaus wurde die Bandbreite des L2-Caches in den Ada-GPUs im Vergleich zu vorherigen GPUs erheblich erhöht. Dies ermöglicht eine schnellstmögliche Datenübertragung zwischen den Kernen und dem L2-Cache. Der größere L2-Cache von Ada führt zu deutlich mehr Cache-Treffern im L2-Bereich und reduziert gleichzeitig den Datenverkehr über den Speicherbus. Ob das am Ende funktioniert, werden wir gleich noch sehen.

Die Palit GeForce RTX 4060 Dual 8 GB im Detail

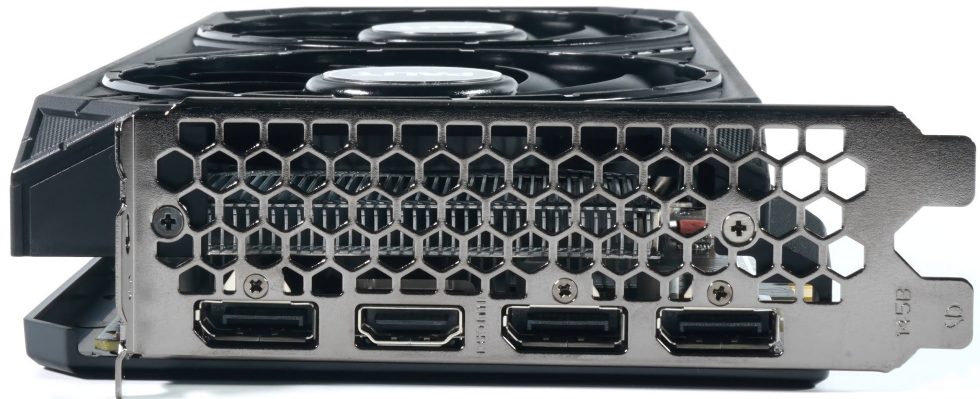

Die Karte wiegt nur noch 649 Gramm, ein Fliegengewicht. Die Länge von 25 cm ist moderat und die Höhe von 11,5 cm liegt auf dem Normalmaß. Da braucht man kein Trum von Gehäuse zumal die Karte mit einem einzigen 6+2-Pin auskommt. Die Einbautiefe beträgt 3,8 cm zuzüglich der 4 mm für den Backplate-Ansatz auf der Rückseite. Damit ist sie eine echte Dual-Slot-Karte. Die einsilbige Kunststoffabdeckung ist altbekannt und auch die Formensprache samt Lüfter und Slotblende ist nicht neu. Nur dass alles reichlich simpel aussieht. Palit nutzt ein Single-BIOS und wer übertakten möchte, muss ein passendes Tool verwenden. Die Haptik ist eher billig, was auch dem Kostendruck geschuldet ist.

Man kann ja aber nicht nur Strom in die Karte stecken, sondern auch Videoanschlüsse. Es sind derer vier, um ganz genau zu sein, als da wären: dreimal DisplayPort 1.4a und einmal HDMI 2.1a. Das ist vor allem beim DisplayPort schade, wenn es um die neuen Spezifikationen geht. Chance vertan, leider. Und beim HDMI muss man ab 4K schon mit der Kompression tricksen, wenn es über 120 Hz gehen soll.

Der Screenshot aus GPU-Z zeigt uns Standardvorgaben der RTX 4060, die bei allen 115-Watt-Karten identisch sind:

| RTX 4060 Ti | RTX 4060 | RTX 3060 Ti | RTX 3060 | |

| Architecture | Ada Lovelace | Ada Lovelace | Ampere | Ampere |

| Process node | TSMC N4 | TSMC N4 | Samsung 8 nm | Samsung 8 nm |

| CUDA cores | 4352 | 3072 | 4864 | 3584 |

| Ray tracing cores | 32 cores (3rd-gen) | 24 (3rd-gen) | 38 cores (2nd-gen) | 28 cores (2nd-gen) |

| Tensor cores | 128 cores (4th-gen) | 96 (4th-gen) | 152 cores (3rd-gen) | 112 cores (3rd-gen) |

| Base clock speed | 2.31 GHz | 1.83 GHz | 1.41 GHz | 1.32 GHz |

| Boost clock speed | 2.54 GHz | 2.46 GHz | 1.76 GHz | 1.78 GHz |

| VRAM | 8 / 16 GB GDDR6 | 8 GB GDDR6 | 8 GB GDDR6/6X | 8 / 12 GB GDDR6 |

| L2 cache | 32MB | 28 MB | 4 MB | 3MB |

| Bus width | 128-bit | 128-bit | 256-bit | 192-bit |

| Total Graphics Power (TGP) | 160 W/165 W | 115 W | 200 W | 170 W |

Damit wäre diese erste Seite geschafft und wir bereiten uns schon einmal langsam aufs Testgeschehen vor.

- 1 - Einführung, technische Daten und Technologie

- 2 - Test System im igor'sLAB MIFCOM-PC

- 3 - Teardown: PCB und Komponenten

- 4 - Gaming Performance FHD (1920 x 1080)

- 5 - Gaming-Performance WQHD (2560 x 1440)

- 6 - Gaming Performance DLSS vs. DLSS3 vs. FSR

- 7 - Latenzen und DLSS 3.0

- 8 - Details: Leistungsaufnahme und Lastverteilung

- 9 - Lastspitzen, Kappung und Netzteilempfehlung

- 10 - Temperaturen, Taktraten, Lüfter und Geräuschentwicklung

- 11 - Zusammenfassung und Fazit

44 Antworten

Kommentar

Lade neue Kommentare

Neuling

1

Neuling

Neuling

Urgestein

Moderator

Urgestein

1

Urgestein

Urgestein

Veteran

Mitglied

1

Mitglied

Urgestein

Urgestein

Urgestein

Mitglied

1

Alle Kommentare lesen unter igor´sLAB Community →