Teardown

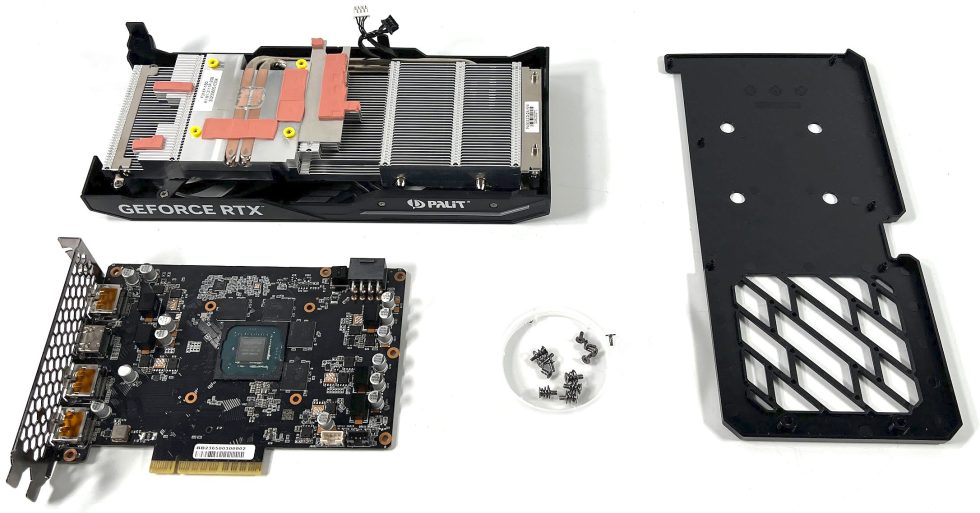

Die Karte ist schnell zerlegt, denn wo nicht viel dran ist, muss auch nicht viel ab- und auseinander gebaut werden.

PCB-Layout und Komponenten

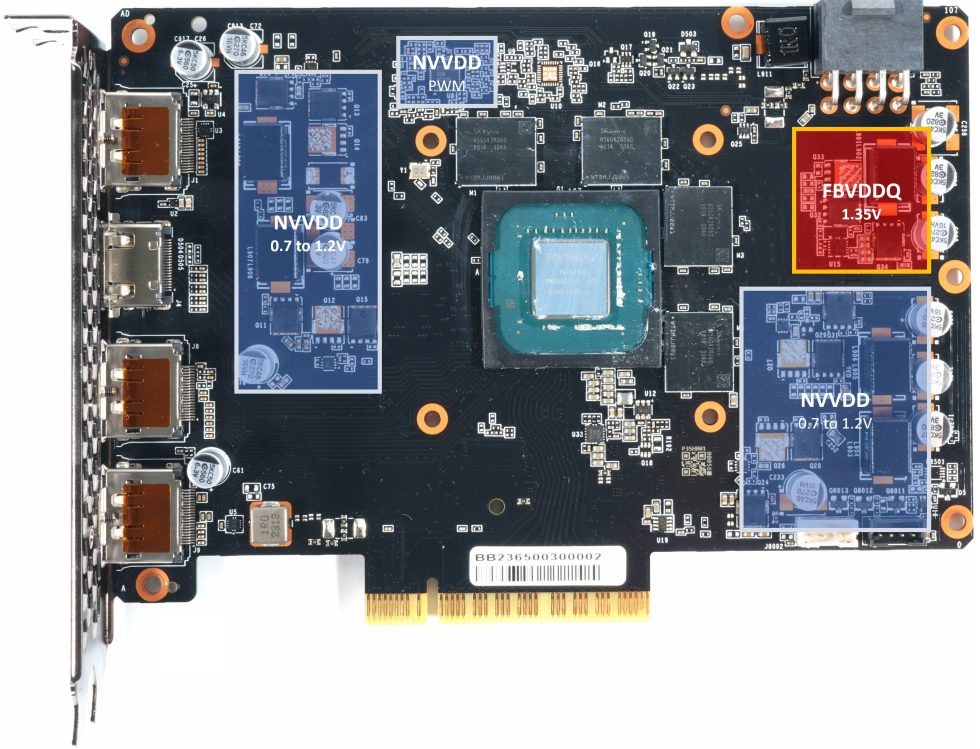

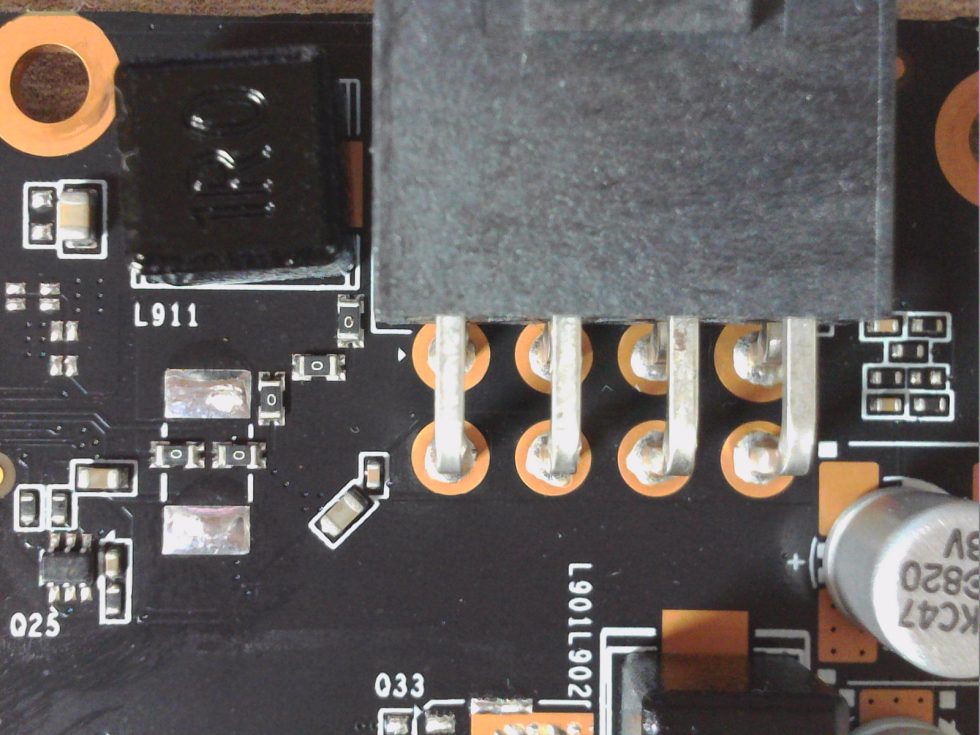

Beginnen wir zunächst mit der Platine. Und hier habe ich den ersten echten Schock bekommen. Ja, wir sind fast schon im im Entry-Level angekommen, aber was man zu sehen bekommt, ist pures Cost Down. NVVDD ist die wichtigste Spannung und so ergibt sich ein Spannungswandler-Design mit insgesamt vier Phasen und den daraus resultierenden Regelkreisen allein für NVVDD. Man spart also im Vergleich zur RTX 4060 Ti FE noch einmal eine Phase ein, was jedoch in Anbetracht der deutlich niedrigeren TDP irgendwie noch zu akzeptieren ist. In Anbetracht möglicher Hotspots und einer höheren Effizienz wären mehr Phasen sicher auch sinnvoller gewesen. Aber es soll ja auch um den Preis gehen und so muss wieder ein Kompromiss her.

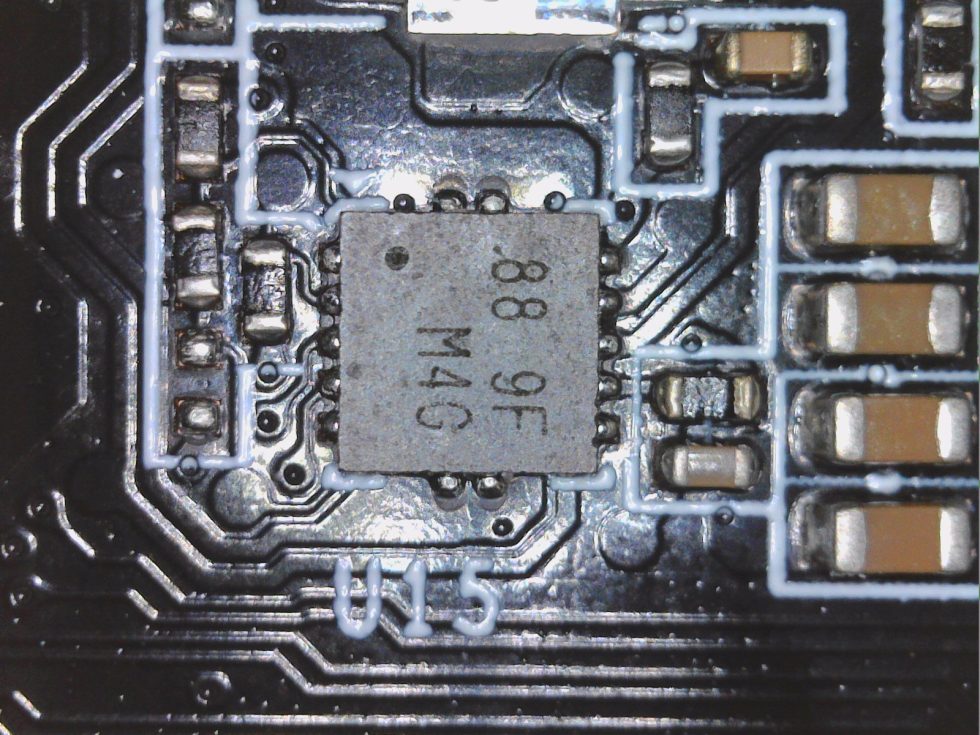

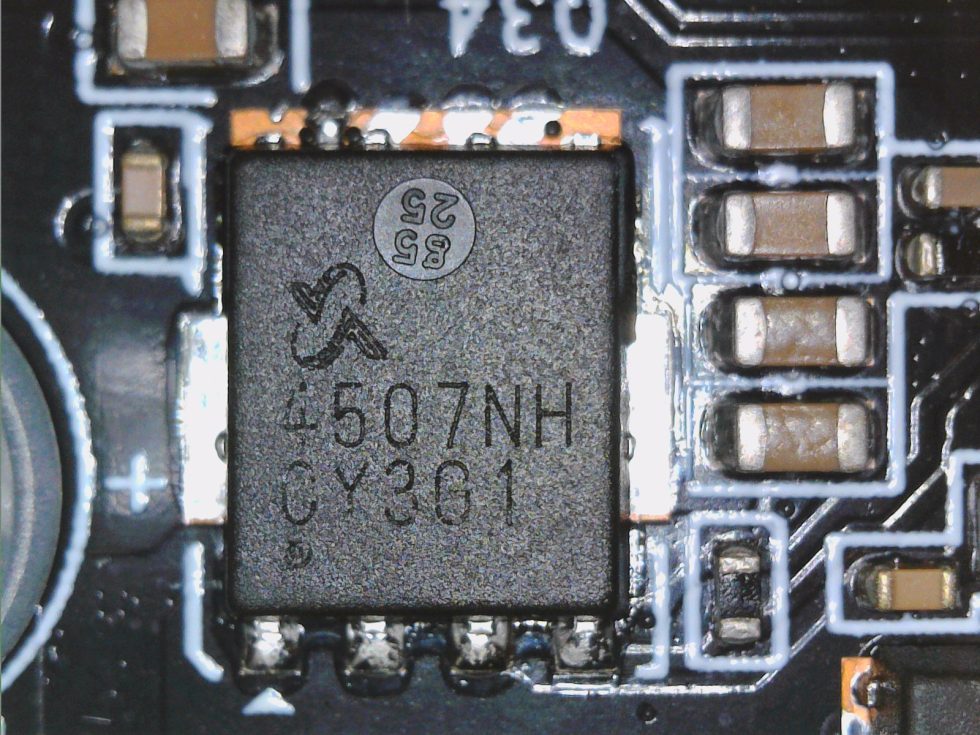

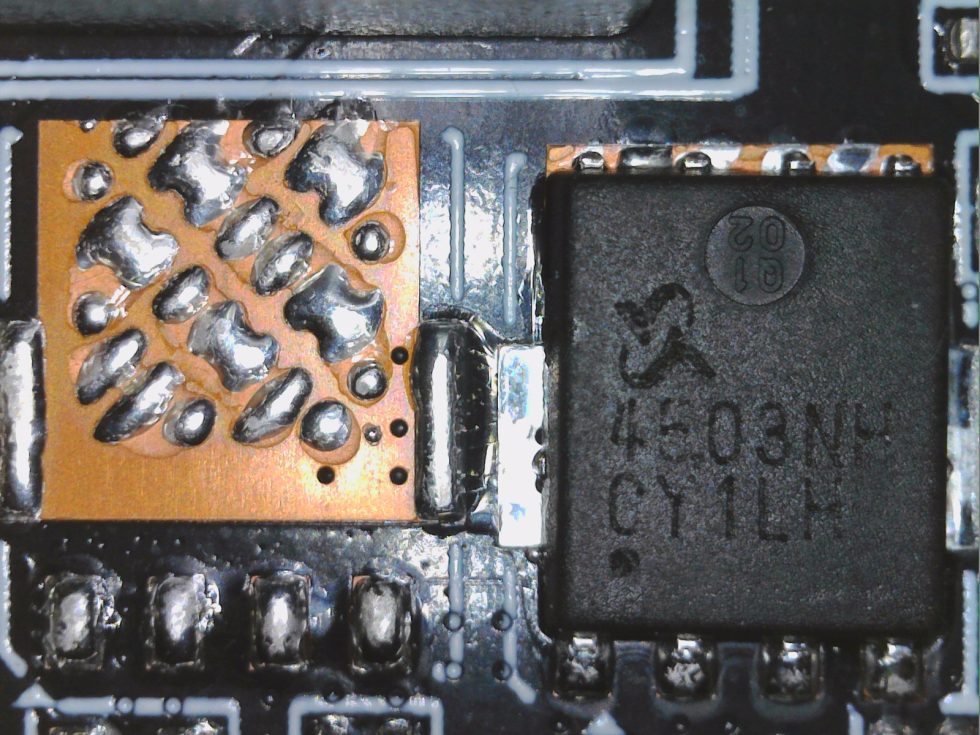

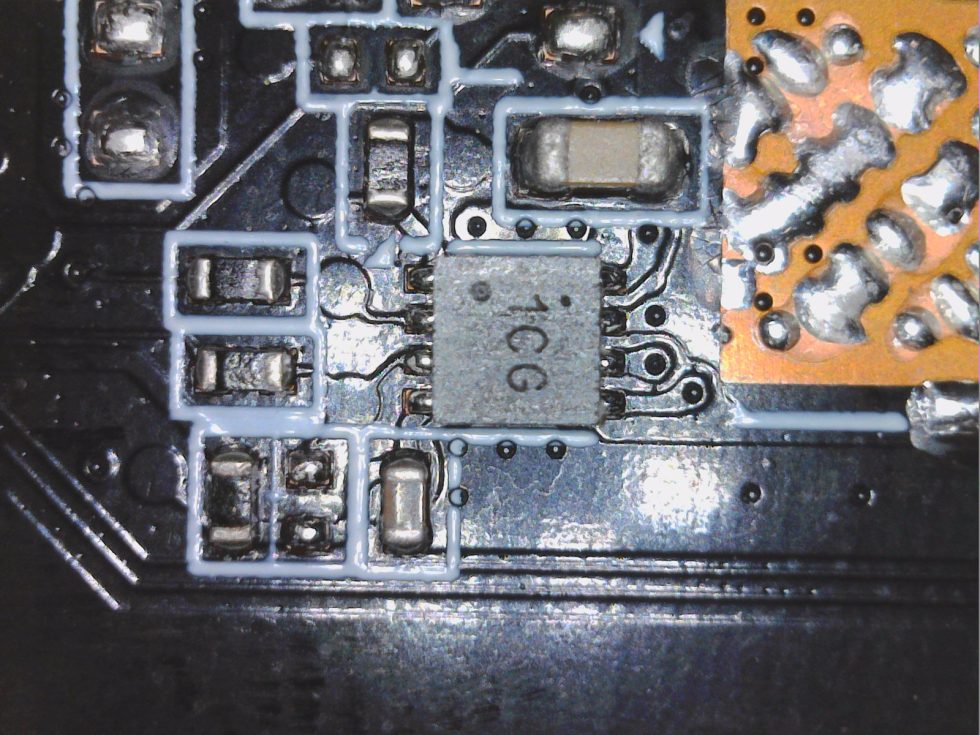

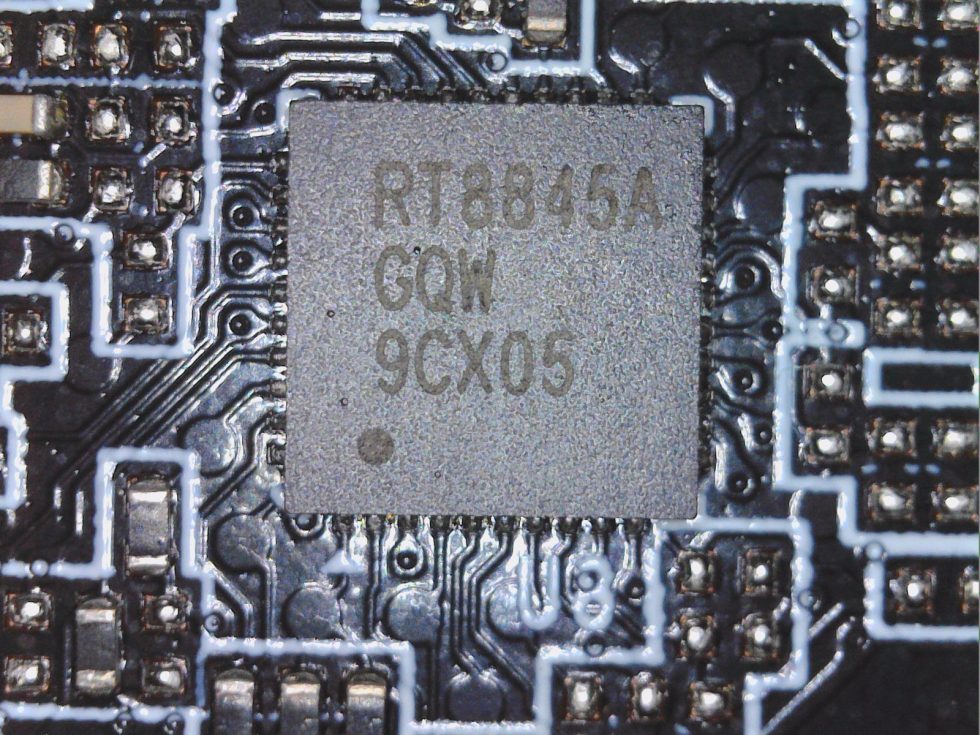

Das sieht alles auf den ersten Blick etwas arg mager aus, aber es reicht. Man nutzt einen sehr günstigen PWM-Controller für NVVDD (GPU Core), die FBVDDQ (Speicher) löst man über einen trivialen Buck-Converter. Für NVVDD nutzt Palit den billigen RT8845A von Realtek, der sich mit den maximal vier Phasen zwar nicht verhebt, aber vor allem im Niedriglastbereich die Effizienz verschenkt. DrMOS gibt es keine, die Spannungswandler sind allesamt diskret mit N-Channel MOSFETS und getrennter Low- und High-Side aufgebaut.

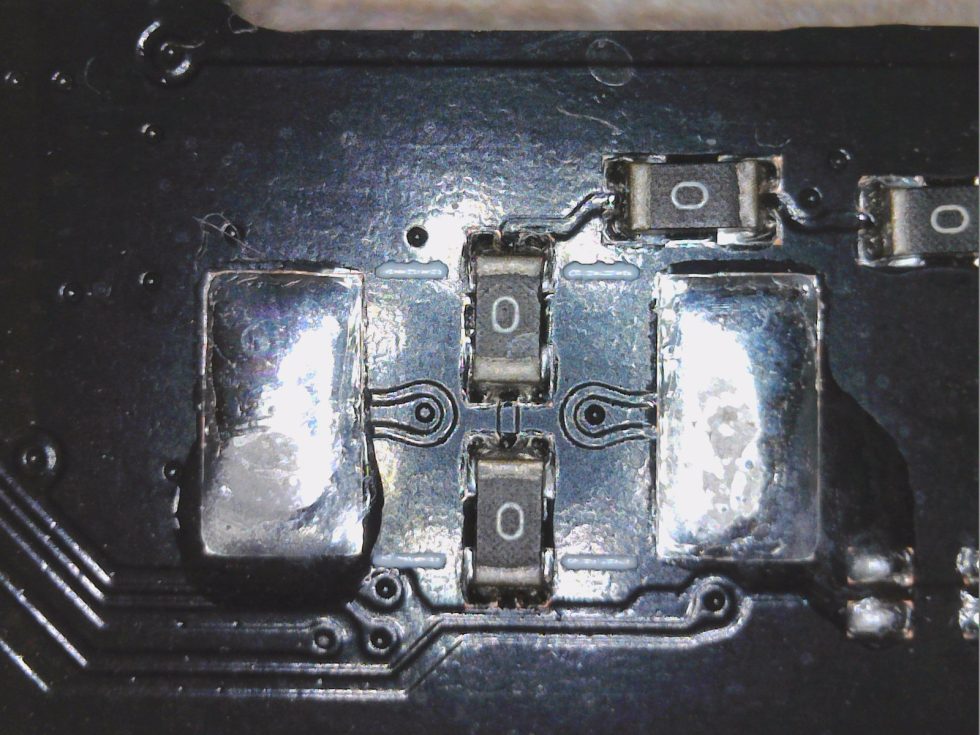

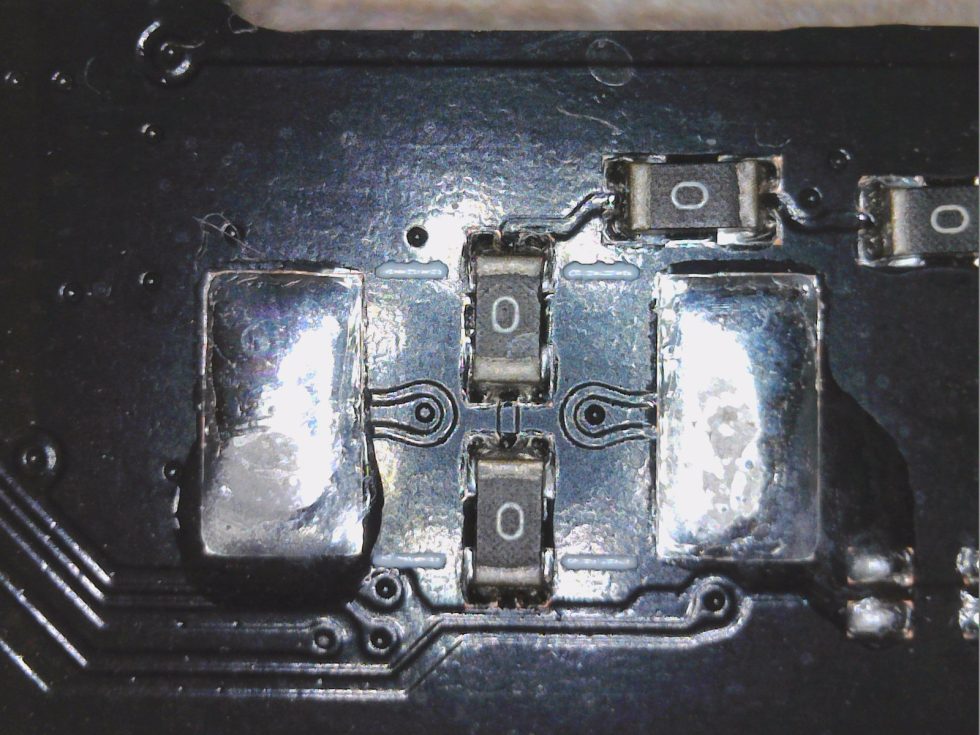

Alle verwendeten MOSFETs für NVVDD sind günstige Produkte von Sinopower. Der in allen Regelkreisen für die Low Side genutzte SM4503NHKP ist ein N-Channel Enhancement Mode MOSFET für maximal 80 Ampere. Der RDS(ON) liegt typisch bei 2.5 mΩ und kann bei voller Erwärmung bis zu 3.75 mΩ ansteigen. Hätte man hier eine bereits vorgesehene Parallelschaltung genutzt, hätte man die Verluste fast halbieren können. Der in allen Regelkreisen für die High Side genutzte SM4507NHKP ist ebenfalls ein N-Channel Enhancement Mode MOSFET, aber für die zu erbringende Leistung eher nicht entscheidend. Angesteuert wird er durch einen separaten Gate-Treiber.

Die eine Phase für FBVDDQ (Speicher) wird ebenfalls diskret realisiert und besteht aus den gleichen MOSFETs wie die vier NVVDD-Phasen. Die 12V-Rails am 6+2 Connector werden direkt nach der Buchse zu einer einzigen Rail zusammengefasst, eine weitere liegt am PEG an, und wird für NVVDD nur gering genutzt.

Wo ist die Kontrolle der fließenden Ströme? Kaputt gespart!

NVIDIA ist ja eigentlich bekannt dafür, dass jede 12V-Rail permanent mittels Shunts und dem dort entstehenden Spannungsabfall überwacht werden. So kann man mittels eines passenden Monitoring-Chips auf die fließenden Ströme schließen und die Firmware kann dann die Leistungszufuhr so drosseln, dass das in der Firmware hinterlegte maximale Power Target auch nie überschritten wird. Diese Shunts existieren interessanterweise auf keiner der RTX 4060 Platinen und auch ein geeigneter Monitoring-Chip fehlt komplett.

NVIDIA deklariert die normalen RTX 4060 als 115-Watt-Karten und spricht selbst von typischen 110 Watt beim Gaming. Doch genau das ist unwahr. Ja, die über die NVAPI auslesbaren Werte liegen brav bei 115 Watt und darunter, nur stimmen sie leider nicht mal im Ansatz. Während die Schnittstelle in der Software bei 115 bis 116 Watt verharrt, messe ich an den Rails und 4 Spielen in Wirklichkeit sogar über 130 Watt! Das sind 15 Watt mehr als maximal erlaubt und immerhin 20 Watt über den für die Spiele kommunizierten Wert! Die Karte ist also bei weiten nicht so effizient, wie es die Schnittstelle vorgaukelt und die PR-Folien gern hätten. Das wären beim Gaming nämlich schon über 18 Prozent mehr! Doch zu den genauen Werten kommen wir später und wir sehen, nicht nur die Idle-Leistungsaufnahme ist eine größere Baustelle.

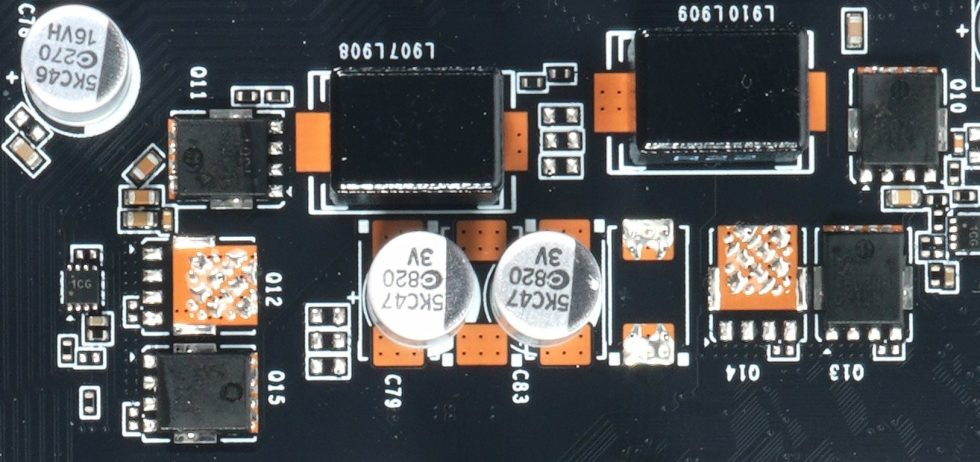

Um die einzelnen Regelkreise überhaupt kontrollieren zu können, benötigt man ein spezielles Verfahren. Das Schlagwort heißt DCR (Direct Current Resistance). Am Ende weist jedes Bauelement diesbezüglich ja ganz bestimmte Charakteristika auf. Um es aber einmal abzukürzen: DCR ist die Basis, um Temperaturen und vor allem Ströme zu kalkulieren oder zu messen. Doch wie erfährt der Controller nun genau, welche Ströme in welchem Regelkreis fließen? Das Monitoring kann unterschiedlich sein, denn es gibt – wen wundert es – verschiedene Methoden dafür.

Wir haben ja bereits analysiert, dass die Spannungswandler auf dem technischen Stand von vor 10 Jahren realisiert wurden. Intelligente Smart Power Stages (SPS), die die Drain-Ströme der MOSFETS für die MOSFET DCR in Echtzeit messen, sind hier reine Utopie. Man ersetzt das Ganze durch die deutlich günstigere Inductor DCR in einer diskreten Schaltung, also eine Strommessung über den induktiven Widerstand der jeweiligen Filterspulen im Ausgangsbereich. Die Genauigkeit dieser Lösung ist allerdings deutlich geringer und wird zusätzlich noch durch Schwankungen der Bauelemente-Güte sehr stark beeinflusst. AMD hat jahrelang auf diese Inductor DCR gesetzt, die aber nicht mehr als eine grobe Schätzung ist und vor allem bei höheren Temperaturen zunehmend ungenauer wird.

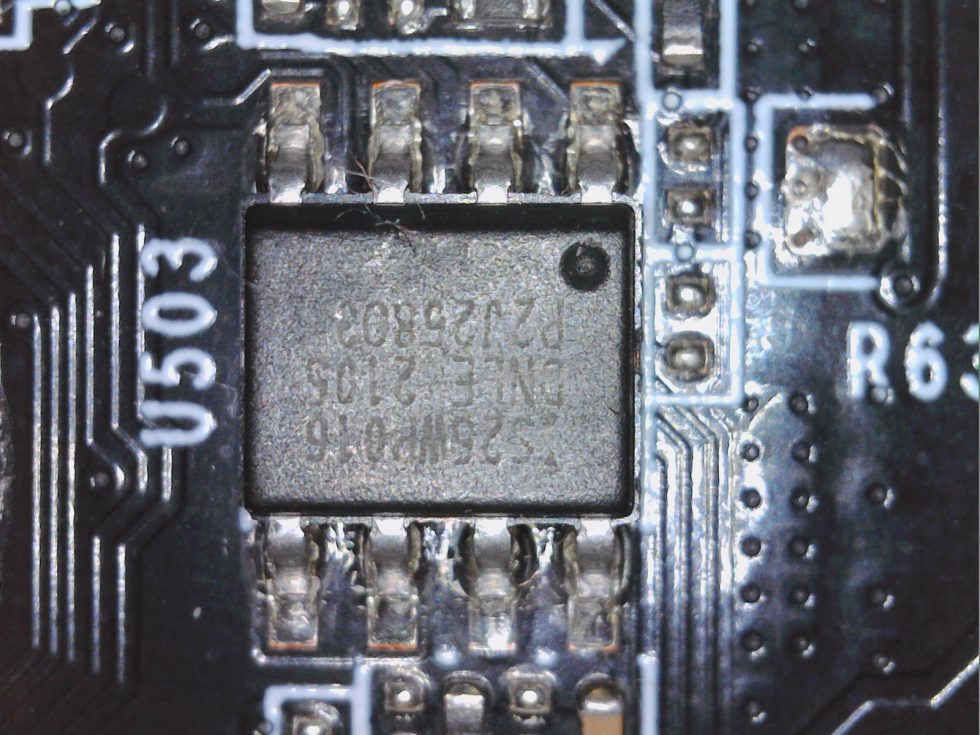

Das BIOS liegt am gewohnten Ort und auch die Generierung der restlichen Kleinspannungen ist wie gehabt. Mehr Besonderheiten gibt es also nicht.

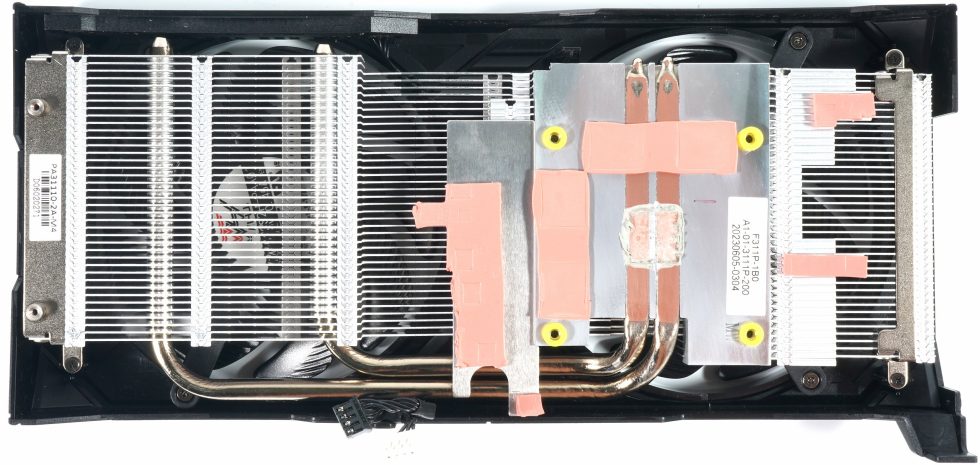

Der Kühler

Die beiden 9,8 cm Lüfter (Öffnung 10 cm) besitzen jeweils 9 Rotorblätter und werden gemeinsam geregelt. Die sonst übliche zweite Regelkurve entfällt bei der GeForce RTX 4060 leider. Palit verwendet einen einfachen Lamellenkühlkörper im Horizontaldesign und zwei in den Aluminium-Heatsink eingepresste und angeschliffene 6 mm DHT-Heatpipes aus Kupferkompositmaterial. Die Pads sind leider nicht so hochwertig, aber ausreichend. Ob und wann dort ggf. etwas Silikon austreten wird, bleibt abzuwarten.

Die Backplate ist aus ABS und dient lediglich der Stabilisierung. Mehr muss man hier nicht berichten, denn es gibt nichts.

- 1 - Einführung, technische Daten und Technologie

- 2 - Test System im igor'sLAB MIFCOM-PC

- 3 - Teardown: PCB und Komponenten

- 4 - Gaming Performance FHD (1920 x 1080)

- 5 - Gaming-Performance WQHD (2560 x 1440)

- 6 - Gaming Performance DLSS vs. DLSS3 vs. FSR

- 7 - Latenzen und DLSS 3.0

- 8 - Details: Leistungsaufnahme und Lastverteilung

- 9 - Lastspitzen, Kappung und Netzteilempfehlung

- 10 - Temperaturen, Taktraten, Lüfter und Geräuschentwicklung

- 11 - Zusammenfassung und Fazit

44 Antworten

Kommentar

Lade neue Kommentare

Neuling

1

Neuling

Neuling

Urgestein

Moderator

Urgestein

1

Urgestein

Urgestein

Veteran

Mitglied

1

Mitglied

Urgestein

Urgestein

Urgestein

Mitglied

1

Alle Kommentare lesen unter igor´sLAB Community →