Zusammenfassung

Ich bin mir nicht ganz schlüssig, was sich NVIDIA im Detail mit dieser Karte gedacht hat, aber wenn es um den Mainstream geht, scheint man bis zum Launch der GeForce RTX 4060 Ti noch ganz guter Dinge gewesen zu sein. Den ganzen Gegenwind mit den 8 GB VRAM hat man damals mit Sicherheit so nicht erwartet und es wundert mich deshalb auch nicht, dass im Vorfeld dieses heutigen Launches derartige Marketing-Pirouetten gedreht und Marketing-Stunts zelebriert wurden.

Ich werde mit Sicherheit jetzt auch nicht auf den stets klammen Speicher eingehen, denn dann würde ich mich nur wiederholen. Die GeForce RTX 4060 8 GB hat nämlich auch positive Seiten, nur muss man sich damit auch arrangieren können. Sie ist in Full-HD in der Summe fast 11 Prozent schneller als eine GeForce RTX 3060 12 GB und in Ultra-HD noch reichlich 8 Prozent. Das mag wenig klingen, aber ich habe ja auch einen Spielemix genutzt, der weniger zum Kirschenpflücken neigt. Die 11 Prozent sind in Full-HD also immer drin, auch außerhalb des bestellten YouTube-Schaulaufens.

Die AMD Radeon RX 7600, die ebenfalls zum Club der VRAM-Hungerleider zählt, wird auch bei reiner Rasterization locker geschlagen und das bei deutlich weniger Durst. Auch das steht auf der Haben-Seite der GeForce RTX 4060, die sogar in gewissem Maße attraktiv sein könnte, wäre der Preis nicht so überzogen. Ich weiß von einigen Boardpartnern, dass man die Karte eigentlich günstiger anbieten wollte, NVIDIA aber auf den 299 USD als MSRP (329 Euro als UVP in Deutschland) bestanden hat, warum auch immer. Ich sehe die Karte eher bei 289 als Einstiegspreis statt der festgelegten 329 Euro. Das wird definitiv in dieser Form so nicht zu halten sein, oder die Karten werden zu Blei in den Regalen.

Irgendetwas Neues für den Mainstream braucht der Markt ja durchaus, so gesehen passt die Karte als Full-HD-Offerte und Technologie-Träger durchaus. Ich finde DLSS praktisch und das komplette Feature-Set der Ada-Karten nimmt man gern mit, auch abseits des ganzen Gamings. Aber die pure Angst, dann damit eigene GeForce RTX 3060 12 GB zu kannibalisieren, die man aus unerfindlichen Gründen bis Q3 weiterlaufen lässt, zementiert den Preis leider dort, wo man echt keine Käufer abholen kann.

Und etwas härtere Kritik muss an dieser Stelle auch erlaubt sein. Dass eine aktuelle Karte im Idle solche Kapriolen schlägt (warum und wie auch immer) und der Treiber auch nach Tagen noch nicht gefixt wurde, entzieht sich meinem Verständnis komplett. Zumal auch der unnötige Wegfall der exakten Eingangsmessung mit Shunts und sauberem Monitoring dazu führt, dass die Karten deutlich mehr an Leistung unter Last aufnehmen als sie sollten. Da ist es umso verwunderlicher, dass alle Programme über die NVAPI viel zu niedrige Werte geliefert bekommen, die mit der tatsächlichen Leistungsaufnahme nichts mehr zu tun haben, aber interessanterweise den Werten des eigenen Marketings entsprechen. Die Referenzplatine ist so kostenoptimiert entworfen worden, dass das Ganze einfach schiefgehen musste. Wenn sich dann auch noch die Boardpartner an dieser neuen „Bescheidenheit“ orientieren, dann wird es für die Effizienz noch enger.

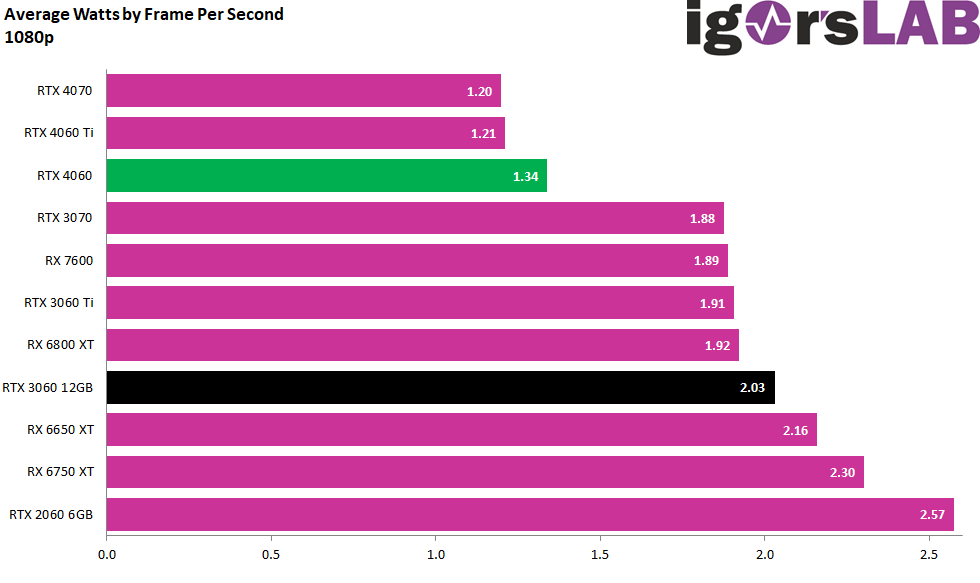

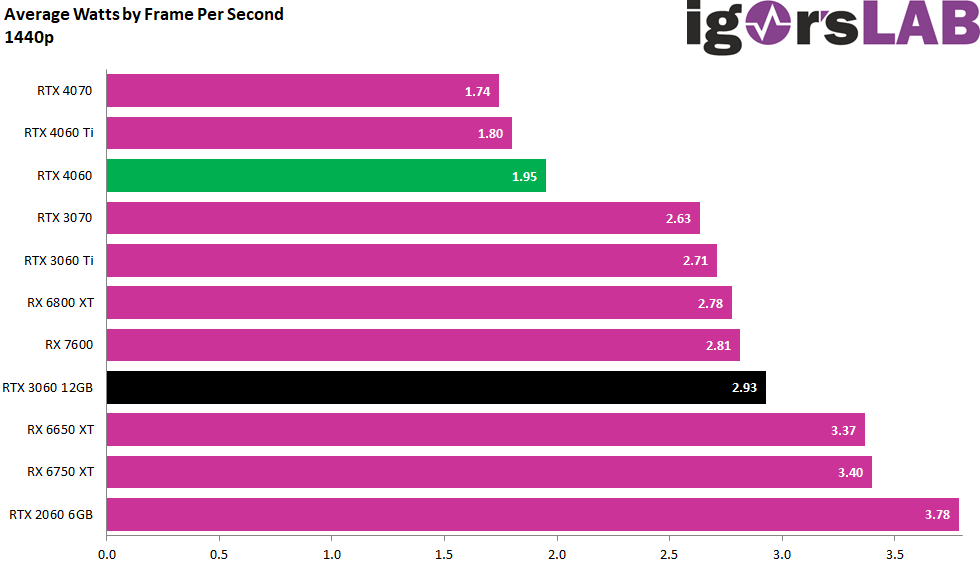

Denn auch die Effizienzbetrachtungen zeigen uns anschaulich, dass die GeForce RTX 4060 8 GB sehr deutlich hinter eine RTX 4060 Ti oder RTX 4070 zurückfällt. Das liegt nicht nur am Chip selbst, sondern primär an den Platinen und der technischen Umsetzung der Spannungswandler. Alles, was hier auf dem Weg bis zum Endverbraucher schon in Wärme umgesetzt wurde, fehlt später dann der GPU. Ich darf schon einmal spoilern, dass eine etwas liebevoller gestrickte OC-Karte bei der Effizienz einen Tick besser dasteht, obwohl ordentlich übertaktet wurde. Aber dazu gibt es dann morgen mehr, denn wir als normalsterbliche Tester dürfen ja leider nicht vorgreifen.

Die GeForce RTX 4060 8 GB ist eine Karte für Full-HD, wenn es um höhere Frameraten geht und auch noch bedingt geeignet für WQHD. Dann aber wird man bereits über smartes Upscaling nachdenken müssen, denn ohne DLSS wird es stellenweise auch schon in QHD etwas arg eng. Hier kann NVIDIA durchaus seine Vorteile ausspielen, die DLSS 2.x auch rein optisch bietet. Unterstützt ein Spiel jedoch DLSS 3.0 und man würde ohne Super Sampling im unspielbaren FPS-Bereich herumdümpeln, dann kann dies quasi sogar der ultimative Rettungsanker zur Spielbarkeit sein. Die Latenzen kann man damit nicht verbessern (sie bleiben ja gleich), aber nicht jedes Genre ist so latenzgebunden wie diverse Shooter.

Man bekommt somit alle Vorteile der Ada-Architektur ab 329 Euro (MSRP-Karten). Nachteilig sind allerdings der nicht mehr zeitgemäße Speicherausbau und das enge Speicherinterface. Die 8 Lanes am PCIe 4.0 reichen vollends aus, aber wenn die Karte auf den Systemspeicher zugreifen muss, wird es spätestens bei älteren Systemen mit PCIe 3.0 arg eng. Dann sind die 11 Prozent Vorsprung zur RTX 3060 12GB schneller weg als man Mops sagen kann.

Und falls man mich noch nach einem persönlichen Fazit fragt: Es fällt leicht anders aus als das, was vorab bei gewissen YouTubern bestellt wurde. Nicht absolut negativ, denn die positiven Seiten habe ich ja genannt. Aber echte Euphorie ist es auch nicht, dazu kostet die Karte einfach zu viel und hält auch energiepolitisch nicht ganz das, was im Vorfeld versprochen wurde. Treiber kann man fixen, kein Thema. Nur beim VRAM und der Telemetrie wirds dann doch etwas komplizierter.

Die Grafikkarte wurde von Palit für diesen Test zur Verfügung gestellt. Die einzige Bedingung war die Einhaltung der Sperrfrist, eine Einflussnahme oder Vergütung fand nicht statt.

- 1 - Einführung, technische Daten und Technologie

- 2 - Test System im igor'sLAB MIFCOM-PC

- 3 - Teardown: PCB und Komponenten

- 4 - Gaming Performance FHD (1920 x 1080)

- 5 - Gaming-Performance WQHD (2560 x 1440)

- 6 - Gaming Performance DLSS vs. DLSS3 vs. FSR

- 7 - Latenzen und DLSS 3.0

- 8 - Details: Leistungsaufnahme und Lastverteilung

- 9 - Lastspitzen, Kappung und Netzteilempfehlung

- 10 - Temperaturen, Taktraten, Lüfter und Geräuschentwicklung

- 11 - Zusammenfassung und Fazit

44 Antworten

Kommentar

Lade neue Kommentare

Neuling

1

Neuling

Neuling

Urgestein

Moderator

Urgestein

1

Urgestein

Urgestein

Veteran

Mitglied

1

Mitglied

Urgestein

Urgestein

Urgestein

Mitglied

1

Alle Kommentare lesen unter igor´sLAB Community →