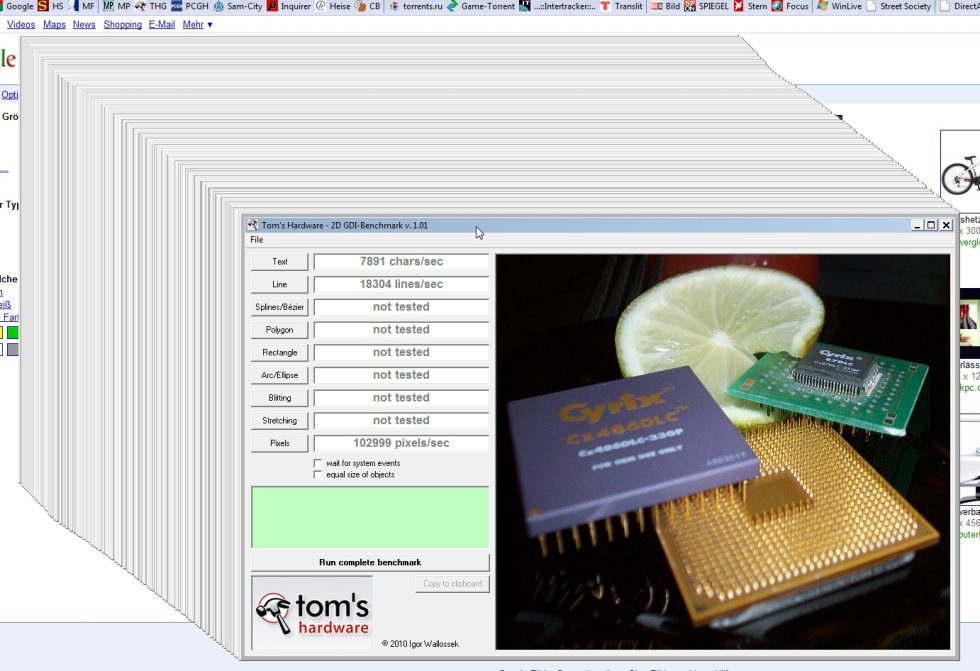

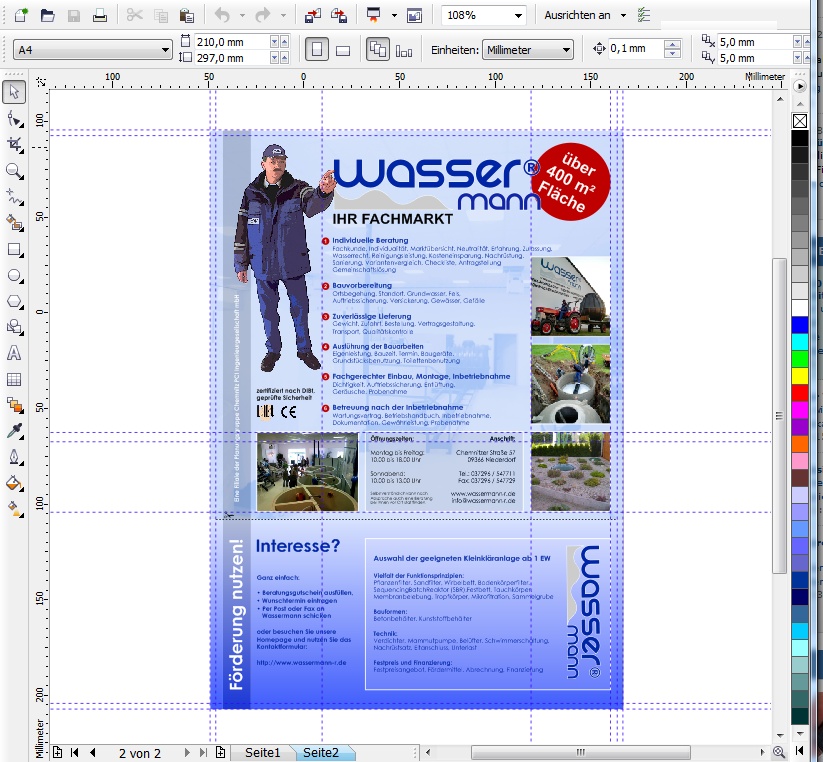

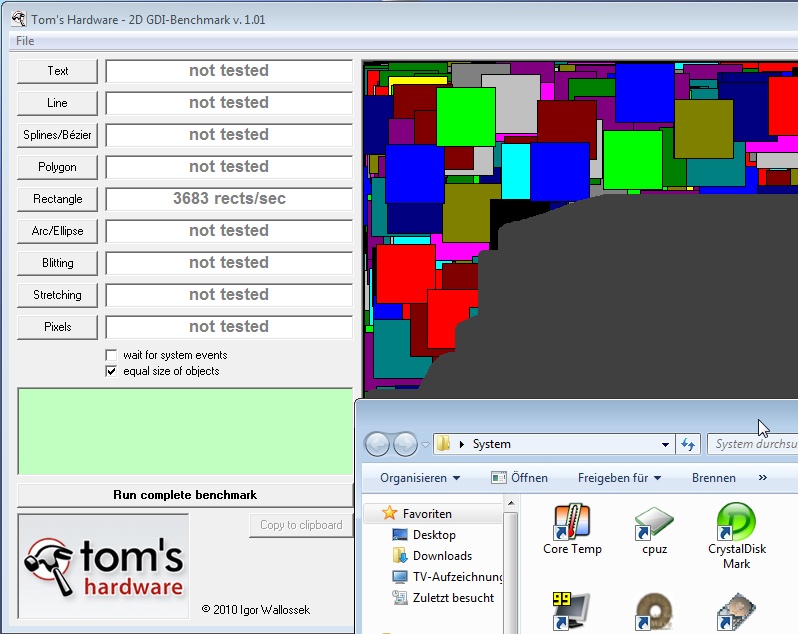

Man kann zu Windows XP stehen, wie man will – die Hardwarebeschleunigung des GDI funktioniert bis heute tadellos und für viele Anwendungsgebiete völlig ausreichend. Was XP leider nicht kann, ist die hardwarebasierte Umsetzung der 2.5D-Layer-Technik unter Ausnutzung der Möglichkeiten aktueller 3D-Karten. Das Zeichnen der Fensterinhalte erfolgt, wie im vorigen Kapitel beschrieben, noch direkt aus den Programmen heraus. Typische 2D-Anwendung, für die man eigentlich keine teure Grafikhardware kauft:

Dieses Verfahren stört nicht, solange der Anwender konzentriert in einem Fenster arbeitet. SDI-Umgebungen (Single Device Interface) sind hier der typische Anwendungsfall. Unangenehm wird es allerdings, wenn viele Fenster ins Spiel kommen. Wer freute sich nicht, ersatzweise zu einer besseren Layer-Technik die Menüs, Werkzeugleisten und Werkzeugfenster komplexer Anwendungen auf einen zweiten Monitor auslagern zu können, anstatt beim Verschieben stets lästige Nachzieheffekte der immer neu zu zeichnenden Fensterinhalte zu bewundern, wenn das System damit nicht mehr hinterherkam?

Während die reine 2D-Leistung in Vektor-Zeichenprogramme wie z.B. CorelDraw oder CAD-Anwendungen völlig ausreichte, da die Hardwarebeschleunigung des GDI ausreichend umgesetzt wurde, zeigen sich hier bereits die Grenzen der WM_Paint-Lösung. Die Oberfläche von XP, überladen mit Animationen, Softshadows, transparenten Fenstern und anderen Gimmicks war schlicht am Ende des Machbaren angekommen.

WM_Paint wird nicht oder nur sporadisch ausgelöst, solange das System ausgelastet ist. Events zum Neuzeichnen landen in der Warteschlange.Viele Anwender haben schnell herausgefunden, dass man Fenster beim Verschieben dann doch lieber als Rahmen anzeigt, auf animierte Menüs verzichtet und auch ansonsten besser sparsam mit den grafischen Ressourcen umgeht. Viele grafische Themen wurden nach erster Euphorie schnell wieder gelöscht – das System war einfach nicht mehr in der Lage, alles fehlerfrei zu rendern. Microsoft hat bald gemerkt, dass die Lösung, wie sie bis einschließlich XP verwendet wurde, möglichst schnell ersetzt werden muss. Das Angebot immer leistungsfähigerer 3D-Grafikkarten und das langsame, aber stetige Sinken der Preise für derartige Hardware taten dann ein Übriges. Eine typische Vertreterin der 3D-Grafikkarten dieser Zeit: Radeon X1800 von 2005

Wir wollen an dieser Stelle auch nicht verschweigen, dass die Hardwarebeschleunigung von XP lange Zeit nicht mit den 780G Onboard-Grafiklösungen von ATI funktionierte. Sich langsam aufbauende Fenster und lahmende Browser waren die unrühmliche Folge. Sprach man zunächst hinter vorgehaltener Hand von einem größeren Hardwarefehler, so konnten die größten Leistungsbremsen später durch neuere Treiber wieder beseitigt werden. Völlig optimal laufen die 780G (im Gegensatz zum 740G) bis heute nicht. Aber da XP mittlerweile an Bedeutung verliert, wollen wir dies lediglich als Randnotiz erwähnt wissen.

Deshalb zunächst Vorhang auf für Vista, das neben Windows ME wohl bisher am polarisierendste Betriebssystem von Microsoft überhaupt. Man kann Vista lieben oder hassen – der technische Fortschritt war nicht mehr aufzuhalten.

Zusammenfassung:

- Die 2D-Hardwarebeschleunigung der GDI-Befehle funktioniert klaglos

- Keine hardwarebeschleunigten 2.5D-Layer, langsame Oberfläche

- Das ständige Neuzeichnen verschobener Fensterinhalte kostet Zeit

- 1 - Einführung: 2D-Grafik – ungeliebtes Stiefkind oder Routineübung?

- 2 - Die Grenzen von 2D und 2.5D - Der Mythos 2D-Hardwarebeschleunigung

- 3 - Windows XP: Old school 2D und die Grenzen des WM_PAINT

- 4 - Windows Vista: Echter Fortschritt und die Kunst des Weglassens

- 5 - Windows 7: Rückkehr des verlorenen Sohnes

- 6 - Windows 7: Radeon HD5xxx ohne 2D-Beschleunigung

- 7 - Tom2D: 2D-Benchmark HD 5870 vs. GTX 285 unter Windows 7

- 8 - Tom2D: Fazit und Vorschau auf Teil 2 des Artikels

16 Antworten

Kommentar

Lade neue Kommentare

Mitglied

Veteran

Urgestein

1

Urgestein

1

Urgestein

Urgestein

Urgestein

Urgestein

Mitglied

Urgestein

1

Urgestein

Mitglied

1

Alle Kommentare lesen unter igor´sLAB Community →