XeSS 1.01 vs. DLSS 2.3 erster grafische Vergleich

Intels erster Versuch sich mit NVIDIA bzgl. Upscaling zu messen – ging in Bezug auf die FPS-Steigerung voll in die Hose. Da habe ich mir deutlich mehr erhofft. Ob XeSS mit einer dedizierten Intel GPU besser skaliert, das kann ich aufgrund des fehlenden Testsamples leider nicht beantworten. Aber, was die grafischen Aspekte betrifft, können wir einen ersten Blick auf XeSS werfen. Ich stelle euch hier zuerst die Bereiche vor, auf die ihr später mal ein Auge werfen solltet. Auf den nächsten Seiten findet ihr die Videos. Doch zuerst schauen wir uns mal eine Übersicht der Upscaling-Verfahren von NVIDIA, AMD und Intel an.

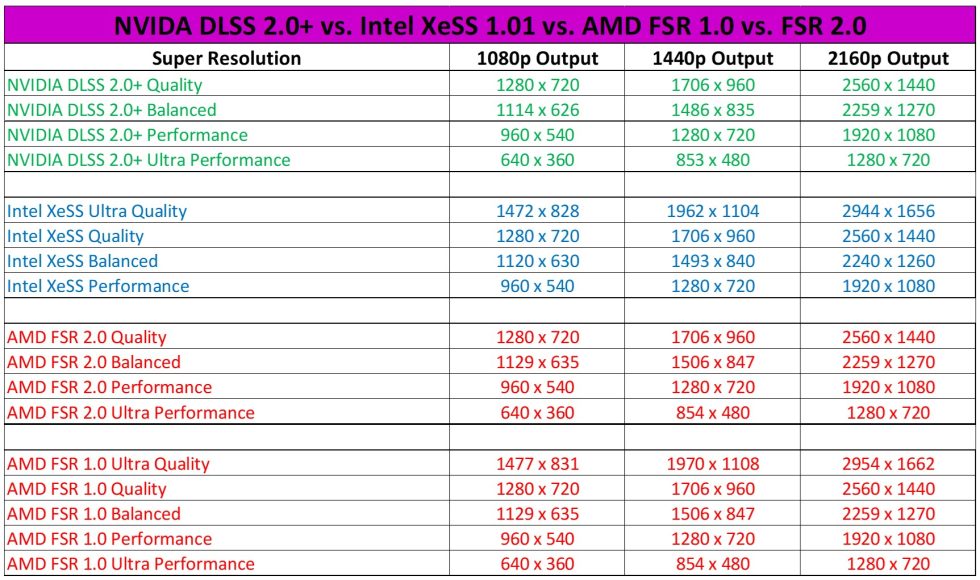

Jetzt wissen wir, dass alle irgendwie ähnlich – aber nicht wirklich gleich sind. Bei NVIDIA gibt es z.B. keinen Ultra Quality Modus. Bei FSR 2.0 gibt es den auch nicht mehr. Dafür hat Intel keinen Ultra Performance Modus. Es ist also nicht immer leicht, die Sachen am Ende zu vergleichen. Vergleicht man es gemäß der Namensgebung passen die Auflösungen nicht immer zueinander. Nimmt man die Auflösungen als Vergleichsbasis, dann verwirren die Namen. Schwierig! Daher mache ich es für Intel als Neuling heute mal einfacher und benachteilige an der Stelle im Grunde NVIDIA:

DLSS Quality vs. XeSS Ultra Quality

DLSS Balanced vs. XeSS Quality

DLSS Performance vs. XeSS Balanced

DLSS Ultra Performance vs. XeSS Performance

Die erste Stelle, auf die ihr euer Augenmerk legen solltet, ist das Geländer auf dem Dach. Hier zeigt XeSS in allen Stufen seine Schwäche gegenüber DLSS. Mit DLSS wird das Geländer deutlich besser und flackerfrei dargestellt.

Bei dem Fahrrad kann XeSS ganz gut mithalten. Die letzte Stufe – DLSS Ultra Performance schwächelt am Ende auch. Aber in Ultra Performance kann man Abstriche schon mal verzeihen. Der Modus ist am Ende nur was für völlig FPS-Verrückte, denen die Grafik vermutlich egal ist.

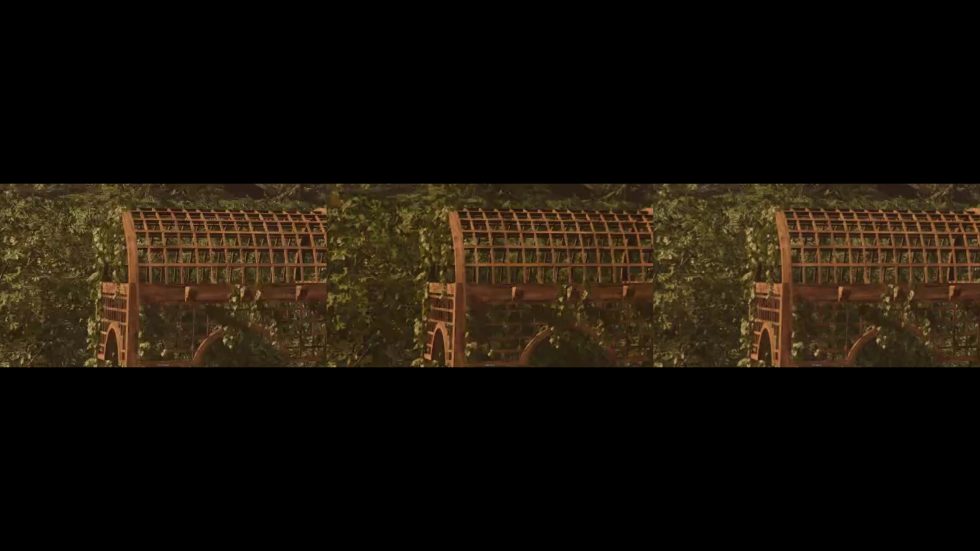

Bei dem Holz-Dingens-keine-Ahnung… was auch immer das sein soll, zeigt XeSS deutlich früher Schwächen auf. Im Allgemeinen finde ich es mit DLSS grundsätzlich schärfer dargestellt. (Anmerkung: weder bei DLSS noch XeSS kann man die Schärfe regulieren)

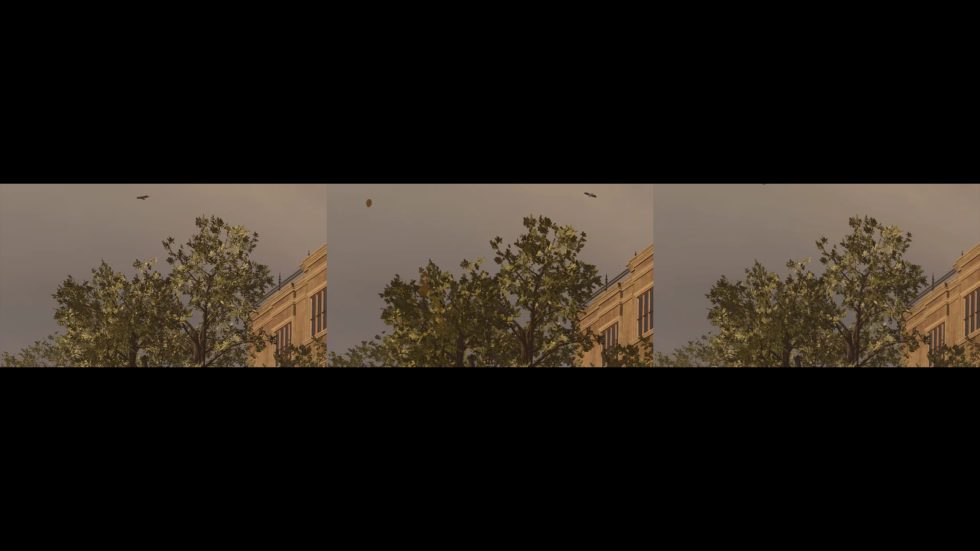

Auch ein Blick auf die Äste und Zweige lohnt sich. Was hier sofort auffällt, dass beide (DLSS und XeSS) im Vergleich zu 2160p nativ die Farben auswaschen. Saftiges Grün wird ausgebleicht. Liegt sehr wahrscheinlich am Nachschärfen. Auch wenn DLSS hier am Ende ein Ticken besser ist, stellt sich mir die Frage für was? Dass das menschliche Auge, das Geländer auf dem Dach – auf die Entfernung noch detailliert wahrnehmen kann – ist klar. Auch das Holz-Ding (whatever) nimmt das Auge gut war. Aber die Blätter weit hinten und hoch oben?

Ein Blick auf die Hecke bestätigt bzw. verdeutlicht nochmals, dass die Farben ausgewaschen werden. Dafür werden die Blätter deutlich schärfer dargestellt. Bedenkt man die “reale” Entfernung zur Hecke und dass ich hier stark vergrößert habe, stellt sich mir die Frage nach der Sinnhaftigkeit. Ich hätte es lieber grüner und etwas unschärfer. Wie es real auch der Fall wäre.

Mein persönliches zwischen Fazit zum heutigen Vergleich DLSS vs. XeSS

Beide Upscaling Techniken überschärfen das Bild und waschen damit die Farben massiv aus. Sieht man am besten, wenn man die Split-Screen-Vergleiche zur nativen Auflösung macht. Hier würde ein manueller Schärferegler dem Nutzer die Wahl lassen, wie scharf es denn sein soll. Bitte an Intel und NVIDIA bzw. die Spieleentwickler – sowas gehört bei jedem Spiel mit integriert. Was die grafische Performance im Allgemeinen betrifft, so muss ich feststellen, dass Intel mit XeSS in etwa auf dem Niveau von FSR 2.0 bzw. DLSS 2.0 gestartet ist. Bis auf kleinere Schwächen, die leider schon ab Ultra Quality zu Tage treten, ist das schon solide. Natürlich kommt XeSS nicht ganz an DLSS 2.3 heran. DLSS ist sowohl grafisch einen ticken besser, und wenn man die FPS-Steigerung noch mit in die Relation setzt, dann zeigt DLSS wer hier der Chef ist.

Auf den nächsten vier Seiten habe ich für euch die jeweiligen Vergleiche als Video-Datei verlinkt. Neu ist dabei, dass ihr selbst mit der Maus und dem Scroll-Rad alles interaktiv anschauen könnt. Das ist doch ein netter Kundenservice, oder nicht? Ebenso könnt ihr euch das Ganze auf einer extra Seite in groß öffnen. Via Link unter dem Video! Schaut euch die von mir beschriebenen Bereiche selbst an und wer von euch noch weitere Unterschiede zwischen XeSS und DLSS zur nativen Auflösung findet, der darf das gerne im Forum anzeigen.

Kurze Galerie bzgl. der Bedienung des Players

Ihr könnt vergrößern bis zum Vollbild. (Geht auch mit dem Mausrad) Ihr könnt die Positionen der Videos ändern (Links, Mitte, Rechts), je nach Belieben. Ich empfehle nativ in der Mitte. Wer gerne ein Overlay hätte, der kann sich das auch drüberlegen. Startet das Video oder lasst es in einem endlos-loop laufen. Im Split-Screen könnt ihr mit dem Slider arbeiten. Es ist alles für euch angerichtet. Die Bedienung ist echt simple. So dann viel Spaß beim Vergleichen… Weiter gehts dann mit Cyberpunk auf Seite 10.

- 1 - Einführung und Testsystem

- 2 - Call of Duty Black Ops Cold War RTX 3080 Ti

- 3 - Call of Duty Black Ops Cold War RTX 4090

- 4 - Lara Croft hat die Wahl: XeSS oder DLSS als FPS Booster

- 5 - Grafikvergleich NVIDIA DLSS vs. Intel XeSS

- 6 - 2160p nativ vs. DLSS Balanced vs. XeSS Quality

- 7 - 2160p nativ vs. DLSS Performance vs. XeSS Balanced

- 8 - 2160p nativ vs. DLSS Quality vs. XeSS Ultra Quality

- 9 - 2160p vs. DLSS Ultra Performance vs. XeSS Performance

- 10 - Cyberpunk 2077 eine neue Zeitrechung mit DLSS 3.0

- 11 - Cyberpunk 2077 - RTX 4090 mit DLSS 3.0

- 12 - Cyberpunk 2077 RTX 3080 Ti vs. RTX 4090

- 13 - DLSS 2.3 vs. DLSS 3.0 Bildqualität Cyberpunk 2077

- 14 - DLSS 2.3 vs. DLSS 3.0 Balanced vs. 2160p nativ

- 15 - DLSS 2.3 vs. DLSS 3.0 Performance vs. 2160p nativ

- 16 - DLSS 2.3 vs. DLSS 3.0 Ultra Performance vs. 2160p nativ

- 17 - DLSS 3.0 vs. FSR 1.0

- 18 - DLSS 3.0 Quality vs. FSR 1.0 Quality vs. 2160p nativ

- 19 - DLSS 3.0 Balanced vs. FSR 1.0 Balanced vs. 2160p nativ

- 20 - DLSS 3.0 Perfomance vs. FSR 1.0 Perfomance vs. 2160p nativ

- 21 - DLSS 3.0 Ultra Perfomance vs. FSR 1.0 Ultra Perfomance vs. 2160p nativ

- 22 - Zusammenfassung und Fazit

132 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Moderator

Neuling

Urgestein

Moderator

Moderator

Veteran

Urgestein

Moderator

Neuling

Veteran

Urgestein

Moderator

Moderator

Veteran

Urgestein

Moderator

Moderator

Veteran

Alle Kommentare lesen unter igor´sLAB Community →