Heute können wir endlich die NVIDIA GeForce RTX 4080 Founders Edition (FE) einschließlich aller technischen Details und der lang ersehnten Benchmarks vorstellen, denn die Spannungskurve war schon reichlich groß. Auch wenn NVIDIA die Karte eigentlich als Nachfolgerin der GeForce RTX 3080 sieht, ist es doch eine Kampfansage an die RTX 3090 und vor allem auch an die GeForce RTX 3090 Ti, denn preislich wird man wohl genau dort landen, wo das alte Spitzenmodell mal lag. Auch bei der GeForce RTX 4080 gibt es wieder richtig fette Kühler, denn ich schrieb ja schon in einem Artikel zur Herkunft der mega-großen Kühler für die RTX 4090, dass man die TBP erst im Nachhinein extrem eingkürzen konnte. Hier sind die Aufbauten immerhin noch um 100 Watt überdimensioniert, denn die geplante TDP wurde von einstmals 420 Watt auf 320 Watt eingekürzt. Das macht natürlich umso neugieriger, vor allem was Temperaturen und Lautstärke betrifft.

Wichtiges Vorwort

Heute geht es erst einmal primär um die technische Übersicht einschließlich der GeForce RTX 4080 FE als Testobjekt. Natürlich wie gewohnt samt Benchmarks, Teardown, Platinen- und Kühler Analyse, sowie die Leistungsaufnahme und die Lastspitzen mit Netzteilempfehlung. Selbstverständlich haben wir auch die wichtigen Dinge wie DLSS 3.0 und Reflex mit in den Benchmarks (samt kurzer Einführungen), aber ich muss bereits jetzt auf die vielen weiteren Follow-Ups verweisen, die sich dann mit weiteren Benchmarks, Bildqualitätsvergleichen zu FSR und Xe sowie den Latenzen befassen werden.

Diese Materie ist mittlerweile nämlich so komplex geworden, dass man dem Thema mit einem kurzen Drüberfliegen einfach nicht gerecht werden würde. Wir haben dann sogar eine spezielle Video-Analyse für Euch, deren Basis ich bereits für die RTX 4090 im CMS eingebaut hatte. Es lohnt sich also auch diesmal, die NVIDIA-Woche bis zum Ende zu genießen. Und wir werden diesen ganzen Aufwand natürlich auch als Grundlage dafür nutzen, um im November dann dies alles noch einmal direkt mit der kommenden RDNA3-Grafikkarten-Generation von AMD zu vergleichen.

Der AD 103 und die neue Ada-Architektur

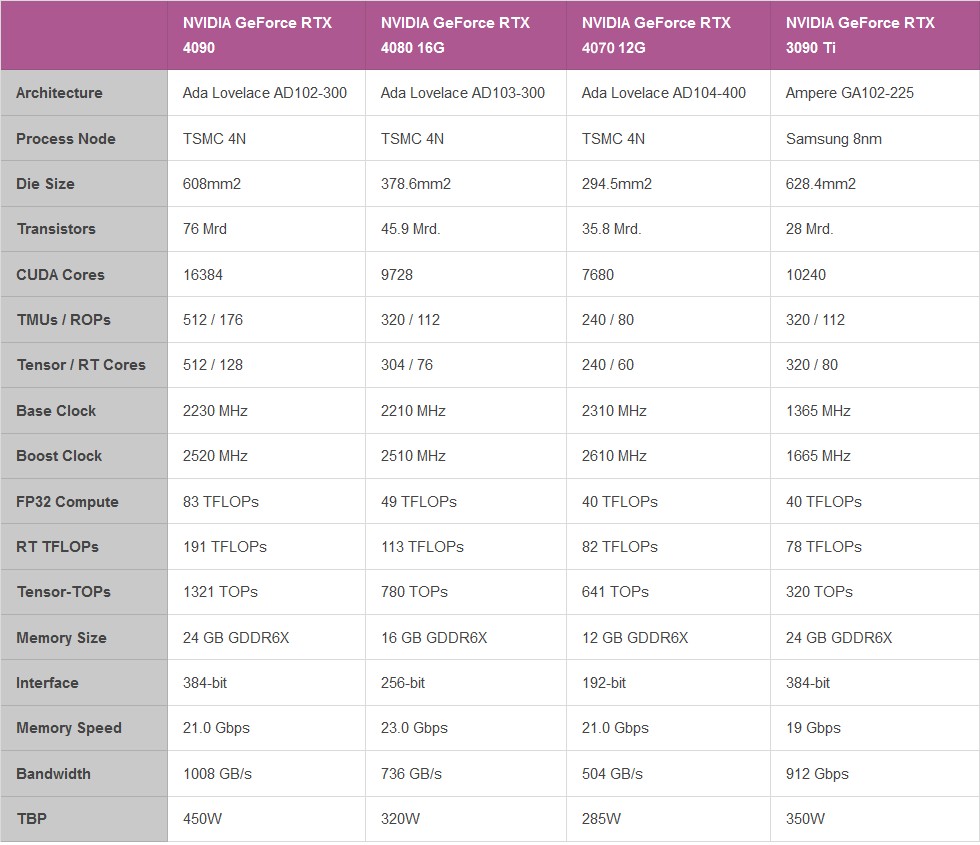

Die NVIDIA GeForce RTX 4080 wird ebenfalls im TSMC 4N Prozess gefertigt und verfügt über 45.9 Milliarden Transistoren und bietet, da kann ich schon einmal spoilern, ebenfalls einen ordentlichen Sprung in Sachen Leistung, Effizienz und auch KI-gestützter Grafik, selbst wenn die Lücke zur GeForce RTX 4090 nahezu riesig erscheint. Die Ada-Architektur setzt dabei auf bis zu 7 Graphic Processing Clusters (GPC) und bis zu 80 neue Streaming-Multiprozessoren (SM) mit 10.240 CUDA Cores, deren Performance und Energieeffizienz deutlich gestiegen ist.

Dazu kommen Tensor-Kerne der 4. Generation und Optical Flow, was transformative KI-Technologien, einschließlich NVIDIA DLSS und dem neuen Bildraten-Vervielfacher NVIDIA DLSS 3 ermöglicht. Die RT-Kerne der 3. Generation bieten bis zu 2-fache Raytracing-Leistung, Shader Execution Reordering (SER) verbessert die Raytracing-Operationen zudem um das Doppelte. Außerdem nutzt nun auch NVIDIA einen dualen AV1 Encoder, wobei der NVIDIA Encoder (NVENC) der 8. Generation mit AV1 bis zu 40% effizienter als H.264 arbeiten soll.

Der AD103-300 der GeForce RTX 4080 wurde etwas beschränkt und bietet in der Summe zwar immer noch 7 GPC, von denen jedoch zwei von 12 auf 10 SM eingekürzt wurden und einer sogar auf 8 SM. Damit ergeben sich noch 76 SM einschließlich der 9728 CUDA-Cores für den Chip der neuen Consumer-Karte. Dazu kommen noch insgesamt 38 Texture Processing Clusters (TPC), 76 RT-Cores der 3. Generation, 304 Tensor-Cores der 4. Generation, 304 Texture Units (TU) und 112 ROPs. Der L2-Cache ist insgesamt 65536 KB groß und die Karte nutzt 16 GB GDDR6X mit 11200 MHz Takt an einem 256-bit Interface, was einer Datenrate von 22,4 Gbps und einer Bandbreite von 716,8 GB/s entspricht.

Die Änderungen an allen drei Kern-Typen kann man recht einfach zusammenfassen:

- Programmierbarer Shader: Die SM von Ada umfassen eine wichtige neue Technologie namens Shader Execution Reordering (SER), die die Arbeit im laufenden Betrieb neu ordnet, was eine 2-fache Beschleunigung fürs Raytracing ermöglicht. SER ist eine ebenso große Innovation, wie es seinerzeit die Out-of-Order-Ausführung für CPUs war. 83 Shader-TFLOPS sind da schon eine Ansage

- Tensor Cores der 4. Generation: Der neue Tensor Core in Ada umfasst die NVIDIA Hopper FP8 Transformer Engine, die in der RTX 4090 über 1,3 PetaFLOPS für KI-Inferenz-Workloads liefert. Im Vergleich zu FP16 halbiert FP8 den Datenspeicherbedarf und verdoppelt die KI-Leistung. Die GeForce RTX 4090 bietet somit mehr als das Doppelte der gesamten Tensor Core-Verarbeitungsleistung der RTX 3090 Ti.

- RT Core der 3. Generation: Eine neue Opacity Micromap Engine beschleunigt das Raytracing von alphageprüften Geometrien um den Faktor 2. Dazu kommt eine neue Micro-Mesh Engine, die die ganze geometrische Fülle ohne weitere BVH-Erstellungs- und Speicherkosten bewältigt. Der Triangulierungs-Durchsatz beträgt 191 RT-TFLOPS, verglichen mit den 78 RTTFLOPS bei Ampere.

Die Karte setzt nach wie vor auf ein PCIe Gen. 4 Interface und nur beim externen Stromanschluss mit dem 12VHPWR-Anschluss (12+4 Pin) auf ein Element der PCIe Gen. 5 Spezifikation. Die TGP liegt bei 320 Watt und kann, je nach Boardpartner, auch auf bis zu 400 Watt angehoben werden (was eher sinnlos ist, weil die Spannung irgendwann sowieso limitiert). Die für den Chip maximal zulässigen 90 °C wird der extrem überdimensionierte Kühler ja sowieso zu verhindern wissen.

Die NVIDIA GeForce RTX 4080 FE 16 GB im Detail

Die FE wiegt “nur” 2123 Gramm. Mit den 30,5 cm Länge und 12,5 cm Höhe ab Slot bis zur Oberkante und einer Dicke von genau 6 cm ist das zwar noch ein echter Kracher, aber sie ist trotzdem noch deutlich kompakter als die meisten Boardpartnerkarten. Mit drei 6+2-Pin-Anschlüssen fällt der beigelegte Adapter auf den 12+4 Pin-Anschluss ähnlich aus, wie der alte Dreier der GeForce RTX 3090 Ti. Was uns wohl in der Endkonsequenz erwartet? Ich weiß es ja schon und Ihr dürft Euch gleich überraschen lassen!

Man kann natürlich nicht nur Strom in die Karte stecken, sondern auch Videoanschlüsse. Vier, um ganz genau zu sein, als da wären: dreimal DisplayPort 1.4a und einmal HDMI 2.1a. Das ist vor allem beim DisplayPort schade, wenn es um die neuen Spezifikationen für 2.1 geht. Chance vertan, leider. Aber mal ehrlich: wann wird es bezahlbare Monitore geben. 2023? Eher kaum…

Sieht aus wie eine geschlossene Veranstaltung, doch es ist nicht der einzige magnetische Verschluss, den man entblättern kann! Doch alles zu seiner Zeit, heute ist bei der Unterwäsche erst einmal Schluss. Nackte Tatsachen gibt es gleich, versprochen!

Damit wäre die erste Seite geschafft und wir bereiten uns schon einmal langsam aufs Testgeschehen vor.

- 1 - Einführung, technische Daten und Technologie

- 2 - Test System im igor'sLAB MIFCOM-PC

- 3 - Teardown: Platine und Kühler

- 4 - Gaming-Performance WQHD (2560 x 1440 Pixel)

- 5 - Gaming-Performance UHD (3840 x 2160 Pixel)

- 6 - Gaming-Performance UHD + DLSS/FSR/XeSS (3840 x 2160 Pixel)

- 7 - DLSS 3.0 und die längsten Balken

- 8 - NVIDIA Reflex und Latenzen

- 9 - Workstation Grafik und Rendering

- 10 - Leistungsaufnahme und Lastverteilung

- 11 - Lastspitzen, Kappung und Netzteilempfehlung

- 12 - Temperaturen, Taktraten, Lüfter und Lautstärke

- 13 - Zusammenfassung und Fazit

168 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Veteran

1

Veteran

Mitglied

Urgestein

Veteran

Moderator

Veteran

Urgestein

Mitglied

Veteran

Urgestein

Veteran

Mitglied

Neuling

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →