Summary

The GeForce RTX 4070 is a highly interesting mid-range graphics card as long as you ignore the price. Therefore, NVIDIA has put some pressure on the board partners to also offer at least one model with a price that corresponds to the RRP. Of course, the shortcomings in the technical implementation, including the limitation of the power limit to 200 watts, can be argued about. Of course, you can easily do without RGB, light metal and other optical extras if the price is right.

But it is left to further tests when it comes to assessing the technical implementation. Mandatory cost saving is always a bad companion and it is to be feared that due to the restrictive power limit, such things as cooling and PCB design could then fall by the wayside. But I have planned to do that separately. For now, it’s all about pure performance. And that’s where my overclocking test with NVIDIA’s Founders Edition today shows two very important things.

To play reasonably performant games, the 200 watts are also easily enough, because you can reach or even beat a GeForce RTX 3080 10GB, of course depending on the game and resolution. That’s the good side. However, the up to 20 watts more of an overclockable card are quite well invested money, because the 10% more energy can be converted into up to 10% more performance in some situations, such as DLSS, when the tensor cores are also fully utilized. However, the advantage in terms of screening performance is much smaller. However, the effects of the higher power consumption are also more noticeable in the Min FPS than in the pure average and that’s where it gets interesting again.

After all, efficiency considerations also show us that efficiency does not drop at the higher power limit, on the contrary.

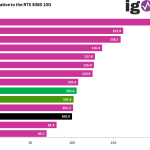

The GeForce RTX 4070 is an excellent card in Full HD when it comes to highest frame rates and is also well suited for WQHD. However, smart upscaling will have to be considered in Ultra HD at the latest, and that’s where DLSS comes into play. Meanwhile, games like “The Last of Us Part 1” (TLOU) even subjectively look better in Ultra HD with DLSS than native Ultra HD. NVIDIA can definitely use its advantages here, which DLSS 2.x also offers purely optically. However, if a game supports DLSS 3.0 and you would be stuck in the unplayable FPS range without Super Sampling, then this can even be the lifeline to playability. You can’t improve latencies with it, but not every genre is as latency-bound as various shooters. For TLOU, I would have liked to see DLSS 3.0, but you can’t have everything.

You get all the advantages of the Ada architecture starting at 659 Euros (MSRP cards) and could be quite satisfied with that in the context of the current price spiral, if it weren’t for the memory expansion and the narrow memory interface, which I had already noted in the GeForce RTX 4070 Ti. Yes, that might be enough for WQHD at the moment, but games like TLOU unfortunately show us that resources are being used more and more wastefully and the memory could be full faster than you can say pug. We can already see: So there is always something. Thus, you can currently still get along very well with it under WQHD, only in Ultra HD there are games that already consider the given 12 GB too puny due to various HD texture packs. This can be seen either way, but it could have been avoided if the AD104 had been designed differently. Two memory controllers are simply missing here, but who am I telling.

I see a certain need for improvement in the drivers. There is still a lot of untapped potential here, especially in the professional sector. I had already noted that as well.

The NVIDIA GeForce RTX 4070 FE 12GB

The cooler is very good in the context of the TBP, but the board as such is rather average, because especially the cheap voltage converters are disappointing. Especially since two more phases could easily have been implemented directly and without changing the layout. But somewhere had to be saved, even if it was only two DrMOS, two coils and up to 4 cup capacitors. The possible 5 USD per card is always a pleasure to take. There’s no need to write anything about the 12VHPWR connection, we’ve already gone through that enough.

The fact that NVIDIA adapted my pad mod without comment is quite remarkable. The relocation of the primary shunt to the back of the board including cooling also has charm, if you read through my tests in this regard again. On the other hand, the fact that this is implemented in a rather low-performance card is rather amusing. But as a practice project, the card is good. Visually and haptically, the Founders Edition is, as always, a cream and collector’s item. Especially since I will definitely question the origin of my chip. But even so, the FE would certainly have made my shortlist if it was to be such a WQHD card.

200-Watt Board Partner Cards at MSRP

I have cards here from MSI, PNY (since last night) and Palit (currently at Fritz for the latency tests). We have already tested the cards in a first hands-on and I do not want to anticipate the individual tests or a final roundup. Apart from the limited power target of 200 watts, the look, feel, operating noise and temperatures are unfortunately far from NVIDIA’s Founders Edition. Yes, you can do all that and also accept it somehow, but sometimes it might make more sense to add a few more euros. But I won’t (be able to) clarify that today and here, because you have to do objective justice to each individual product.

Conclusion

The GeForce RTX 4070 with the AD104-250 is a highly interesting mid-range card that does not yet have to fear any direct rivals from AMD in this generation. In terms of efficiency, NVIDIA once again sets standards that AMD still has to measure up to. If and when the RX 7800 series will come then and if we will see 16 GB memory expansion again, that is still up in the stars. But gamers live in the here and now, and there are simply no alternatives at the moment if you want the full feature set, including high-quality super sampling and AI.

Apart from the outdated Display Port port and the 12 GB memory expansion, which is meager for Ultra HD, I do not see any drawbacks that would speak against the GeForce RTX 4070. Except for the price, but that has unfortunately become a running joke and affects all areas of daily life. Even chips and Coke for playing games have risen in price adequately. That doesn’t make things any nicer, but at least a little more plausible. The manufacturers will hardly make big profits at least with the MSRP cards, that much I can reveal at least. I’m not allowed to do more than that because the calculations are all under NDA. Unfortunately, this also diminishes the hope that the upcoming AMD cards will be significantly cheaper. It should already be clear that NVIDIA will be undercut again, but it should not and cannot be much. The current manufacturing costs (not production costs) also speak against this.

The graphics cards were provided by NVIDIA, MSI, Palit and PNY for this test. The only condition was compliance with the blocking period; there was no influence or remuneration.

- 1 - Introduction, Specs and Unboxing

- 2 - Test system, equipment and methods

- 3 - Teardown: PCB, components and cooler

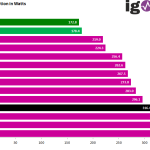

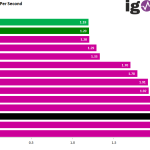

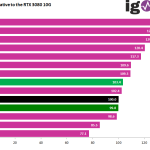

- 4 - Gaming Performance Full HD (1920 x 1080)

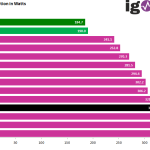

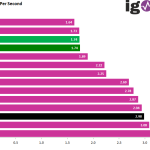

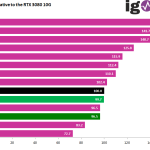

- 5 - Summe Gaming-Performance WQHD (2560 x 1440)

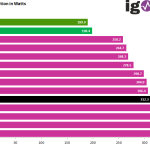

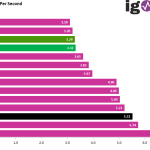

- 6 - Gaming Performance Ultra HD (3840 x 2160)

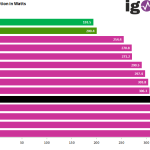

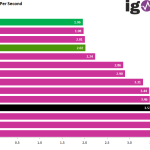

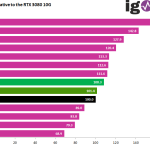

- 7 - Gaming Performance DLSS vs. FSR

- 8 - Latency and DLSS 3.0

- 9 - Workstation and rendering

- 10 - Power consumption and PEG loads

- 11 - Transients, cutting and PSU recommendation

- 12 - Clock rate and OC, temperatures and thermal imaging

- 13 - Fan speed and noise level

- 14 - Summary and conclusion

258 Antworten

Kommentar

Lade neue Kommentare

Moderator

1

Urgestein

Neuling

Urgestein

Neuling

1

Veteran

Neuling

Urgestein

Urgestein

Veteran

Mitglied

Mitglied

Veteran

Urgestein

Urgestein

Urgestein

Mitglied

Alle Kommentare lesen unter igor´sLAB Community →