Was macht man als Hersteller, um auf ein neues Produkt aufmerksam zu machen? Man splittet einfach den Launch einer solchen GeForce RTX 4070 12 GB und veröffentlicht zuerst die Karten, die auch zum UVP angeboten werden. So schön, so unaufregend, denn am Ende sind alle diese Karten irgendwie gleich. Bis auf eine, denn die ist viel gleicher als die anderen. Und das ist NVIDIAs eigene Founders Edition. Doch während die Leistungsgrenze aller sogenannten “MSRP-Karten” bei 200 Watt gedeckelt ist, erlaubt die Founders Edition 20 Watt mehr und ist damit eigentlich eine getarnte OC-Karte, die nur manuell auf diesen Sockel eingestellt werden muss.

Und was macht der Kunde? Für einen UVP von 659 Euro lässt NVIDIA heute die Einsteigerkarten von der Leine und hofft, in der wichtigen Mittelklasse Boden gut zu machen. Am Ende kann ich schon verraten, dass die Leistung eher der einer GeForce RTX 3080 FE 10 GB entspricht, nur dass hier sogar 2 GB mehr Speicher zur Verfügung stehen. Anhand der technischen Daten hätte die GeForce RTX 3080 10GB wahrscheinlich einen größeren Vorteil, aber Papier ist geduldig und die Realität ist viel differenzierter. Ja, der Preis ist jetzt nicht wirklich das bahnbrechende Sonderangebot, aber es hätte auch schlimmer kommen können. Und solange der direkte Konkurrent in dieser Klasse nichts Neues zu bieten hat, wird NVIDIA die alleinige Autorität in Sachen Preis haben.

Ich habe die NVIDIA GeForce RTX 4070 FE mit der MSI RTX 4070 Ventus und der PNY RTX 4070 12 GB zuvor in Bezug auf die Leistung verglichen, und der Unterschied liegt bei oder sogar unter einem Prozent, was für Messungenauigkeit und Chip-Lotterie spricht, wobei die MSI-Karte den schlechteren Kühler hat als die FE. Die PNY-Karte ist ein bisschen von allem und liegt pflichtbewusst dazwischen. Für die heutige Leistung werde ich also etwas anderes tun, als alle drei Karten auf buchhalterisch korrekte Weise gegenüberzustellen. An gleich langen Balken ist sowieso niemand interessiert. Ich werde die einzelnen Karten dann Schritt für Schritt im Detail vorstellen, denn es gibt durchaus Unterschiede in der technischen Umsetzung, den Kühlern und der Optik. Aber alles zu seiner Zeit. Es wird also noch mehrere Einzelberichte geben, keine Sorge. Nur für heute war das alles einfach zu viel.

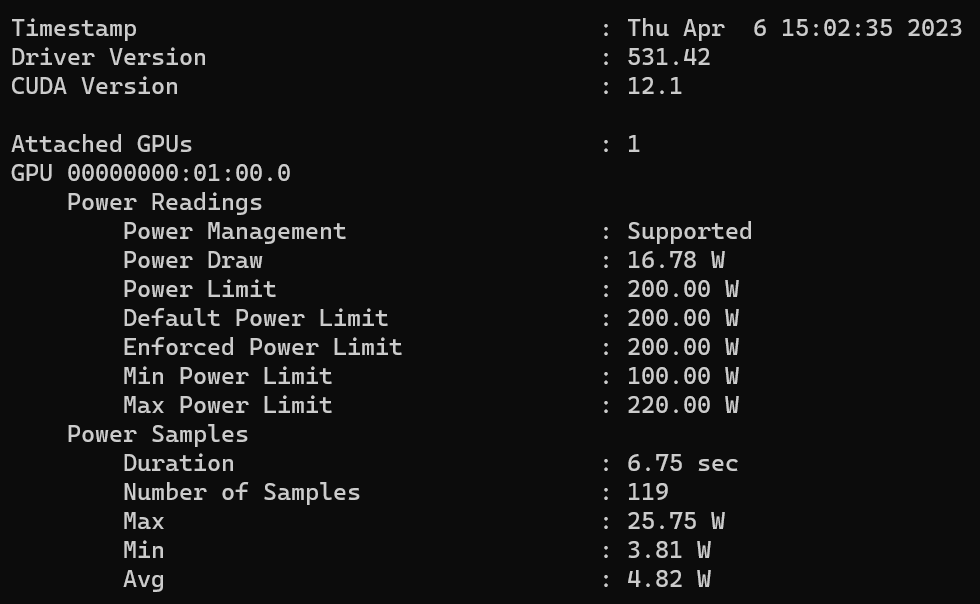

Stattdessen teste ich heute die NVIDIA GeForce RTX 4070 FE 12 GB out of the box, wo sie die gesamte 200-Watt-Klasse der sogenannten MSRP-Karten repräsentiert, denn die Leistung ist identisch. Und natürlich gibt es noch die Krönung des Durchlaufs mit den 220 Watt als maximale Leistungsgrenze, bei der ich den Takt um weitere 150 MHz erhöht habe. Es ist nicht meine Schuld, dass diese Karte im Bereich der OC-Karten liegt, die erst morgen auf den Markt kommen werden. Die Karte kann und deshalb zeige ich sie. Und ohne etwas Verbotenes zu spoilern: Ich habe nie mehr als 215 Watt gebraucht, auch nicht an der Taktgrenze. Deshalb kann ich in der Nacht vor der Markteinführung ganz gut schlafen und mir das Doppelte sparen.

Wichtiges Vorwort

Natürlich gibt es wie immer viele Benchmarks, den umfangreichen Teardown, eine sehr aufwendige Board- und Kühleranalyse mit etwas Reverse Engineering, sowie die Analyse des Stromverbrauchs und der Lastspitzen inklusive einer passenden Netzteil-Empfehlung. Da ich weiß, dass viele Kollegen auch alle technischen Details samt Theorie wiederholen werden, die bereits in diversen Leckerbissen vorgestellt wurden, erspare ich mir das heute im großen Stil und verweise nur kurz auf die bereits bekannten Daten. Schließlich wollen Sie heute echte Zahlen sehen und kein PR-Feuerwerk. Natürlich kommen die Daten später auf dieser Seite.

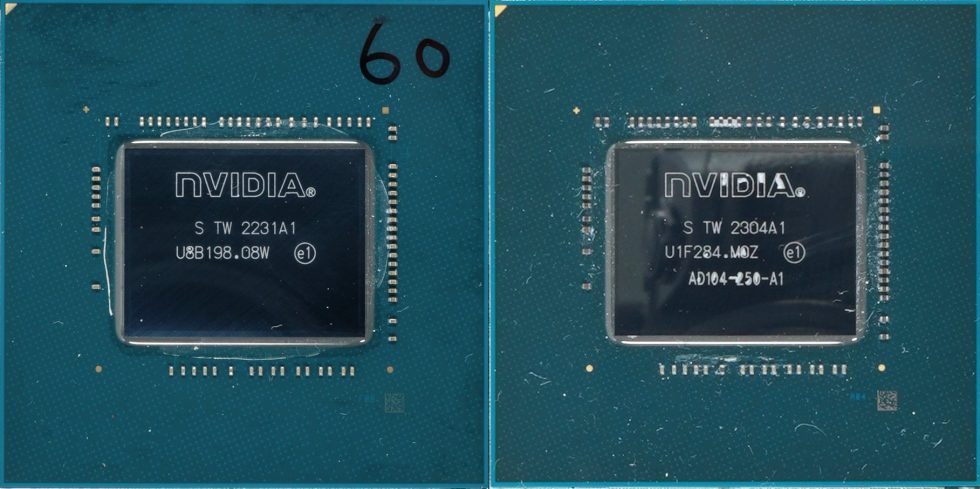

Ich werde aber auf alle Metriken einschließlich DLSS 3 näher eingehen und an den entsprechenden Stellen diverse Teaser bis hin zu den Latenzen, über die ein Kollege (Fritz Hunter) am Freitag ein größeres Special vorbereitet. Da der Aufwand hier höher ist, nimmt dies natürlich etwas mehr Zeit in Anspruch. Damit wäre die 4070er Woche komplett. Und auch bei den Chips gibt es einen kleinen Unterschied. Während die Founders Edition meines Pressesamples einen Chip ohne Typenbezeichnung aus der KW 31 von 2022 inklusive handgemalter Nummer hat, setzen die AIC-Karten auf neuere Chips wie den MSI Ventus mit einem komplett beschrifteten AD104-250 aus der KW 4 im Jahr 2023.

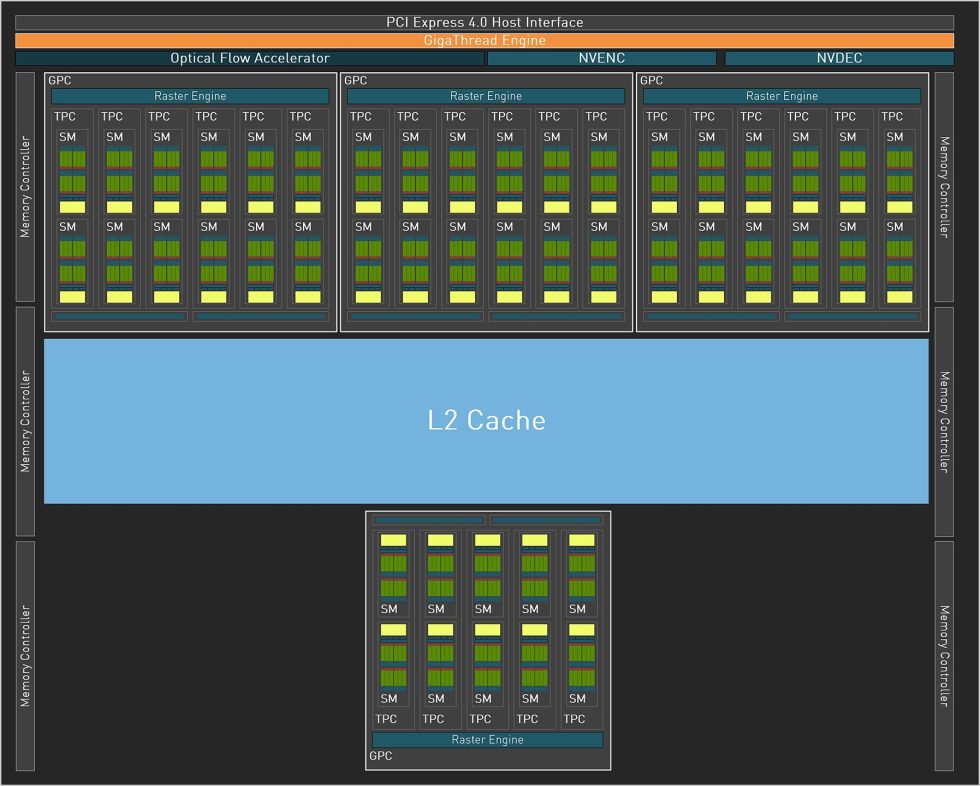

Der AD 104 und die neue Ada-Architektur

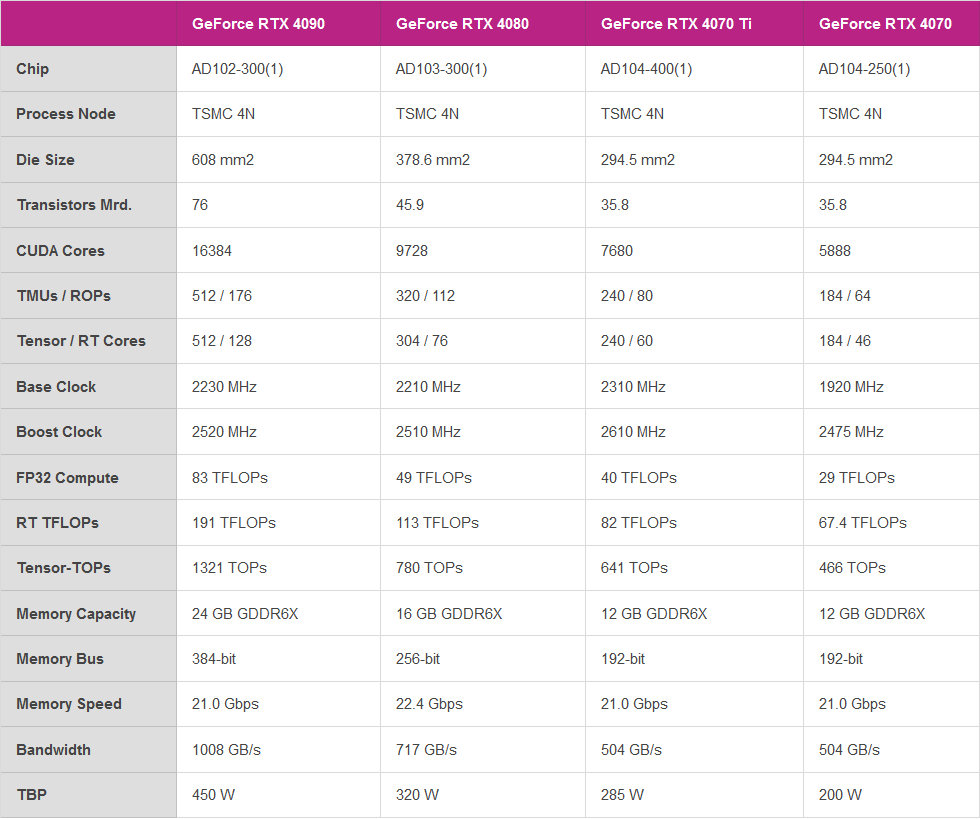

Der 294,5 mm² große Chip der NVIDIA GeForce RTX 4070 ist ebenfalls im TSMC 4N-Prozess gefertigt und hat 35,8 Milliarden Transistoren. Die AD104-250 verfügt nach wie vor über vier Graphic Processing Cluster (GPC) und 46 neue Streaming Multiprozessoren (SM) mit 5888 CUDA-Kernen, deren Leistung und Energieeffizienz im Vergleich zu Ampere deutlich gesteigert werden konnten. Außerdem gibt es 184 Tensor-Kerne der 4. Generation und Optical Flow, die transformative KI-Technologien wie NVIDIA DLSS und den neuen NVIDIA DLSS 3 Frame Rate Multiplier ermöglichen.

Die 46 RT-Kerne der 3. Generation Die neue Generation bietet bis zu 2-fache Raytracing-Leistung, Shader Execution Reordering (SER) verbessert Raytracing-Operationen um den Faktor 2. Darüber hinaus gibt es insgesamt 23 Texture Processing Cluster (TPC), 184 Texture Units (TU) und 64 ROPs. Der L2-Cache beträgt insgesamt 36864 KB und die Karte nutzt wie die GeForce RTX 4070 Ti die bekannten 12 GB GDDR6X, die mit 10500 MHz auf einem eher schmalen 192-Bit-Interface getaktet sind, was einer Datenrate von 21 Gbps und einer Bandbreite von 504 GB/s entspricht. Der AD104-250 der GeForce RTX 4070 bietet statt vier nur einen NVDEC (Decoder) und einen einzigen NVENC (Encoder). Der AV1-Encoder soll bis zu 40 % effizienter als H.264 sein.

Die Änderungen an allen drei Kerntypen lassen sich recht einfach zusammenfassen:

- Programmierbarer Shader: Der SM von Ada enthält eine wichtige neue Technologie namens Shader Execution Reordering (SER), die die Arbeit im laufenden Betrieb neu ordnet und so eine zweifache Beschleunigung für Raytracing ermöglicht. SER ist eine ebenso große Innovation wie das Out-of-Order-Design für CPUs zu jener Zeit. 83 Shader-TFLOPS sind eine beeindruckende Leistung

- Tensor Cores der 4. Generation: Der neue Tensor Core in Ada umfasst die NVIDIA Hopper FP8 Transformer Engine, die über 1,3 petaFLOPS für KI-Inferenz-Workloads in der RTX 4090 liefert. Im Vergleich zu FP16 halbiert FP8 den Datenspeicherbedarf und verdoppelt die KI-Leistung. Damit bietet die GeForce RTX 4090 mehr als doppelt so viel Tensor Core Rechenleistung wie die RTX 3090 Ti.

- RT Core der 3. Generation: Eine neue Opazitäts-Micromap-Engine beschleunigt das Raytracing von alphakontrollierten Geometrien um den Faktor 2. Hinzu kommt eine neue Micro-Mesh-Engine, die den gesamten geometrischen Reichtum ohne weitere BVH-Erstellung und Speicherkosten verarbeitet. Der Triangulationsdurchsatz beträgt 191 RT-TFLOPS, verglichen mit 78 RTTFLOPS bei Ampere.

Die Karte setzt immer noch auf eine PCIe Gen. 4-Schnittstelle und nur für den externen Stromanschluss mit dem 12VHPWR-Anschluss (12 4-Pin) auf ein Element der PCIe Gen. 5-Spezifikation. Das TGP liegt bei 200 (220) Watt und kann je nach Boardpartner auch auf 240 Watt erhöht werden (was aber eher sinnlos ist, da die Spannung irgendwann ohnehin begrenzt ist).

Die NVIDIA GeForce RTX 4070 FE 12 GB im Detail

Die Karte wiegt nur 1020 Gramm. Die Länge von 24,5 cm ist moderat und die Höhe von 10,5 cm liegt auf dem Normalmaß. Da braucht man keinen Trum von Gehäuse, auch wenn man den tollen 12VHPWR Adapter nutzen muss, sondern kommt mit 2x 6 2-Pin aus. Die Einbautiefe beträgt 3,8 cm plus die 5 mm für die Backplate-Befestigung auf der Rückseite. Das macht sie zu einer echten Dual-Slot-Karte.

Der Leichtmetallrahmen ist bekannt und auch die Designsprache von Lüfter, Abdeckung und Slotblende ist nicht neu. Nur dass alles reichlich geschrumpft aussieht. NVIDIA verwendet ein einziges BIOS und wer übertakten will, muss ein entsprechendes Tool verwenden. Die Haptik ist wie gewohnt hochwertig, die Karten haben durchaus Sammlerwert und wirken angenehm zeitlos.

Aber man kann nicht nur Strom in die Karte stecken, sondern auch Videoanschlüsse. Vier an der Zahl, um genau zu sein, denn es gibt: dreimal DisplayPort 1.4a und einmal HDMI 2.1a. Das ist besonders schade für den DisplayPort, wenn es um die neuen Spezifikationen geht. Eine verpasste Chance, leider. Und bei HDMI muss man ab 4K mit der Kompression tricksen, wenn es über 120 Hz gehen soll.

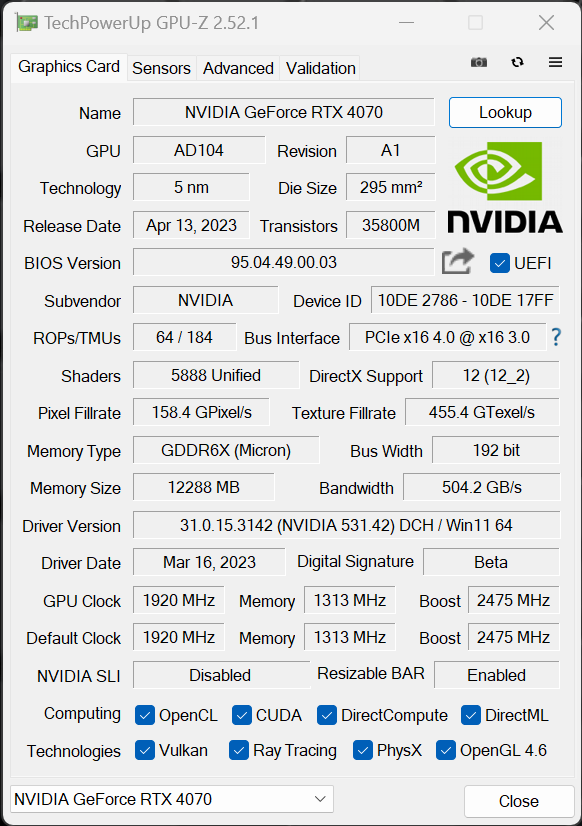

Der Screenshot von GPU-Z zeigt uns die Standardeinstellungen der RTX 4070, die für alle 200-Watt-Karten identisch sind:

Damit ist die erste Seite fertig und wir bereiten uns langsam auf den Test vor.

- 1 - Introduction, Specs and Unboxing

- 2 - Test system, equipment and methods

- 3 - Teardown: PCB, components and cooler

- 4 - Gaming Performance Full HD (1920 x 1080)

- 5 - Summe Gaming-Performance WQHD (2560 x 1440)

- 6 - Gaming Performance Ultra HD (3840 x 2160)

- 7 - Gaming Performance DLSS vs. FSR

- 8 - Latency and DLSS 3.0

- 9 - Workstation and rendering

- 10 - Power consumption and PEG loads

- 11 - Transients, cutting and PSU recommendation

- 12 - Clock rate and OC, temperatures and thermal imaging

- 13 - Fan speed and noise level

- 14 - Summary and conclusion

258 Antworten

Kommentar

Lade neue Kommentare

Moderator

1

Urgestein

Neuling

Urgestein

Neuling

1

Veteran

Neuling

Urgestein

Urgestein

Veteran

Mitglied

Mitglied

Veteran

Urgestein

Urgestein

Urgestein

Mitglied

Alle Kommentare lesen unter igor´sLAB Community →