Zusammenfassung

Die GeForce RTX 4070 ist eine hochinteressante Mittelklasse-Grafikkarte, solange man über den Preis hinwegsieht. Daher hat NVIDIA die Boardpartner unter Druck gesetzt, auch mindestens ein Modell mit einem Preis anzubieten, der der UVP entspricht. Über die Unzulänglichkeiten in der technischen Umsetzung, darunter die Begrenzung der Leistung auf 200 Watt, lässt sich natürlich streiten. Auf RGB, Leichtmetall und andere optische Extras kann man natürlich getrost verzichten, wenn der Preis stimmt.

Aber das bleibt weiteren Tests überlassen, wenn es darum geht, die technische Umsetzung zu beurteilen. Sparzwang ist immer ein schlechter Begleiter und es ist zu befürchten, dass aufgrund der restriktiven Leistungsbegrenzung dann solche Dinge wie Kühlung und Platinengestaltung auf der Strecke bleiben könnten. Aber das habe ich separat geplant. Im Moment geht es nur um die reine Leistung. Und da zeigt mein heutiger Übertaktungstest mit NVIDIAs Founders Edition zwei sehr wichtige Dinge.

Um einigermaßen performante Spiele zu spielen, reichen die 200 Watt auch locker aus, denn man kann eine GeForce RTX 3080 10GB erreichen oder sogar übertreffen, natürlich je nach Spiel und Auflösung. Das ist die gute Seite. Allerdings sind die bis zu 20 Watt mehr einer übertaktbaren Karte durchaus gut investiertes Geld, denn die 10% mehr Energie können in manchen Situationen, wie z.B. DLSS, in bis zu 10% mehr Leistung umgewandelt werden, wenn auch die Tensor-Kerne voll ausgelastet sind. Der Vorteil in Bezug auf die Screening-Leistung ist jedoch wesentlich geringer. Allerdings machen sich die Auswirkungen des höheren Stromverbrauchs auch bei den Min FPS stärker bemerkbar als beim reinen Durchschnitt und da wird es wieder interessant.

Schließlich zeigen auch Effizienzbetrachtungen, dass der Wirkungsgrad an der oberen Leistungsgrenze nicht abnimmt, im Gegenteil.

Die GeForce RTX 4070 ist in Full HD eine hervorragende Karte, wenn es um höchste Frameraten geht und auch für WQHD gut geeignet. Spätestens in Ultra HD muss jedoch über ein intelligentes Upscaling nachgedacht werden, und hier kommt DLSS ins Spiel. Mittlerweile sehen Spiele wie „The Last of Us Part 1“ (TLOU) in Ultra HD mit DLSS sogar subjektiv besser aus als natives Ultra HD. Hier kann NVIDIA durchaus seine Vorteile ausspielen, die DLSS 2.x auch rein optisch bietet. Wenn ein Spiel jedoch DLSS 3.0 unterstützt und man ohne Super Sampling im unspielbaren FPS-Bereich feststecken würde, dann kann dies sogar der Rettungsanker zur Spielbarkeit sein. Die Latenzen kann man damit nicht verbessern, aber nicht jedes Genre ist so latenzabhängig wie diverse Shooter. Für TLOU hätte ich gerne DLSS 3.0 gesehen, aber man kann nicht alles haben.

Ab 659 Euro (MSRP-Karten) bekommt man alle Vorteile der Ada-Architektur und könnte damit im Rahmen der aktuellen Preisspirale durchaus zufrieden sein, wäre da nicht der Speicherausbau und das schmale Speicherinterface, das ich schon bei der GeForce RTX 4070 Ti angemerkt hatte. Ja, das mag im Moment für WQHD reichen, aber Spiele wie TLOU zeigen uns leider, dass die Ressourcen immer verschwenderischer eingesetzt werden und der Speicher schneller voll sein könnte, als man Mops sagen kann. Wir können es schon sehen: Es gibt also immer etwas. So kann man derzeit unter WQHD noch sehr gut damit auskommen, nur in Ultra HD gibt es Spiele, denen die vorgegebenen 12 GB aufgrund diverser HD-Texturpakete schon zu mickrig sind. Das kann man so oder so sehen, hätte aber vermieden werden können, wenn der AD104 anders konzipiert worden wäre. Es fehlen hier einfach zwei Speichercontroller, aber wem sage ich das.

Einen gewissen Verbesserungsbedarf sehe ich bei den Treibern. Hier gibt es noch viel ungenutztes Potenzial, vor allem im professionellen Bereich. Das hatte ich auch schon festgestellt.

Die NVIDIA GeForce RTX 4070 FE 12GB

Der Kühler ist im Rahmen des TBP sehr gut, aber das Board als solches ist eher durchschnittlich, denn vor allem die billigen Spannungswandler sind enttäuschend. Zumal zwei weitere Phasen direkt und ohne Änderung des Layouts leicht hätten implementiert werden können. Aber irgendwo musste gespart werden, auch wenn es nur zwei DrMOS, zwei Spulen und bis zu 4 Becherkondensatoren waren. Die möglichen 5 USD pro Karte nimmt man gerne in Kauf. Über den 12VHPWR-Anschluss brauchen wir nichts mehr zu schreiben, das haben wir schon zur Genüge getan.

Die Tatsache, dass NVIDIA meinen Pad-Mod kommentarlos übernommen hat, ist schon bemerkenswert. Auch die Verlegung des primären Shunts auf die Rückseite des Boards inklusive Kühlung hat Charme, wenn man sich meine diesbezüglichen Tests noch einmal durchliest. Dass dies in einer eher leistungsschwachen Karte umgesetzt wird, ist dagegen eher amüsant. Aber als Praxisprojekt ist die Karte gut. Optisch und haptisch ist die Founders Edition wie immer ein Sahnestück und Sammlerstück. Zumal ich die Herkunft meines Chips sicherlich in Frage stellen werde. Aber auch so wäre die FE sicherlich in die engere Wahl gekommen, wenn es denn eine solche WQHD-Karte sein sollte.

200-Watt-Karten von Board-Partnern zum MSRP

Ich habe hier Karten von MSI, PNY (seit gestern Abend) und Palit (derzeit bei Fritz für die Latenztests). Wir haben die Karten bereits in einem ersten Hands-On getestet und ich möchte weder den einzelnen Tests noch einem finalen Roundup vorgreifen. Abgesehen vom begrenzten Leistungsziel von 200 Watt sind Optik, Haptik, Betriebsgeräusch und Temperaturen leider weit von NVIDIAs Founders Edition entfernt. Ja, man kann das alles machen und auch irgendwie akzeptieren, aber manchmal ist es vielleicht sinnvoller, ein paar Euro mehr auszugeben. Aber das werde ich heute und hier nicht klären (können), denn man muss jedem einzelnen Produkt objektiv gerecht werden.

Fazit

Die GeForce RTX 4070 mit der AD104-250 ist eine hochinteressante Mittelklassekarte, die in dieser Generation noch keine direkten Konkurrenten von AMD fürchten muss. In Sachen Effizienz setzt NVIDIA einmal mehr Maßstäbe, an denen sich AMD noch messen lassen muss. Ob und wann die RX 7800 Serie dann kommt und ob wir wieder 16 GB Speichererweiterung sehen werden, das steht noch in den Sternen. Aber Gamer leben im Hier und Jetzt, und es gibt im Moment einfach keine Alternativen, wenn man den vollen Funktionsumfang inklusive hochwertigem Super-Sampling und KI haben möchte.

Abgesehen von dem veralteten Display-Port-Anschluss und der für Ultra HD mageren Speichererweiterung von 12 GB sehe ich keine Nachteile, die gegen die GeForce RTX 4070 sprechen würden. Außer dem Preis, aber der ist leider ein Running Gag geworden und betrifft alle Bereiche des täglichen Lebens. Selbst Chips und Cola zum Spielen haben sich entsprechend verteuert. Das macht die Sache zwar nicht schöner, aber zumindest ein wenig plausibler. Große Gewinne werden die Hersteller zumindest mit den MSRP-Karten kaum machen, so viel kann ich zumindest verraten. Mehr darf ich nicht sagen, weil die Berechnungen alle unter NDA stehen. Leider schwindet damit auch die Hoffnung, dass die kommenden AMD-Karten deutlich billiger sein werden. Es sollte schon klar sein, dass NVIDIA wieder unterboten werden wird, aber es sollte und kann nicht viel sein. Dagegen sprechen auch die aktuellen Herstellungskosten (nicht Produktionskosten).

Die Grafikkarten wurden von NVIDIA, MSI, Palit und PNY für diesen Test zur Verfügung gestellt. Einzige Bedingung war die Einhaltung der Sperrfrist, eine Beeinflussung oder Vergütung gab es nicht.

- 1 - Introduction, Specs and Unboxing

- 2 - Test system, equipment and methods

- 3 - Teardown: PCB, components and cooler

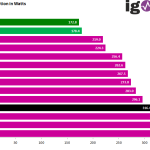

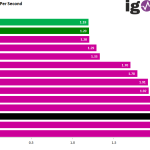

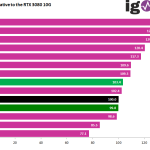

- 4 - Gaming Performance Full HD (1920 x 1080)

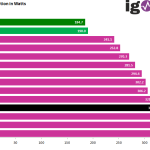

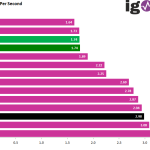

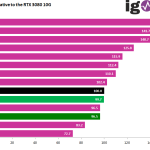

- 5 - Summe Gaming-Performance WQHD (2560 x 1440)

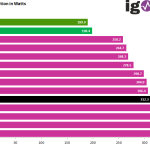

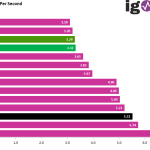

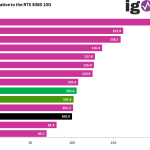

- 6 - Gaming Performance Ultra HD (3840 x 2160)

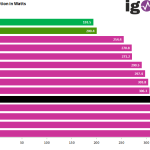

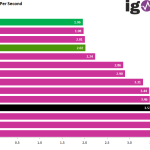

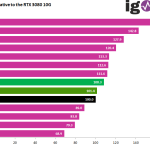

- 7 - Gaming Performance DLSS vs. FSR

- 8 - Latency and DLSS 3.0

- 9 - Workstation and rendering

- 10 - Power consumption and PEG loads

- 11 - Transients, cutting and PSU recommendation

- 12 - Clock rate and OC, temperatures and thermal imaging

- 13 - Fan speed and noise level

- 14 - Summary and conclusion

258 Antworten

Kommentar

Lade neue Kommentare

Moderator

1

Urgestein

Neuling

Urgestein

Neuling

1

Veteran

Neuling

Urgestein

Urgestein

Veteran

Mitglied

Mitglied

Veteran

Urgestein

Urgestein

Urgestein

Mitglied

Alle Kommentare lesen unter igor´sLAB Community →