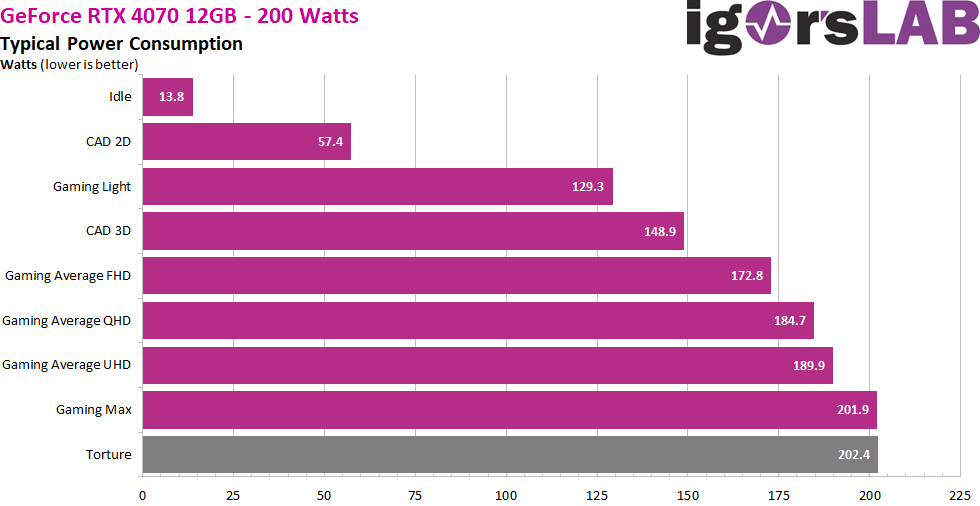

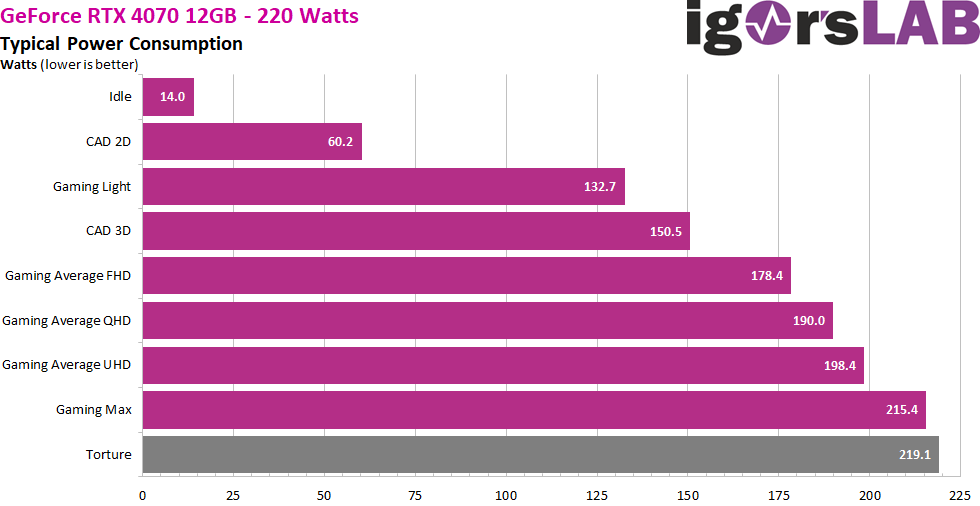

Stromverbrauch im Werkszustand als Zusammenfassung

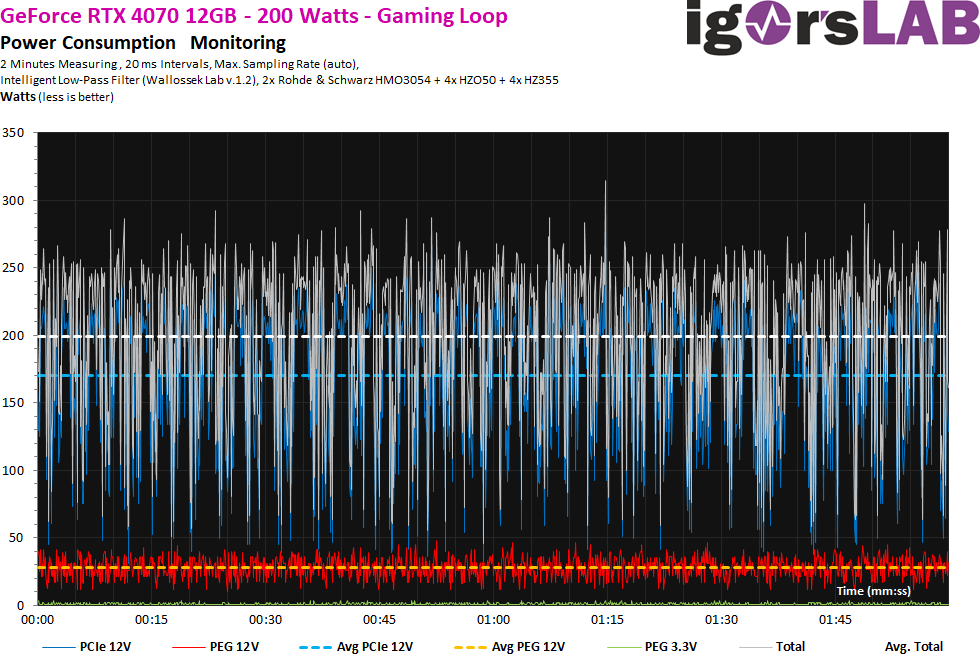

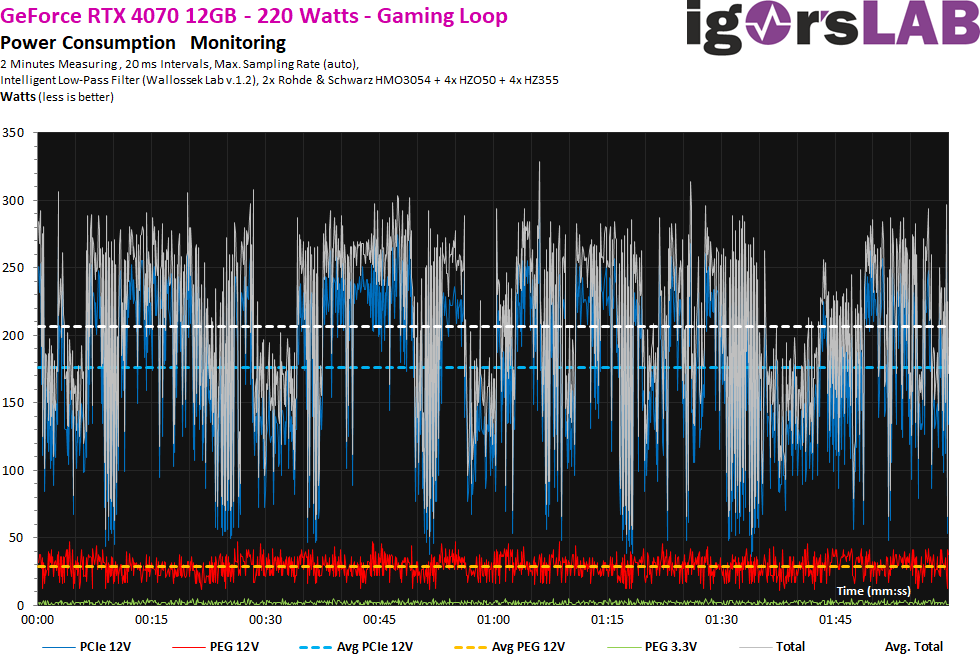

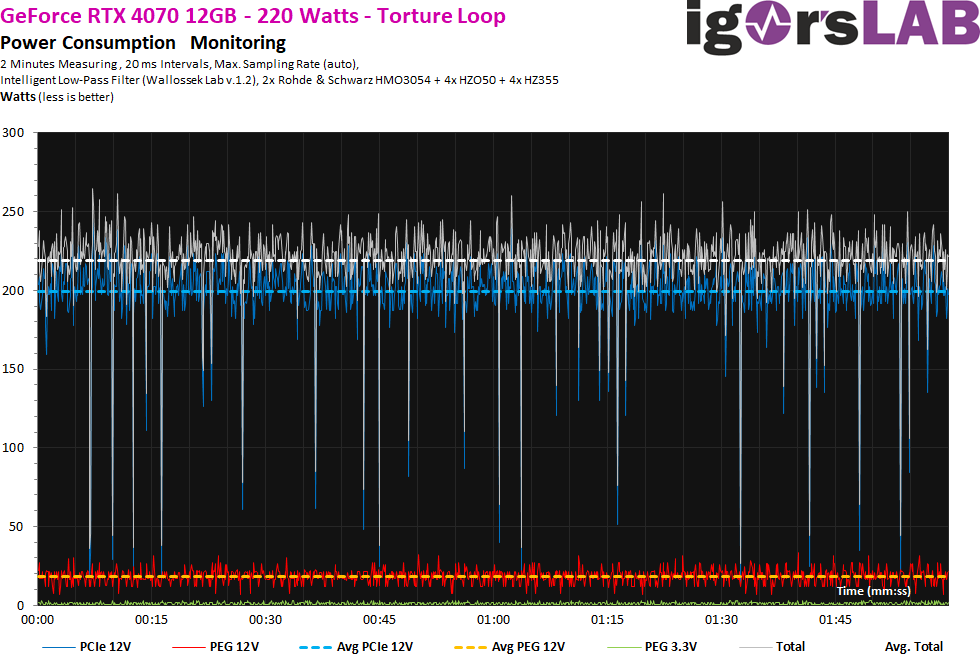

Die rund 14 Watt im Leerlauf sind in Ordnung. Mit einem zweiten Monitor und einer anderen Auflösung werden daraus aber schnell 35 Watt und mehr. Übrigens können wir sehr schön sehen, dass das volle TBP von 200 Watt selten ausgeschöpft wird und nur die Torture Loop oder ein Spiel hier überhaupt den Rahmen erreicht. Im Normalfall ist es immer weniger. Beim Betrieb an der 220 Watt Leistungsgrenze sehen wir, dass diese auch im Extremfall beim Spielen nicht erreicht wird.

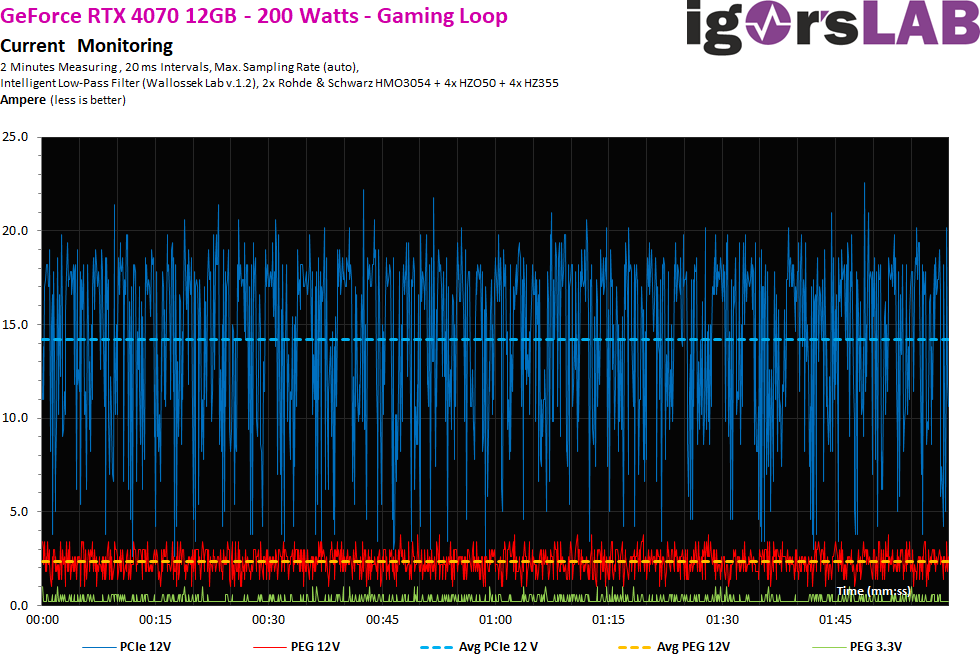

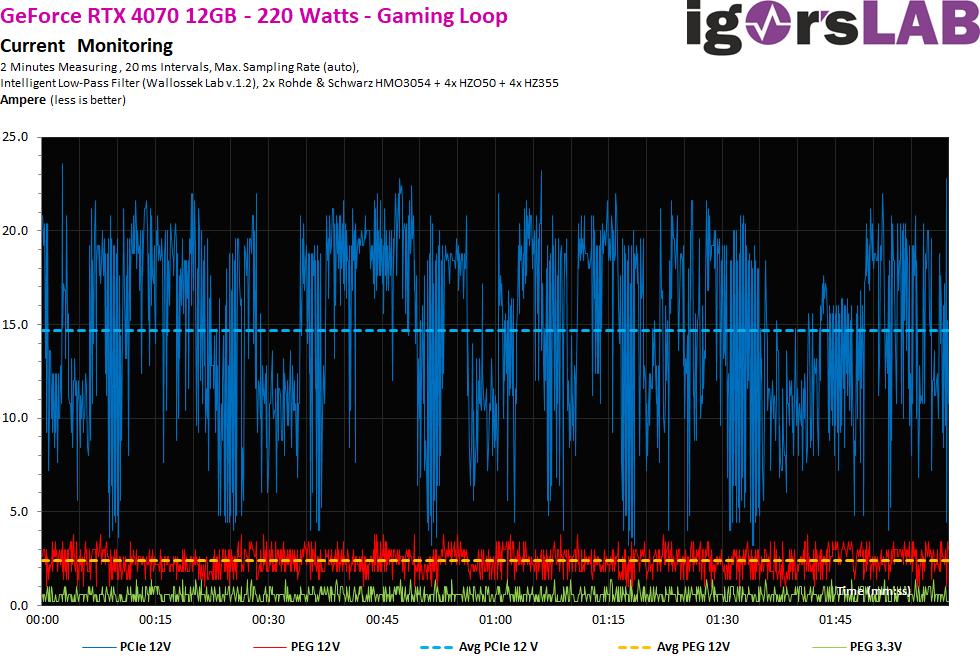

Lastverteilung zwischen PCIe-Slot und den PCIe-Sockeln

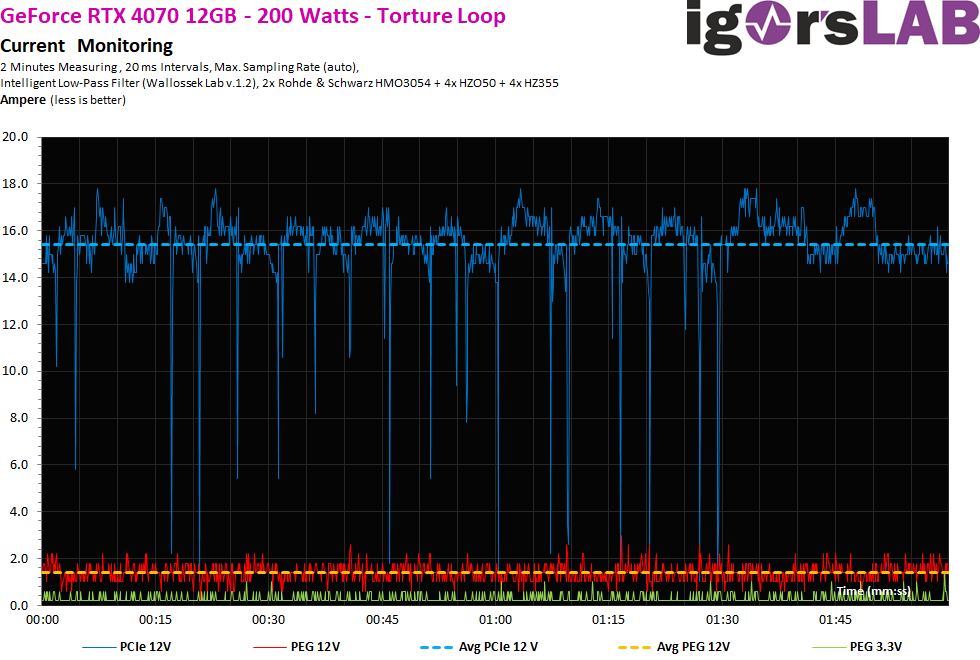

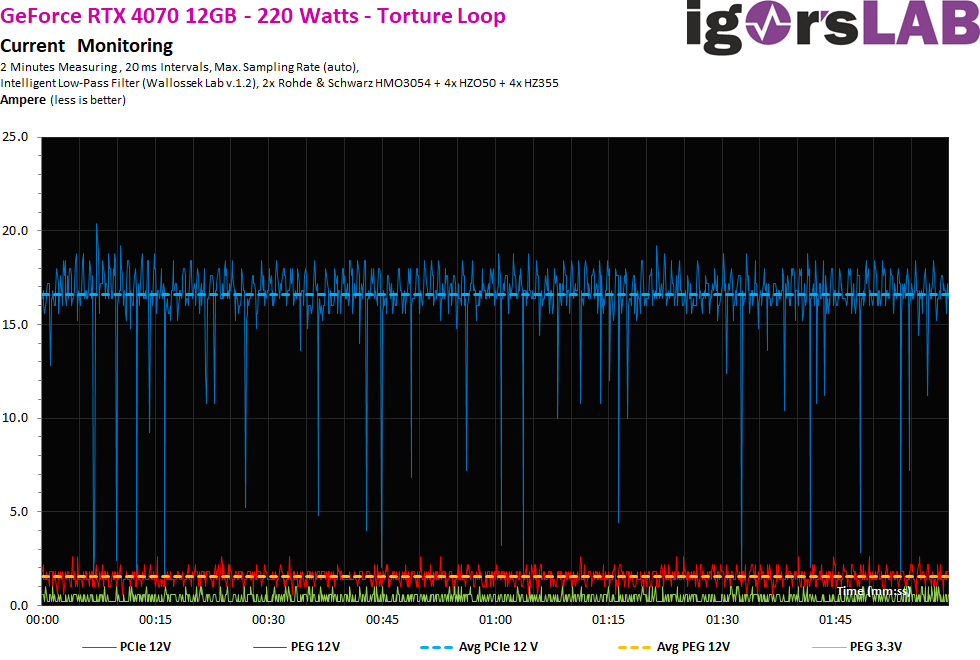

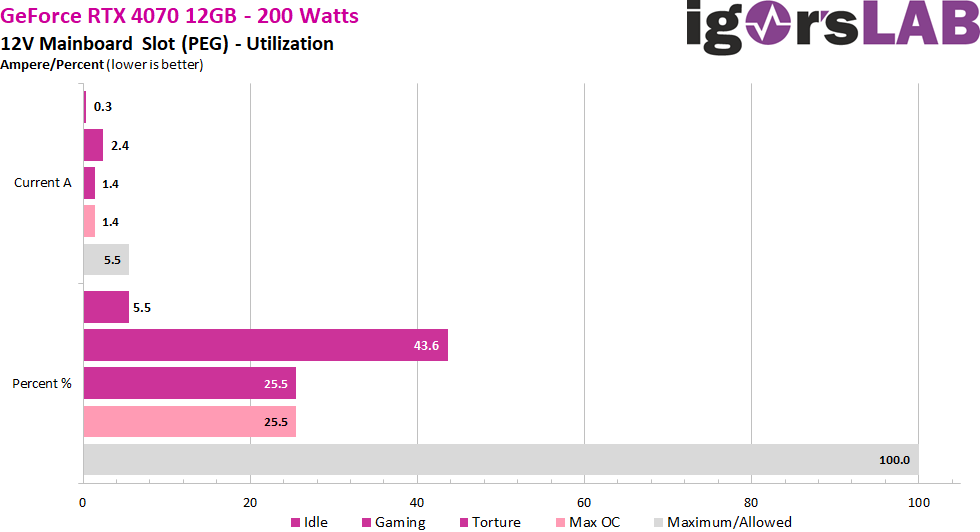

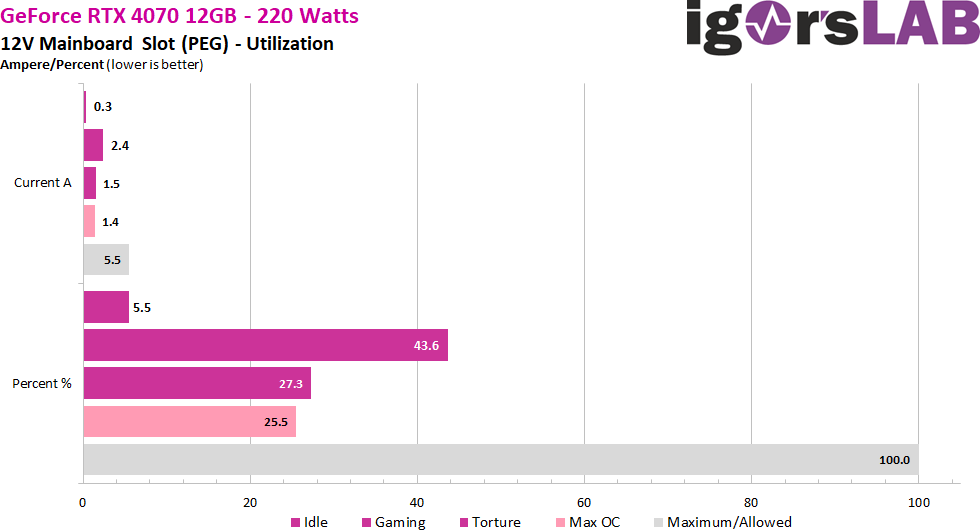

NVIDIA nutzt den PCIe-Steckplatz ein wenig, vor allem für Spiele. Mit maximal 5,5 Ampere bei den fließenden Strömen liegt man aber immer noch unter der Hälfte dessen, was erlaubt ist, selbst bei der erhöhten Leistungsgrenze.

Während NVIDIA die Versorgung über die PEG deutlich reduziert hat, nutzt AMD diese Schiene weiterhin recht exzessiv.

Grobe 20 ms-Intervalle

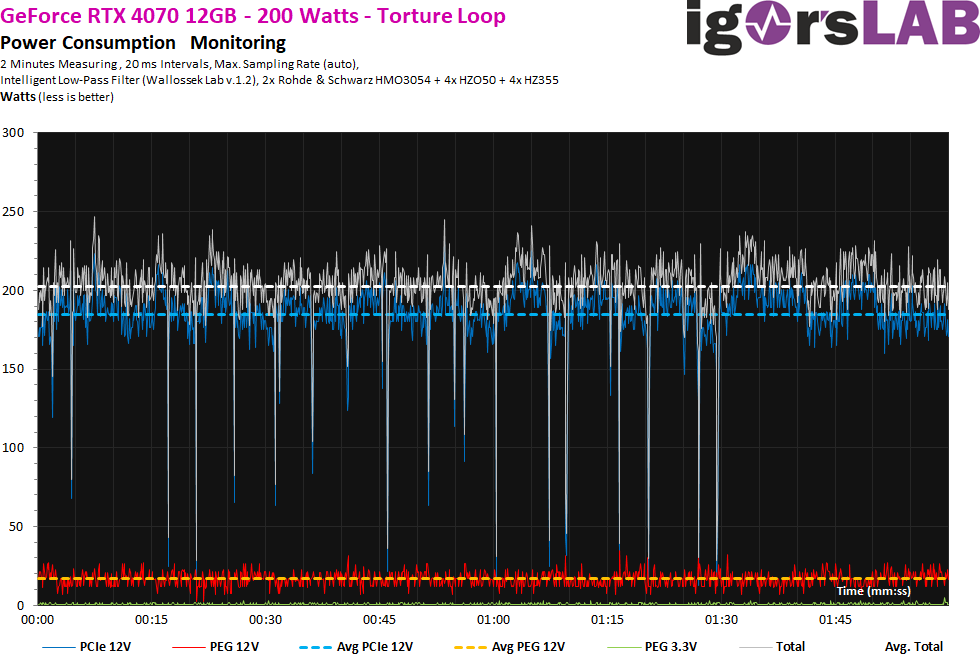

Schauen wir uns zunächst die fließenden Ströme an. Gemessen wurde in gröberen 20-ms-Intervallen, also etwa 50 mal pro Sekunde, um die Belastung des Supervisor-Chips der Netzteile (Shutdown) zu simulieren. Wir sehen, dass selbst kurze Lastspitzen spätestens bei 20 oder 22 A gedeckelt werden. eine echte Begrenzung sieht aber anders aus. Das ist nicht wenig. Wir sehen aber auch einen großen visuellen Unterschied zwischen den beiden Varianten, der die Regelwut von Boost sehr schön demonstriert.

Trotzdem müssen wir noch einen Blick auf die Spannungen bzw. das Produkt aus Spannung und Stromfluss werfen. Ich habe ja schon geschrieben, dass ich hier an verschiedenen Netzteilanschlüssen gemessen habe, auch wenn sich am Ende auf dem Board der Grafikkarte alle Anschlüsse irgendwie wieder treffen. Was wir hier nun als deutlichere Schwankungen und Spitzen sehen, ist auf das teilweise leicht übersteuernde Netzteil und damit die Spannung und nicht die Ströme zurückzuführen. Das ist technisch bedingt, aber keine große Sache. Wir sehen aber auch, dass die wenigen Spitzen bei über 300 Watt nicht auf den fließenden Strom (Grafikkarte) zurückzuführen sind, sondern tatsächlich aus dem Netzteil resultieren! Das liegt auch an der Topologie und vor allem an dem recht mickrigen Eingangsfilter mit nur einer Spule auf der einen Schiene.

Der Torture Test ist kaum anders. Die OC-Variante regelt ein bisschen hektischer.

Wenn man nun die Spannung wieder addiert, sieht man eine stärkere Restwelligkeit, die wiederum aus der etwas zittrigen Betriebsspannung resultiert. Zur Ehrenrettung des Netzteils muss aber gesagt werden, dass dies alle aktuellen Produkte aller Hersteller betrifft und sicherlich kaum vermeidbar ist.

- 1 - Introduction, Specs and Unboxing

- 2 - Test system, equipment and methods

- 3 - Teardown: PCB, components and cooler

- 4 - Gaming Performance Full HD (1920 x 1080)

- 5 - Summe Gaming-Performance WQHD (2560 x 1440)

- 6 - Gaming Performance Ultra HD (3840 x 2160)

- 7 - Gaming Performance DLSS vs. FSR

- 8 - Latency and DLSS 3.0

- 9 - Workstation and rendering

- 10 - Power consumption and PEG loads

- 11 - Transients, cutting and PSU recommendation

- 12 - Clock rate and OC, temperatures and thermal imaging

- 13 - Fan speed and noise level

- 14 - Summary and conclusion

258 Antworten

Kommentar

Lade neue Kommentare

Moderator

1

Urgestein

Neuling

Urgestein

Neuling

1

Veteran

Neuling

Urgestein

Urgestein

Veteran

Mitglied

Mitglied

Veteran

Urgestein

Urgestein

Urgestein

Mitglied

Alle Kommentare lesen unter igor´sLAB Community →