Board analysis and power supply

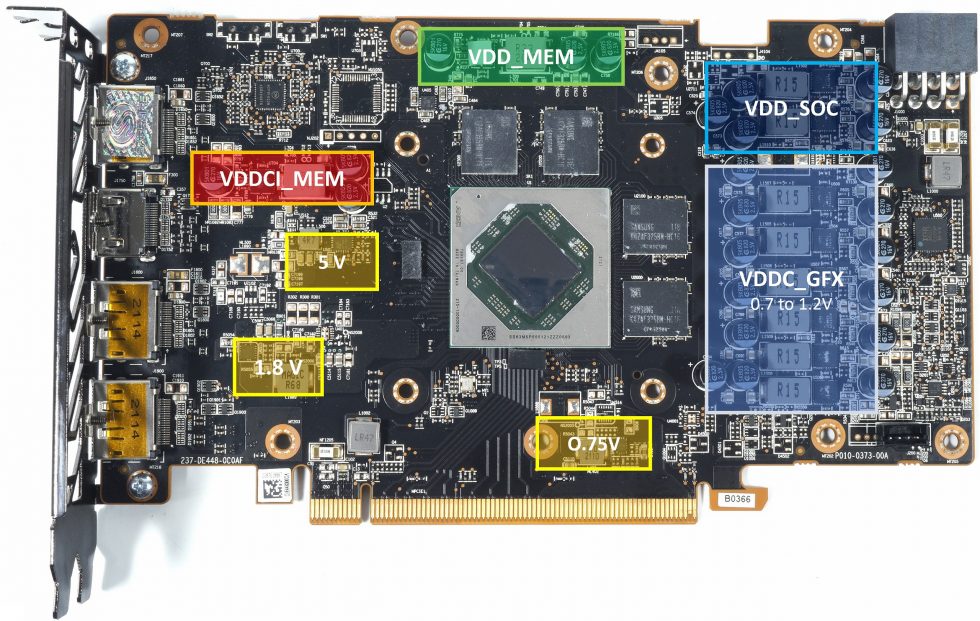

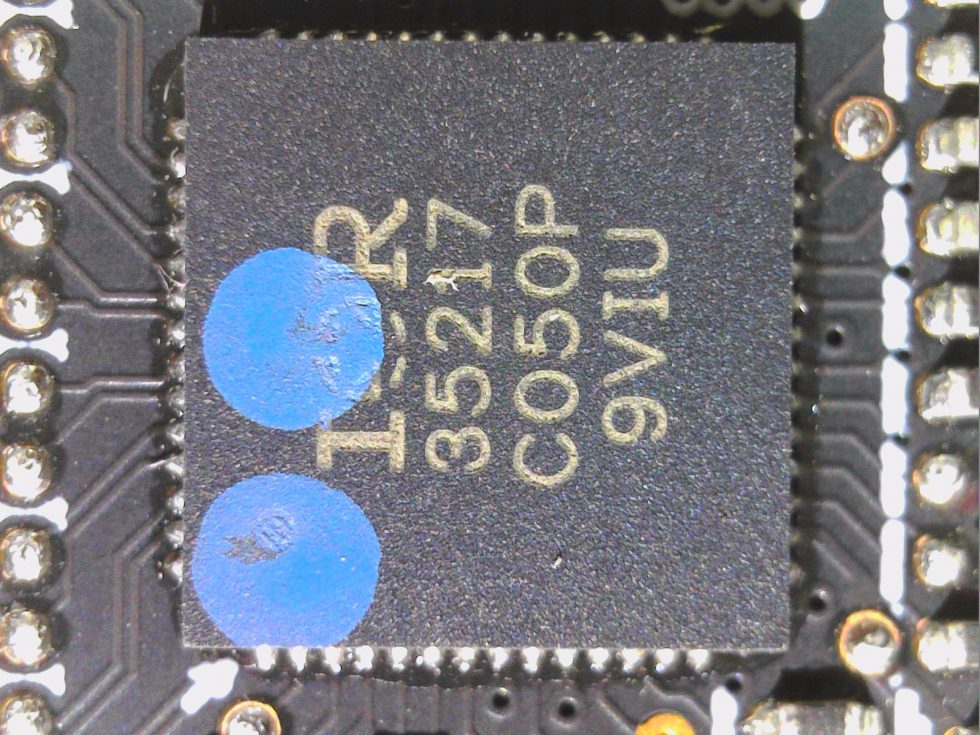

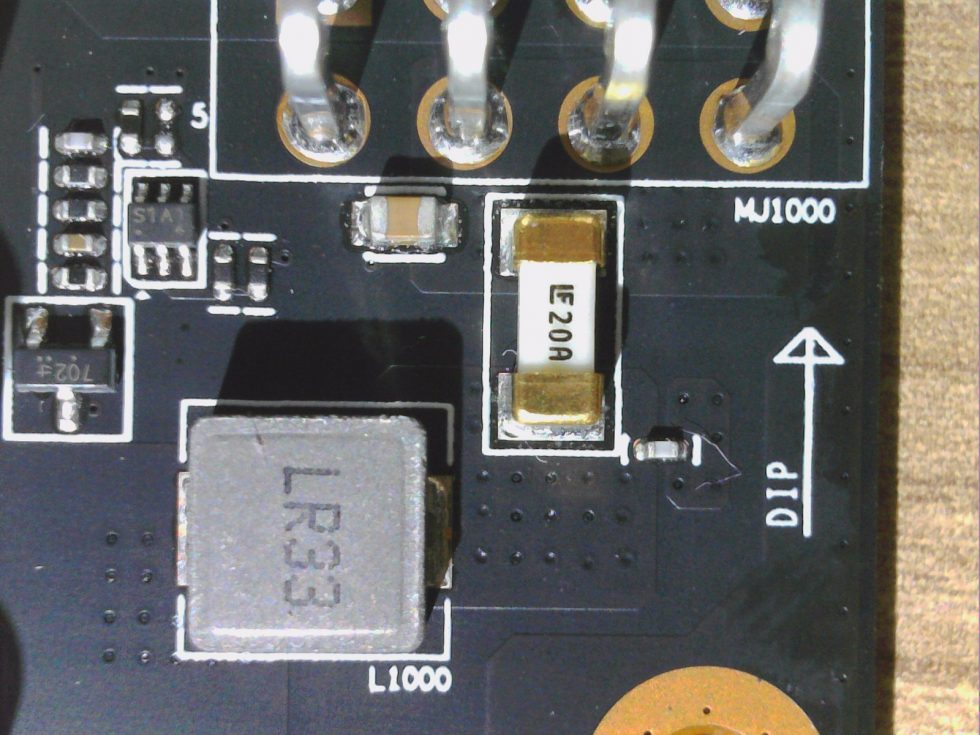

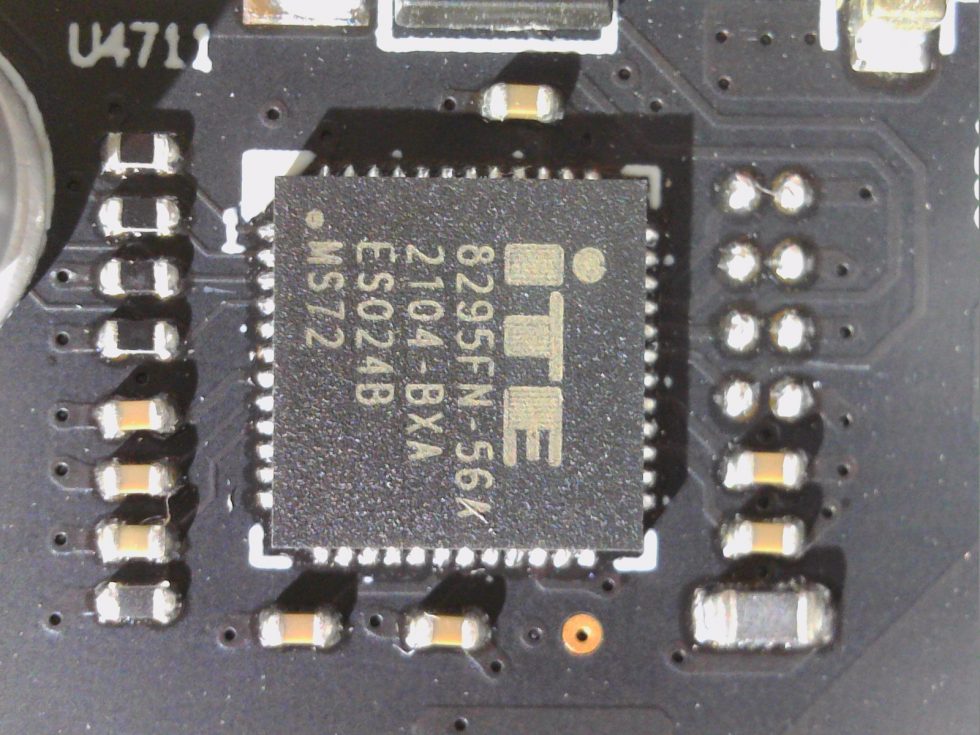

They have saved a bit on the circuit board, which is much simpler than that of the RX 6800 and RX 6700 XT. However, well equalized hotspots are also a plus point this time, even if the very decent input filtering with a real LC filter (low-pass) is omitted and only longitudinal coils (chokes) and fuses are used. With a 35217 from International Rectifier Sapphire uses a rather average PWM controller, which drives the 6 phases for VDDC_GFX of the RX 6600 XT and generates the two phases for VDD_SOC.

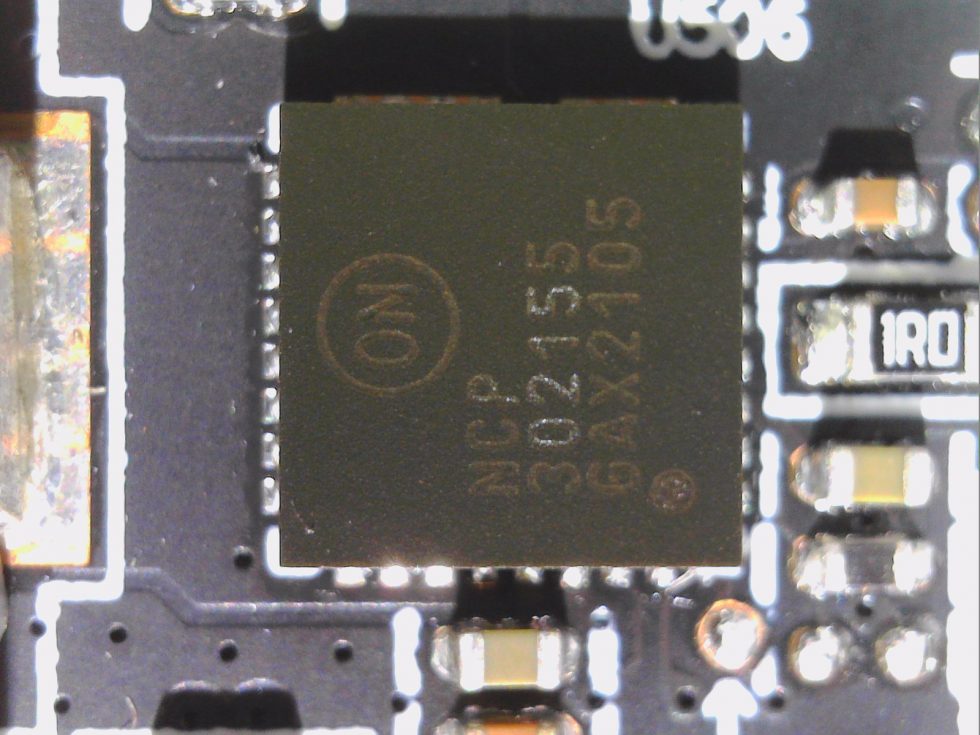

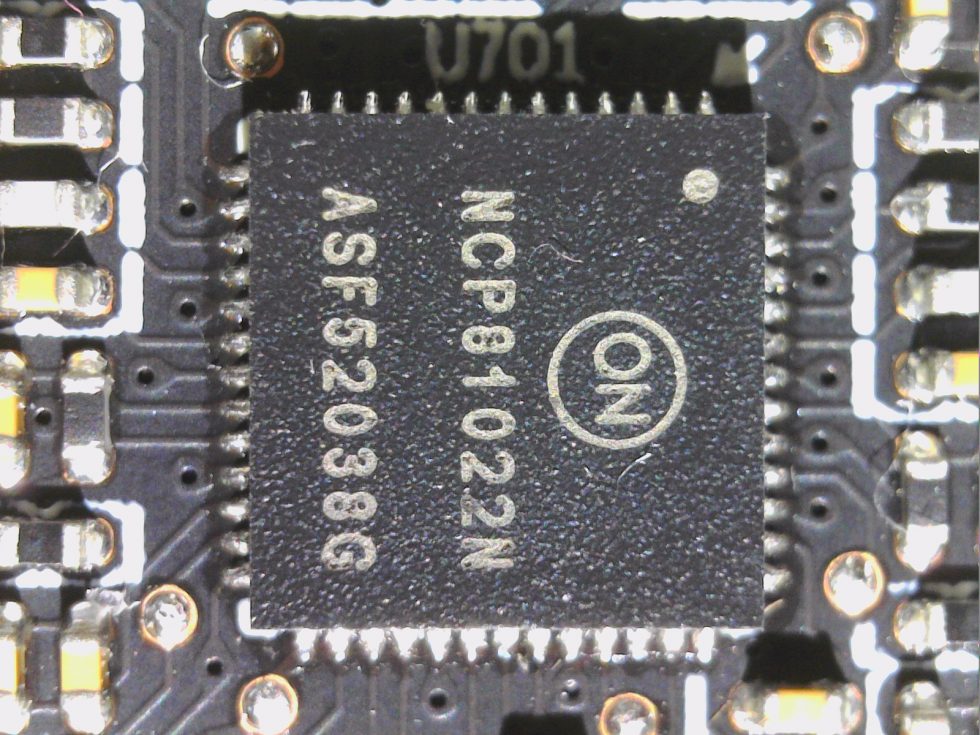

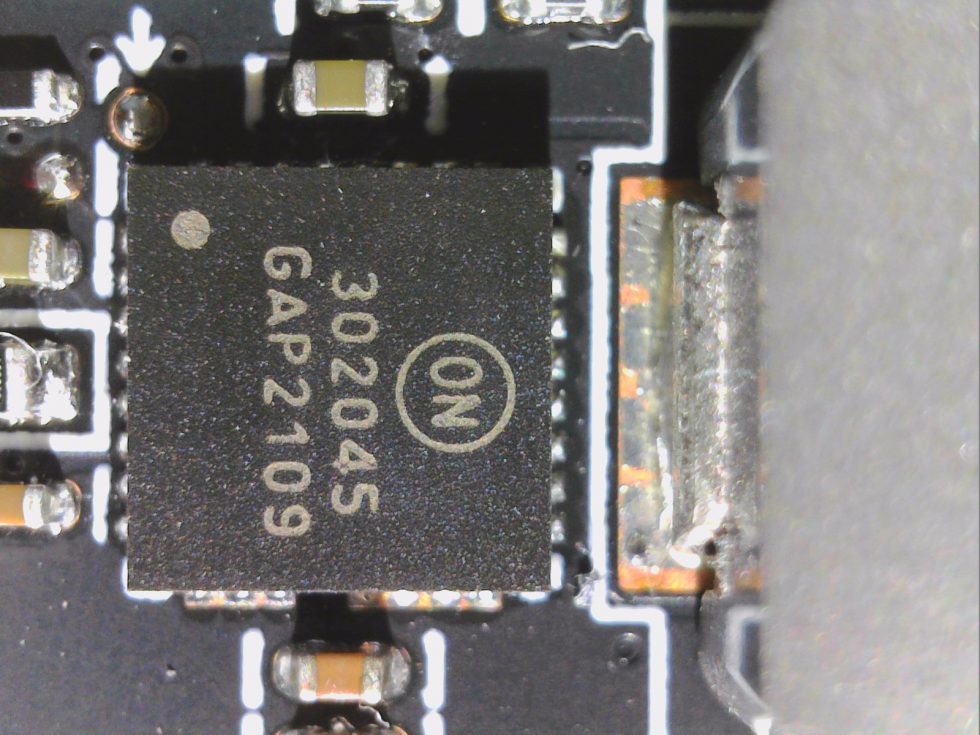

ON Semi’s rather inexpensive DrMOS NCP302155 (55 amps max.) doesn’t offer true MOSFET DCR, but it does at least offer temperature protection circuitry and a readout output. By the way, they are used for all controllers except SoC and VDDCI, where slightly smaller NCP302145 with 45A are used. The voltage range for VDDC_GFX is between 0.7 and maximum 1.2 Volt, whereby the maximum value can never be exceeded by the end user without special firmware and software. This can be left as it is, especially since the DrMOS NCP302155, i.e. the combination of MOSFET driver, high-side and low-side MOSFET in one package, is also quite efficient and cool to work with.

In parallel, an NCP 81022N from On Semi operates for the generation of other partial voltages such as VDD_MEM and a phase for VDDCI_MEM, resulting in a total of 10 phases for the various main voltages, all of which are equipped with the same DrMOS.

For input smoothing one coil each with 470 mH is used for the 8-pin and the PEG motherboard slot. You can also see the four 2GB GDDR6 memory modules with Samsung’s 16Gbps. That’s about as exciting as it gets.

Cooler and disassembly

The front is characterized by the two 8.7 cm fan modules with 8 rotor blades each, which act quite quietly. There are no more special features to observe from above for the time being. Disassembly is easy if you follow a few simple rules and have decent screwdrivers.

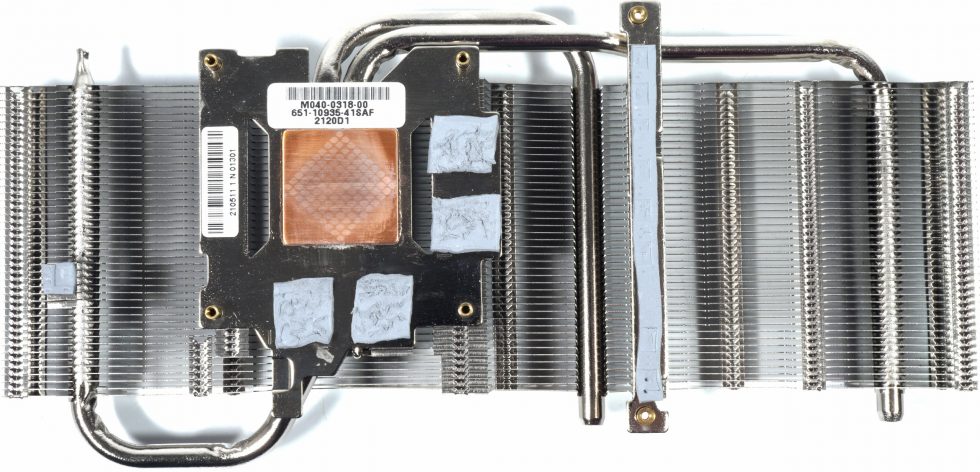

After unscrewing the top cover over the backplate and the GPU screws, the cooler and cover can also be removed quite easily. You just have to disconnect the fan cable. The very soft pads on the memory modules and the VRM do their job, but are not top shelf and stick like hell for it. We see a total of three nickel-plated 6mm heatpipes made of copper composite material attached to the copper heatsink above the GPU. The memory is cooled by the 2 mm thick pads from the rather cheap shelf, the voltage converters at the cooler too.

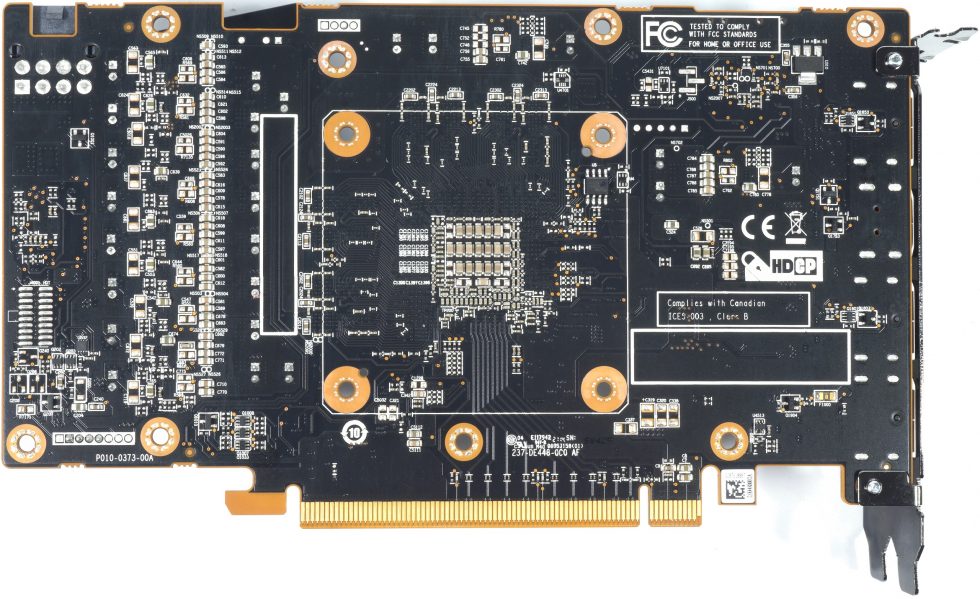

On the back side you find a backplate made of light metal, unfortunately there are no pads behind the memories and the voltage converters for a passive cooling function. Too bad.

81 Antworten

Kommentar

Lade neue Kommentare

Veteran

Urgestein

Veteran

Urgestein

Urgestein

Urgestein

Veteran

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →