NVIDIA GeForce RTX 3070 Ti

Ich zeige euch erstmal die Werte, dann sage ich was dazu. Lasst euch nicht blenden!

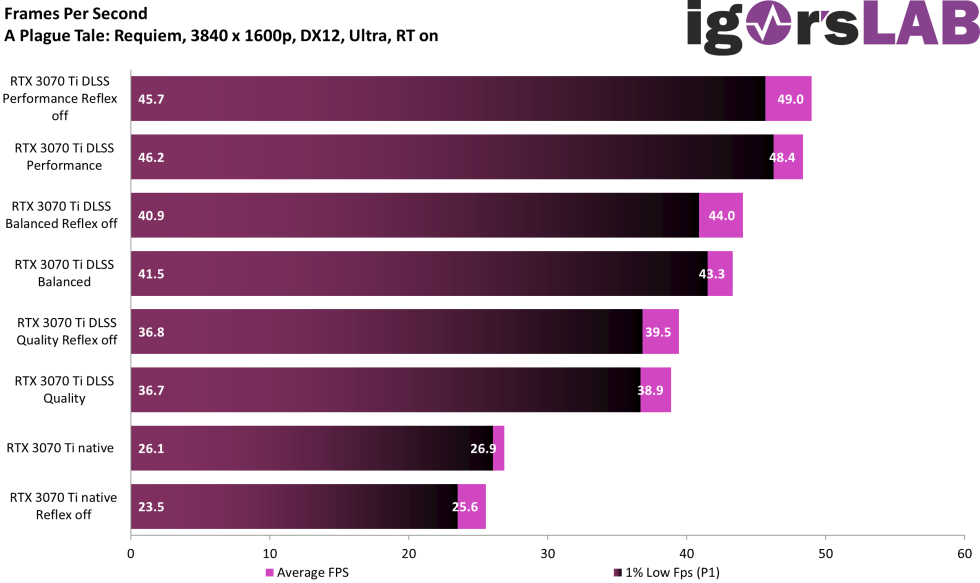

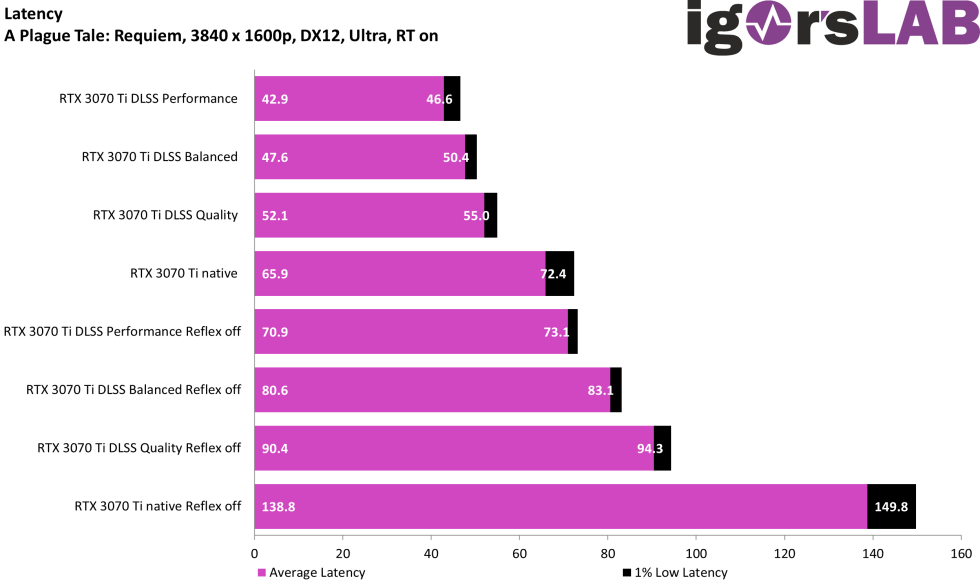

Da geht der Karte die Leistung aus und nicht nur das. Das viel Schlimmere ist, dass die 8 GB volllaufen, und dann geht das Geruckel los. Das wird durch meinen Test leider nicht sichtbar. Dazu muss man „tiefer“ im Spiel sein und dann wird es kriminell. Jeder der jetzt meint: Das liegt an der hohen Auflösung, der FritzHunter hat mal gar keinen Plan, der irrt gewaltig. Das Problem kann schon in 1080p auftreten. Und, wer jetzt der Meinung ist, dass ist nur in diesem Spiel so – auch der irrt. Ein Spiel kommt ja noch, abwarten.

NVIDIA Reflex gibt alles. Der Abstand der RTX 4070 liegt ohne Frame Generation bei max. 10 FPS, wenn man DLSS-Performance vergleicht. Wenn da das Speicherproblem der RTX 3070 Ti nicht wäre, dann müsste man für diese Spiel klar festhalten: So groß fällt der Leistungssprung der RTX 4070 dann doch nicht aus. Die Radeon RX 6700 XT sollte jetzt – dank ihrer 12 GB – alle Trümpfe in der Hand haben. Jetzt wird es spannend…

- 1 - Einführung und Testsystem

- 2 - CoD MW2 RTX 4070

- 3 - CoD MW2 RTX 3070 Ti

- 4 - CoD MW2 RX 6700 XT

- 5 - A Plague Tale Requiem RTX 4070

- 6 - A Plague Tale Requiem RTX 3070 Ti

- 7 - A Plague Tale Requiem RX 6700XT

- 8 - Hogwarts Legacy RTX 4070

- 9 - Hogwarts Legacy RTX 3070 Ti

- 10 - Hogwarts Legacy RX 6700 XT

- 11 - Zusammenfassung und Fazit

61 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Moderator

Urgestein

Moderator

Urgestein

Mitglied

Urgestein

Urgestein

Veteran

1

Moderator

Veteran

Urgestein

1

Veteran

Moderator

Moderator

Urgestein

1

Alle Kommentare lesen unter igor´sLAB Community →