AMD Radeon RX 6700 XT

Meine Erwartungen sind leider gedämpft, denn obwohl die 12 GB Speicher der RX 6700 XT ausreichend sind, ist die reine Rohleistung der Karte – mit aktiviertem Raytracing sehr dünn. Zumindest haben die Spieleentwickler in Hogwarts Legacy FSR 2 integriert, das könnte der AMD-GPU jetzt den Hintern retten. Schauen wir mal…

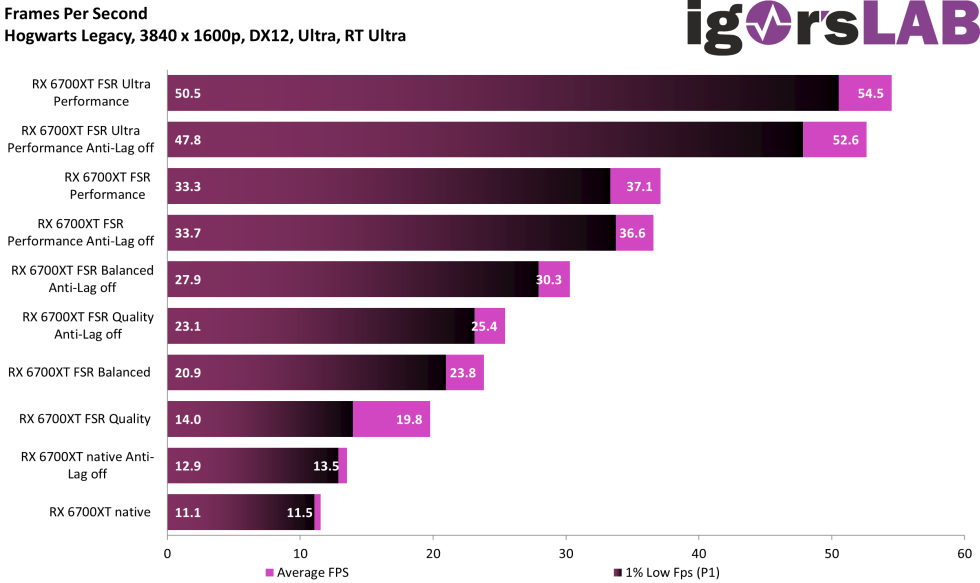

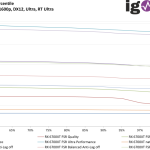

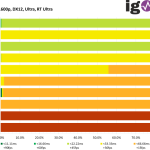

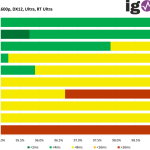

Um der Karte wenigstens annähernd spielbare FPS zu bescheinigen, habe ich dann doch FSR Ultra Performance aktiviert. Somit kommt die RX 6700 XT an die RTX 3070 Ti mit nur DLSS-Performance ran. Komische FPS-Sprünge mit und ohne Anti-Lag zwischen FSR-Qualität und Balanced kann man hier sehen. Was sagen die Latenzen?

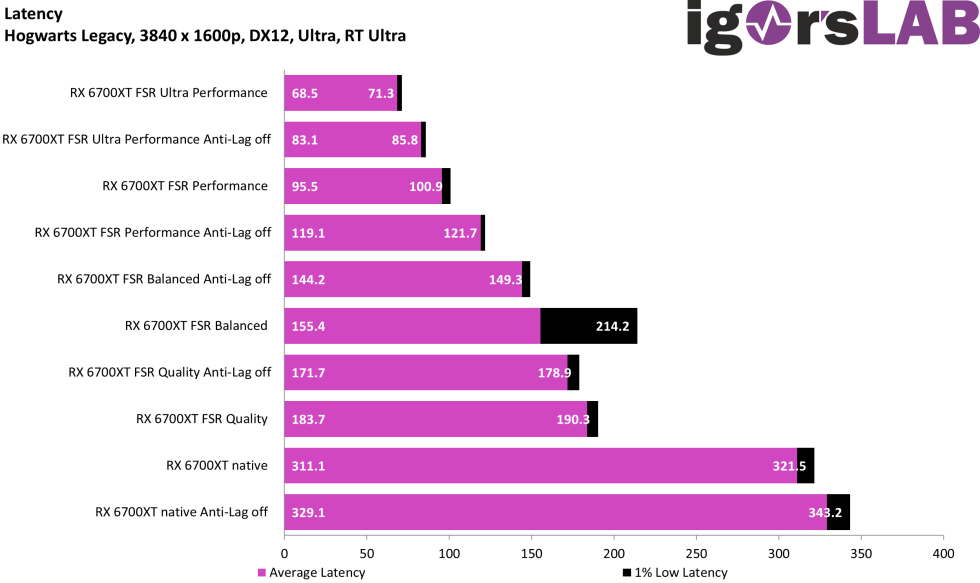

Hmm, immerhin scheint Anti-Lag zu funktionieren. Man kommt aber selbst mit FSR Ultra Performance nur auf das Niveau von DLSS-Qualität. An den FPS kann es nicht liegen, denn die RX 6700 XT mit FSR Ultra Performance kommt auf 54 FPS und die RTX 3070 Ti mit DLSS-Qualität nur auf ruckelige 37 FPS. Das zeigt einmal mehr, dass ein Eingriff von außen (über den Treiber) nicht so gut funktioniert wie Reflex – das bekanntlich im Spiel implementiert ist. Das sollte sich AMD nochmal anschauen.

Als Zwischenbilanz zum Thema RTX 3070 Ti und der RX 6700 XT kann ich nur sagen: Das muss ich mir nochmal anschauen, ab wann die beiden Karten sowohl in Hogwarts Legacy als auch in A Plague Tale Requiem nutzbar sind. Kann man mit den Karten überhaupt 1440p mit Raytracing spielen, ohne Geruckel? Follow up soon…

- 1 - Einführung und Testsystem

- 2 - CoD MW2 RTX 4070

- 3 - CoD MW2 RTX 3070 Ti

- 4 - CoD MW2 RX 6700 XT

- 5 - A Plague Tale Requiem RTX 4070

- 6 - A Plague Tale Requiem RTX 3070 Ti

- 7 - A Plague Tale Requiem RX 6700XT

- 8 - Hogwarts Legacy RTX 4070

- 9 - Hogwarts Legacy RTX 3070 Ti

- 10 - Hogwarts Legacy RX 6700 XT

- 11 - Zusammenfassung und Fazit

61 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Moderator

Urgestein

Moderator

Urgestein

Mitglied

Urgestein

Urgestein

Veteran

1

Moderator

Veteran

Urgestein

1

Veteran

Moderator

Moderator

Urgestein

1

Alle Kommentare lesen unter igor´sLAB Community →