Für die Sapphire Nitro+ Radeon RX 7900 XTX Vapor-X 24 GB öffnet Sapphire den ganz großen Besteckkasten. Im Vergleich zur MBA-Karte (made by AMD) funktioniert die Vapor-Chamber übrigens bestens und macht genau das, was man von ihr erwartet. Auch in den absonderlichsten Lebens- und Einbaulagen. Zusammen mit einem deutlich höheren Power Limit geht auch beim Takt zusätzlich die Post ab. Unter voller Last an der 3-GHz-Marke zu knabbern ist schon irgendwie nice. Gut, ich will mal noch nicht allzu viel spoilern, aber diese Interpretation einer dicken Karte lässt einem dann sogar ab und an die Effizienz vergessen. Denn etwas Brechstange ist natürlich stets mit dabei. Aber sei es drum…

Natürlich gibt es, wie gewohnt und üblich, den umfassenden Teardown, eine aufwändige Platinen- und Kühler-Analyse mit einigem Reverse-Engineering, sowie die Analyse der Leistungsaufnahme und der Lastspitzen samt passender Netzteilempfehlung. Für die weiterführenden Details empfehle ich meinen Launchartikel zur Radeon RX 7900 XTX und RX 7900XT.

Die Sapphire Nitro+ Radeon RX 7900 XTX Vapor-X 24 GB

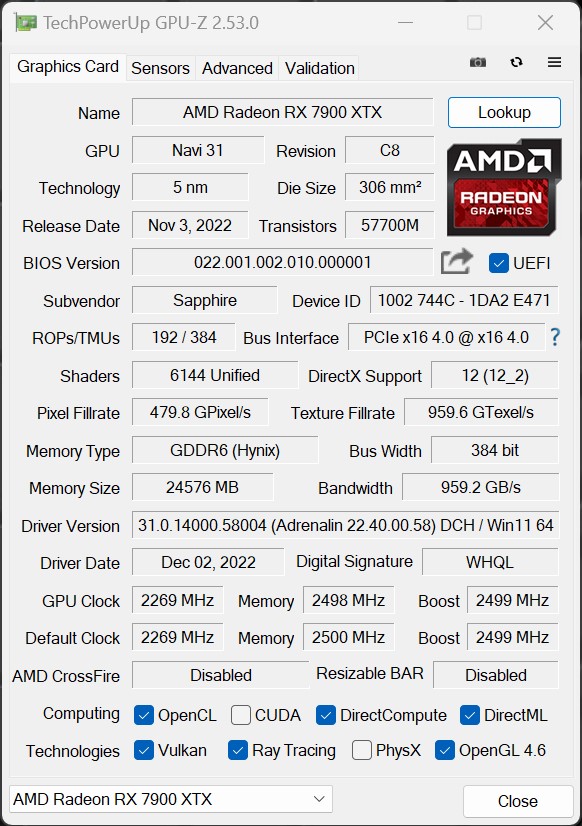

AMDs Navi 31-GPU besitzt 58 Milliarden Transistoren und bietet ohne OC bis zu 61 TFLOPs an Single-Precision-Rechenleistung. Diese GPU verfügt zudem über einen Chiplet Interconnect mit 5,3 TB/s. Mit dem 5-nm-Node von TSMC besitzt Navi 31 GPU eine auf 165% gestiegene Transistordichte im Vergleich zu Navi 2X. Die Radeon RX 7900 XTX bietet 96 CUs mit 2,27 GHz Takt (Boost bis 2,5 GHz) und besitzt eine Board-Power von reichlich 400 Watt (Torture bis rund 450 Watt). Was den Speicher betrifft, so verfügt auch dieses XTX-Modell über 24 GB GDDR6-Speicher, der mit 20 Gbit/s getaktet ist. Diese SKU hat einen 384-Bit-Speicherbus und bietet eine Speicherbandbreite von 959,2 GB/s.

Die neue Nitro-Formsprache ist gut gelungen und Sapphire setzt nun auf einen wirklich dicken, zweischaligen Rahmen der wiederum den eigentliche Lamellenkühlkörper samt Vapor-Chamber trägt. Dazu gleich mehr im Teardown, denn das ist für Sapphire neu. Man verzichtet auf die sonst üblichen Einbaurahmen für die RAM- und VRM-Kühlung (Sandwich) und bringt jetzt alles wie aus einem Guss. Und es sieht eben nicht nur aus wie Metall, sondern es ist welches und fühlt sich deshalb auch richtig wertig an. Die Karte ist 31.5 cm lang und 13.5 cm hoch. Die Dicke ist nicht von schlechten Eltern und es ist am Ende dann ein fast 2 Kilo schweres 3,5-Slot-Design.

Auf der Oberseite sehen wir primär die drei 8-Pin Buchsen für die externe Stromversorgung. Über die Biegeradien bei den Stromversorgungsanschlüssen müssen wir AMD natürlich nicht diskutieren, das ist alles noch so richtig schön oldschool, auch wenn drei massive Kabel schon ordentlich fett auftragen. Der Radeon-Schriftzug steckt in einer großflächigen LED-Leuchtfläche, die das ARGB-Feuerwerk oben und unten so richtig anheizt. Es hat fast schon den Charme einer richtigen Leselampe und bekam von Sapphire den klangvollen Namen “Pantheon+”. Nun kann man natürlich streiten, warum gerade Pantheon, aber es könnte sich auf den in Rom befindlichen Tempel für alle römischen Götter beziehen, der über eine architektonisch wegweisende Kuppel verfügt oder aber die Mythologie und die Gesamtheit der Götter und Göttinnen, die in einem bestimmten religiösen oder kulturellen Glaubenssystem verehrt werden. Sucht euch einfach was aus oder lasst die Lampen aus. Je nach Gusto.

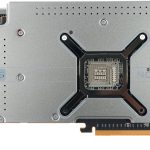

Dreht man die 1940 Gramm schwere Karte jetzt ebenfalls mal nach hinten, dann sieht man eine massive Backplate mit dem obligatorischen Leuchtschnickschnack. Das Sapphire Logo ist genauso am Start wie ein ARGB-Header zur externen Einbindung. Außerdem integriert Sapphire wieder Software-BIOS-Umschaltfunktion (rechts oben). Der BIOS-Schalter hat drei Positionen (von der Slotblende zum Kartenende gesehen): Standard-BIOS, zweites BIOS (Mitte) und Software-gesteuert. Mit Sapphires TRIXX-Software kann man dann die BIOS-Auswahl umschalten, ohne das Gehäuse öffnen oder unter den Schreibtisch kriechen zu müssen.

Sapphire gibt diesem zweiten BIOS keine eigene Bezeichnung, aber eigentlich braucht man es auch gar nicht. Es lässt die Karte mit etwas niedrigeren Taktraten laufen und die geringeren Taktraten führen dann zu einer kleinen Abnahme von Temperaturen, Lüftergeschwindigkeit und Geräuschpegel. Aber das ist eher marginal und zumindest kein “echtes” Silent-BIOS. Just another option, oder so.

Mit den beiden bekannten DisplayPort 2.1 Anschlüssen, sowie zwei HDMI 2.1 Buchsen beenden wir die Nabelschau. Der USB Typ C Anschluss entfällt allerdings und auch auf der Platine fehlt die passende Spannungsversorgung.

Übersicht der RDNA3-Karten – Technische Daten

Die RDNA3-Karten unterscheiden sich durchaus und das nicht nur äußerlich. Die Karte von Sapphire übertrumpft jedoch die Referenz auch bei Takt und Power und ist von daher eine richtige Spaßkarte. Aufgeblasene OC-Kandidaten sind in der Summe natürlich stets etwas schneller, aber eben auch deutlich durstiger. Wir werden später noch sehen, dass dies auch hier der Fall sein wird, denn die gute alte Physik kann auch Sapphire nicht neu erfinden. Aber damit muss man eben leben. Ich komme noch darauf zurück.

Noch einmal der tabellarische Vergleich:

| RX 7900 XTX | RX 7900 XT | |

| Compute units | 96 | 84 |

| AI accelerators | 192 | 168 |

| Ray tracing accelerators | 96 | 84 |

| Memory | 24 GB GDDR6 | 20 GB GDDR6 |

| Memory speed | 20 Gbps | 20 Gbps |

| Memory bus size | 384-bit | 320-bit |

| Game clock speed | 2.3 GHz | 2 GHz |

| Output | DisplayPort 2.1 | DisplayPort 2.1 |

| TBP | 355 W | 315 W |

| MSRP | 1000 USD | 900 USD |

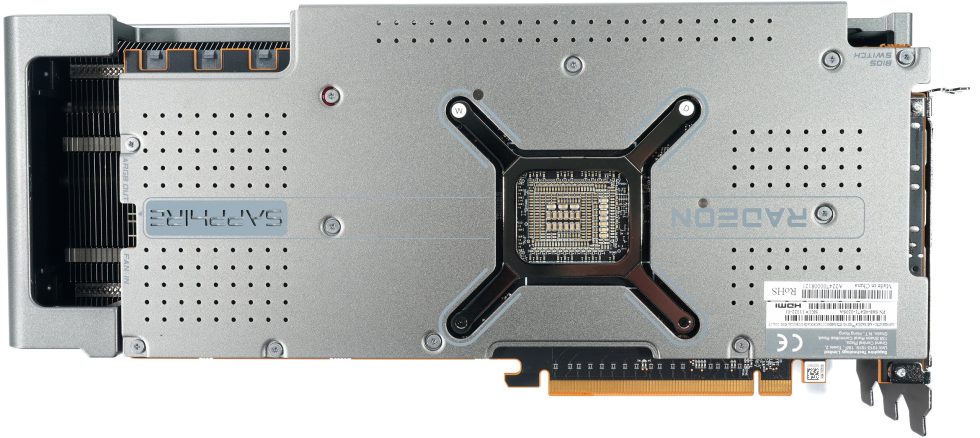

Test-Setup

Auf vielfachen Wunsch hin setze ich wiederum auf ein geschlossenes System, das in Form eines für igor’sLAB speziell von MIFCOM zusammengestellten PCs (exemplarischer Produktlink, kein Affiliate) eine wirklich praxisbezogene Basis bietet. Das verwendete Gehäuse ist richtig gut, besitzt genügend Innenvolumen und dazu auch noch einen vorzüglichen Airflow. Die verwendete AiO-Kompaktwasserkühlung in Form der Silen Loop II von Be Quiet passt optisch zum Gesamtkonzept und die RGB-Akzente von RAM und Motherboard lassen sich im Zweifelsfall entweder auf schlichtes Weiß setzen oder gleich ganz ausschalten. Wenn es einem mal wieder zu bunt werden sollte.

Der PC wurde von MIFCOM schön ordentlich zusammengebaut (ich habe es ja immer so mit den Kabeln) und kann in dieser Konfiguration (siehe weiter unten) genauso oder auch modifiziert beim Händler erworben werden. Mir war es hier einfach wichtig, eine marktübliche Lösung zu nutzen und nicht meine extrem gechillte Labor-Hardware in der Klima-Oase. Zwischen Seitenwand (Glas) und Grafikkarte bleibt genügend Platz und der Stauraum des XL-Gehäuses wurde nicht einmal annähernd genutzt. Somit haben sogar auch alle anderen RTX 4080 (und RTX 4090) mit dem unsäglichen Adapter noch genügend Platz zum Atmen. Das sollte also passen, denn die Radeon-Karten haben kein Problem mit ausufernden Biege-Radien. In der Front brauche ich zudem nur zwei Lüfter.

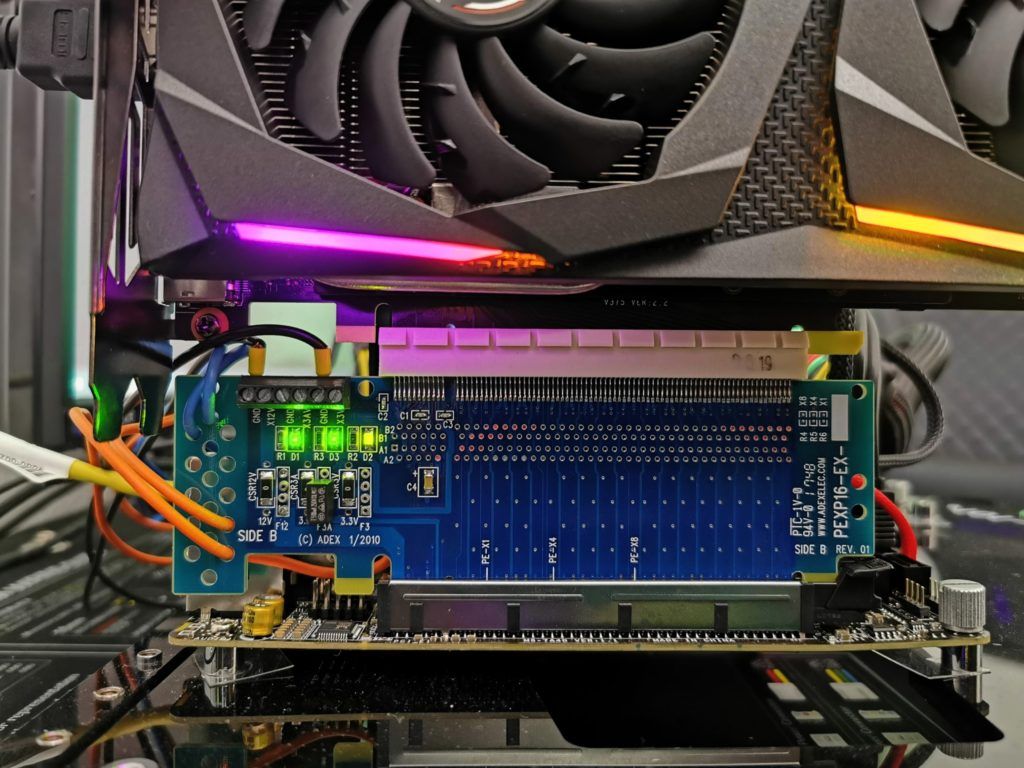

Die Messung der detaillierten Leistungsaufnahme und anderer, tiefergehender Dinge erfolgt jedoch im Labor zweigleisig mittels hochauflösender Oszillographen-Technik (es kommen ja auch noch diverse Follow-Ups!) und dem selbst erschaffenen, MCU-basierten Messaufbau für Motherboards und Grafikkarten (Bilder unten) bzw. NVIDIAs PCAT. Dafür nutze ich natürlich ein redundantes System, mit den gleichen Komponenten, weil solche Messungen im Gehäuse eher schwierig sind.

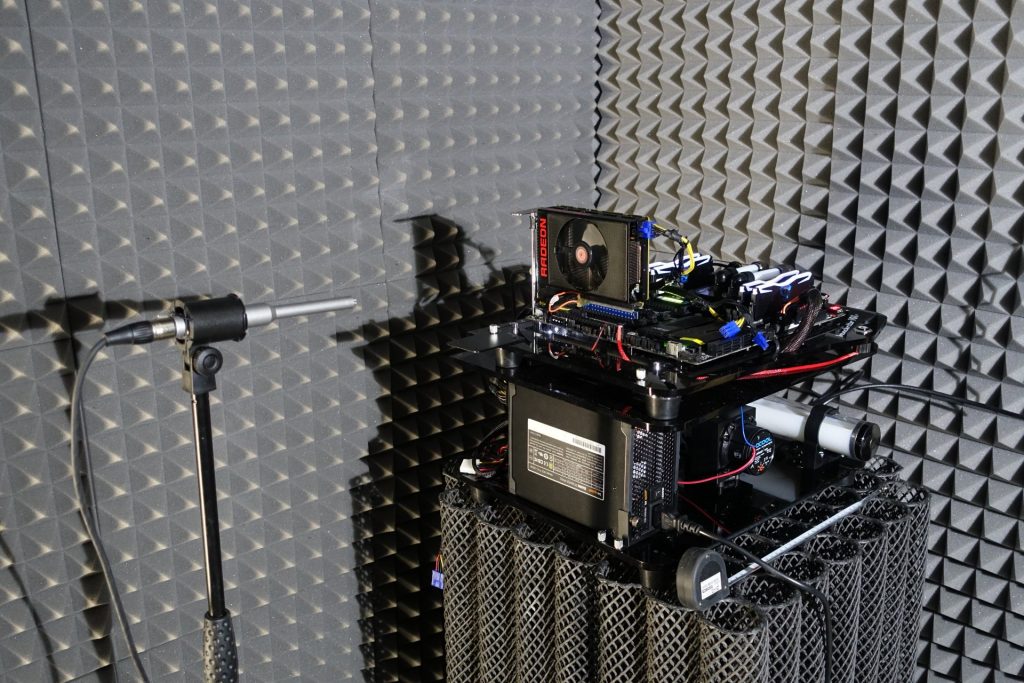

Die Audio-Messungen erfolgen außerhalb in meiner Chamber (Raum im Raum).

Die einzelnen Komponenten des Testsystems habe ich auch noch einmal tabellarisch zusammengefasst:

Sapphire Nitro+ Radeon RX 7900 XTX Vapor-X, 24GB GDDR6, 2x HDMI, 2x DP, full retail (11322-01-40G)

| Lagernd, Lieferung 1-2 WerktageStand: 27.07.24 03:48 | 1093,65 €*Stand: 27.07.24 03:55 |

| siehe Shop | 1093,66 €*Stand: 27.07.24 03:26 |

| Onlineshop: sofort ab Lager, Lieferung 2-3 WerktageDortmund, Düsseldorf, Hamburg, Hannover/Laatzen, München: lagernd (keine Online-Reservierung möglich)Berlin, Stuttgart: nicht lagerndStand: 27.07.24 03:43 | 1093,66 €*Stand: 27.07.24 03:44 |

- 1 - Einführung, technische Daten und Technologie

- 2 - Teardown: PCB und Komponenten

- 3 - Teardown: Kühler und De-Montage-Tips

- 4 - Gaming Performance Full-HD (1920 x 1080)

- 5 - Gaming Performance WQHD (2560 x 1440)

- 6 - Summe Gaming-Performance Ultra-HD (3840 x 2160)

- 7 - Details: Leistungsaufnahme und Lastverteilung

- 8 - Lastspitzen, Kappung und Netzteilempfehlung

- 9 - Temperaturen, Taktraten und Infrarot-Analyse

- 10 - Lüfterkurven und Lautstärke

- 11 - Zusammenfassung und Fazit

200 Antworten

Kommentar

Lade neue Kommentare

Mitglied

Veteran

Urgestein

Mitglied

Veteran

Urgestein

Urgestein

1

Veteran

Urgestein

1

Urgestein

Veteran

Urgestein

Urgestein

Urgestein

Mitglied

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →