Gestern hab es das Review der MSRP-Karten und heute dürfen wir Normalsterblichen dann endlich auch die etwas besseren Karten testen. Dass da noch viel Luft nach oben war, ohne dass sich das Testobjekt zum Krüppel saufen musste, zeigt einmal mehr, dass die knapp auf Kante genähten “Einsteigermodelle” einmal mehr mit Argwohn zu betrachten sind. Nicht, dass es dafür keine Zielgruppe gäbe, aber mit diesen Modellen den Ersteindruck zu erzeugen, ist psychologisch kompletter Nonsens. Wobei sich das mit dem Ersteindruck ja durch willige Video-Handlanger etwas relativiert.

Die heute getestete MSI Gaming X 8G ist eigentlich genau dort, wo ich eine Launchkarte gern gesehen hätte. Und weil sich die kleine Ada so willig und hingebungsvoll treten lassen wollte, habe ich alle Benchmarks gleich komplett im 3-GHz-Setup gemacht. Die Mehrleistung an der Steckdose hielt sich dabei arg in Grenzen und der Chip lief trotzdem satte 250 MHz schneller als der gestern getestete. Offensichtlich gabs auch hier wieder ein gnadenloses Binning in Reinkultur. Die MSI RTX 4060 Ventus 8G ist hier das komplette Kontrastprogramm und in Bezug auf Geräuschentwicklung und Hitzewallungen sogar etwas schlechter als die Palit von gestern. Ich schrieb es ja heute früh schon in meinem Editorial:

Heute gibt es also die überdrehte Schraube mit dem Rechtsgewinde und ich habe, auch wegen der bewussten Aufmerksamkeitsspanne, die Inhalte etwas gestrafft. Das wird dem Ganzen sicher gut tun. Natürlich gibt es wie gewohnt auch die Benchmarks, den umfassenden Teardown (sehr wichtig!), eine sehr aufwändige Platinen- und Kühler-Analyse mit einigem Reverse-Engineering, sowie die Analyse der Leistungsaufnahme und der Lastspitzen samt passender Netzteilempfehlung (genauso interessant). Den Rest hatten wir ja gestern schon.

Wichtiges Vorwort zur Leistungsaufnahme

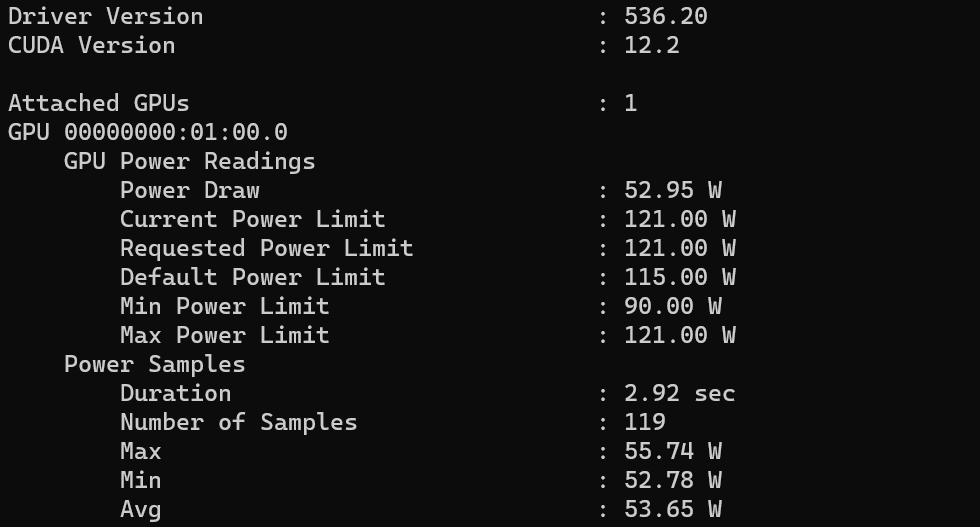

Dass NVIDIA die Telemetrie zum Teil komplett verhunzt hat, das haben wir bereits gestern gelesen und ich werde das heute aus gutem Grund auch noch einmal thematisieren. Vorab möchte ich aber noch einen Teil richtig stellen, den ich gestern Nachmittag noch einmal nachgetestet habe. Hier geht es im die Leistungsaufnahme im Idle. Nach weiteren Treiber-Deinstallationen und Neuinstallationen ist die getestete Karte dann irgendwann doch noch heruntergetaktet. Das wiederum senkte die Leistungsaufnahme auf rund 14 Watt, mit Spitzen bis über 30 Watt. Auch das ist in Anbetracht so einer winzigen Karte noch zuviel, aber schon deutlich besser. Allerdings verharrte die Telemetrie dann immer noch bei über 52 Watt, was einmal mehr beweist, dass sich NVIDIA hier durch das Weglassen der bisherigen Stromüberwachung ein gediegenes Eigentor geschossen hat. Ohne externe Messung kann man alle Ausgabewerte, egal welcher Software, einfach nicht ernst nehmen. Das sind energetische Lyrics, nicht mehr.

Ein Test mit Übertaktung: OC-Karte wörtlich genommen

Kommen wir nun zur Übertaktung beim heutigen Test. ich habe, wie man im Bild oben sehen kann, das Power Limit auf das Maximum von 121 Watt gestellt. Parallel dazu habe ich den Offset um 150 MHz angehoben. Den Speicher habe ich bewusst nicht übertaktet, da ich den Unterschied rein für den GPU-Takt testen wollte. Es macht am Ende auch keine großen Unterschiede mehr. Das zum besseren Verständnis des heutigen Artikels vorab. Und für diejenigen, die gestern noch nichts gelesen haben oder vergleichend mitlesen wollen, hier noch einmal zwei Links zum Thema RTX 4060 8G:

Die MSI GeForce RTX 4060 Gaming X 8G im Detail

Die Karte wiegt nur noch 584 Gramm und ist damit sogar leichter als die gestern getestete Palit-Karte mit 649 Gramm, ein richtiges Eintags-Fliegengewicht. Die Länge von 24,5 cm ist moderat und die Höhe von 12 cm liegt etwas über dem Normalmaß. Positiv ist, dass die Karte mit einem einzigen, weiter nach unten versetzten 6+2-Pin auskommt. Die Einbautiefe beträgt 3,8 cm zuzüglich der 5 mm für den Backplate-Ansatz auf der Rückseite.

Damit ist sie eine echte Dual-Slot-Karte. Die dunkle Kunststoffabdeckung folgt MSIs Gaming-X-Formensprache auch die Lüfter und Slotblende sind nicht neu. Nur dass alles nicht ganz so billig aussieht wie bei der günstigeren Ventus. Auch MSI nutzt ein Single-BIOS und wer übertakten möchte, muss ein passendes Tool verwenden. Die Haptik ist zumindest ok, denn die Backplate ist aus Leichtmetall und RGB gibt es auch.

Man kann ja aber nicht nur Strom in die Karte stecken, sondern auch Videoanschlüsse. Es sind derer vier, um ganz genau zu sein, als da wären: dreimal DisplayPort 1.4a und einmal HDMI 2.1a. Das ist vor allem beim DisplayPort schade, wenn es um die neuen Spezifikationen geht. Chance vertan, leider. Und beim HDMI muss man ab 4K schon mit der Kompression tricksen, wenn es über 120 Hz gehen soll.

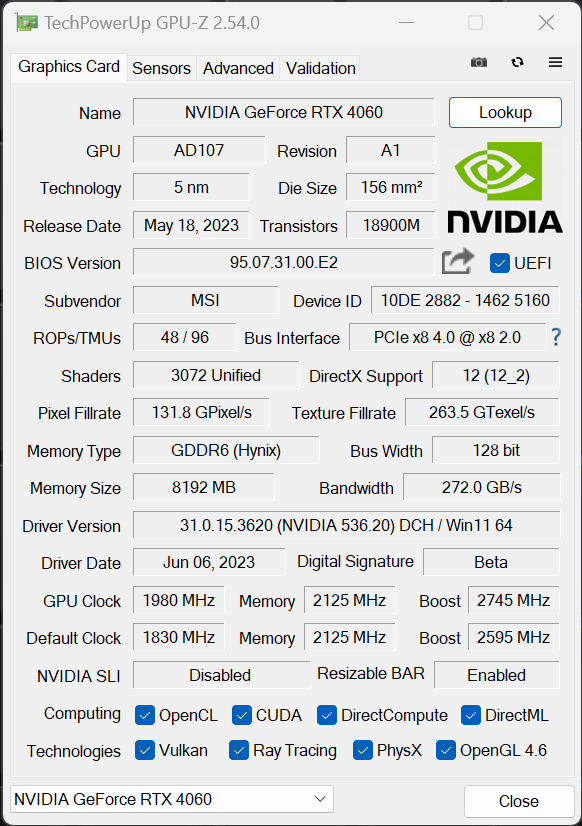

Der Screenshot aus GPU-Z zeigt uns Standardvorgaben der RTX 4060, die bei allen OC-Karten ähnlich ausfallen, denn es gibt etwas Boost-Takt mehr. Und wer ganz genau hinschaut, der sieht auch meine 150 MHz Offset, die ich der übertakteten Karte gegönnt habe und die Folgen für den Boost. Der liegt übrigens in der Realität noch viel höher…

| RTX 4060 Ti | RTX 4060 | RTX 3060 Ti | RTX 3060 | |

| Architecture | Ada Lovelace | Ada Lovelace | Ampere | Ampere |

| Process node | TSMC N4 | TSMC N4 | Samsung 8 nm | Samsung 8 nm |

| CUDA cores | 4352 | 3072 | 4864 | 3584 |

| Ray tracing cores | 32 cores (3rd-gen) | 24 (3rd-gen) | 38 cores (2nd-gen) | 28 cores (2nd-gen) |

| Tensor cores | 128 cores (4th-gen) | 96 (4th-gen) | 152 cores (3rd-gen) | 112 cores (3rd-gen) |

| Base clock speed | 2.31 GHz | 1.83 GHz | 1.41 GHz | 1.32 GHz |

| Boost clock speed | 2.54 GHz | 2.46 GHz | 1.76 GHz | 1.78 GHz |

| VRAM | 8 / 16 GB GDDR6 | 8 GB GDDR6 | 8 GB GDDR6/6X | 8 / 12 GB GDDR6 |

| L2 cache | 32 MB | 28 MB | 4 MB | 3 MB |

| Bus width | 128-bit | 128-bit | 256-bit | 192-bit |

| Total Graphics Power (TGP) | 160 W/165 W | 115 W | 200 W | 170 W |

Damit wäre diese erste Seite geschafft und wir bereiten uns schon einmal langsam aufs Testgeschehen vor.

- 1 - Einführung, technische Daten und Technologie

- 2 - Test System im igor'sLAB MIFCOM-PC

- 3 - Teardown: PCB und Komponenten

- 4 - Gaming Performance FHD (1920 x 1080)

- 5 - Gaming-Performance WQHD (2560 x 1440)

- 6 - Gaming Performance DLSS vs. DLSS3 vs. FSR

- 7 - Lastspitzen, Kappung und Netzteilempfehlung

- 8 - Temperaturen, Taktraten, Lüfter und Geräuschentwicklung

- 9 - Zusammenfassung und Fazit

20 Antworten

Kommentar

Lade neue Kommentare

Urgestein

1

Urgestein

Veteran

Mitglied

Urgestein

Veteran

Veteran

Veteran

Urgestein

Urgestein

Veteran

Mitglied

1

Mitglied

Moderator

Neuling

Neuling

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →