Die dritte Einstiegskarte mit dem neuen GA106-150 in meiner Testreihe ist heute Gigabytes GeForce RTX 3050 Gaming OC 8GB, denn man kann ja nicht immer nur die dicken Brummer testen und die Zielgruppe derer, die Ihre Nieren lieber behalten wollen, möchte ja auch bedient werden. Und was ist mir an der Gaming OC als Erstes aufgefallen? Naja, Ihr kennt das ja, dass der jugendliche Mopedfahrer von Welt oft meint, je lauter das Teil töppert, umso schneller fährt es dann auch. Und leider implizieren immer noch viele Asiaten mit drei Lüftern samt Betriebsgeräusch eine führende Performance. Ob dem so ist, oder ob Igor doch lieber Polizei spielt und das Teil dann wieder normgerecht für den europäischen Pixelverkehr einbremst, das wird der heutige Artikel zeigen. Spoiler statt Auspuff? Ja.

Doch kommen wir zunächst zu den allgemeinen Dingen. Die 8 GB Speicher sind auch für diese Karte ausreichend und so ermöglicht es der Speicherausbau auch, dass die Karte in WQHD mit einer ausgewogenen und wohlüberlegten Mixtur aus mittleren Einstellungen bei Bild- und DLSS-Qualität durchaus noch passabel performt. Das setzt natürlich eine gewisse optische Kompromissbereitschaft voraus, so ehrlich muss man natürlich auch bleiben. Preislich liegt sie aktuell mit 479 Euro übrigens auf auf dem Level der RTX 3050 Gaming X von MSI, die in der technischen Umsetzung wirklich zu überzeugen wusste. Die Messlatte liegt somit wirklich hoch!

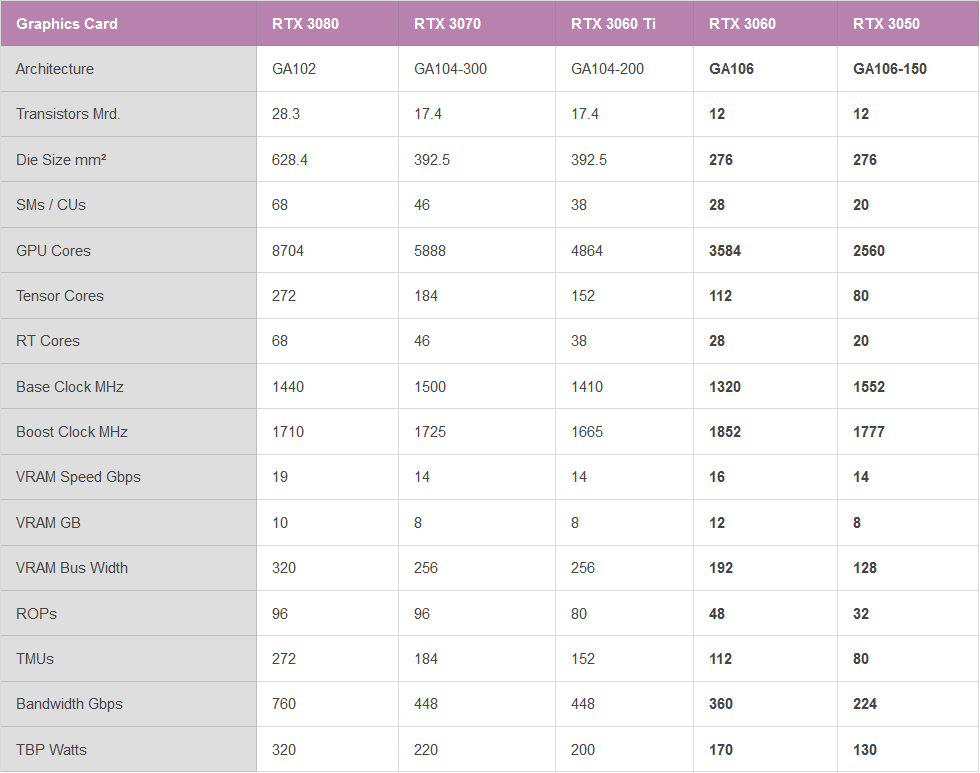

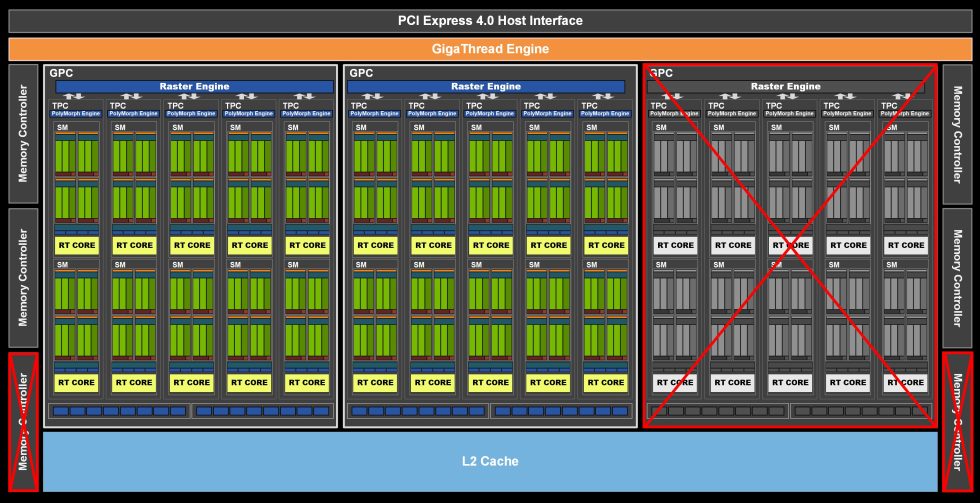

Der beschnittene GA106-150 auf der GeForce RTX 3050

Der Chip der NVIDIA GeForce RTX 3050 basiert ebenfalls auf dem GA106 und wurde noch ein wenig mehr eingekürzt. Für die GeForce RTX 3050 nutzt NVIDIA insgesamt 20 SM (28 bei der RTX 3060) der maximal 30 Einheiten des GA106 (siehe Schema unten), was zu insgesamt 2560 (3584 bei der RTX 3060) CUDA-Kernen führt, wenn alle Einheiten mit FP32 werkeln dürfen. Zusätzlich zu den CUDA-Kernen ist NVIDIAs GeForce RTX 3060 auch mit 20 RT-Kernen der nächsten Generation (Ray-Tracing), 80 Tensor-Kernen, 32 ROPs und 80 TMUs ausgestattet.

Was den Speicher betrifft, so verfügt die GeForce RTX 3050 noch über 8 GB GDDR6-Speicher mit einer Geschwindigkeit von 14 Gbps, der am 128 Bit Interface der 4 Speicher-Controller eine kumulative Bandbreite von 224 Gbps besitzt. Dafür reichen die insgesamt 8 Lanes am PCIe 4.0 mehr als aus. Im Übrigen sind diese selbst bei PCIe 3.0 noch ausreichend, um der Karte keine Nachteile zu verschaffen. Aber für die Chipausbeute scheint diese Beschneidung wirklich was gebracht zu heben.

Der Rückstand zur GeForce RTX 3060 ist so natürlich vorauszusehen und weniger als 2/3 des Vollausbaus mit 30 SM ergäben letztendlich wohl auch keinen Sinn mehr. So kann man am Ende des Tages seitens NVIDIA die Ausbeute des GA106 erhöhen, was in Anbetracht des extrem hungrigen Marktes gar keine so schlechte Entscheidung ist. Merken wird man die fehlenden 10 SM (8 weniger als die RTX 3060) natürlich schon, aber man taktet dann einfach etwas höher und fertig.

Resizeable BAR ist zwar hardwareseitig bereits implementiert, allerdings funktioniert diese Implementierung aktuell eher so lala. Es ist also wirklich spannend zu sehen, was NVIDIA jetzt als neues RTX-Einstiegspaket anbietet, denn Karten sind momentan generell knapp und die Zielgruppe der weniger gut betuchten Full-HD-Spieler existiert ja wirklich. Genau diese Eignung werde ich heute genauer untersuchen und dieser Test umfasst natürlich auch noch die elektrische Umsetzung, die Platine, die Leistungsaufnahme und die Kühlung.

Das Gehäuse der Karte folgt der bekannten Formensprache der Gaming Reihe von Gigabyte und man ordnet diese Karte bewusst unterhalb des Aorus-Brands an. Eine Zerklüftung der Oberfläche gehört damit aber trotzdem dazu. Anthrazit als Farbe der Wahl (sehr erfrischend!) und ABS als Hauptkomponente – mehr gibt es nicht für die Kühlerabdeckung. Luxuriös ist es nicht, haptisch eher Durchschnitt aber optisch passt es wiederum zur bekannten Designsprache. Man setzt, im Gegensatz zu MSI, aber auf drei Lüfter, was zwar schnell aussieht, aber im Ende bei mageren 8 cm (7,6 cm Rotordurchmesser) auch zu Problemen führen dürfte.

Der Gesamtaufbau mit den 3.8 cm Einbautiefe zuzüglich der 4 mm für die Backplate aus Leichtmetall (etwas haptischer Luxus musste es dann schon sein) macht diese Karte zu einem echten Dual-Slot-Design mit allen bekannten Vor- und und Nachteilen. Der große Kühlerüberhang wird in der Backplate mit einer großen Öffnungen auf maximalen Durchlass getrimmt.

Mit den abgewogenen 700 Gramm liegt diese Karte fast in der Mitte zwischen der leichte Karte von Palit und dem Kilo-Stein von MSI, was erst einmal gut ausschaut. Die Länge von 28,5 cm ist übertrifft jedoch die beiden anderen, bereits getesteten Karten deutlich. Die Einbauhöhe ist mit 11 cm ab der Oberkante des PCIe-Slots bei eingebauter Karte bis zur Oberseite der Abdeckung erträglich, was mehr Platz zur Seitenwand garantiert.

Der einzelne 8-Pin-Anschluss an der Oberseite reicht völlig aus und er markiert optisch auch des Ende der versteckten, mit 21 cm auch etwas längeren Platine. Zum Kühler- und Lüfterdesign gibt es gleich auch noch weitere Details. Den NVLINK-Anschluss hat man logischerweise weggelassen, denn SLI ist eh tot und hier auch nicht erwünscht. RGB findet sich an der Oberseite als Hintergrundbeleuchtung für den Gigabyte-Schriftzug ohne Logo.

Der obligatorische HDMI-2.1-Anschluss darf nicht fehlen, die drei aktuellen DisplayPorts natürlich auch nicht. Die Rundloch-Öffnungen entlassen noch etwas Abwärme aus dem Gehäuseinneren, haben aber mit der direkten Kühlung nichts zu tun, da die Lamellen senkrecht sehen. Damit wären wir mit den Äußerlichkeiten auch schon wieder einmal komplett fertig und mehr gibt es dann später beim Teardown.

Das gegenüberliegende Ende der Karte zeigt uns nur noch eine geschlossene Veranstaltung.

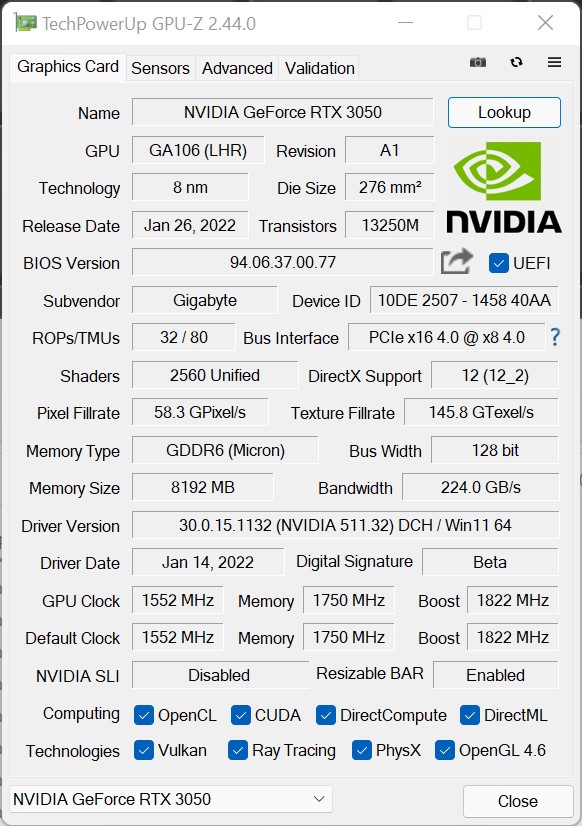

Die Daten der MSI-Grafikkarte zeigt uns noch einmal der aktuelle GPU-Z Screenshot, den Rest hatte ich ja schon weiter oben aufgeführt. Die 1552 MHz Basistakt entsprechen der Referenzvorgabe von NVIDIA und die 1777 MHz Boost-Takt der Referenz hebt MSI auf 1822 MHz ab Werk an. Die 1750 MHz Speichertakt waren zu erwarten und der Speicherausbau mit 8 GB am 128-Bit Interface logischerweise auch, wenn man an die 4 Speicher-Controller aus dem oben gezeigten Schema denkt.

Auch hier habe ich noch einmal eine Tabelle für alle Statistiker unter Euch, bevor es dann ab der nächsten Seite wirklich voll losgeht.

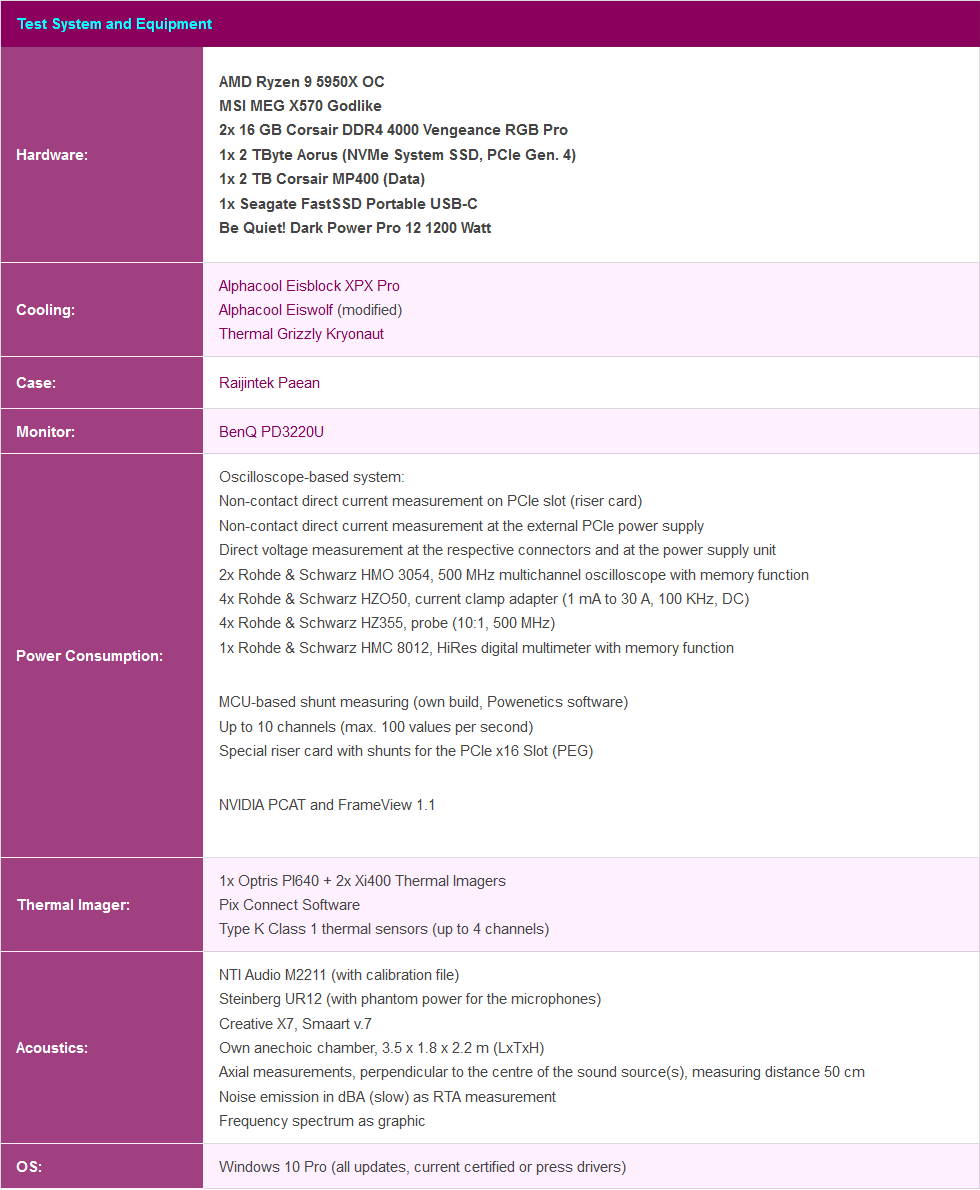

Testsystem und Auswertungssoftware

Das Benchmarksystem ist neu und steht jetzt nicht mehr im Labor, sondern wieder im Redaktionsraum. Ich setze nunmehr auch auf PCIe 4.0, das passende X570 Motherboard in Form eines MSI MEG X570 Godlike und einen selektierten Ryzen 9 5950 X, der wassergekühlt stark übertaktet wurde. Dazu kommt schneller RAM sowie mehrere schnelle NVMe SSDs. Für das direkte Loggen während aller Spiele und Anwendungen nutze ich NVIDIAs PCAD, was den Komfort ungemein erhöht.

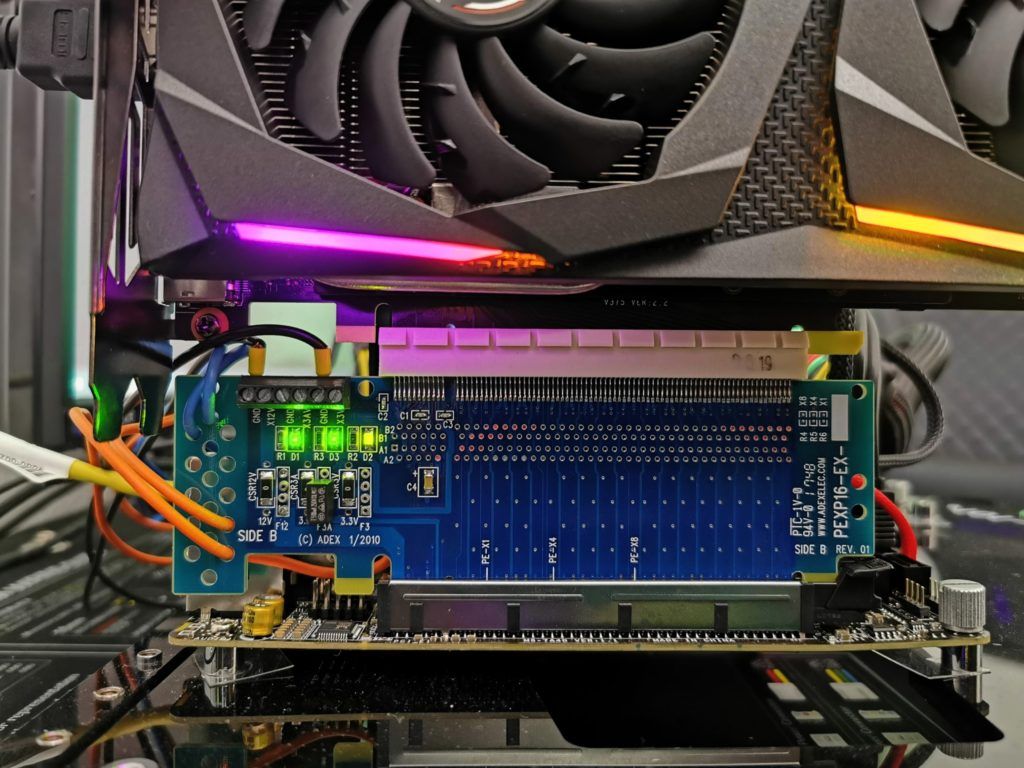

Die Messung der Leistungsaufnahme und anderer Dinge erfolgt hier im Speziallabor auf einem redundanten und bis ins Detail identischem Testsystem dann zweigleisig mittels hochauflösender Oszillographen-Technik…

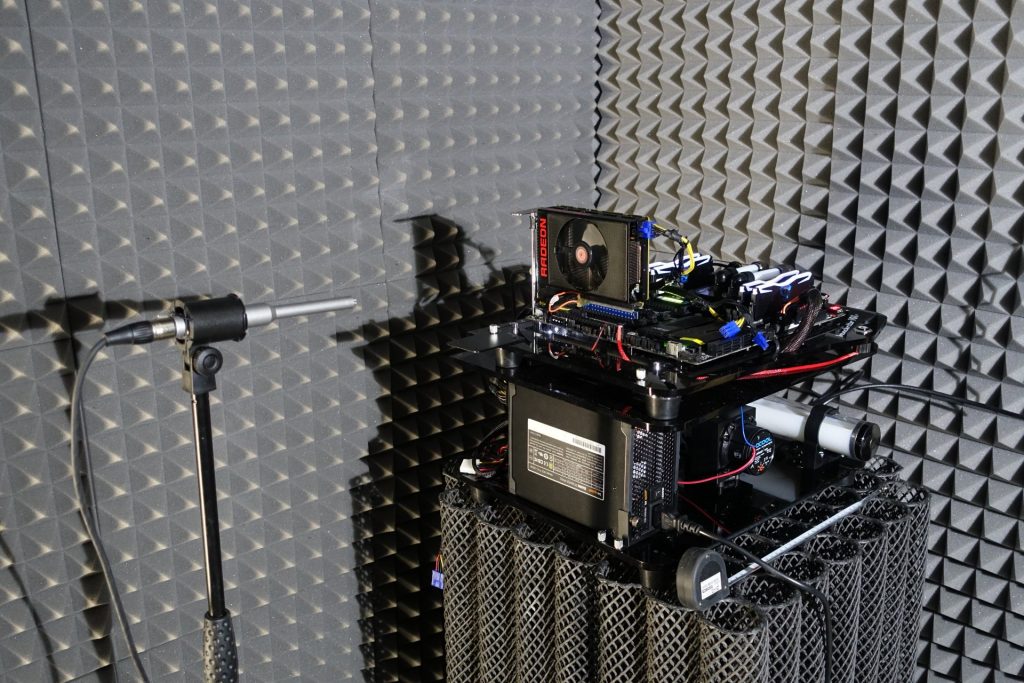

…und dem selbst erschaffenen, MCU-basierten Messaufbau für Motherboards Grafikkarten (Bilder unten), wo am Ende im klimatisierten Raum auch die thermografischen Infrarot-Aufnahmen mit einer hochauflösenden Industrie-Kamera erstellt werden. Die Audio-Messungen erfolgen außerhalb in meiner Chamber.

Die einzelnen Komponenten des Testsystems habe ich auch noch einmal tabellarisch zusammengefasst:

MSI GeForce RTX 3050 Gaming X 8G, 8GB GDDR6, HDMI, 3x DP (V397-421R)

| ca. 2 Wochen | 513,88 €*Stand: 27.07.24 03:05 |

- 1 - Einführung und Testsystem

- 2 - Teardown, Platinenanalyse und Kühler

- 3 - Gaming Performance Full-HD

- 4 - Leistungsaufnahme und Norm-Einhaltung

- 5 - Lastspitzen (Transienten) und Netzteilempfehlung

- 6 - Temperaturen und Infrarot-Tests

- 7 - Geräuschemission / Noise

- 8 - Zusammenfassung. Features und Fazit

25 Antworten

Kommentar

Lade neue Kommentare

Veteran

Urgestein

Urgestein

1

Veteran

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Veteran

Mitglied

Mitglied

Veteran

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →