The load on the 12-volt rails from 350 to 520 watts

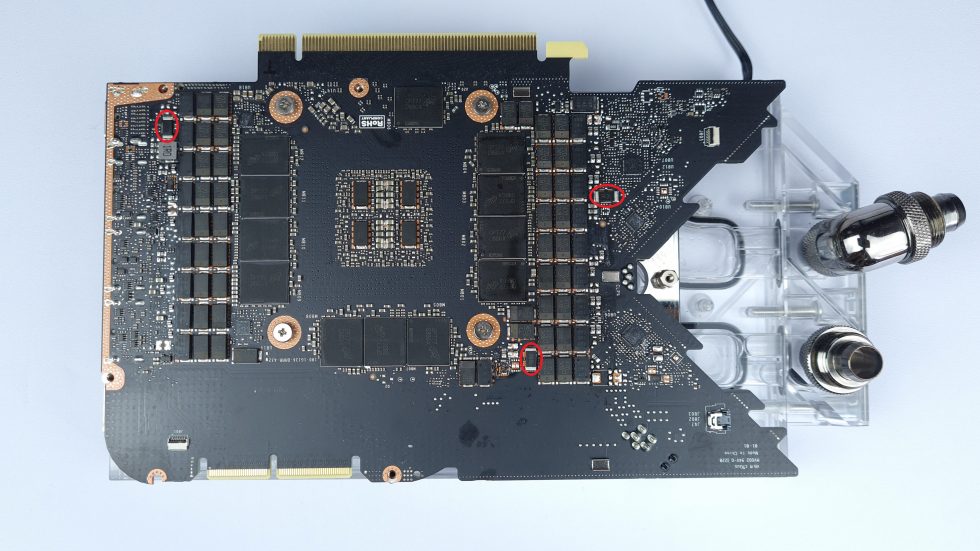

After the somewhat longer introduction, I now want to record the balancing of the RTX 3090 FE with three measurements and an extrapolation (emulation), which I almost pushed to the limits with a temporary shunt mod and water cooling including chiller. It’s better not to copy this excursion into hardware hell, because it doesn’t bring much besides a senselessly high power consumption and the waste of valuable resources. We already had a detailed article on how to solve this in detail:

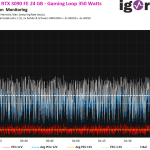

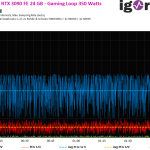

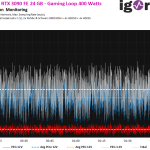

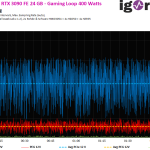

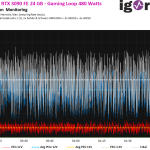

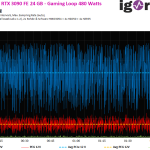

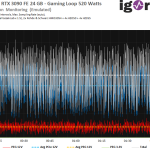

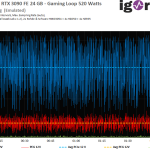

Let’s leave the graphics card at the 350 watts ex-factory for now and save the initial values. The following image galleries now show us the wattages for the entire card (white, average value dashed), the sum of the aux connectors (blue) and the motherboard slot (PEG, in red) with its average value (yellow dashed). The water temperature is nice and low with 20 °C over all measurementsand and makes you want to raise the power limit already.

But let’s first look at the 350-watt measurement in detail. The measured power consumption is initially exactly 350.3 watts (1 ms spikes up to 528 watts) and is thus really fitting the trend minus possible tolerances. However, the somewhat more sensitive PEG is already fully loaded to the limit here with 5.3 amps (gaming) and 5.6 amps (torture), which was also the case in the MSI RTX 3090 Suprim by the way. This isn’t really helpful, but it’s design-related.

But what happens when you run the Founders Edition without a shunt mod with the maximum BIOS power limit of 400 watts and extremely cool? We now end up with about 401 watts, which is also only 1 watt above the hard limit set in the BIOS. Again, a nice point landing, but the PEG is now already loaded with 5.7 amps (Gaming) and 5.9 amps (Torture). In both cases, the card is already slightly above the PCI SIG standard, which allows a maximum of 5.5 amps. Nothing will burn down or explode here, but standards are like laws and should also be strictly monitored! With 647 watts in the 1-ms interval, the load peak of all rails is also already quite high, but it will get “better”, promised.

I just temporarily soldered two identical resistors next to the 12-pin and the one for the PEG, doubling the power limit. The test run again landed at a bit under 350 watts (tolerances). Afterwards I determined the rough limit in Afterburner with the pocket calculator (consider that only half of the power is tracked!) and fiddled at the slider, until I landed with approx. 480 Watts. However, this is already completely borderline for the GeForce RTX 3090 FE and really nothing that I could justify for permanent use. Unfortunately, I didn’t get much higher than 490 watts despite manual OC, because the voltage runs out in the end. So 500 watts were no longer in reach, which is a pity.

With 757.9 watts, the highest measured 1-ms interval was once again slightly above the already measured peak value and the current load at the PEG increases to 6.9 amps (gaming) and 7 amps (torture). That is already 82.8 or 84 watts instead of the allowed 66 watts. But you can go one better, right away….

Since I didn’t want to destroy my card, I calculated the possible load for the rumored 520 watts on the basis of the three first measurements and the increase (the PEG increases in the ratio somewhat more slowly than Aux), because the three 8-pin sockets of the Suprim don’t allow for much more (the 12-pin Microfit of the FE certainly does not either). Of course, this is not a real measurement, but if one follows the trend of past performance increases, then what is now depicted is quite plausible. Thus, we are at the end of today’s experiment with 520 watts, which would also suggest a maximum of 821.3 watts with the 1-ms spikes. We are a bit closer to MSI’s 1000 Watt power supply recommendation.

The PEG would be prognostically loaded with a whopping 7.4 amps (Gaming) and 7.5 amps (Torture). That would be a maximum of 90 watts, which corresponds to an overload of 36%, which also applies to the flowing currents, which are up to 2 amps above the norm.

Stability and balancing

Now, of course, one could argue that current motherboards would simply handle this overload, but the problem is also due to the type of load. because there are no constant currents flowing, but the fast and frequent load changes almost create a high-frequency mixture, where the current peaks can be up to 15 (!) amperes, which amounts to 180.2 watts. Sure, they are only peaks and the power supply or the circuit board can still handle it. But such a nasty mix also has a retroactive effect on the other assemblies on the motherboard, which are also powered from the relevant 12-volt rail of the 24-pin motherboard connector.

And what does this have to do with the firmware? Of course, you can’t change the electrical distribution or connection of the phases to the respective rails with this, because there are unfortunately no intelligent load balancers in the existing layouts that would allow smart power gating from the PEG to the PCIe (the GTX 1070 Katana from Galax, for example, could do that). However, it is possible to influence the control of the individual phases to a certain extent and to take the ones connected to the PEG somewhat out of circulation. However, this creates higher loads on the other phases and it almost becomes a dog-eat-dog principle, because it may push the AUX connections to the limits and the power management in the PWM controller is somewhat overridden. Apart from the fact that the smart power stages would be significantly more expensive because they would have to handle higher currents.

Summary and conclusion

Today’s experiment asks questions that even the board partners did not (or could not) answer definitively. But as always, no answer is the best answer. Because as usually explicitly denied when I hit with speculation, this time no one did. And also many a shopping list (BoM) actually speaks for my thesis. Of course, this is and remains purely speculative, but the conclusion cannot be dismissed. It is almost impossible to build a significantly faster graphics card out of one that has already been designed to the limit if you want to stick to the set standards.

I don’t even want to write about the capacitors underneath the GPU and along all the tracks up to the PWM nodes of the voltage converters, because this topic can’t be dismissed either. If 350 or even 450 watts already cause huge stability problems (and that could only be fixed by a driver), what happens at 520 watts? I don’t really want to think about that. But if such cards really make it to the market, I’ll be happy to be convinced of the opposite (or convince myself).

If the graphics card manufacturers should really offer models with over 500 watts TBP as the next generation, then the layout will have to be completely redesigned. Simply upgrading, as happened in the case of the rumored GeForce RTX 3090 Ti, will then inevitably end in a fiasco. Incidentally, the memory with 21 Gbps is also a shaky candidate, whose stability could be argued about despite the backdrill method, even if NVIDIA’s base design kit allows it and the manufacturers stick to it. Theory and practice.

This is the end of this short excursion, and I wouldn’t be surprised if I’m not that far off the mark in my assessment of the problem. Because I still also want to note one thing in the end: the measured card was no longer really stable from about 450 watts onwards.

69 Antworten

Kommentar

Lade neue Kommentare

Urgestein

1

Urgestein

Urgestein

Veteran

Urgestein

Veteran

1

Veteran

Urgestein

Veteran

Urgestein

Urgestein

Veteran

Veteran

Veteran

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →