Dass sich die bereits für den 27.01.22 kolportierte GeForce RTX 3090 Ti ordentlich verschiebt, dürfte vielleicht sogar mehrere Gründe haben, die jedoch sicher im Zusammenhang betrachtet werden müssen. Dass es so ist, konnte man bereits überall lesen, nur eben leider nicht, warum genau. Die Schmallippigkeit bei NVIDIAs Boardpartnern war diesmal erstaunlich ausgeprägt und doch kommt man auch im Ja-Nein-Ausschlussverfahren zu einem interessanten Schluss, wenn man die richtigen Fragen stellt. Ich möchte heute auch nicht wild spekulieren, sondern anhand diverser Informationen und Puzzle-Steinchen (die mir quasi in meinen virtuellen Briefkasten geworfen wurden) ein wenig Grundlagenforschung betreiben.

Die Umstände, über die ich heute schreibe, sind also durchaus ein reales Szenario und es erhebt gleichzeitig doch nur den Anspruch, lediglich ein Praxis- und Fakten-basiertes “Was wäre wenn” Experiment zu sein und eben kein Leak, wo man seine Quellen mit Contenance in die Pfanne haut und NVIDIAs Legal-Abteilung zu rotieren beginnt. Die aktuelle Gerüchte, je nach Seite, sprechen von Hardware- oder Firmware-Probleme, ich würde sogar soweit gehen, von Hardware UND Firmware-Problemen zu sprechen, wobei die Firmware gleichzeitig die Ursache und die Lösung sein könnte und die Hardware der harte Betonpfosten im High-Speed-Rennen.

Allerdings, das muss ich auch eingrenzen, haben mittlerweile sogar drei große Boardpartner versichert, dass Ihre Karten problemlos laufen, man keine wirklichen Probleme damit hätte und das Hold von NVIDIA ohne jegliche Angaben von Gründen kam. Ob sich NVIDIA jetzt mit der eigenen Founders Edition müht und der Rest der Anbieter auf das “MSRP-Modell” warten muss, wer weiß… Aber dass die Anpassung der FE nicht einfach ist (bis hin zur Kühlung), ist sicher kein Geheimnis. Deshalb beziehe ich mich im heutigen Artikel auch allein auf die FE und kein andees Modell.

Bestehende Designs und die Grenzen des Balancings

Um auch wirklich alle abzuholen, werde ich die folgenden Inhalte stark vereinfachen. Zumindest soweit, wie es noch inhaltlich exakt genug bleibt. Fangen wir zunächst auf der kaufmännischen und technischen Seite an. Da die GeForce RTX 3090 Ti eher ein Einhorn-Dasein fristen dürfte, ergäbe es wenig Sinn, für eine physisch fast baugleiche Karte (sieht man mal von der GPU und dem Speicher ab) extra noch eine eigene Platine zu entwickeln bzw. diese neue Karte dann auch noch noch einmal aufwändig durch NVIDIAs Greenlight-Programm zur Validierung aller Einzelschritte zu schicken. Das erklärt dann auch, warum z.B. MSI bei den drei 8-Pin Anschlüssen statt des neuen 16-Pin Microfit-Adapters bzw. des 12+4 ATX-Steckers verbleibt. Man benutzt einfach weiter, was man eh schon hat!

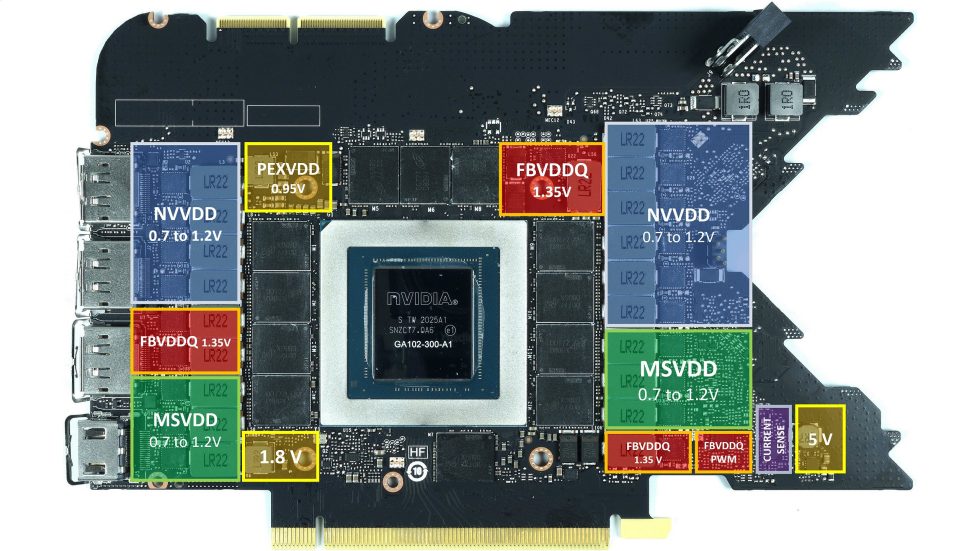

Deshalb werden die Boardpartner meist nichts anderes tun, als die bestehenden Designs der GeForce RTX 3090 weiter zu nutzen und diese Platinen, sowie die Firmware einfach dementsprechend anzupassen. Doch wie immer steckt da bereits der Teufel im Detail, denn die komplette Spannungsversorgung so einer Karte ist ein sehr fragiles und sorgsam untereinander abgewogenes Konstrukt. Da reicht es nicht, an nur einer oder zwei Stellschrauben zu drehen (wie es wohl oft passiert ist), sondern man muss unbedingt kontrollieren, welchen Rattenschwanz an gegenseitigen Beeinflussungen man möglicherweise noch hinter sich herzieht. Zumal ja auch diese ganzen Karten bereits sehr knapp auf Kante genäht worden sind. Betrachten wir der Einfachheit halber zunächst rein exemplarisch die Aufteilung der GeForce RTX 3090 Founders Edition, wobei wir die Rückseite vernachlässigen:

Wir sehen eine Aufteilung der GPU-Versorgungsspannung in NVVDD (Blau) und MSVDD (Grün), sowie die für den Speicher in Form von FBVDDQ (Rot). Die Erzeugung der weiteren Teilspannungen ist hier erst einmal wegen Ihres Anteils an der TBP zu vernachlässigen, wenn auch nicht völlig uninteressant. Wenn man weiß, wie die Phasen der Spannungswandler funktionieren, dann weiß man auch, dass der Großteil am externen PCIe-Anschluss (Aux) angebunden ist. Aber es sind nun einmal nicht alle. Ein gewisser Teil hängt auch am PCIe-Motherboard-Slot (PEG) und spätestens jetzt beginnt das Problem, das sich sogar recht einfach nachstellen lässt! Der PEG hat nämlich seine Grenze von 5.5 Ampere (also 66 Watt) auf der 12-Volt-Schiene bei vielen GeForce RTX 3090 bereits erreicht und könnte nur nur mittels einer (eklatanten) Normüberschreitung noch weiter belastet werden!

Wer übrigens wissen möchte, welche Komponenten welche Leistungsaufnahme verursachen, kann zunächst noch erst einmal einen Blick auf das Referenzlayout (PG132) werfen, das NVIDIA den Boardpartnern als Leitfaden mit auf den Weg gab. Die thermische Last entspricht natürlich auch der elektrischen Verlustleistung der jeweiligen Komponenten, da gilt immer noch der Energieerhaltungssatz! Und so sehen wir, dass der Speicher wirklich mit fast 60 Watt (also 2x 30 Watt pro Seite) kalkuliert wird und die GPU eigentlich sogar noch unter 230 Watt bleibt.

In der Firmware wird für die GeForce RTX 3090 Ti jedoch eine deutlich höhere TBP (ab ca. 480 Watt) hinterlegt, also der Wert für die gesamte Grafikkarte unter Einbeziehung aller existierenden 12-Volt-Schienen. Und wenn wir nun die Komponenten aus dem Schema oben im Hinterkopf behalten, wird es besonders im Bereich der GPU, der GPU-Spannungswandler und dem Speicher auch thermisch recht lustig zugehen. Doch die Abwärme ist letztendlich ja nur die Folge der zuvor zugeführten elektrischen Energie.

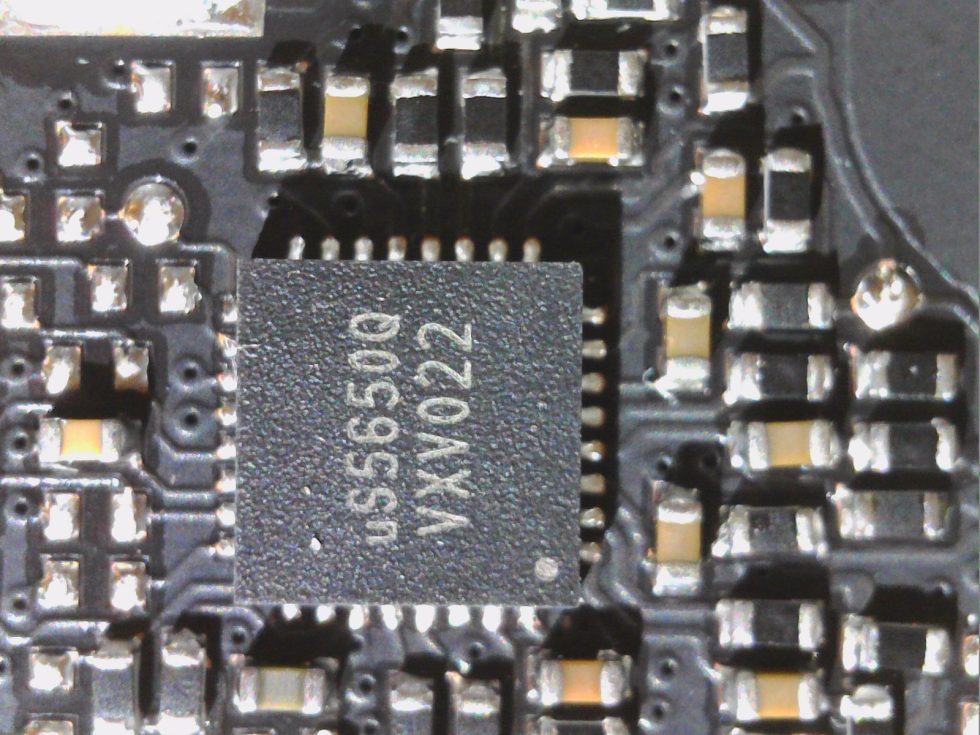

Das dürfte dann auch der primäre Ausgangspunkt der ganzen Probleme sein, auch wenn NVIDIA alle eingehenden Leitungen mit sogenannten Monitoring-Chips wie z.B. dem unten abgebildeten uS5650Q von UPI akribisch überwacht. Diese speziellen Chips erfassen verschiedene Spannungen in recht kleinen und damit sehr gut geeigneten Intervallen und lassen somit eine Echtzeitkontrolle zu.

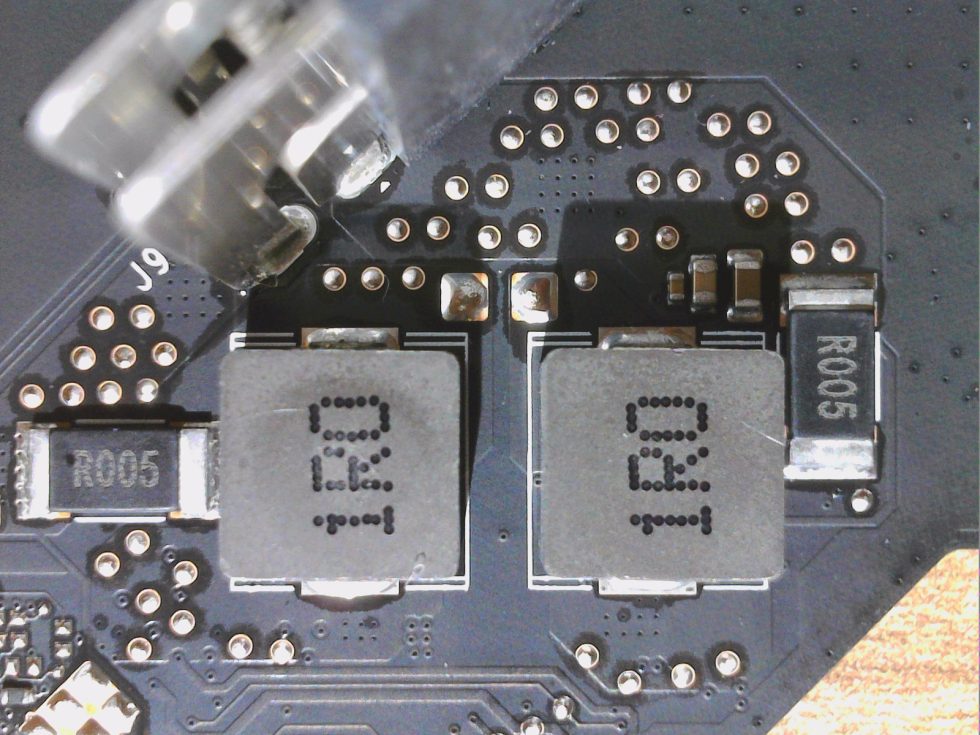

Doch es geht ja am Ende auch um die fließenden Ströme und so misst man zweckmäßigerweise den Spannungsabfall, der an den jeweiligen Eingängen der 12-V-Schienen an sogenannten Shunts (also niederohmigen Widerständen) entsteht (siehe Bild unten neben den beiden Längsspulen in der Mitte). Daraus lässt sich nach dem Ohm’schen Gesetz dann ganz einfach der jeweils fließende Strom errechnen und zusammen mit der ebenfalls erfassten Eingangsspannung kann man so auf die jeweilige Leistung als Produkt beider Werte schließen. Zusammenaddiert hat man dann die aktuelle Leistungsaufnahme, die z.B. Programme wie HWInfo auch auslesen können. AMD bietet so einen Service leider (noch) nicht. Schade eigentlich. Und wenn ich hier so vereinfacht “man” schreibe, das erledigt natürlich die Firmware der Karte.

Nur leider kann man nicht so einfach die Leistungsaufnahme einzelner Komponenten wie GPU oder Speicher steigern, ohne dass es zu einem gleichzeitigen Anstieg auf allen Versorgungsleistungen käme. Und ja, auch der noch schnellere Speicher wird wohl zusätzliche Leistung benötigen und sicher nicht mit den aktuellen, maximal 3 Watt pro Modul auskommen. Und das alles mit bereits bestehenden Designs? Bei einer MSI RTX 3090 Ti Suprim hätte ich da auch aufgrund des fetten Kühlers thermisch sicher kein Problem, wohl aber elektrisch.

Und auch wenn ich Shunt-Mods für den Alltagsbetrieb eigentlich ablehne, kann man doch aus ihnen sogar noch lernen! Denn wenn man nur die Shunts an der externen Versorgungbuchse ändert (in diesem Fall der RTX 3090 FE also zwei) und den Shunt des PCIe-Slots (Motherboard) im Original belässt, wird die Karte sporadisch instabil und sie wird auch nicht mehr sauber unter Last laufen. Auch das habe ich getestet, bevor auch die Messungen auf der nachfolgenden Seite gemacht habe. Stichwort Umblättern! Jetzt gibts Watt zu staunen.

69 Antworten

Kommentar

Lade neue Kommentare

Urgestein

1

Urgestein

Urgestein

Veteran

Urgestein

Veteran

1

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Veteran

Veteran

Veteran

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →