Die Belastung der 12-Volt Schienen von 350 bis 520 Watt

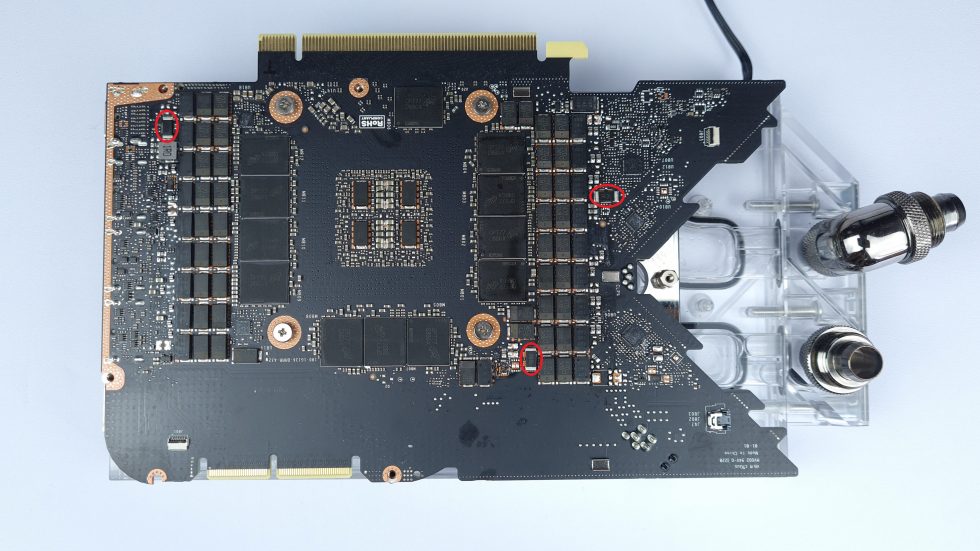

Nach der doch etwas längeren Einführung will ich nun mit drei Messungen und einer Hochrechnung (Emulation) das Balancing der RTX 3090 FE erfassen, die ich mittels temporärem Shunt-Mod und einer Wasserkühlung samt Chiller fast an die Grenzen des Möglichen getrieben habe. Nachmachen sollte man diesen Ausflug in die Hardware-Hölle besser nicht, denn es bringt außer einer sinnlos hohen Leistungsaufnahme und der Verschwendung wertvoller Ressourcen nicht mehr so viel. Wie das im Detail zu lösen ist, hatten wir ja bereits schon einmal als ausführlichen Artikel:

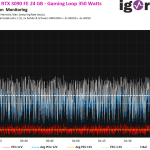

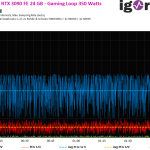

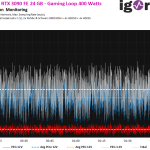

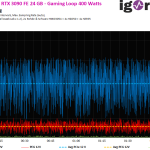

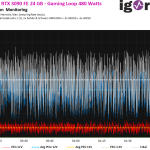

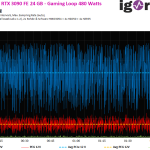

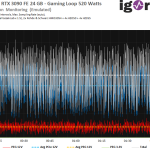

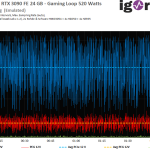

Belassen wir die Grafikkarte zunächst erst einmal auf den 350 Watt ab Werk und sichern die Ausgangswerte. Die nachfolgenden Bildergalerien zeigen uns nun die Wattzahlen für die gesamte Karte (Weiß, Durchschnittswert gestrichelt), die Summe der Aux-Buchsen (Blau) und den Motherboard-Slot (PEG, in Rot) mit dessen Durchschnittswert (Gelb gestrichelt). Die Wassertemperatur ist mit 20 °C über alle Messungen hin schön niedrig und macht so wirklich Spaß auf mehr.

Doch betrachten wir zunächst erst einmal die 350-Watt-Messung im Detail. Die gemessene Leistungsaufnahme beträgt zunächst exakt 350,3 Watt (1 ms Spikes bis 528 Watt) und liegt damit abzüglich möglicher Toleranzen so richtig voll im Trend. Der etwas empfindlichere PEG wird hier aber bereits mit 5,3 Ampere (Gaming) und 5.6 Ampere (Torture) voll am Limit belastet, was übrigens auch bei der MSI RTX 3090 Suprim der Fall war. Das ist nicht wirklich hilfreich, aber designbedingt.

Doch was passiert jetzt, wenn man die Founders-Edition ohne Shunt-Mod mit dem maximalen, im BIOS hinterlegten Power Limit von 400 Watt und zudem extrem kühl betreibt? Wir landen nun bei ca. 401 Watt, also auch nur 1 Watt über dem im BIOS gesetzten harten Limit. Erneut eine schöne Punktladung, aber der PEG wird nun schon mit 5,7 Ampere (Gaming) bzw. 5.9 Ampere (Torture) belastet. In beiden Fällen liegt die Karte also schon etwas über der Norm der PCI SIG, die maximal 5.5 Ampere erlaubt. Es wird hier nichts abfackeln oder explodieren, aber Normen sind wie Gesetze und sollten auch strikt eingehalten werden! Mit 647 Watt im 1-ms-Intervall liegt auch die Lastspitze aller Rails schon ordentlich hoch, aber es wird noch „besser“, versprochen.

Ich habe einfach zwei identische Widerstände neben dem 12-Pin und dem einen für den PEG temporär aufgelötet und damit das Power Limit verdoppelt. Der Testbetrieb landete wieder bei etwas unter 350 Watt (Toleranzen). Danach habe ich mir die gröbere Vorgabe im Afterburner mit dem Taschenrechner ermittelt (immer berücksichtigen, dass man ja nur die Hälfte erfassen kann!) und solange am Regler gespielt, bis ich bei ca. 480 Watt gelandet bin. Das ist für die GeForce RTX 3090 FE allerdings bereits komplett grenzwertig und wirklich nichts, was ich für den Dauerbetrieb vertreten könnte. Sehr viel höher als 490 Watt bin ich leider trotz manuellem OC dann nicht mehr gekommen, denn da geht einem am Ende auch die Spannung aus. Die 500 Watt waren leider nicht mehr drin, schade.

Mit 757,9 Watt lag der höchste gemessene 1-ms-Intervall noch einmal etwas über dem bereits gemessenen Spitzenwert und die Strombelastung am PEG steigt auf 6,9 Ampere (Gaming) und 7 Ampere (Torture). Das sind immerhin bereits 82,8 bzw. 84 Watt statt der erlaubten 66 Watt. Aber man kann ja noch einen drauflegen, gleich…

Da ich meine Karte nicht zerstören wollte, habe ich anhand der drei ersten Messungen und dem Anstieg (der PEG steigt im Verhältnis etwas langsamer an als Aux) die mögliche Last für die kolportieren 520 Watt berechnet, denn viel mehr geben auch die drei 8-Pin-Buchsen der Suprim nicht her (der 12-pin Microfit der FE sowieso nicht). Natürlich ist dies keine echte Messung, aber folgt man dem Trend der bisherigen Leistungssteigerungen, dann ist das nun Abgebildete durchaus plausibel. Mit 520 Watt liegen wir also am Ende des heutigen Experiments, was auch bei den 1-ms-Spikes auf maximal 821,3 Watt schließen ließe. Da kommen wir den 1000 Watt Netzteilempfehlung von MSI doch schon etwas näher.

Der PEG würde prognostisch mit satten 7,4 Ampere (Gaming) und 7,5 Ampere (Torture) belastet. Das wären dann maximal 90 Watt, was einer Überlast von immerhin reichlich 36% entspricht, was auch für die fließenden Ströme gilt, die bis zu 2 Ampere über der Norm liegen.

Stabilität und Balancing

Jetzt könnte man natürlich argumentieren, dass aktuelle Motherboards diese Überlast einfach wegstecken würden, aber das Problem liegt auch an der Art der Last. denn es fließen ja keine konstanten Ströme, sondern die schnellen und häufigen Lastwechsel erzeugen fast schon ein hochfrequentes Gemisch, bei dem die Stromspitzen bis zu 15 (!) Ampere betragen können, was 180,2 Watt ausmacht. Sicher, es sind nur Peaks und das Netzteil bzw. die Platine können das noch wegstecken. Aber solch ein fieses Gemisch wirkt sich auch rückwirkend auf die anderen Baugruppen auf dem Motherboard aus, die ebenfalls aus der relevanten 12-Volt-Schiene des 24-Pin-Motherboardanschlusses gespeist werden.

Und was hat das nun mit der Firmware zu tun? Die elektrische Aufteilung bzw. Anbindung der Phasen an die jeweiligen Rails kann man natürlich damit nicht ändern, denn es gibt leider in den existierenden Layouts keine intelligenten Load-Balancer, die ein smartes Power-Gating vom PEG zum PCIe ermöglichen würden (das konnte z.B. die GTX 1070 Katana von Galax). Man kann aber in gewissem Grade die Ansteuerung der einzelnen Phasen beeinflussen und die am PEG angeschlossenen etwas aus dem Verkehr ziehen. Nur schafft man damit wieder höhere Lasten auf den anderen Phasen und es wird fast schon zum Hund-Schwanz-Prinzip, weil es dann unter Umständen die AUX-Anschlüsse an die Grenzen treibt und das Power Management im PWM-Controller etwas ausgehebelt. Mal abgesehen davon, dass die Smart Power Stages deutlich teurer würden, weil sie höhere Ströme stemmen müssten.

Zusammenfassung und Fazit

Das heutige Experiment stellt Fragen, die auch die Boardpartner nicht final beantworten wollten (oder konnten). Aber wie immer ist gar keine Antwort sogar die bessere. Denn wie sonst explizit verneint, wenn ich mit Spekulationen aufgeschlagen bin, hat es diesmal niemand. Und auch so manche Einkaufsliste (BoM) spricht eigentlich für meine These. Es ist und bleibt natürlich rein spekulativ, aber des Fazit ist nicht von der Hand zuweisen. Aus Grafikkarten, die bereits am Limit konstruiert wurden, eine signifikant schnellere zu basteln, ist nahezu unmöglich, wenn man sich an die gesetzten Normen halten möchte.

Da will ich auch nicht wieder über die Kondensatoren unterhalb der GPU und entlang der ganzen Tracks bis hin zu dem PWM Nodes der Spannungsgwandler schreiben, denn auch dieses Thema ist nicht von der Hand zu weisen. Wenn schon 350 oder gar 450 Watt bereits riesige Stabilitätsprobleme aufwerfen (und das alles nur durch einen Treiber wieder gefixt werden konnte), was passiert dann erst bei 520 Watt? Darüber will ich eigentlich gar nicht nachdenken. Aber falls es wirklich solche Karten auf den Markt schaffen, lasse ich mich gern vom Gegenteil überzeugen (bzw. überzeuge mich selbst).

Wenn die Grafikkartenhersteller als nächste Generation wirklich Modelle mit über 500 Watt TBP anbieten sollten, dann muss das Layout komplett neu gestaltet werden. Einfach aufbohren, so wie im Fall der kolportierten GeForce RTX 3090 Ti geschehen, wird dann unweigerlich im Fiasko enden. Im Übrigen ist auch der Speicher mit den 21 Gbps so ein Wackelkandidat, über dessen Stabilität man trotz Backdrill-Verfahren trefflich streiten könnte, selbst wenn NVIDIAs Base-Design-Kit das hergibt und sich die Hersteller daran halten. Theorie und Praxis eben.

Damit ist dieser kurze Exkurs auch schon wieder beendet und es würde mich nicht erstaunen, wenn ich mit der Problemerfassung nicht gar so weit daneben liege. Denn eines will ich zum Schluss auch noch loswerden: so richtig stabil war die gemessene Karte ab ca. 450 Watt auch nicht mehr.

69 Antworten

Kommentar

Lade neue Kommentare

Urgestein

1

Urgestein

Urgestein

Veteran

Urgestein

Veteran

1

Veteran

Urgestein

Veteran

Urgestein

Urgestein

Veteran

Veteran

Veteran

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →