Is the 600 watts really the upper end or where are the tolerance ranges for exceeding the standards for a short bursts? And why does the GeForce RTX 3090 Ti suddenly show a completely different behavior under full load? I will answer exactly these questions today, because the review of the GeForce RTX 3090 Ti has (probably not only) made me curious and no, it is NOT an April Fool’s joke. In order to understand the whole thing including the internal information at all, we of course also need high-resolution measurements in the microsecond range and the appropriate before/after comparison. Only then will we also understand the new standards for the expansion cards between 300 and 600 watts of power consumption, in which both GPU manufacturers were already very intensively involved a year ago. Interestingly, there is nothing in the standardization of the 12VHPWR connector from Intel.

Comparison of the high-resolution measurements and NVIDIA’s Boost

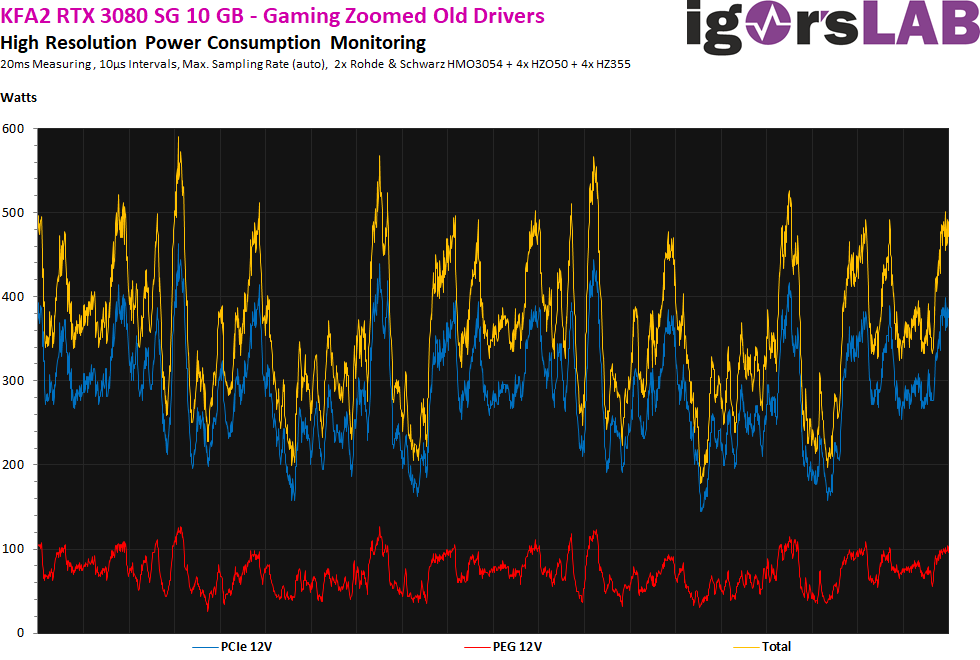

Let’s start with a typical 320 watt card in the form of the GeForce RTX 3080. And we remember that my investigations and technical submissions had also led NVIDIA to de facto “defuse” the driver in order to eliminate at least the biggest load peaks. With an initial power of up to almost 600 watts, this card was of course already a real load for the system and also the power supply. The largest ratio between the measured average power of 320 watts (2 minutes) and the relevant intervals around 100 µs was a maximum of 1.875. I will write something more about the ratio on the next page, because we need it for compliance with the standard.

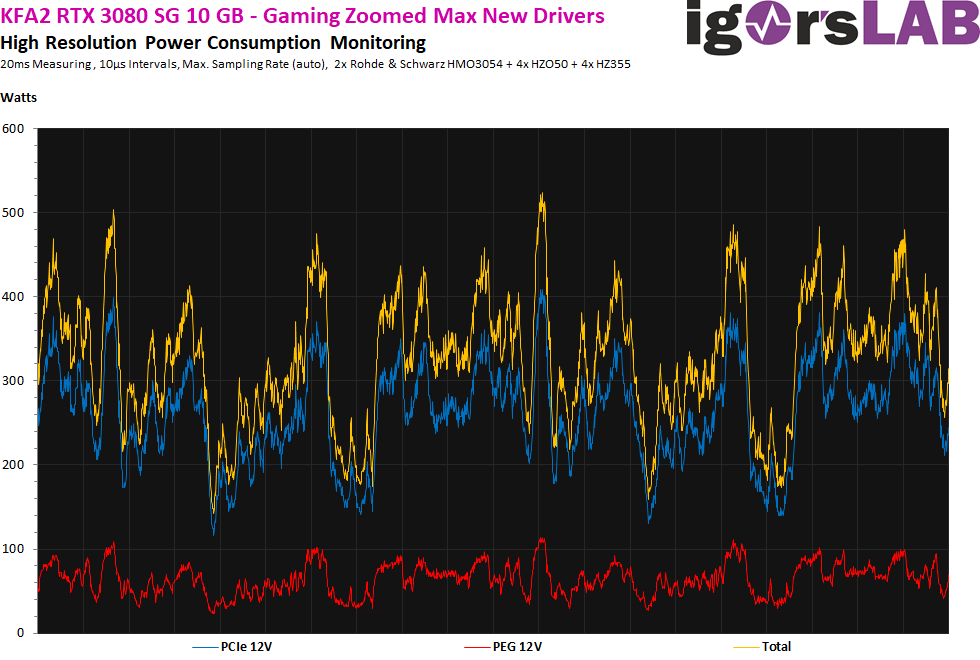

Then NVIDIA counteracted with a “miracle driver”, but also had to let up a bit in performance. But even here we are still at up to 520 watts in the peak. The ratio between the average board power and the largest spikes (100 µs) was now a maximum of 1.625. But again, you don’t see any capping by the firmware, only a reduction of the load differences (“smoothing”), which is most likely achieved by a slightly lower voltage change curve.

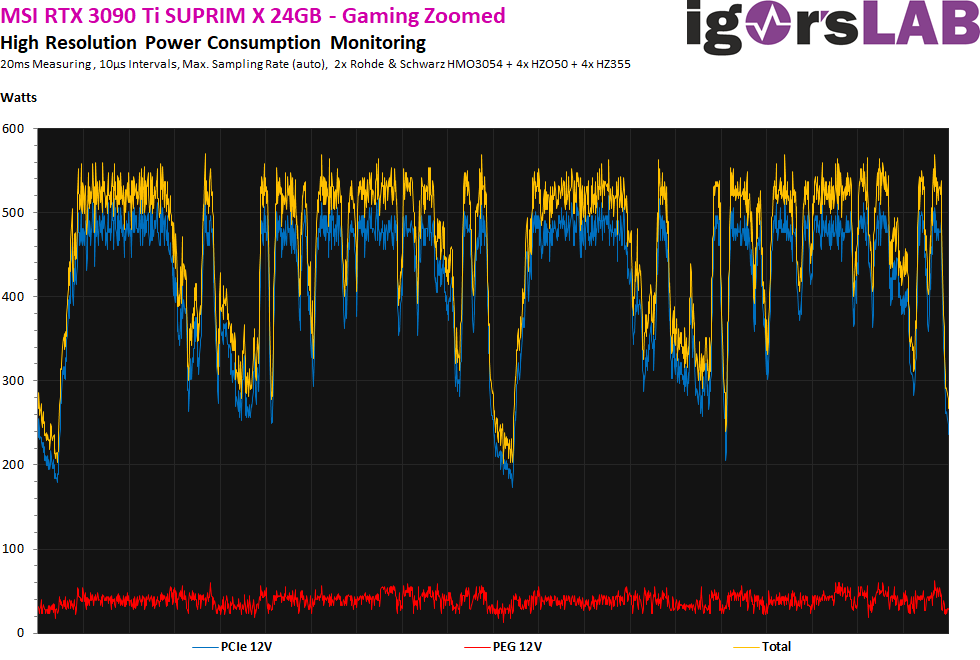

And then came the GeForce RTX 3090 Ti. What I have always called the “playground” for NVIDIA’s new cards with the Ada chip starting in the fall is quite interesting, although it is not only limited to NVIDIA, but also includes AMD, which both sit on the PCI SIG board and can bring in their own demands and suggestions. So, the GeForce RTX 3090 Ti is actually the first graphics card ever that has to submit to the new standards of the PCIe 5.0 specification in terms of power consumption and supply.

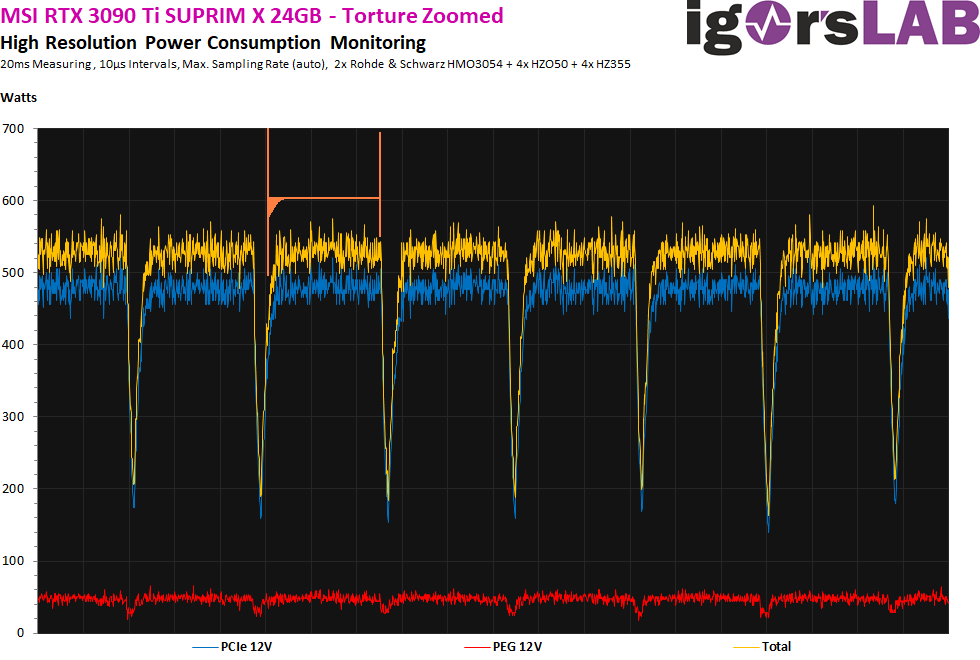

Let’s now take a look at the measurement at just under 480 watts on average, where the load peaks are usually only at a maximum of 580 watts. The ratio of the relevant load peaks in the 100 µs interval is only 1.2, although the card is significantly thirstier! We also see a much more balanced curve and much fewer voltage dips.

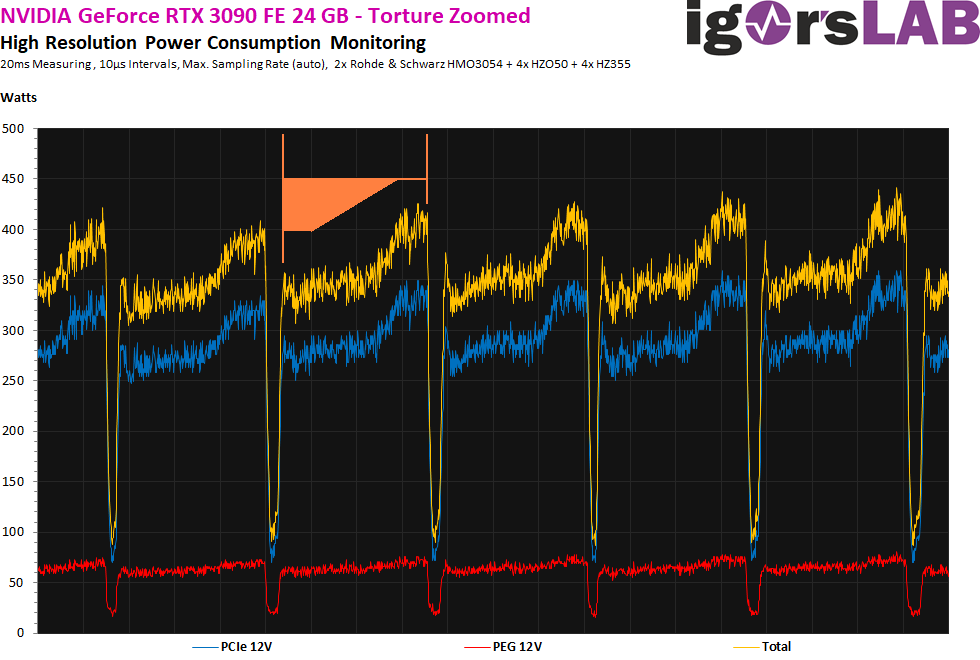

If you now also compare the full load scenarios, such as a stress test, you can see the completely changed control behavior of the card. NVIDIA has improved the boost in the entire power supply. First, I analyzed the previous behavior using the GeForce RTX 3090 FE under constant steady load. After a short “transient phase”, we see a longer increase up to a capping limit, after which a complete power collapse occurs after it is reached and exceeded over time, before the whole thing repeats identically over and over again:

With the new card, we first see a somewhat slower increase (also in the GPU clock) over a very short period of time and then a very balanced, straight load curve until the usual downclocking. The intervals between the individual load sections have also become somewhat shorter, including the “pauses”. So we can see very well that NVIDIA’s control reacts significantly differently when all sensors and input monitoring of all 12-volt rails are included.

The lower “rule frenzy” will possibly have a somewhat negative impact on the achievable performance, but it also creates fewer stability problems in the surroundings. This is also absolutely necessary for the safe operation of such bolides with up to 600 watts of board power. What this now has to do with the PCI SIG and the standards for the 12VHPWR connector, which is also used for the first time, and what influence AMD and NVIDIA have equally had on this standardization, we’ll read on the next page.

15 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Mitglied

Urgestein

Veteran

Urgestein

Veteran

Alle Kommentare lesen unter igor´sLAB Community →