So, finally the time has come and today I can show you detailed benchmarks with the GUNNIR Iris Xe MAX Index V2 – Intel’s DG1, which can offer a first taste of Intel’s ARC Alchemist series, which is based on the newer DG2 GPU family. However, this is not yet on the market, so this first freely available retail card of the DG1 has aroused my desires. After all, the DG1 GPUs were initially only available for software developers (see our first review), but eventually found their way into the discrete DIY desktop market later under the Iris Xe brand. Just not in Germany. Our sample was purchased privately in Hong Kong, because as we all know, curiosity dies last so let’s dive into this GPU mystery together.

BIOS and suitable microcode as basic requirement

But even if this retail card in the form of the GUNNIR Iris Xe MAX Index V2 still costs the equivalent of 110 USD (without import sales tax plus shipping costs) – you can’t just plug it in and go. Unfortunately, Intel doesn’t love us that much. Gunnir does not give any compatibility information on its own homepage and product page, on which motherboard this card could run at all. The fact is that the Iris Xe graphics cards do not work with all systems, and AMD also has to be left out in general. The reason lies in the chip’s origin, which is actually a notebook GPU and thus should not be able to run independently on any platform with its own EEPROM for the complete firmware on the PCB.

There is also no support for AMD platforms for exactly this reason. Various websites colocate the support for Intel with the restriction to the Coffee and Comet Lake, i.e. the 9th and 10th generation. Following this information, the Iris Xe models would only be compatible with Intel’s B460, B365 and H310C motherboards. However, after inquiring with several motherboard manufacturers (and after a few unsuccessful attempts of our own), a completely different picture unfortunately emerged. In order to use up-to-date hardware and also to test the DG1 against the biggest SKU of the UHD 770, we therefore use a specially prepared Z690 board. We can perhaps explain how this works with the BIOS injection another time, if there is reader interest.

Thus, there is no motherboard (not even among the mentioned chipset variants) – which should generally and across-the-board already be fully compatible and executable from the dealer. In my specific case, I will be using an MSI MAG Z690 Tomahawk WiFi DDR4 along with a special “beta” BIOS (or rather homebrew).

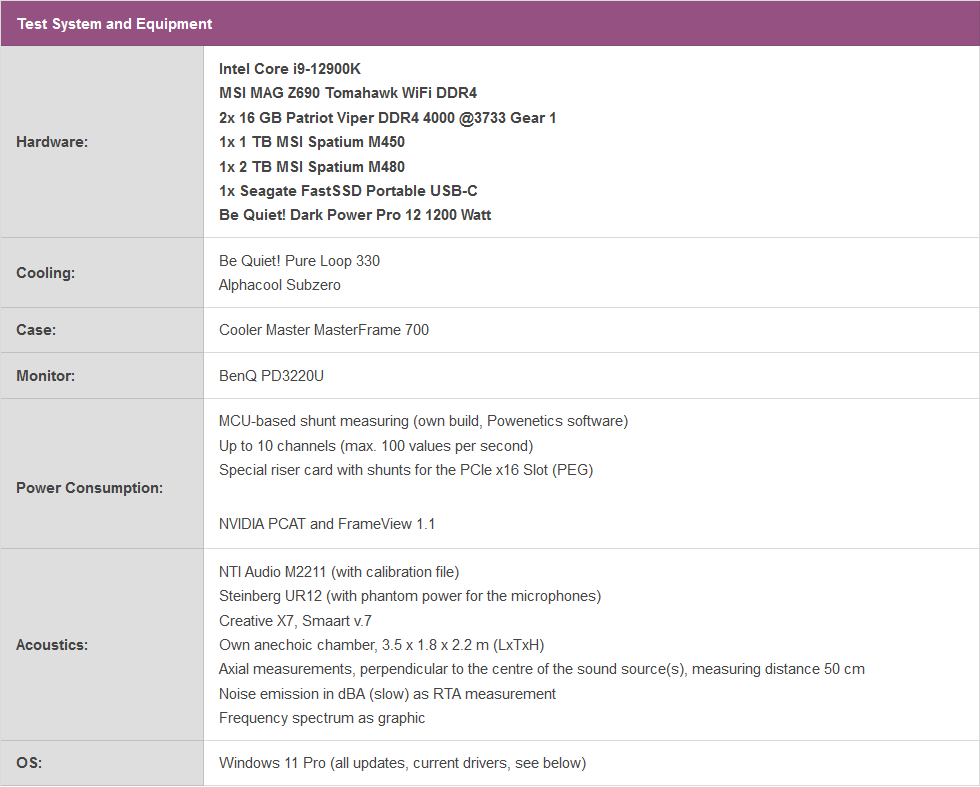

The test system differs from the usual, so I’ll tabulate all the details again here:

The GUNNIR Iris Xe MAX Index V2 – Technical data

The Iris Xe series can virtually be considered the predecessor of the Arc A300 series, which is supposedly based on the DG2-128EU GPU. A smaller 6nm manufacturing node, higher clock rates and a higher TDP should provide a significant performance increase in Intel’s entry-level desktop GPU segment. But this initial test can also provide a certain foretaste when you later try to extrapolate the performance data with the help of the execution units and clock rate.

Intel has actually developed two DG1-SKUs: Iris Xe and Iris Xe Max- Whereby our model corresponds to the chip exclusively developed for laptops in its full configuration. GUNNIR thus uses all 96 execution units for the Iris Xe Max Index V2 (instead of 80 for the Iris Xe non-MAX). The 96 EUs offer 768 shader units and a boost clock of 1.65 GHz. Despite this increase over the 80-EU variant, the power limit of 25 to 41W has not changed compared to the non-MAX model. At least on paper.

Incidentally, the company offers no less than three variants of DG1-based cards, all of which are listed on Taobao, with prices rising all the time. This ranges from the cheapest low-profile card for plenty of 90 USD and the Index V2 with the Xe chip for just over 100 USD to the Xe Max “top model” for over 110 USD by now.

The drivers

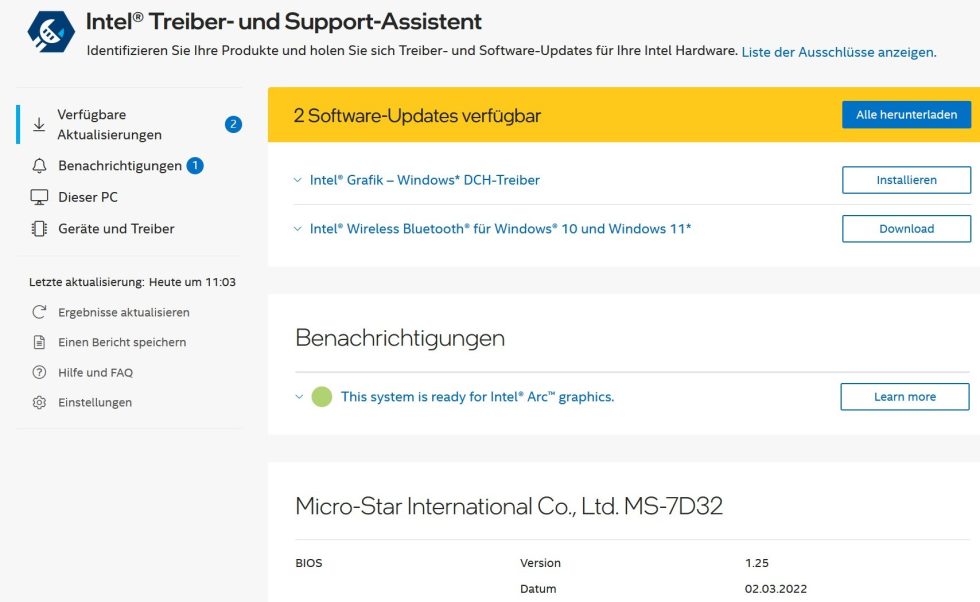

I dedicate a separate paragraph on the first page to the drivers on purpose. If you have implemented the microcode correctly, even Intel’s driver wizard recognizes the card and selects / installs the currently best driver. In our case, even a brand-new DCH driver from March 03 (see also GPU-Z next page).

The installation is rather unspectacular, but I have also documented here for the curious how the setup of the new drivers might turn out later, namely like this:

The gpu is, well, a bit bitchy, but that’s because of the drivers, as the UHD 770 showed very similar behavior. Due to these crashes, the decision to temporarily remove Metro Exodus from the benchmark suite because of the Ukraine war was also much easier for me. Far Cry 6 only ran with extreme graphics errors (on all Intel solutions) and Vulkan cannot be activated in WWZ. That’s why I tested this game with DirectX 11. But there were still enough games left that were running. Not to mention it again later: the edge flickering is really extreme in places, Intel still has to work hard on the drivers. This also applies to transparent textures, where ugly misrepresentations occurred again and again.

Except for these criticisms, I didn’t even really get stuck in the games that were running, at least. There were no crashes during the game, despite many runs. At least that’s a start.

- 1 - Intro, technical data, test system, drivers

- 2 - Unboxing, features and functionality

- 3 - Teardown: PCB, components and cooler

- 4 - Borderlands 3 (1280 x 720, DX12)

- 5 - Control (1280 x 720, DX12)

- 6 - Control (1920 x 1080, DX12)

- 7 - Horizon Zero Dawn (1280 x 720, DX12)

- 8 - Shadow of the Tomb Raider (1280 x 720, DX12)

- 9 - Shadow of the Tomb Raider (1920 x 1080, DX12)

- 10 - Wolfenstein Youngblood (1280 x 720, Vulkan)

- 11 - Wolfenstein Youngblood (1920 x 1080, Vulkan)

- 12 - World War Z (1280 x 720, DX11)

- 13 - World War Z (1920 x 1080, DX11)

- 14 - Power consumption in detail

- 15 - Conclusion and final words

61 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Moderator

Moderator

Urgestein

Mitglied

1

Mitglied

1

Urgestein

1

Mitglied

1

Mitglied

1

Urgestein

1

Urgestein

Mitglied

1

Alle Kommentare lesen unter igor´sLAB Community →