Vorfreude ist die schönste Freude – sagt man zumindest. Auch wenn Intels DG1 von Anfang an als Einstiegskarte konzipiert und auch als solche beworben wurde, ein Mindestmaß an Features und Funktionalität kann man natürlich auch von so einem Zwerg erwarten. Vieles lässt sich gut nach oben skalieren, solange die Testkandidaten gut zu testen sind. Ich habe über einen guten Bekannten nun exklusiv die Möglichkeit gehabt, eines der wenigen Gesamtkunstwerke zumindest auf Zuruf und aus der Ferne zu analysieren, den Teardown zu wagen und Benchmarks zu versuchen. Torx works.

Wichtige Vorbemerkung

Da die mit dem Smartphone erzeugten Bilder dann bei näherer Betrachtung doch nicht ganz so smart aussahen, wie man es von meiner Webseite sonst eigentlich erwartet, habe ich die Bilder alle zunächst noch einmal etwas nachbearbeitet und vor allem die Kanten etwas entzerrt. Nur falls sich jemand wundert. Die Karte existiert wirklich und auch die Bilder sind alles Originale. Die Tests sind frisch, also von gestern, was auch das Datum in den Screenshots zeigt.

Mit der DG1 (Desktop Graphics 1) will Intel zunächst den massenkompatiblen Einsteigerbereich bedienen, was durch zum Sammeln von wertvollen Erfahrungen dienen kann. Man Nennt das Ganze dann Iris Xe MAX (Notebook) oder einfach auch nur Iris Xe (Desktop). Da diese Karte nicht einzeln verkauft werden wird, sondern für SI (Systemintegratoren) und OEMs gedacht ist, sind auch bei der kompatiblen Hardware gewisse Limits vorprogrammiert und sogar so gewollt. Genau deshalb schrieb ich ja auch oben “Gesamtkunstwerk”, denn die getestete Karte wurde in einem kompletten OEM-PC geliefert (und nur darin auch getestet).

Hier beginnt dann auch die Irrfahrt des interessierten Testers, denn diese DG1 läuft nur auf speziellen Motherboards mit Grafikausgang und mit wenigen, dafür ausgesuchten Intel-CPUs, die allesamt eine iGP besitzen müssen und nicht zum Übertakten geeignet ist. Damit verhindert man natürlich auch, dass einzelne, vorab verteilte DG1-Karten außerhalb des vorgesehenen Intel-Mikrokosmos getestet werden. Ich will noch nichts spoilern, aber auch das rettet die DG1 SDV (Software Development Vehicle) nicht.

Technische Daten, Temperaturen und Leistungsaufnahme

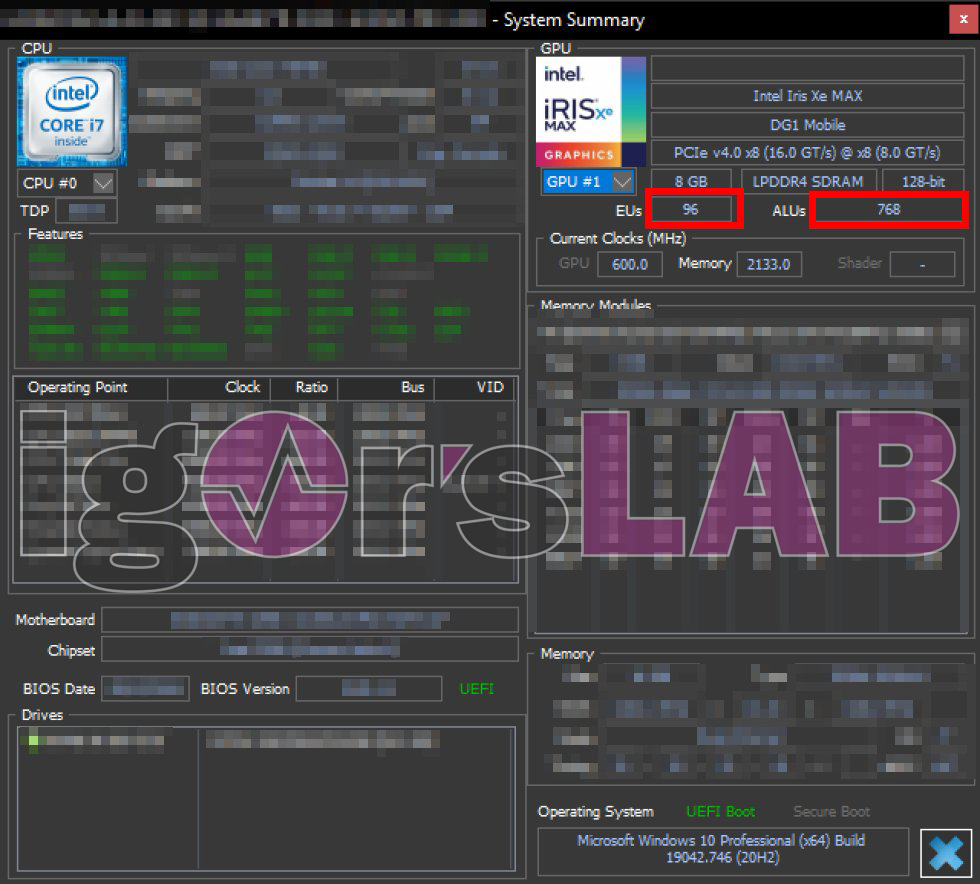

Interessanterweise ist die originale DG1 SDV von Intel der Mobile-Vollausbau mit 90 EU (Execution Units) und sie meldet sich auch in jedem der Programme dann brav als Intel Iris Xe MAX. Hergestellt wird der DirectX-12-Chip in Intels eigenem 10-nm-Super-Fin-Verfahren, das durchaus wettbewerbsfähig ist, denn die Zahlen der Nonenklatur sagen erst einmal nicht viel aus. In der hier getesteten Karte ergeben sich aus den 96 EU somit 768 FP32-Alus (“Shader”). Das ist sogar noch etwas mehr, als man für die auf 80 EU (640 ALUs) “beschnittene” Iris Xe eingeplant hat, die von Anbietern wie Asus gebaut werden soll.

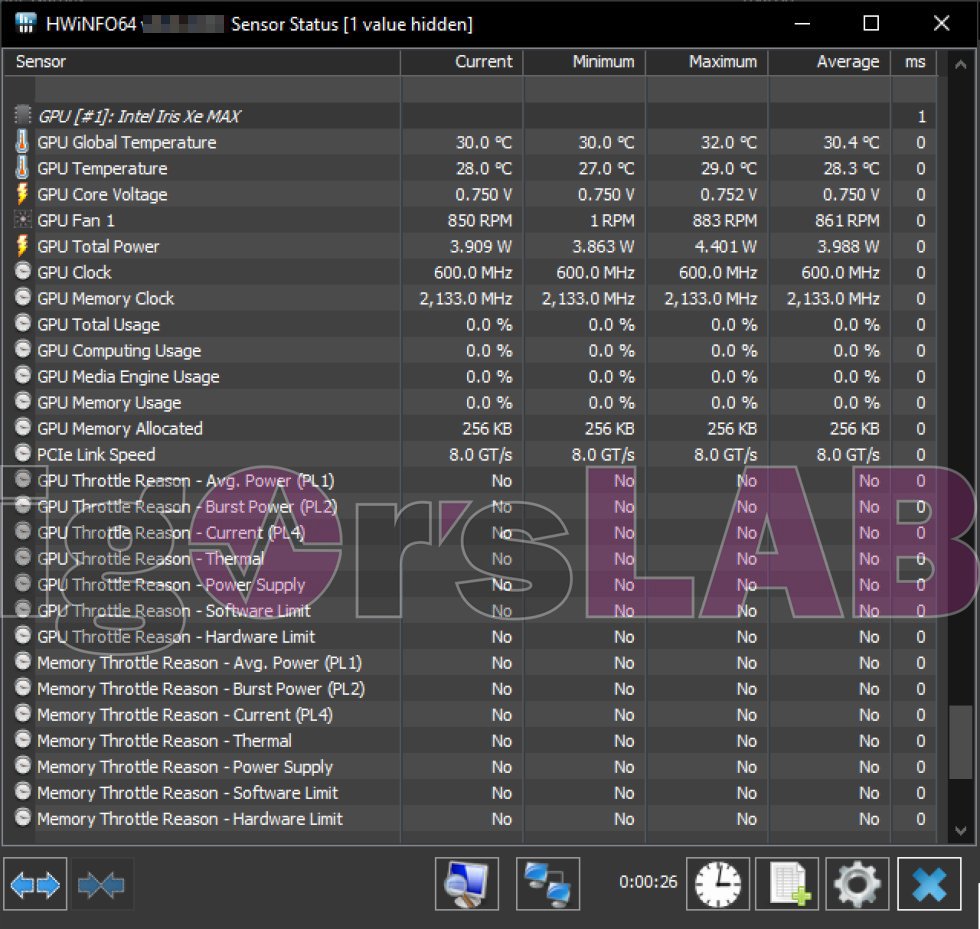

Insgesamt 8 GB LPDDR4 SDRAM mit 2133 MHz hängen an dem 128-Bit Speicherinterface und zumindest unterstützt man PCIe 4.0, wenn auch nur 8-fach angebunden. Auch das unterstreicht noch einmal die Herkunft aus dem Mobile-Sektor. Die OEM-Karten der Boardpartner werden wohl sogar mit nur 4 GB auskommen müssen. Schauen wir uns einmal die Daten aus dem Idle-Betrieb an. Bei niedrigen 600 MHz Taktrate liegt die Leistungsaufnahme des Chips (nicht der ganzen Karte!) bei knapp 4 Watt und die 850 U/min des Einzellüfters reichen für 30 °C GPU-Temperatur im Idle.

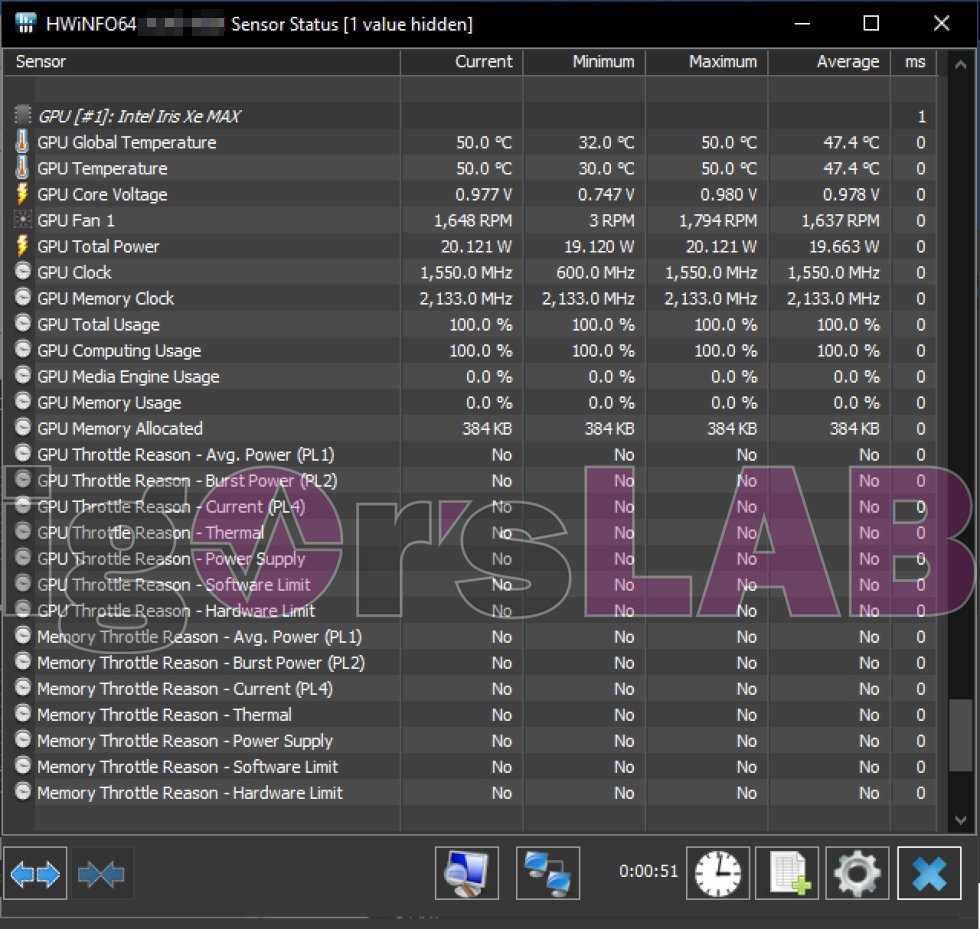

Mit Hilfe einer einfachen GPGPU-Anwendung konnte 100%-GPU-Last erzeugt werden. Die üblichen Stresstest-Programme streiken jedoch treiberbedingt (dazu komme ich gleich noch). Der Takt liegt nun bei 1550 MHz, mehr konnte auch bei Teillasten nie erreicht werden. Damit liegt die echte DG1 immerhin 100 MHz unter dem, was man im Vorfeld für den Mobil-Bereich angenommen hatte. Es bleibt zu vermuten, dass auch die Ableger von Asus oder Colorful nicht deutlich höher takten werden. Reichlich 20 Watt für die GPU only, sollten dann um die 27 bis 30 Watt für die gesamte Karte ergeben, denn auch der Lüfter hängt mit seinen bis zu 1800 U/min an der elektrischen Nabelschnur. 50 °C zeigen von einer eher aggressiven Lüfterkurve und dem Misstrauen, dass die Karte dann doch zu heiß werden könnte.

Die Speichertemperaturen lassen sich nicht direkt auslesen, werden aber zumindest intern wohl überwacht, denn so richtig gekühlt werden die vier 2-GB-Module von Micron nämlich nicht. Womit wir quasi beim Teardown angekommen wären. Das Testsystem muss ich aus Gründen des Quellenschutzes natürlich überall auspixeln, denn Intel wird kaum erfreut sein, wenn jemand Dritte wie mich mit Informationen füttert. Die Spuren verraten den Täter und so muss es reichen, wenn ich erwähne, dass es ein Core i7 Nicht-K-Modell auf einem Z390 mini-ITX Board war.

37 Antworten

Kommentar

Lade neue Kommentare

Veteran

Mitglied

Urgestein

Mitglied

Urgestein

Veteran

Urgestein

Urgestein

Mitglied

Mitglied

Moderator

Mitglied

Mitglied

Urgestein

Urgestein

Urgestein

Veteran

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →