Die heute veröffentlichte Version von NVIDIA DLSS 3.5 ist die neueste Iteration der DLSS-Technologie (Deep Learning Super Sampling) von NVIDIA und bringt eine Reihe von Verbesserungen und neuen Funktionen, um die Ray-Tracing-Erfahrung in Spielen und Anwendungen zu verbessern. Dabei hat sich NVIDIA ehrgeizige Ziele gesteckt, um auch die Akzeptanz der neuen Technologie zu vergrößern. Immer frei nach dem Motto: “Das Auge isst mit”. Womit wir beim Ziel des heutigen Artikel angelangt wären, denn ich werde mich heute (fast) ausschließlich mit der Optik beschäftigen.

Apropos Akzeptanz und Massentauglichkeit: Der heutige Artikel wurde bewusst mit einer GeForce RTX 4070 erstellt, denn eine GeForce RTX 4090 kann zwar deutlich mehr, sie ist aber mit Sicherheit nichts, was die breite Masse der Leser repräsentiert. Deshalb sind die Screenshots und Videos überwiegend in WQHD bzw. UWQHD erstellt worden, auch wenn Ultra-HD natürlich feiner ausschaut. Aber wir legen heute bewusst den Schwerpunkt auf das, was der durchschnittliche Anwender davon für sich selbst in der Praxis mitnehmen kann. Und da kommt auch schon mal DLSS im Performance Modus mit ins Spiel, der von der neuen Ray Reconstruction fast noch mehr profitiert als der Quality Mode.

Ray Reconstruction (RR)

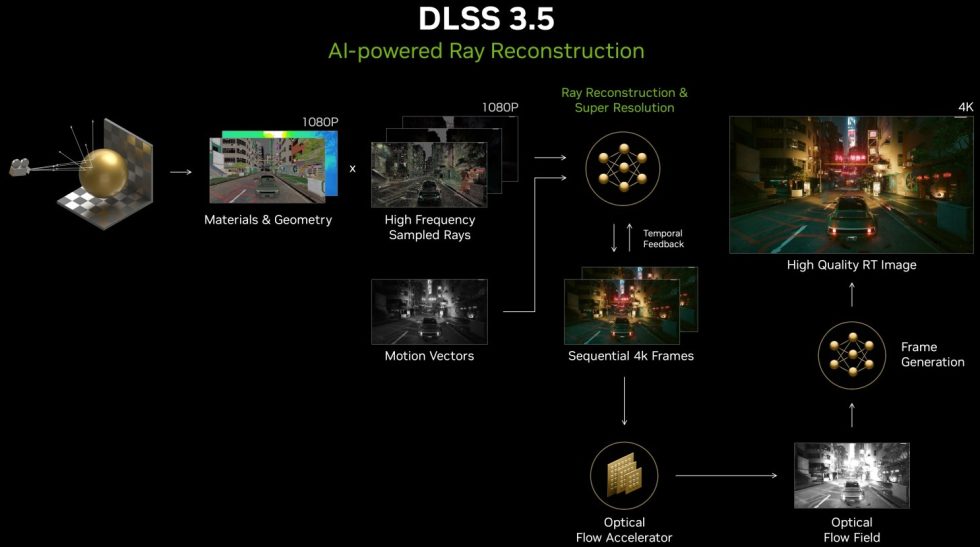

Ganz ohne etwas Theorie bzw. Hintergrundinformationen will ich Euch aber auch nicht im Regens stehen lassen, da müsst Ihr jetzt durch. Also noch einmal die wichtigste Frage: “Was ist Ray Reconstruction?”. Es handelt sich, kurz zusammengefasst, um ein neues KI-Modell, das höherwertige Bilder für intensive RT-Spiele und -Anwendungen erstellt. Es ersetzt handabgestimmte Denoiser durch ein von NVIDIA-Supercomputern trainiertes KI-Netzwerk, das höherwertige Pixel zwischen den abgetasteten Strahlen erzeugt, was die Spiele realistischer und schöner macht. Bei dieser Methode werden hochfrequente gesampelte Rays verwendet, um einen in 1080p berechneten Frame mit ausreichenden Informationen zu versehen, die später z.B. für eine Ausgabe in Ultra-HD benötigt werden. Dies wird durch die Hinzufügung von Vektorinformationen aus dem Spiel selbst erreicht

Traditionelle Denoiser (das kennen wir sogar aus Blender & Co.) können Probleme wie Geisterbilder, das Entfernen dynamischer Effekte und die Reduzierung der Qualität anderer Aspekte verursachen. Sie neigen auch dazu, zu viele Details unnötig zu verwischen oder im Gengensatz dazu nicht immer genug zu verwischen, wenn es doch nötig ist. Das ist eine Unzulänglichkeit, die zu nicht einheitlichen Lichteffekten führt. „Ray Reconstruction“ adressiert diese Probleme effektiv, indem es intelligentere Entscheidungen über die Verwendung von zeitlichen und räumlichen Daten trifft. Sie kann spezifische Ray-Tracing-Effekte identifizieren und andere Spielinformationen wie Bewegungsvektoren und Oberflächenfarben integrieren, um ein viel genaueres Endbild in Ray-Tracing-Spielen zu erzeugen. Dies führt zu einer deutlich verbesserten Klarheit, Genauigkeit und Schärfe der Ray-Tracing-Effekte.

Das KI-Modell wurde mit 5-mal mehr Daten als DLSS 3 trainiert, was es ermöglicht, klügere Entscheidungen über die Verwendung von zeitlichen und räumlichen Daten zu treffen und hochfrequente Informationen für eine überlegene Qualität der Hochskalierung zu erhalten. Im heutigen Beispiel mit Cyberpunk 2077 verbessert „Ray Reconstruction“ die Qualität und Klarheit von Reflexionen, macht die globale Beleuchtung genauer und die Beleuchtung dynamisch reaktionsfähiger. Die Funktion erkennt bestimmte Muster, die mit Reflexionen assoziiert sind, und hält das Bild stabil, während es genaue Pixel sammelt und benachbarte Pixel mischt, um hochwertige Reflexionen zu erzeugen. Für Entwickler vereinfacht die Technologie den Entwicklungsprozess, indem sie die Notwendigkeit manuell abgestimmter Denoiser elegant eliminiert. Für Spieler bedeutet dies eine verbesserte Bildqualität mit realistischeren und immersiveren Erfahrungen. Also eine Art Win-Win-Situation für die Spielentwickler und die Spieler. Und natürlich NVIDIA, das darf man nicht verschweigen.

Super Resolution und DLAA

Super Resolution ist eine Schlüsseltechnologie in der NVIDIA DLSS 3.5 Suite, die (was sonst?) auf den Fähigkeiten künstlicher Intelligenz (KI) basiert. Diese Technologie nutzt die Tensor Cores der GeForce RTX GPUs, um Bilder zu erschaffen, die eine gleichwertige oder sogar höhere Qualität als die native Auflösung aufweisen. Dadurch werden nicht nur die Bildraten beschleunigt und die Bildqualität verbessert, sondern auch die Reaktionsfähigkeit in Spielen und Anwendungen erhöht. Entwickler haben seit einiger Zeit auch die Möglichkeit, Super Resolution recht einfach und schnell in ihre Projekte zu integrieren, indem sie die entsprechenden DLSS SDKs und Plugins herunterladen. Ein weiterer Vorteil dieser Technologie ist ihre breite Verfügbarkeit, da sie zumindest auf allen RTX GPUs unterstützt wird.

DLAA, die Abkürzung für Deep Learning Anti-Aliasing, ist eine Technologie, die die KI-Techniken nutzt, die auch in DLSS vorhanden sind, um die Bildqualität zu verbessern. Im Gegensatz zu DLSS, das die Auflösung reduziert und dann ein KI-Modell verwendet, um das Bild wiederherzustellen, arbeitet DLAA direkt auf der nativen Auflösung, um die Kantenglättung zu verbessern. Dies bedeutet, dass es die Bildrate nicht erhöht, sondern tatsächlich ein wenig Leistung kosten kann, um eine höhere Bildqualität zu erzielen. Man kann also DLSS oder DLAA benutzen, nie aber beides Gleichzeitig, da der Ansatz ein komplett anderer ist.

DLAA ist besonders nützlich in Szenarien, in denen die Bildrate bereits sehr hoch ist und die Nutzer bereit sind, einige Frames pro Sekunde (fps) zu opfern, um eine verbesserte Bildqualität zu erzielen. Es ist jedoch zu beachten, dass Spiele diese Technologie explizit unterstützen müssen, um die Vorteile von DLAA nutzen zu können. Diese Technologie ist ein Teil der neuesten Aktualisierung von NVIDIAs DLSS 3.5 und ist darauf ausgelegt, die visuelle Qualität von Spielen zu verbessern, indem sie die Kantenglättung signifikant verbessert, ohne die native Auflösung zu reduzieren. Dies führt zu Bildern, die schärfer und detaillierter sind und mit weniger visuellen Artefakten wie “Ghosting” negativ beeinflusst werden.

Frame Generation und NVIDIA Reflex

Diese Technologien arbeiten zusammen, um die Leistung zu steigern und das Gameplay reaktionsfähiger zu machen. Die Frame Generation nutzt die Leistung der NVIDIA Ada Lovelace GPU Tensor Cores und des Optical Flow Accelerators. Doch zu diesen Technologien haben wir ja bereits ausführlich berichtet, das kann man alles noch einmal nachlesen, ohne dass ich den heutigen Artikel immens aufblähen muss.

Verfügbarkeit und Integration

Kleine Randbemerkung, die uns NVIDIA immer mit in die Brotdose packt: Immerhin über 330 veröffentlichte Spiele und Anwendungen unterstützen mittlerweile NVIDIA DLSS, darunter sind über 40, die nun auch DLSS 3.5 unterstützen. Das NVIDIA Streamline SDK erleichtert den Programmierern die Integration von DLSS 3.5 und umfasst Super Resolution sowie DLAA (was für alle RTX-GPUs verfügbar ist), sowie Frame Generation für die Ada-Karten. und die Ray Reconstruction, die ebenfalls für alle RTX-GPUs verfügbar ist.

Entwickler, die bereits DLSS 2 mit dem NVIDIA Streamline SDK integriert haben, sind fein raus, denn es ist dann nur noch ein winziger Schritt, um DLSS 3 und seine verschiedenen Komponenten zu integrieren. Das Streamline SDK ist eine offene Quer-IHV-Lösung, die die Integration der neuesten NVIDIA- und anderer unabhängiger Hardware-Hersteller-Super-Resolution-Technologien in Anwendungen und Spiele vereinfacht. Es unterstützt eine Vielzahl von Technologien, darunter DLAA, NVIDIA Image Scaling (NIS), NVIDIA Real-Time Denoisers (NRD), DLSS Ray Reconstruction, NVIDIA Reflex und DLSS Frame Generation.

Und weil sich immer so viele über das angeblich so proprietäre Cyberpunk 2077 als neues Crysis beschweren: Die Unreal Engine 5.2 unterstützt mittlerweile auch DLSS 3. Die Unreal Engine ist ein gern genutztes Werkzeug für die Erschaffung von Echtzeit-3D-Inhalten, also interaktive Erlebnisse und immersive virtuelle Welten. Wie das Ganze dann qualitativ in der UE 5.x aussehen wird, bleibt natürlich noch offen, aber dass es sogar ein einfach zu nutzendes Plugin für die UE gibt, lässt das Beste hoffen.

130 Antworten

Kommentar

Lade neue Kommentare

Mitglied

Mitglied

Veteran

Mitglied

Moderator

Mitglied

Moderator

Urgestein

Urgestein

Urgestein

Mitglied

Mitglied

1

Veteran

Veteran

Mitglied

Mitglied

Mitglied

Mitglied

Alle Kommentare lesen unter igor´sLAB Community →