Palit geht diesmal bei der neuen Palit RTX 3080 Ti GameRock 12GB rein optisch sehr eigene Wege. Ob die einem Eispanzer (Kristall-Design) nachempfundene RGB-Disko-Beleuchtung an der Front wirklich jedem gefällt, sei jetzt mal dahingestellt. Aber es ist ein sehr auffälliges Design, das polarisiert. Das allein ist ja schon eine Existenberechtigung. Die einzige Einschränkung für meinen neutigen Test: Da es nur wenige rotierende Muster gibt und ich auch den anderen Kollegen die Originalkarte überlassen möchte, muss der Teardown auch bei dieser Karte leider entfallen. Das ist sicher schade, aber wichtiger Bestandteil des Deals, um diese Karte zu bekommen.

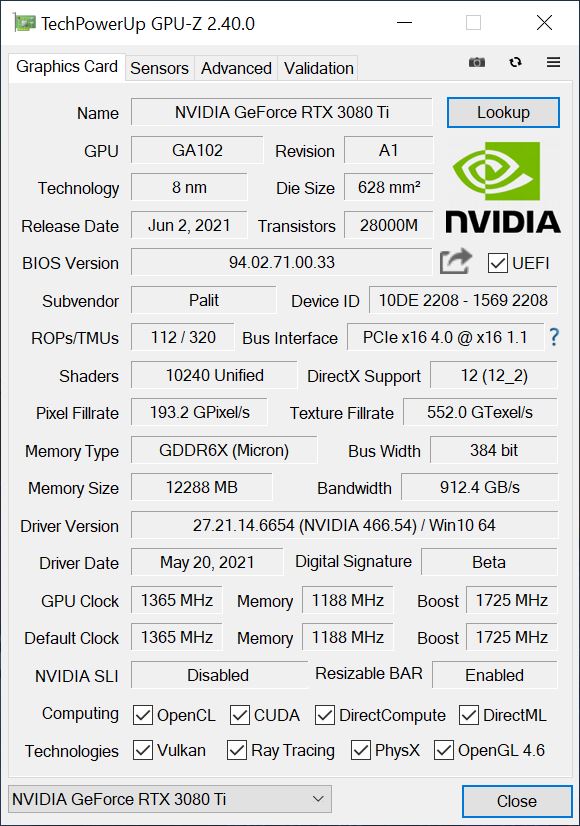

Diese Grafikkarte besitzt das übliche GeForce Feature-Set der aktuellen Ampere-Generation. Das Herzstück der GeForce RTX 3080 Ti ist der GA102-225 Grafikprozessor. Er basiert auf Samsungs speziell für NVIDIA entwickeltem 8-nm-Prozessknoten und verfügt über insgesamt 28 Milliarden Transistoren. Den kennen wir ja schon vom letzten Jahr. Er misst knapp 628 mm², was ihn zum zweitgrößten jemals produzierten Gaming-Grafikprozessor direkt unter dem Turing TU102 Grafikprozessor macht.

Für die GeForce RTX 3080 Ti hat NVIDIA immerhin 80 SM-Einheiten auf seinem Flaggschiff aktiviert, was zu insgesamt 10240 CUDA-Kernen führt. Zusätzlich zu den CUDA-Kernen ist NVIDIAs GeForce RTX 3080 Ti auch mit RT-Kernen der nächsten Generation (Ray-Tracing), Tensor-Kernen und den neuen SM- oder Streaming-Multiprozessoreinheiten ausgestattet. Was den Speicher betrifft, so ist die GeForce RTX 3080 Ti mit 12 GB GDDR6X Speicher ausgerüstet, der Speichergeschwindigkeiten von 19,0 Gbps liefern kann. Zusammen mit einem 384 Bit Interface wird dies eine kumulative Bandbreite von 912,4 Gbps liefern.

Optik und Haptik

Die Formensprache hatten wir ja schon. Die Leichtmetallabdeckung sieht gut aus, aber das mit der eisigen Kunststoff-Beplankung samt RGB-Stadionbeleuchtung muss man wirklich mögen. Die Palit RTX 3080 Ti GameRock 12GB wiegt 1552 Gramm und ist damit deutlich schwerer als die Referenzkarte. Sie ist mit ihren satten 30 cm auch länger, stattliche 12,5 cm hoch (Einbauhöhe ab PEG) und dazu 5.5 cm dick (2.5-Slot-Design), wobei noch eine Backplate und das PCB mit insgesamt fünf weiteren Millimetern dazukommen.

Das, was an der Oberseite wie ein kleiner Switch für ein Dual-BIOS aussieht, ist auch einer und zwar für ein Performance und ein Silent-BIOS. Ich werde heute ausschließlich das Performance-BIOS testen, jedoch an den relevanten Stellen auf die Unterschiede hinweisen. Damit wäre das dann auch geklärt, denn so extrem sind die Unterschiede gar nicht. Ich habe es lieber kühler und schneller.

Versorgt wird der grafische Ziegelstein samt Illumination gleich über drei standesübliche 8-Pin-Buchsen, also alles wie bekannt und gehabt, wenn eine Karte 400 Watt (optional bis 440 Watt) Power Limit besitzt. Wir sehen hier auch die vertikale Ausrichtung der Kühllamellen und die Platinenverstärkung in Form einer Backplate und eines Rahmens. Drei 9-cm-Lüfter sorgen für den nötigen frischen Wind bei der Kühlung, jedoch machen die sehr unregelmäßig geformten Öffnungen des plastischen Eispanzers aerodynamisch keinen Sinn, eher im Gegenteil. Aber dazu kommen wir später noch.

Die Slot-Blende ist wabenörmig gelöchert, trägt 1x HDMI 2.1 und drei aktuelle DP-1.4-Anschlüsse. Die USB Type C Buchse fehlt hingegen. Mehr zum Aufbau, dem Kühler und der Bestückung muss ich Euch diesmal leider schuldig bleiben, denn das Auseinandernehmen war ja leider tabu. Aber man sieht ja auch so, was hier geht (oder auch nicht).

Technik

Während der Basistakt mit 1365 MHz angegeben wird, liegt der Boost-Takt bei 1725 MHz (FE bei 1665 MHz), der sogar erreicht wird. Die Karte setzt auf 12 GB GDDR6X mit 19 Gbps, aber das hatten wir ja schon. Die restlichen Eckdaten entnehmen wir bitte dem GPU-Z Screenshot…

… und der tabellarischen Übersicht (wobei die Werte von NVIDIAs RTX 3080 Ti FE in Klammern gesetzt wurden).

| GeForce RTX 3070 | GeForce RTX 3080 | GeForce RTX 3080 Ti |

GeForce RTX 3090 | |

|---|---|---|---|---|

| GPU | GA104-300 | GA102-200 | GA102-225 |

GA102-300 |

| Process Node | Samsung 8 nm | |||

| Die Size | 395.2 mm2 | 628.4 mm2 | ||

| Transistoren | 17.4 Mrd. | 28 Mrd. | ||

| CUDA Cores | 5888 | 8704 | 10496 | |

| TMUs/ROPs | TBA | 272 / 96 | 320/112 |

TBA |

| Tensor/RT | 184 / 46 | 272 / 68 | 320 / 80 | 328 / 82 |

| Basis-Takt |

1500 MHz | 1440 MHz | 1365 MHz |

1400 MHz |

| Boost-Takt |

1730 MHz | 1710 MHz | 1725 (1665) MHz |

1700 MHz |

| Speicher | 8 GDDR6 | 10 GB GDDR6X | 12 GB GDDR6X | 24 GB GDDR6X |

| Interface | 256-bit | 320-bit | 384-bit | 384-bit |

| Durchsatz | 14 Gbps | 19 Gbps | 19 Gbps |

19.5 Gbps |

| Bandbreite | 448 Gbps | 760 Gbps | 912.4 Gbps |

936 Gbps |

| TGP | 220W | 320W | 400 (350) W |

350W |

| Launch | 15.10.2020 | 17.09.2020 | 02.06.2021 |

24.09.2020 |

- 1 - Einführung und technische Details

- 2 - Testsystem und Methodik

- 3 - Gaming Performance

- 4 - Effizienz und Leistungsaufnahme beim Gaming

- 5 - Leistungsaufnahme, Spannungen und Normeinhaltung

- 6 - Lastspitzen und Netzteil-Empfehlung

- 7 - Taktraten und Temperaturen

- 8 - Lüfter und Geräuschemission ('Lautstärke')

- 9 - Übersicht, Zusammenfassung und Fazit

31 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Urgestein

Mitglied

1

Urgestein

1

Urgestein

Moderator

Veteran

Neuling

Urgestein

Neuling

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →