Messsystemanalyse (MSA) für Nvidia LDAT

Wenn es um das Messen von Latenzen und den damit verbunden Nvidia-eigenen Entwicklungen wie Reflex geht, sollte man schon mal kritisch nachschauen. Schließlich werden die Latenzen mit einem von Nvidia entwickeltem Tool wie LDAT gemessen. An der Stelle könnten jetzt die Ultra-Kritiker ihren großen Auftritt bekommen. Alles anzweifeln, insbesondere, wenn der ein oder andere einen Groll gegen Nvidia hegt. Für alle diese Kritiker habe ich extra was vorbereitet.

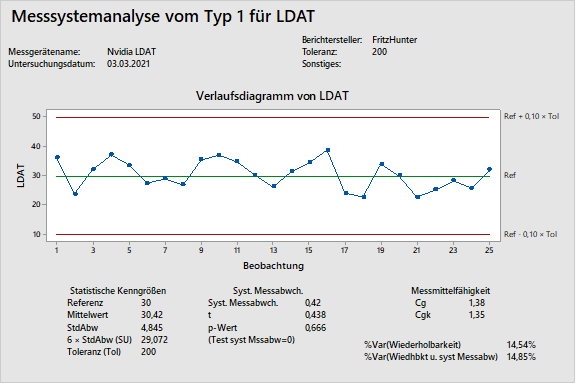

Da ich in der Automobilindustrie arbeite, ist eine Messung im Zweifel nur dann glaubwürdig, wenn eine MSA vorliegt. Alles andere würde mich im Zweifel nicht tangieren. Hier ist es das Ziel, nachzuweisen, dass das eingesetzte Messmittel fähig ist. Es soll schließlich das messen, was man messen will. Und das reproduzierbar! Sonst gilt: Wer viel misst, misst Mist!

Was genau ist eine MSA?

Vereinfacht erklärt, zeigt eine MSA auf, ob die gemessenen Werte die Realität ausreichend wiedergeben. Mittels einer MSA wird sichergestellt, dass die Messungen egal wo auf der Welt, mit dem gleichen Messsystem – reproduziert werden können. Wer mehr wissen will: klick hier! Hierzu habe ich zuerst geprüft, wie sich LDAT auf unterschiedliche Messpositionen im Spiel Call of Duty Modern Warfare auswirkt. Einflüsse durch Bildberechnungen prüfen und ausschließen. Multiplayer-Karte Hackney Yard!

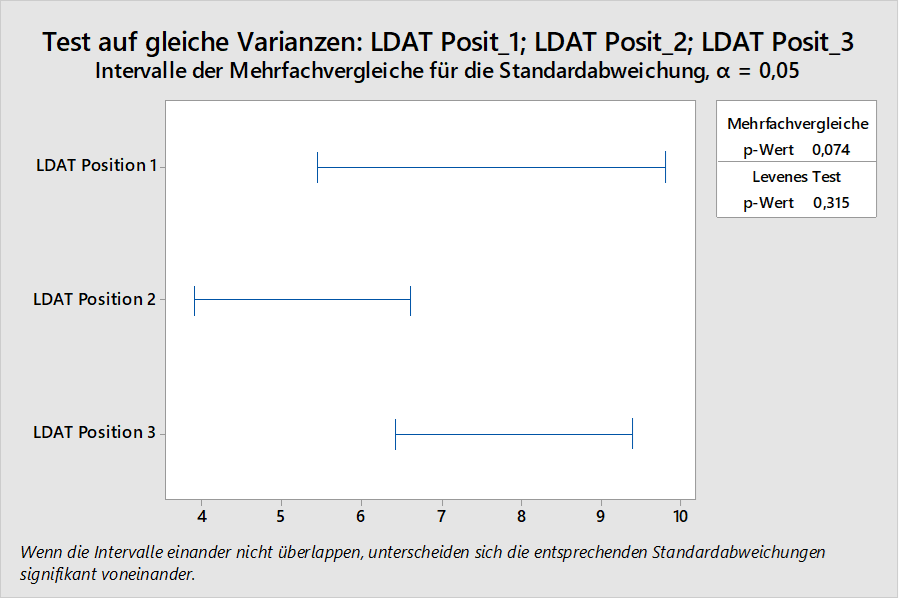

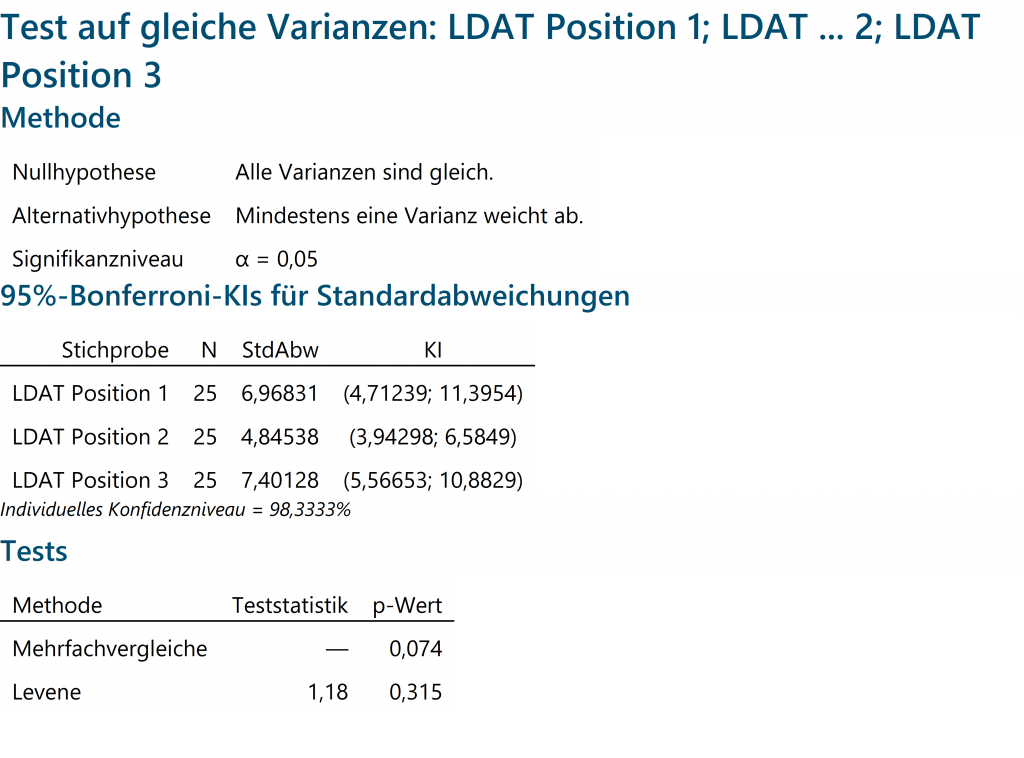

Die gemessenen Werte habe ich dann mit einer ANOVA untersucht. Die Nullhypothese: Alle Varianzen sind gleich! Wenn diese sich bestätigt, dann bedeutet das, dass die Reproduzierbarkeit gegeben ist. Egal wo man die Messungen im Spiel macht. Das bedeutet aber nicht, dass ihr die gleichen Messwerte wie ich erreicht. Warum das im Zweifel so ist, liegt an diversen anderen Faktoren. Beispielsweise, ob ein CPU oder GPU Limit vorliegt usw. Das Thema CPU Limit merken wir uns mal. Da komm ich später nochmal drauf zu sprechen. Zum Auswerten der Daten nutze ich das Programm Minitab in der Version 18.

Der p-Wert ist größer 0,05. Somit hat sich meine Hypothese, dass alle Varianzen gleich sind, bestätigt. Nvidia LDAT kann reproduzierbar messen!

Die Messsystemfähigkeit für LDAT ist gegeben: Cgk ≥ 1,33

Wer dazu Fragen hat, der kann mich gerne über das Forum kontaktieren oder sich schlau machen. Hierzu findet man reichlich Lektüre im Internet. Es lohnt sich auch der Blick in Richtung SixSigma, um den Umgang mit statistischen Verfahren zu erlernen. Hier wurde ich bestens geschult und habe diverse Qualifikationen erworben.

Mal was in eigener Sache. Ich gehöre grundsätzlich auch zur Gruppe: „das zweifele ich an“! Aber nur rumheulen und unreflektierte Behauptungen aufstellen, bringt keinen weiter. Hinsetzen und Messen, das hilft, um Klarheit zu schaffen. Daher schönen Gruß an alle Hardcore-Kritiker: LDAT ist über jeden Zweifel erhaben!

54 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Veteran

Veteran

Moderator

Veteran

Mitglied

Moderator

Moderator

Veteran

Veteran

Moderator

Moderator

Urgestein

Moderator

Urgestein

Moderator

Urgestein

Veteran

Mitglied

Alle Kommentare lesen unter igor´sLAB Community →