Design für die Zukunft: Tensor-Kerne und DLSS

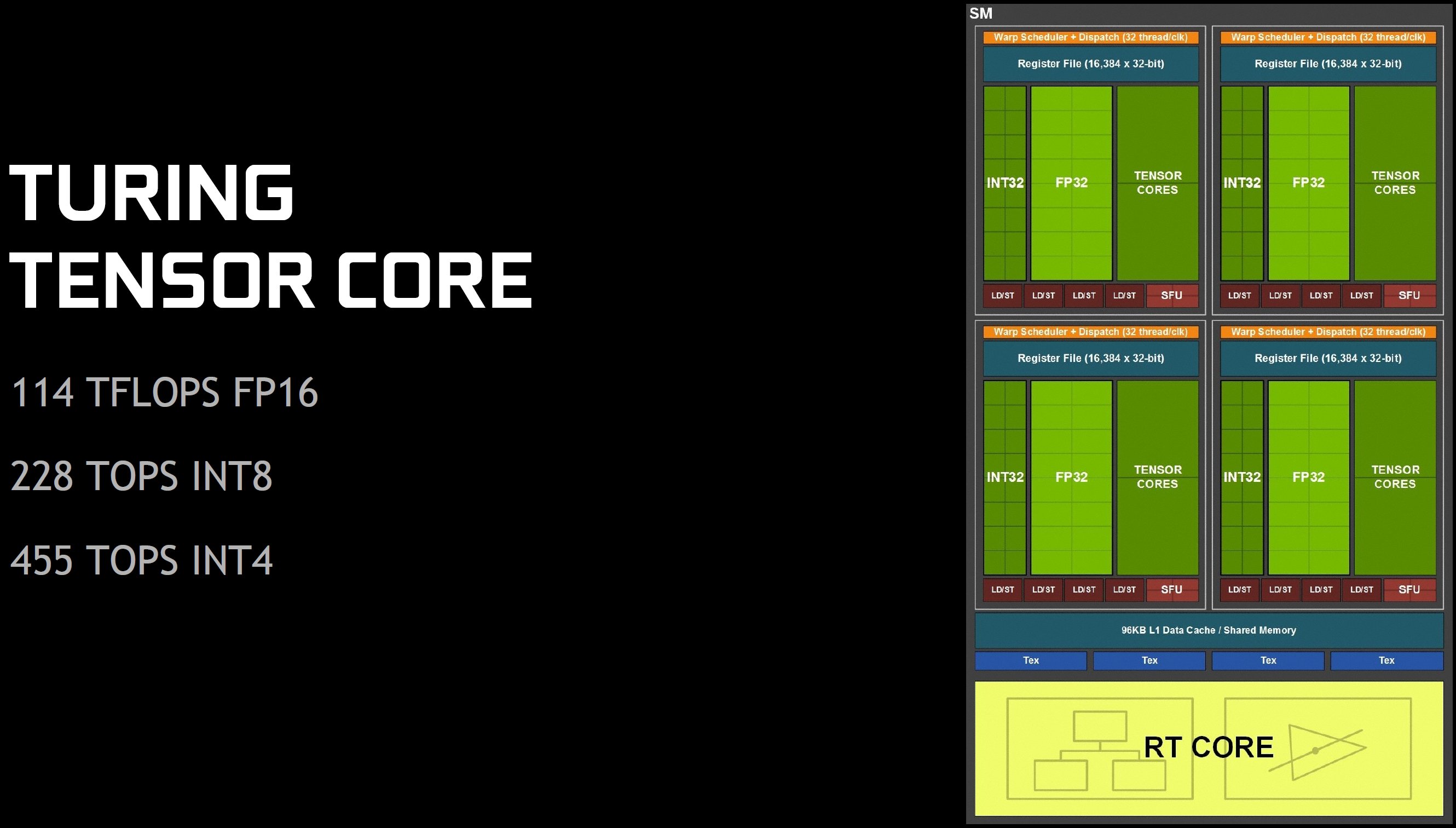

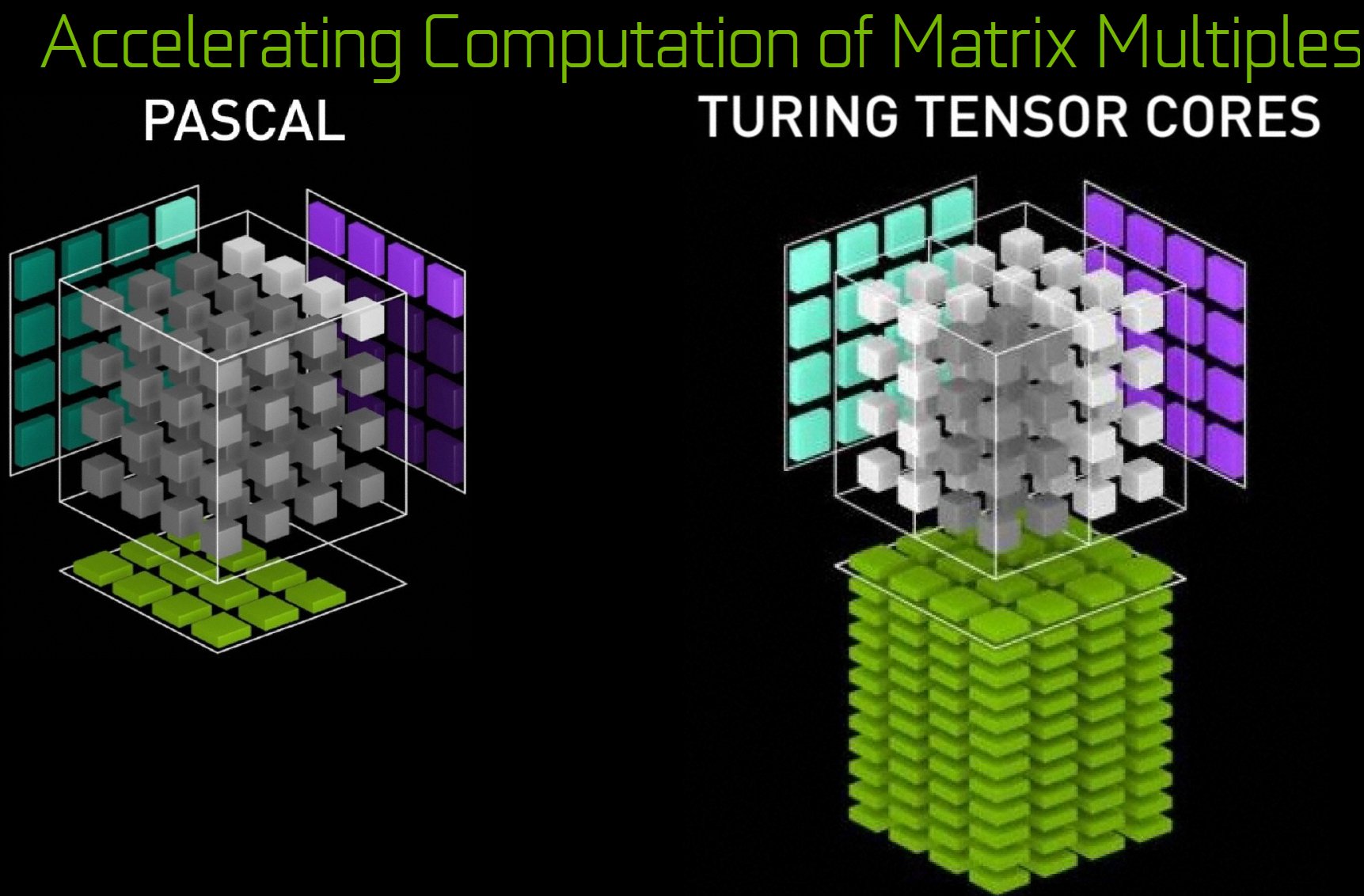

Obwohl die Volta-Architektur im Vergleich zu Pascal auch sonst voller bedeutender Änderungen steckte, war die Hinzufügung von Tensor-Kernen der wichtigste Hinweis auf den eigentlichen Zweck des GV100: die Beschleunigung von 4×4-Matrixoperationen mit FP16-Input, die die Grundlage für das Training und das Inferenzieren (Argumentation, um aus impliziten Annahmen explizite Aussagen zu machen) neuronaler Netze bilden. Wie der Volta SM besitzt Turing zwei Tensor-Kerne pro Quad oder acht pro Streaming-Multiprozessor. Der TU102 verfügt über weniger SMs als der GV100 (72 gegenüber 84) und bei der GeForce RTX 2080 Ti sind weniger SMs aktiviert als bei der Titan V (68 gegenüber 80).

So besitzt die GeForce RTX 2080 Ti nur 544 Tensor-Kerne, die Titan V immerhin 640. Die Tensor-Kerne des TU102 sind jedoch etwas langsamer: Sie unterstützen zwar FP32-Akkumulationsoperationen, wie sie für das Deep-Learning-Training verwendet werden, jedoch nur mit der halben Geschwindigkeit der FP16-Akkumulationsoperationen. Das macht natürlich Sinn, denn der GV100 wurde für das Training neuronaler Netze entwickelt, während der TU102 ein Gaming-Chip ist, der in der Lage ist, bereits trainierte Netze für das Inferenzieren zu nutzen.

Durch die gezielte Ausrichtung der FP16-, INT8- und INT4-Operationen werden weniger Transistoren benötigt, als durch den Aufbau breiter Wege für hohe Präzision. Auch die Performance profitiert von dieser Neuausrichtung, denn Nvidia behauptet, dass die Tensor-Kerne des TU102 bis zu 114 TFLOPS für den FP16-Betrieb, 228 TOPS INT8 und 455 TOPS INT4 liefern.

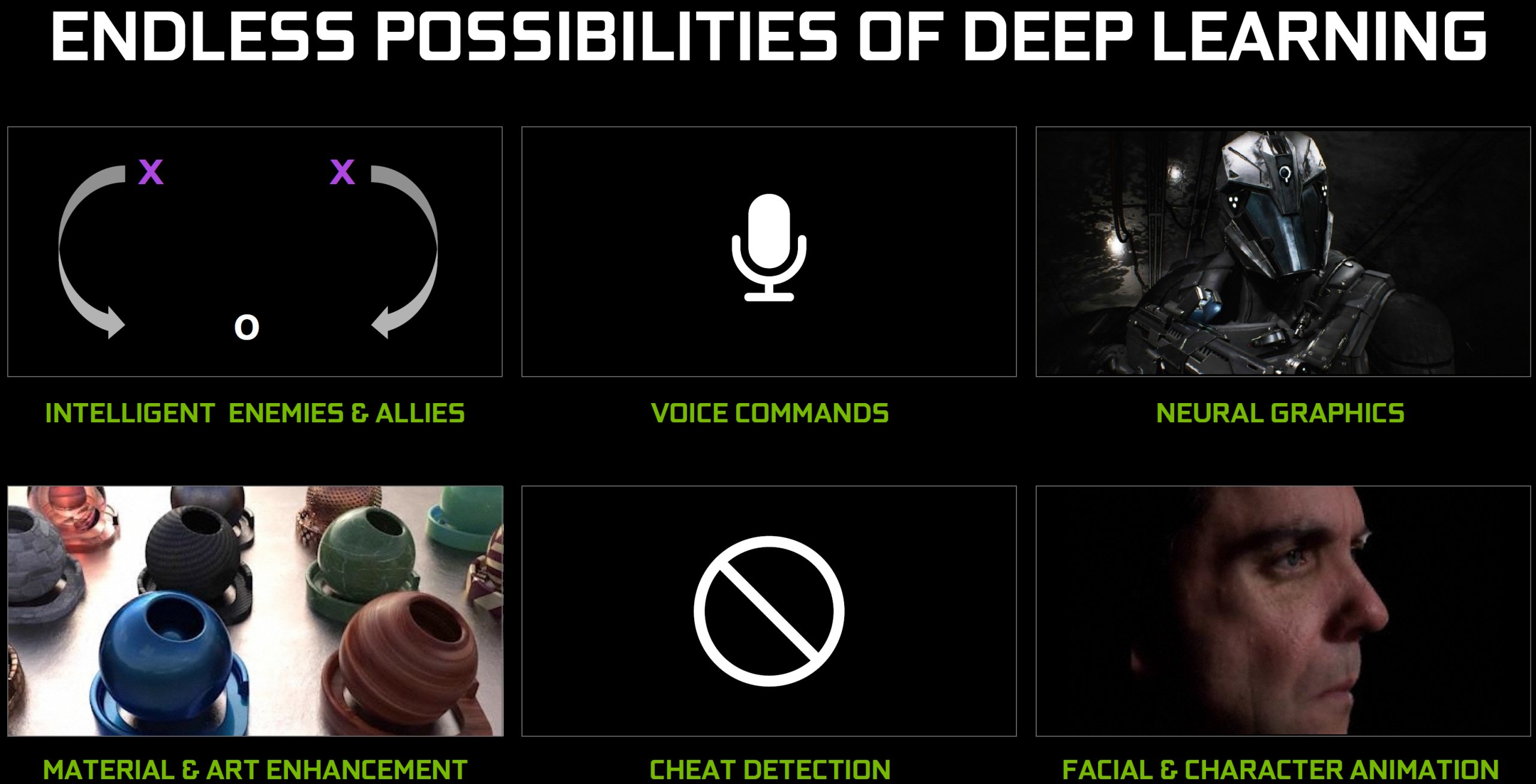

Die meisten von Nvidias aktuellen Plänen für die Tensor-Kerne betreffen jedoch neuronale Grafiken. Aber man plant auch einige andere Anwendungen aus dem Bereich des Deep-Learning auf Desktop-Grafikkarten. Intelligente Feinde zum Beispiel würden die Art und Weise, wie Spieler Endboss-Kämpfe angehen, völlig verändern. Sprachsynthese, Spracherkennung, Materialverbesserung, Cheat-Erkennung und Charakteranimation sind alles Bereiche, in denen KI bereits im Einsatz ist oder in denen Nvidia zumindest ordentliches Potenzial dafür sieht.

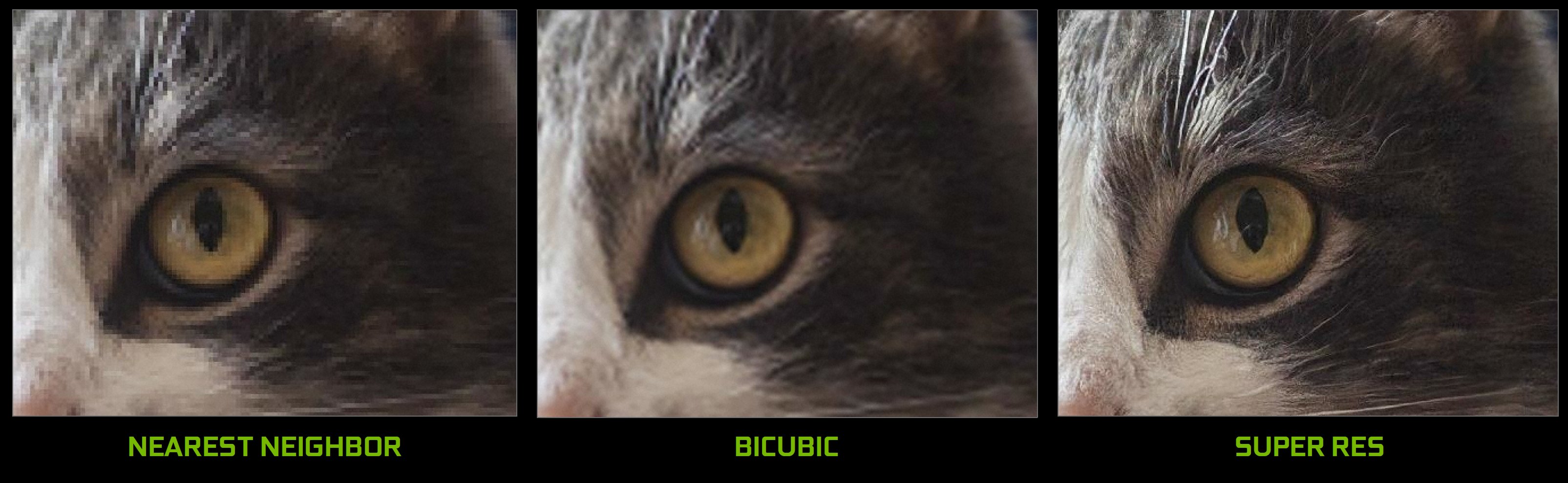

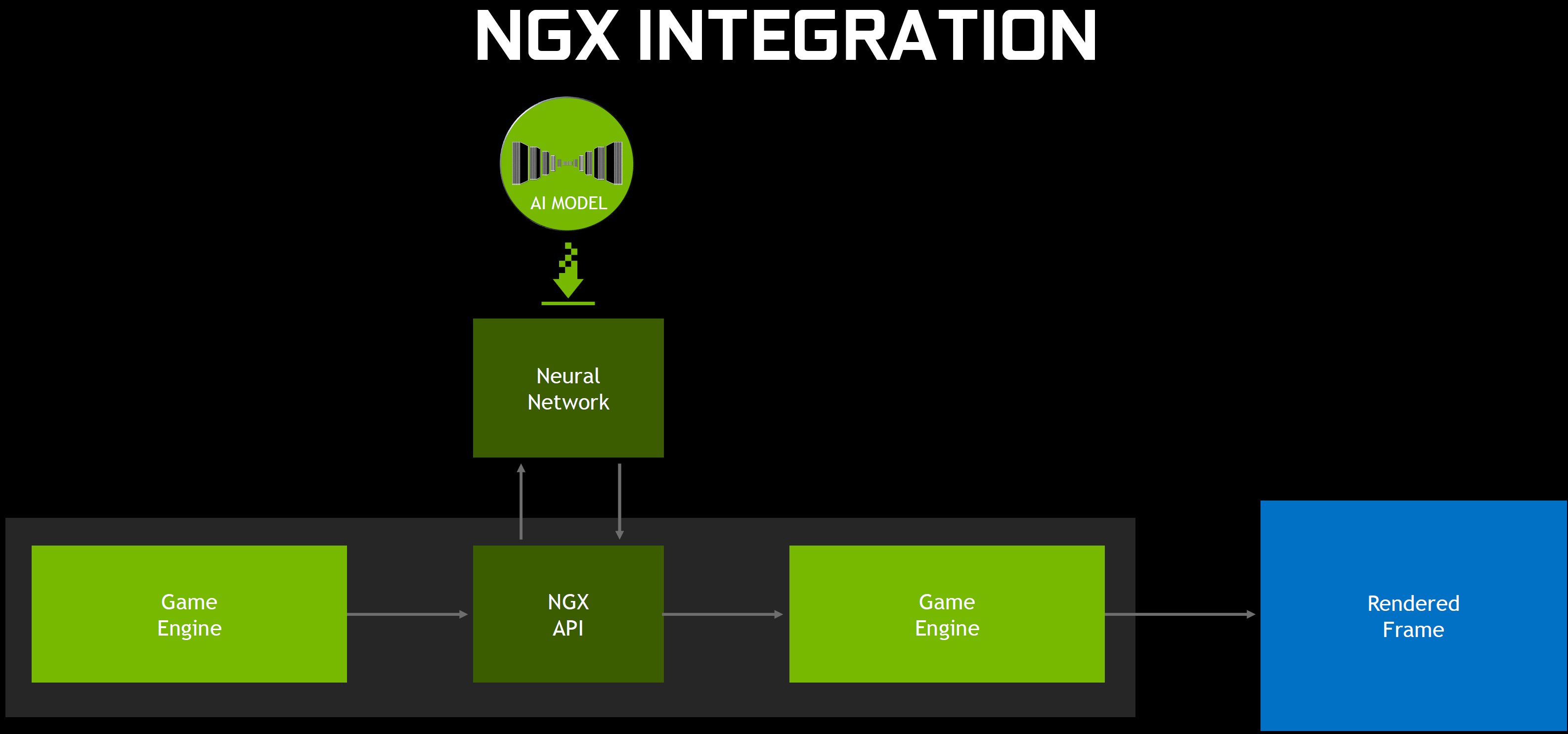

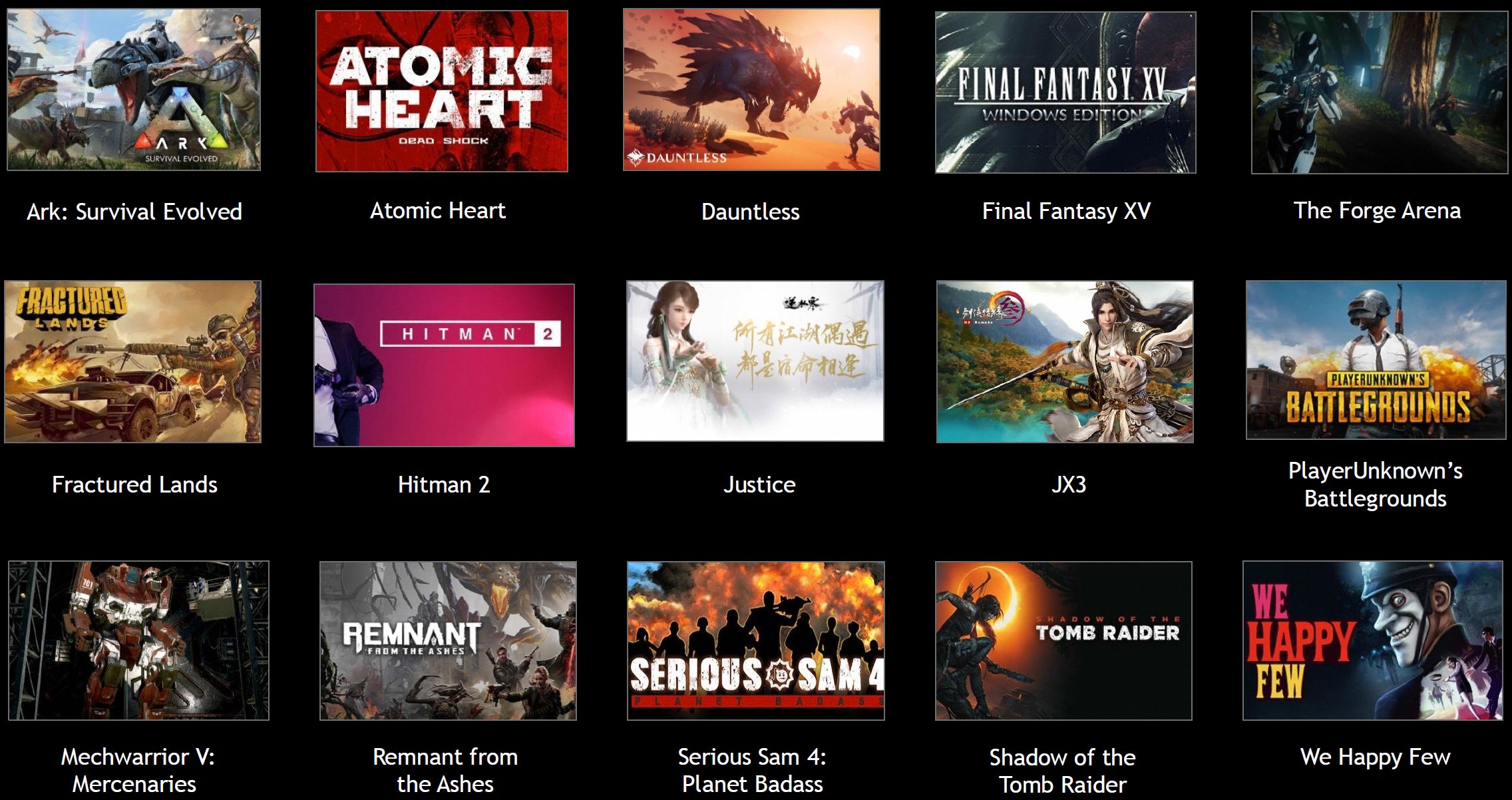

Aber natürlich steht auch Deep Learning Super Sampling (DLSS) im Mittelpunkt der GeForce RTX. Der Prozess, mit dem DLSS implementiert wird, erfordert Entwicklerunterstützung durch die NGX-API von Nvidia. Aber Nvidia verspricht, dass die Integration ziemlich einfach sei, und hat eine Liste von Spielen mit geplanter Unterstützung veröffentlich, um die Begeisterung der Softwareentwickler für das zu demonstrieren, was DLSS für die Bildqualität tun kann.

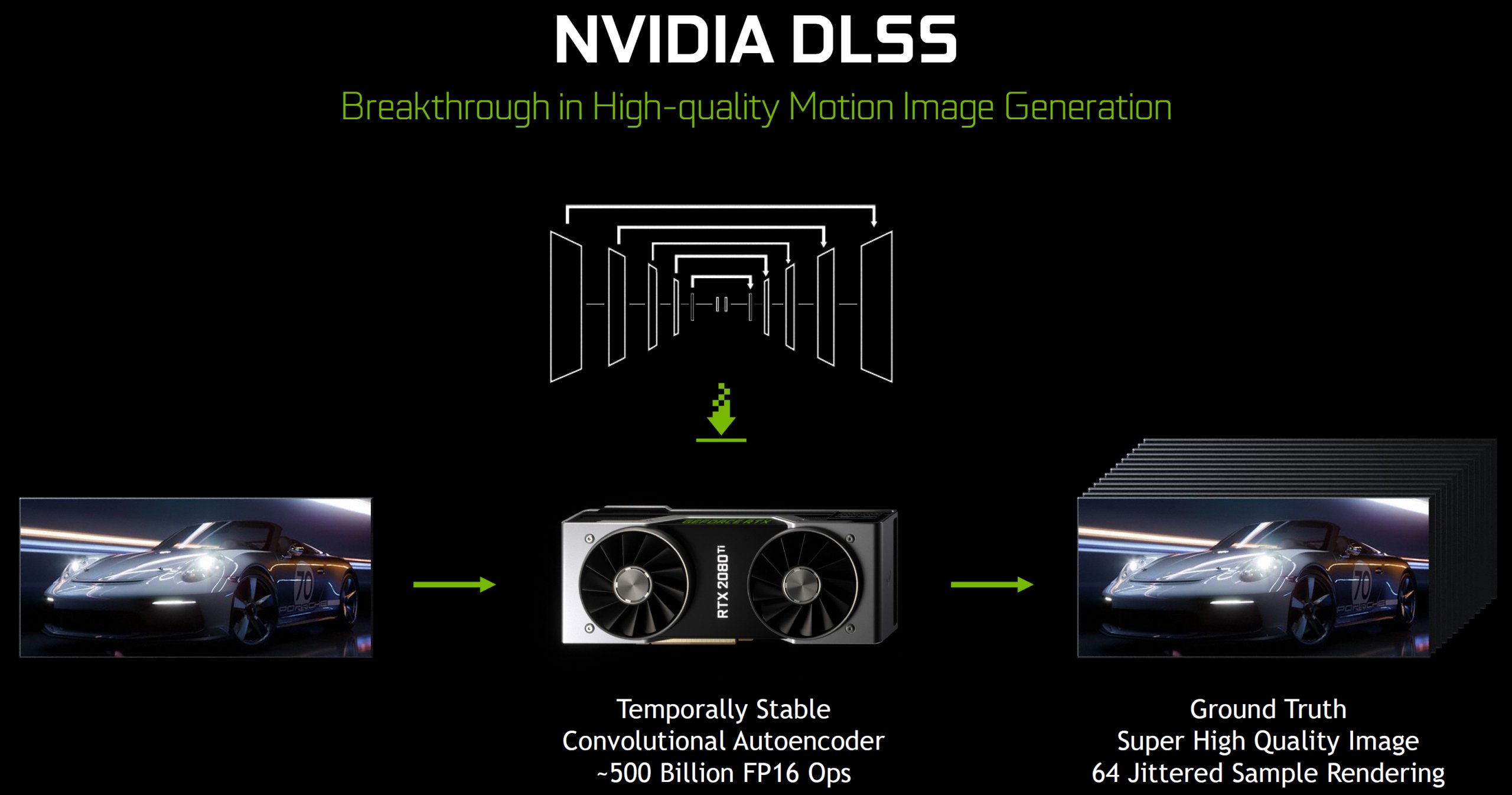

Vermutlich liegt das daran, dass das Aufwändigste an dieser Technik von Nvidia selbst realisiert bzw. durchgeführt wird. Das Unternehmen bietet die Erzeugung von Ground Truth Images an – die höchstmögliche Darstellungsqualität, die durch extrem hohe Auflösung, viele Samples pro Frame oder viele gemittelte Frames erreicht wird. Dann ist man in der Lage, ein KI-Modell mit dem 660-Knoten-DGX-1-basierten SaturnV-Server zu trainieren, um qualitativ minderwertige Bilder so nah wie möglich an die originalen Inhalte zu bringen.

Diese Modelle werden über den Nvidia-Treiber heruntergeladen und über die Tensor-Cores auf jeder GeForce RTX-Grafikkarte aufgerufen. Nvidia meint, dass jedes KI-Modell nur wenige Megabyte groß sein wird, was es relativ leicht macht, derartige Inhalte bei Bedarf (einmalig) nachzuladen. Wir hoffen nur, dass DLSS nicht explizit and GeForce Experience gebunden sein wird und somit einen Registrierungs- und Installationszwang schafft.

Doch lohnt sich der immense Aufwand für DLSS eigentlich? Zu diesem frühen Zeitpunkt ist dies schwer zu beurteilen. Wir haben ein Beispiel für DLSS aus Epics Infiltrator-Demo gesehen und es sah großartig aus. Aber es ist unklar, ob Nvidia in jedem Spiel das gleiche Idealbild an Ergebnissen erzielen kann, unabhängig von Genre, Tempo, Umgebungsdetails und so weiter. Was wir wissen, ist, dass DLSS ein Realtime-Convolutional-Auto-Encoder ist, der auf 64-mal gesampelten Bildern trainiert wurde.

Er erhält über die NGX-API einen Frame mit normaler Auflösung und liefert eine höherwertige Version dieses Frames zurück. Auf 2x DLSS gesetzt, so meinte Nvidia, kann es das Äquivalent von 64x Super-Sampling erreichen, während man die Transparenz-Artefakte und Unschärfen, die manchmal von zeitlichem Anti-Aliasing erzeugt werden, komplett umgeht.

Kurz nach der Ankündigung auf der Gamescom begann Nvidia damit, die Leistungsdaten der GeForce RTX 2080 mit DLSS gegenüber der GeForce GTX 1080 zu vergleichen. Diese Ergebnisse ließen es so aussehen, als würde man durch DLSS höhere FPS erhalten. In Wirklichkeit glauben wir, dass das Unternehmen versucht zu suggerieren, dass eine GeForce RTX 2080 mit DLSS und ohne aktiviertem Anti-Aliasing die gleiche Bildqualität wie die Vorgängergeneration mit aktiviertem Anti-Aliasing und ohne DLSS erreicht und es nur fair sei, dies auch so zu vergleichen. Nun ja.

Nvidia hat angekündigt, dass 15 Spiele bereits mit DLSS-Unterstützung in Vorbereitung seien, darunter bestehende Titel wie Ark: Survival Evolved, Final Fantasy XV und PlayerUnknown’s Battlegrounds, sowie einige andere, die noch nicht veröffentlicht wurden.

- 1 - Einführung und Vorstellung

- 2 - TU102 + GeForce RTX 2080 Ti

- 3 - TU104 + GeForce RTX 2080

- 4 - TU106 + GeForce RTX 2070

- 5 - Performance-Anstieg für bestehende Anwendungen

- 6 - Tensor-Kerne und DLSS

- 7 - Ray Tracing in Echtzeit

- 8 - NVLink: als Brücke wohin?

- 9 - RTX-OPs: wir rechnen nach

- 10 - Shading-Verbesserungen

- 11 - Anschlüsse und Video

- 12 - 1-Klick-Übertaktung

- 13 - Tschüss, Gebläselüfter!

- 14 - Zusammenfassung und Fazit

Kommentieren