TU102 – Der Grand-Turing

Der TU102-Chip im Herzen der GeForce RTX 2080 Ti ist mit seinen 754 Quadratmillimetern geradezu riesig. Seine 18,6 Milliarden Transistoren werden mit dem 12nm FinFET-Fertigungsprozess von TSMC realisiert, was angeblich eine leichte Dichteverbesserung gegenüber dem vorherigen 16nm-Prozess von TSMC ermöglichen soll. TSMC präsentiert auf der eigenen Webseite übrigens die 12nm-Technologie unter der gleichen Rubrik wie die 16nm-Technologie. Warum auch immer.

Dass Nvidias “große” Gaming-GPU gleichzeitig mit einer neuen Architektur eingeführt wird, ist hingegen neu. Aber Nvidia weiß sehr wohl, dass das Echtzeit-Raytracing mit reibungslosen Bildraten laufen muss, um Enthusiasten wirklich von der neuen Technologie zu begeistern. Den TU102 möglichst frühzeitig zu veröffentlichen war somit nur folgerichtig. Im Vergleich zum GP102, der größten Pascal-basierten GPU, die aktuell in einer Desktop-Grafikkarte verwendet wird, ist der TU102 von Nvidia nun um satte 60% größer und wartet mit einer um 55% höheren Transistoranzahl auf. Aber es ist damit trotzdem nicht der größte Grafikprozessor des Unternehmens.

Das Turing-Flaggschiff wird nämlich vom „alten“ GV100 sogar noch in den Schatten gestellt, einem 21,1 Milliarden Transistor-Giganten, der mit einer Größe von 815 mm² aufwarten kann. Diese GPU wurde 2017 mit Schwerpunkt auf Anwendungen in Rechenzentren eingeführt und findet sich immer noch auf der extrem teuren Titan V wieder. Der TU102 richtet sich allerdings an eine komplett andere Zielgruppe als der GV100 und verfügt daher auch über eine Anzahl anderer Features. Während Teile von Turing auf dem GV100 basieren, wurden andere Teile der Volta-Architektur, die entweder den Spielern keinen Nutzen bringen oder auf dem Desktop nicht kostengünstig herzustellen sind, bewusst entfernt.

So enthält beispielsweise jeder Streaming Multiprozessor (SM) von Volta 32 FP64-Kerne für schnelle Berechnungen mit doppelter Genauigkeit, was sich auf bis zu 2688 FP64-Kerne im GV100 aufaddiert. Diese sind jedoch in normalen Spielen nicht wirklich nützlich und sie verschlingen im Gegenzug viel Platz, so dass Nvidia davon lediglich zwei pro SM übrigließ. Infolgedessen beträgt die Doppelpräzisions-Rate des TU102 dann auch nur 1/32 seiner FP32-Leistung. Damit steht gerade noch so viel FP64-Compute-Leistung zur Verfügung, um die Kompatibilität mit der von ihr abhängigen Software aufrechtzuerhalten.

Ebenso wären die acht 512-Bit-Speichersteuerungen des GV100, die an vier Stacks des HBM2 angeschlossen sind, viel zu teuer geworden. Hier wird Nvidia sicher auch zu AMD geschielt und die Schwierigkeiten bemerkt haben, die man dort hatte, um die Radeons mit HBM2-Bestückung noch einigermaßen kostendeckend herzustellen (oder eben auch nicht). Der HBM2 wurden folglich durch GDDR6 ersetzt, was eine viel kostengünstigere Lösung ermöglicht, die immer noch in der Lage ist, ein großes Bandbreiten-Upgrade gegenüber Pascal-basierten Vorgängern durchzuführen und bei der auch die Modulverfügbarkeit deutlich höher ausfallen dürfte.

Ein kompletter TU102 Grafik-Prozessor besteht aus sechs Graphics Processing Clusters (GPCs), die jeweils aus einer Raster-Engine und sechs Texture Processing Clusters (TPCs) bestehen. Jeder TPC besteht aus einer PolyMorph-Engine (Fixed-Function Geometry Pipeline) und zwei Streaming Multiprozessoren (SMs). Auf der SM-Ebene finden wir jeweils 64 CUDA-Kerne, acht Tensor-Kerne, einen RT-Kern, vier Textureinheiten, 16 Lade-/Speichereinheiten, 256KB Registerdateispeicher, vier L0-Anweisungs-Caches und eine 96KB große, konfigurierbare L1-Cache/Shared-Speicherstruktur.

Multipliziert man das nun alles, erhält man einen Grafikprozessor mit 72 SMs, 4608 CUDA-Cores, 576 Tensor-Cores, 72 RT-Cores, 288 Textureinheiten und 36 PolyMorph-Engines. Dieses Konstrukt wird von zwölf 32-Bit-GDDR6-Speichercontrollern gespeist, die jeweils an einen 8-ROP-Cluster und 512KB L2-Cache angeschlossen sind, was am Ende einen aggregierten 384-Bit-Speicherbus, 96 ROPs und einen 6 MB großen L2-Cache ergibt. Liest sich viel und ist es auch.

Alles zusammengesetzt: GeForce RTX 2080 Ti

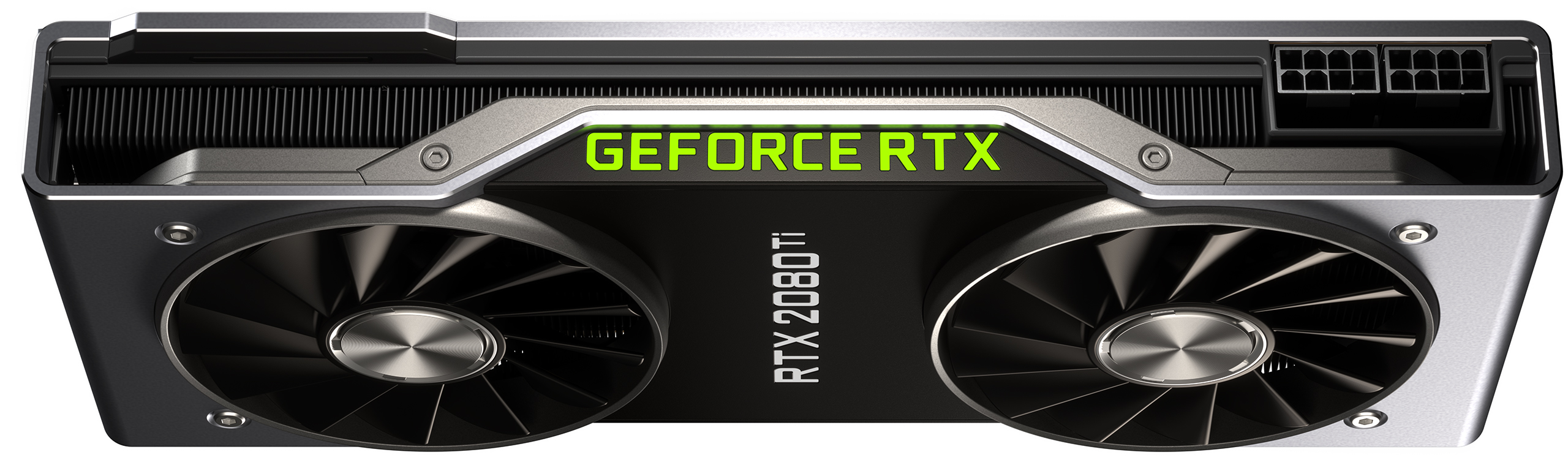

Der TU102 auf der GeForce RTX 2080 Ti ist jedoch kein voll ausgebauter Prozessor. Ob Nvidia neben der Quadro RTX 8000 auch noch Raum für ein Modell der Titan-Klasse lassen wollte oder die Erträge voll funktionsfähiger GPUs ab einem bestimmten Bin nicht mehr zufriedenstellend waren – bei der RTX 2080 Ti lässt man zwei der TPCs deaktiviert, was dann in einer Karte mit 4352 CUDA-Kernen, 544 Tensor-Kernen, 68 RT-Kernen, 544 Textureinheiten und 34 PolyMorph-Maschinen mündet.

Darüber hinaus wird einer der 32-Bit-Speichercontroller des TU102 abgeschaltet, wodurch ein aggregierter 352-Bit-Bus entsteht, der die Daten an 88 ROPs und 5,5 MB L2-Cache überträgt. Nvidia passt seine strategisch ausgestattete GPU an Microns MT61K256M32JE-14:A Speicher-Module an. Elf dieser Module sitzen auf dem PCB der GeForce RTX 2080 Ti und somit bleibt dann auch logischerweise ein Platz frei. Dennoch steigt die theoretische Spitzenbandbreite im Vergleich zur Vorgängergeneration aufgrund der höheren Datenrate des GDDR6 stark an: Bei 14 Gb/s auf einer 352-Bit-Schnittstelle sind es 616 GB/s. Im Vergleich dazu lieferte der GDDR5X mit 11 Gb/s auf der GeForce GTX 1080 Ti nur 484 GB/s.

Zumindest auf der Founders Edition-Karte kann der Basistakt von 1350 MHz bis zu einer typischen GPU-Boost-Rate von 1635 MHz springen, solange die GeForce RTX 2080 Ti kühl genug läuft. Und da Nvidia die maximale Compute-Performance mit auf GPU-Boost basierenden Zahlen angibt, erreicht das Top-End-Modell bis zu 14,2 TFLOPS Single-Precision-Leistung. Die Referenzspezifikation sieht eine typische GPU-Boost-Frequenz von 1545 MHz und eine etwas geringere TDP vor. Während die Übertaktung der Founders Edition-Karte eine maximale Board-Leistung (TBP) von 260W vorsieht, sollten die Referenz-Karten bei rund 250W liegen.

- 1 - Einführung und Vorstellung

- 2 - TU102 + GeForce RTX 2080 Ti

- 3 - TU104 + GeForce RTX 2080

- 4 - TU106 + GeForce RTX 2070

- 5 - Performance-Anstieg für bestehende Anwendungen

- 6 - Tensor-Kerne und DLSS

- 7 - Ray Tracing in Echtzeit

- 8 - NVLink: als Brücke wohin?

- 9 - RTX-OPs: wir rechnen nach

- 10 - Shading-Verbesserungen

- 11 - Anschlüsse und Video

- 12 - 1-Klick-Übertaktung

- 13 - Tschüss, Gebläselüfter!

- 14 - Zusammenfassung und Fazit

Kommentieren