Wer viel misst misst Mist. Diese Regel gilt, solange man sich nicht aktiv mit den Umständen und Erfordernissen auseinandersetzt und auch nicht bereit ist, viel – meist private – Zeit in deren Ergründung zu investieren. Ich hatte 2014 begonnen, mich intensiver mit der Leistungsaufnahme von Grafikkarten zu beschäftigen und um eine wirklich gute Lösung zu finden. Auf diesem Weg bin ich zudem auf so manche interessante Erkenntnis und auch auf Dinge gestoßen, die ich so nicht vermutet hätte.

Zusammen mit unseren Partnern aus der Industrie wurde dabei der Messplatz Zug um Zug systematisch um- und ausgebaut. Es wurden Setups getestet und wieder verworfen, Firmware geändert und erneut fast bei Null begonnen. Kurzum: Für eine Entwicklung, die ja auch im laufenden Betrieb erfolgen musste, war das ziemlich viel Arbeit neben der Arbeit. Aber es hat sich wirklich gelohnt. Und wenn ich ehrlich sein soll: Geheimniskrämerei mag zwar gut fürs eigene Geschäft sein, aber Transparenz ist noch viel wichtiger.

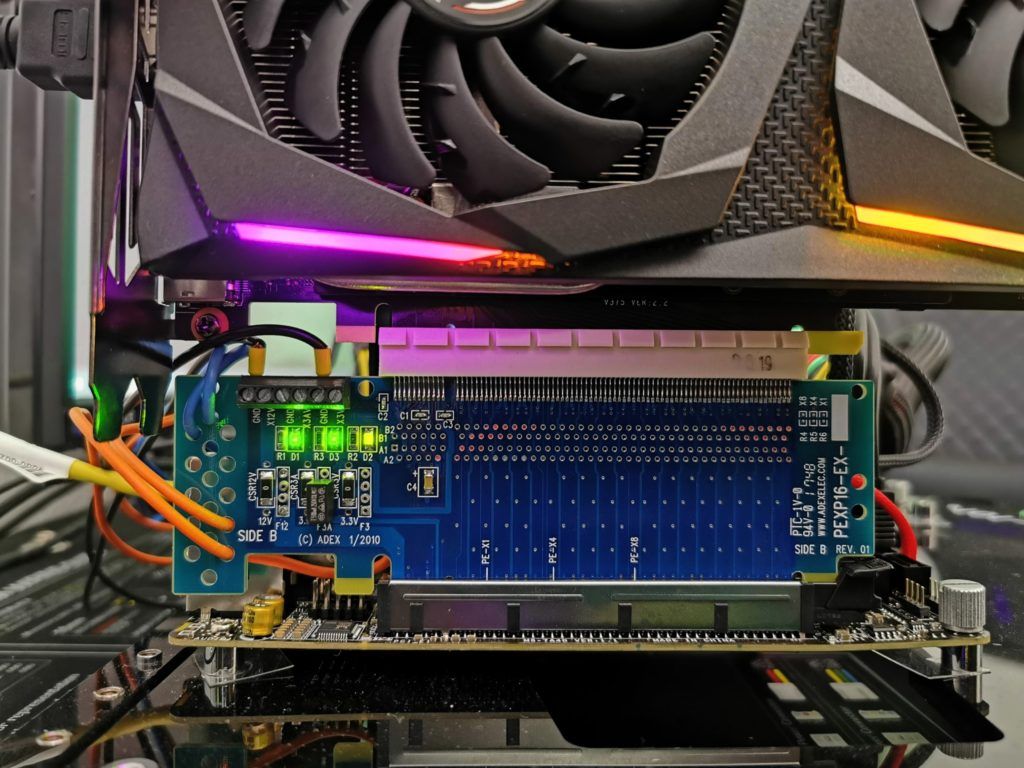

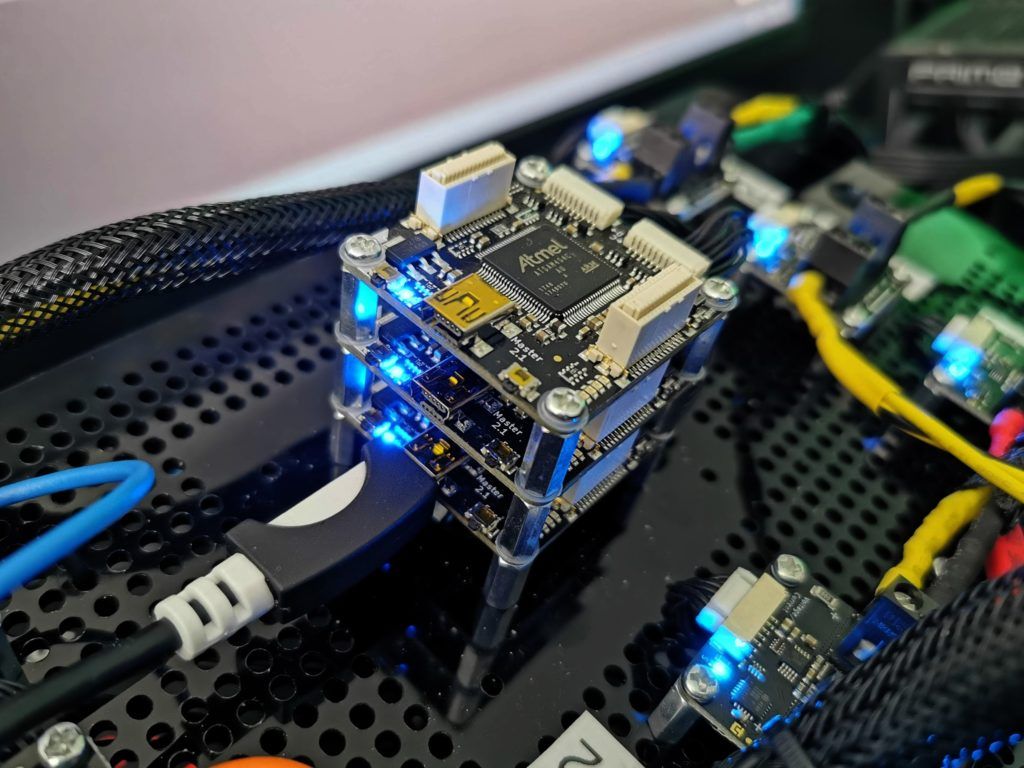

Vor allem wenn es darum geht, die veröffentlichten Messwerte in den Artikeln auch begründen zu können. Deshalb lüfte ich auch ein klein wenig “das Geheimnis”, wie genau die exakten Zahlen unserer Messungen eigentlich entstehen. Der heutige Messplatz hat sich natürlich verändert, denn neben den getriggerten Oszillografen setze ich auch auf eine sepziell entwickelter Riser-Card zur direkten Leistungsaufnahmemessung an allen Rails mit Shunt und Auswertungssoftware, sowie eine große, MCU-basierte Messtation, bei der ebenfalles jede einzelne Versorgungsspannungsleitung in kleinen Zeitintervallen mitgeloggt werden kann und man hier sogar alles im direkten Zusammenspiel von GPU, CPU und Motherboard auf insgesamt 12 verschiedenen Rails gleichzeitig messen kann. Ausruhen ist nicht.

Nur muss man es ab und zu zeigen und auch ältere Artikel wieder mal periodisch entstauben, sonst glaubt einem ja am Ende auch keiner…

Wechseljahre: Die Last mit den Spitzen

Grafikkarten sind leider nicht mehr die geduldigen “Verbraucher”, die sie vor wenigen Jahren noch waren. Dabei geht es nicht um die Leistungsaufnahme als solche und deren Mittelwert, sondern um die Art und Weise, WIE die Chiphersteller versuchen, die Effizienz zu steigern und auf welche Kunstgriffe und Verrenkungen sie dabei zurückgreifen. Womit wir direkt beim Thema wären. Um das alles nicht zu sehr zu verkomplizieren, habe ich uns als Beispiel AMD und Power Tune herausgegepickt – wobei Nvidias Boost am Ende die gleichen Probleme hat, da die Herangehensweise und die Folgen sehr ähnlich sind.

Worum aber geht es? Das Hauptanliegen besteht bei beiden Anbietern darin, die Kernspannung der GPU in Echtzeit möglichst so anzupassen, dass nur so viel Leistung zugeführt wird, wie man für die aktuelle Auslastung der GPU auch wirklich benötigt. Warum also ständig mit hohen Drehzahlen im dritten Gang durch die Stadt fahren, wenn es der vierte oder fünfte auch tun würden? Sicher hinkt dieser Vergleich etwas, aber es kommt schon ungefähr hin. Auch wenn sich seit der Erstveröffentlichung im Jahre 2014 so Einges getan hat, das Grundprinzip ist immer noch bei beiden Herstellern das gleiche. Mit PowerTune hat AMD – analog zu Nvidias Boost – ein sehr komplexes Ablaufgebilde mit vielen, sich gegenseitig beeinflussenden Faktoren geschaffen. Doch wie zur Hölle funktioniert dies alles im Detail?

Telemetrie wie in der Formel 1

Zunächst schätzt PowerTune stets den Energieverbrauch in Echtzeit, fragt gleichzeitig die thermischen Sensoren ab und bezieht die Telemetrie-Daten des Spannungsreglers mit ein. Diese Werte werden an den vorprogrammierten digitalen Power-Management-Mittler übermittelt. Dieser Mittler (Arbitrator) kennt die Power-, thermischen und Stromstärken-Limits der GPU (BIOS, Treiber). Innerhalb dieser Grenzen kontrolliert er nun also alle Spannungen, Taktfrequenzen sowie die Lüftergeschwindigkeiten und versucht dabei stets, die maximale Performance aus der Karte herauszuholen. Wenn auch nur eine der Eingangsgrößen überschritten wird, kann der Mittler Spannung oder Takt zurücknehmen.

Der Kerngedanke besteht also darin, dass man über geeignete VR-Schaltkreise (Voltage Regulation) wie den IR 3567B in der Lage ist, die Spannungen in sehr kurzen Intervallen – also faktisch in “Echtzeit” – den tatsächlichen Erfordernissen anzupassen. Hier greift nun auch AMDs Protokoll der zweiten Generation SVI2 , das mittlerweile von allen gängigen ICs beherrscht wird und auch für APUs genutzt wird, bei denen dann zusätzlich der Prozessorteil über die Northbridge mit gesteuert wird.

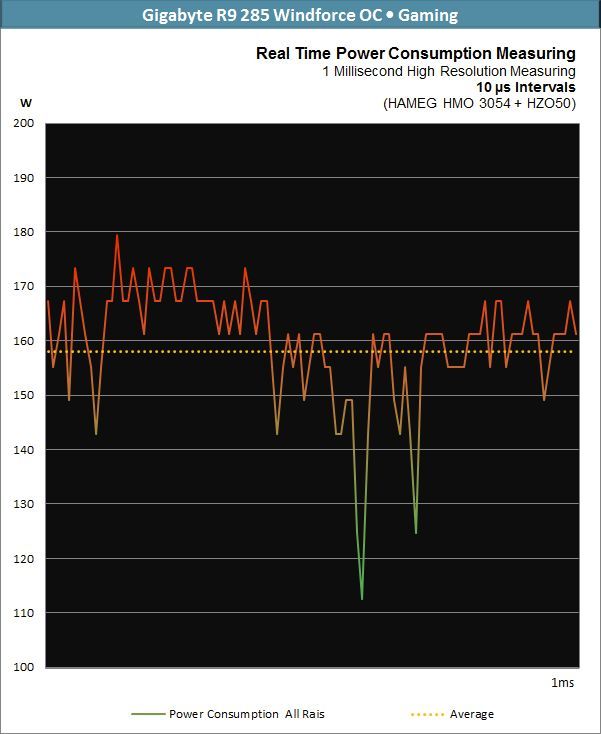

Doch wie kurz sind diese Intervalle wirklich? Früher gab es noch eine relativ große Verzögerung zwischen der Nachfrage nach einer höheren Spannung und der darauffolgenden Anpassung der Taktfrequenz. AMDs SVI2 der zweiten Generation ist aber nunmehr rund zwei Zehnerpotenzen schneller (also rund 10 µs anstelle 1 ms) und agiert mit 6,25-mV-Schritten wesentlich granulärer als noch die Vorgängerversion. Betrachten wir uns dazu einmal eine einzige, kleine Millisekunde im Verlaufsprotokoll einer Radeon R9 285 unter Last:

Die Spikes sind los: Lastspitzen bis unter die Decke

Genau an dieser Stelle beginnt nun aber mit Sicherheit das große Zähneklappern bei denen, die die Problematik bis hierher nachvollziehen konnten. Die durchschnittliche Leistungsaufnahme einer Grafikkarte ist ja am Ende auch nichts anderes als ein Durchschnittsverbrauch beim Auto. Und wer mal einen Blick auch die Echtzeitanzeige seines Autos geworfen hat, wird meist zunächst gar nicht glauben, was er da so sieht. Trotzdem zeigen die meisten Bordcomputer die Momentanverbräuche mittlerweile sehr realistisch an, denn es gibt diese Spitzen wirklich!

Die durch die schnellen Spannungswechsel entstehenden Lastspitzen stellt die Stromversorgung leistungsstarker Grafikkarten vor völlig neue Herausforderungen. Der Einfluss auf das zweckmäßige Design der passenden Netzteile ist kein geringer und wird im Folgenden auch Gegenstand unserer Betrachtungen sein.

Natürlich hat sich mittlerweile so einiges geändert und deshalb empfehle ich zum Thema eine weiterführende Analyse von mir, die sich mit diesem Thema anhand aktuellerer Grafikkarten von AMD und Nvidia sehr ausführlich befasst:

Der Kampf von Grafikkarte gegen Netzteil – Leistungsaufnahme und Lastspitzen entmystifiziert | igorsLAB

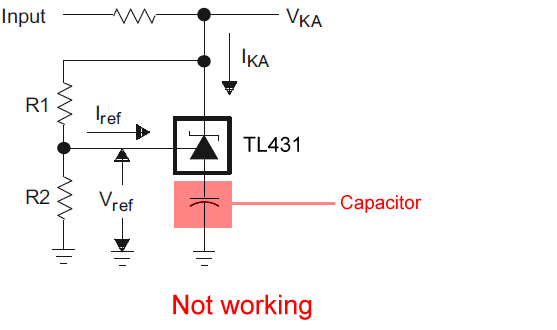

Diese kurze Einleitung zeigt bereits deutlich, dass beide Hersteller durchaus in der Lage sind, die selbst gesteckten TDP-Grenzen ziemlich genau einzuhalten. Sollten die Messwerte bei einer Grafikkarte dann einmal deutlich darüber liegen, hat man entweder durch unzureichende Technik den sprichwörtlichen Mist gemessen, oder die Grafikkarte hat einen Defekt. Manchmal trickst aber auch der Board-Partner (siehe Schaltung unten) mit einem eingebauten “Fehler” (das hatten wir ja auch schon mal). Suchen wir uns jetzt aus, was im Alltag wohl am wahrscheinlichsten ist…

Doch zunächst wollen wir erst einmal gemeinsam überlegen, wie man solch alternierende Leistungsaufnahmen wirklich exakt messen und bewerten kann. Denn auch an uns Redakteure und die genutzte Technik werden völlig neue Anforderungen gestellt: Mit den meisten herkömmlichen Methoden wird man nämlich immer nur eine gewisse Momentaufnahme erhalten, die mit etwas Pech dermaßen weit neben der Realität liegen kann, dass es schon eine echte Fehleinschätzung und Falschaussage wird.

Lösungsvorschläge und Ideen? Begeben wir uns nun auf die Suche.

Rüstungswettlauf und erste Gehversuche mit einem einzelnen Oszilloskop

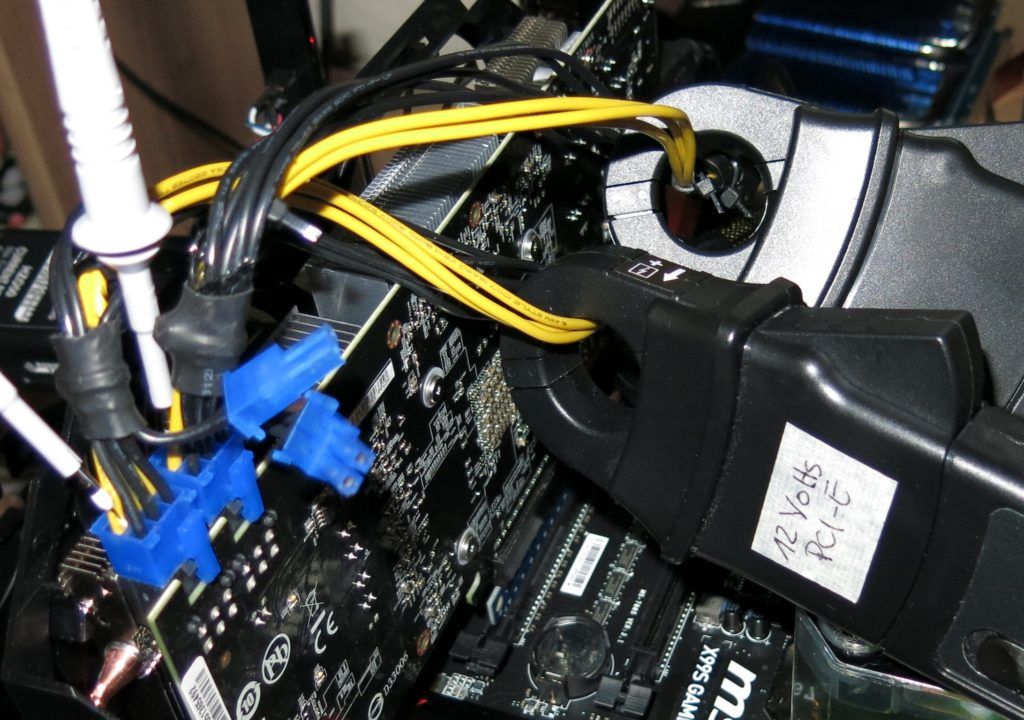

Wenn die VR-Controller die Grafikkarten so schnell schalten lassen, was schlägt dann davon wirklich bis auf die Stromversorgungsanschlüsse der Grafikkarten durch? Wie hart wird die Versorgung über das Mainboard und wo sind die externen PCI-Express-Versorgungsanschlüsse wirklich gefordert? Ich hatte das System für diese Messungen im Hinblick auf möglichst kleine Intervalle konzipiert, was allerdings den Einsatz eines sehr guten (und leider auch sehr teuren) Mehrkanal-Speicheroszillografen mit Speicherfunktion unabdingbar machte.

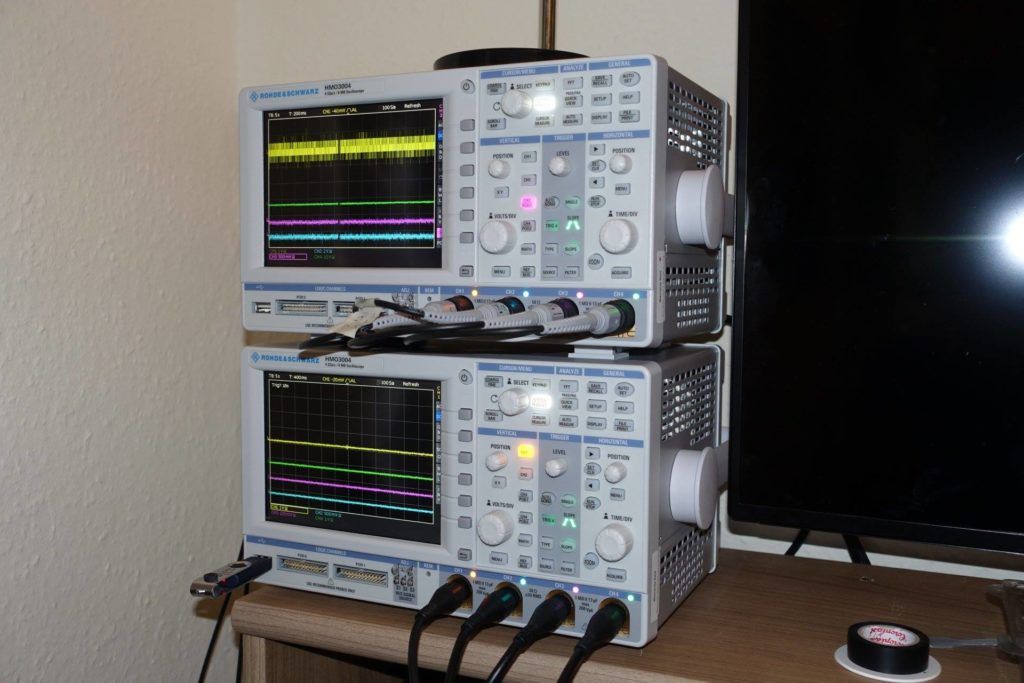

Als Basis diente ein 500 MHz Mehrkanal-Oszilloskop (HAMEG HMO 3054), das das gemeinsame Speichern von vier Kanälen und eine sinnvolle Fernsteuerung über Ethernet erlaubt. Dazu kommen noch mehrere hochauflösende AC/DC Stromzangenadapter (HZO 50), die für diese hohen Frequenzbereiche noch problemlos einsetzbar sind und die vor allem ohne Bereichsumschaltung genutzt werden können (Full-Range).

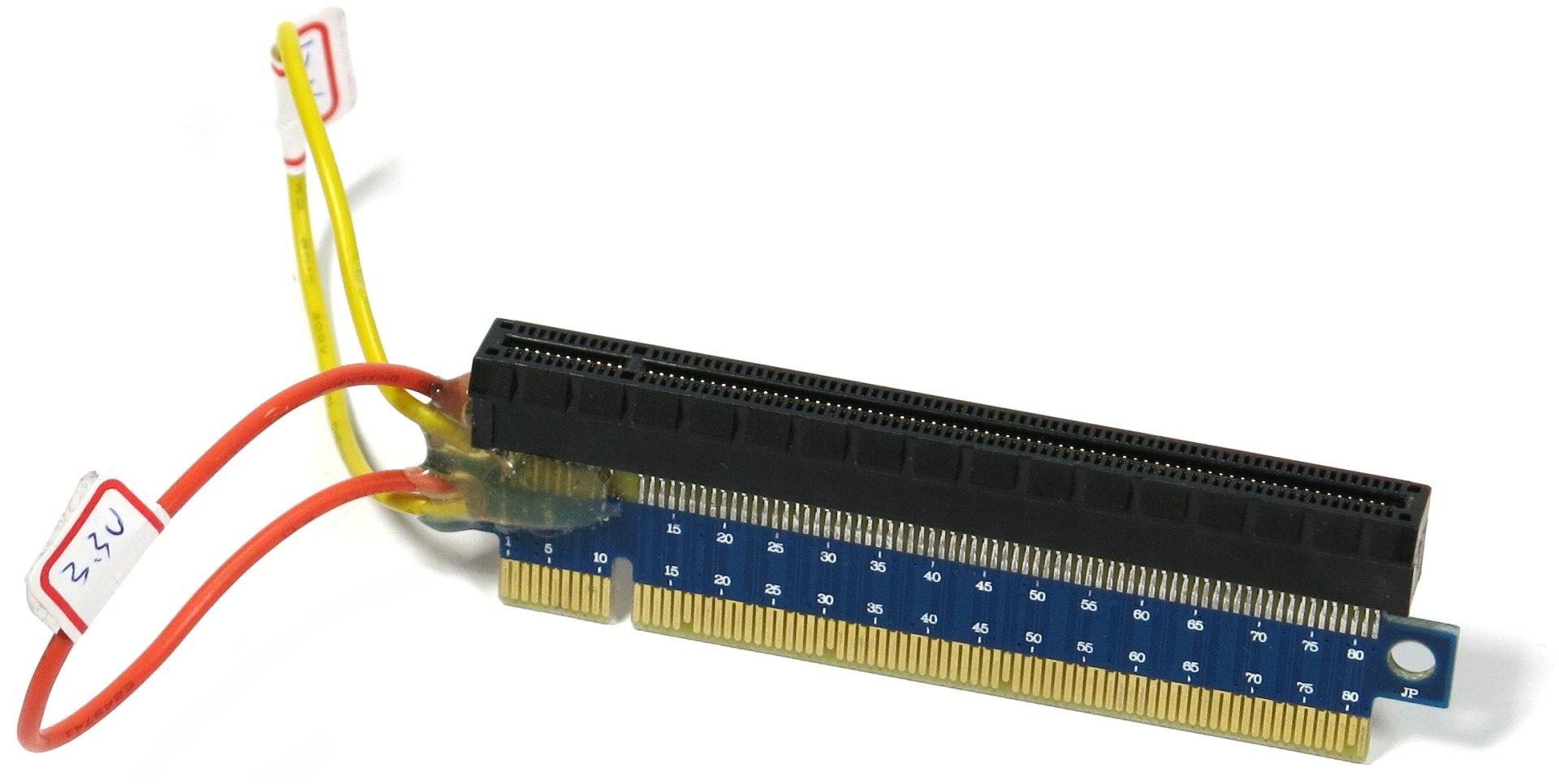

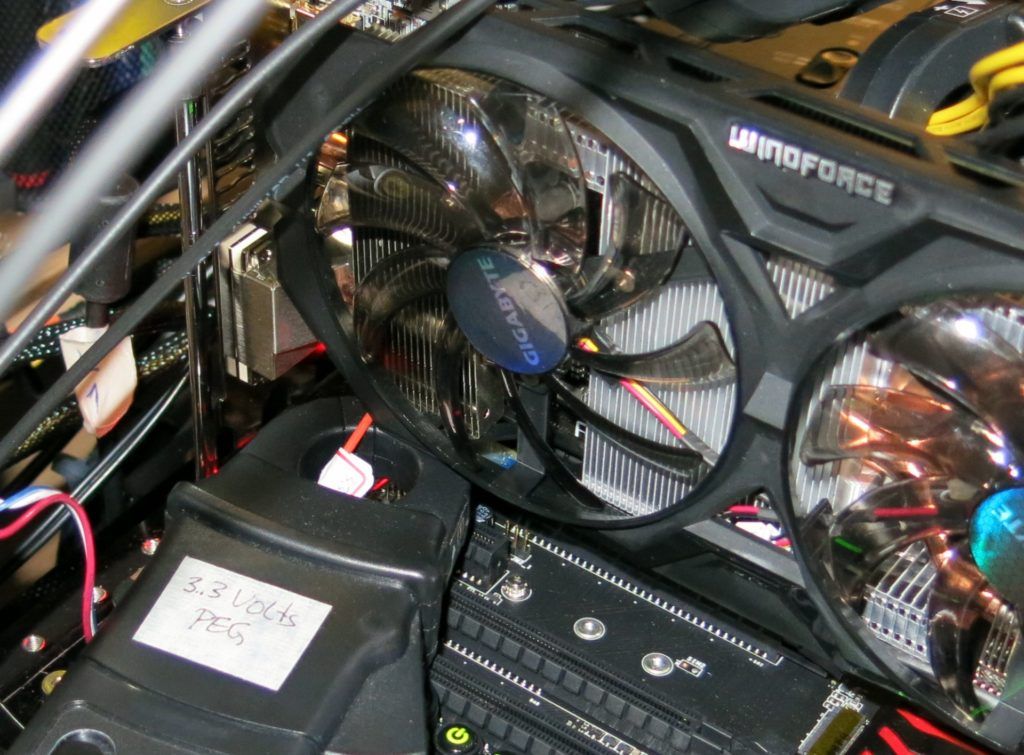

Ein weiteres, wichtiges Utensil ist eine spezielle Riser-Card mit Loops, die zudem extrem kurze Signalwege besitzen muss, damit auch moderne PCIe-Karten der dritten Generation problemlos damit laufen. Dieser Adapter steckt dann zwischen Mainboard und Grafikkarte. Wer jetzt glaubt, die beiden zu den Grafikkarten-Slot durchgeschleiften Spannungschienen einfach am 24-Pin-Anschluss des Mainboards messen zu können, wird enttäuscht werden. Denn das Mainboard bedient sich hier aus der gleichen Quelle. Ohne geeignete Riser-Card ging also nichts und so gab es wieder Bastelstunden und jede Menge Lehrgeld inklusive.

Nach der Lösung dieser kleinen Bastelaufgabe kommt nun die strategische Partnerschaft zur Industrie (HAMEG, Rohde & Schwarz) zum Zug, denn ohne brauchbare Labor-Technik und jahrelange Erfahrungen läuft man trotz aller Ambitionen schnell ins Leere. Das Zwischenergebnis, so wie wir es aus den Reviews der letzten Monate kennen, war da sicher schon ein erster, ermutigender Erfolg. Nur sind vier Kanäle zwar auf den ersten Blick noch purer Luxus, aber wenn man das Ganze mal aufdröselt, steht man gleich vor dem nächsten Problem und wundert sich.

Misst man nämlich die Stromstärken für die beiden Mainboard-Leitungen (3,3 und 12 Volt) und den externen PCIe-Stromanschluss, so bleibt nur noch ein Kanal übrig, um wenigstens eine der Spannungen zu messen. Da auf dem PCI-Express-Anschluss unter Last das meiste passiert, habe ich dort die Spannung der 12-Volt-Schiene gemessen, die Werte für 3,3 mittels Multimeter bestimmt und später als Festwert eingesetzt.

Spätestens aber bei Grafikkarten wie der Radeon R9 295X2 und einigen Board-Partner-Eigendesigns merkt man jedoch, dass auch dies alles nur ein fauler Kompromiss ist: Man kann die PCIe-Anschlüsse doch nicht so einfach zu einem einzigen Kanal zusammenfassen, wenn an den jeweiligen Anschlüssen unterschiedliche Phasen der Grafkikkartenversorgung hängen. Teilweise fließen die Ströme in sehr kurzen Spikes nämlich auch schon mal in umgekehrter Richtug, was ich so nicht vermutet hätte.

Die Messung mit einem einzigen Vierkanal-Speicheroszilloskop, drei geeigneten Stromzangenadaptern und einem Tastkopf ist zumindest um Welten besser als Dinge wie Steckdosenmessung, Zangenamperemeter oder Stromzangenadapter und Multimeter, aber leider immer noch reichlich ungenau. Und nun?

4-Punkt-Messung und ein doppeltes Lottchen

Schrieb ich oben Wettrüsten? Das Ganze artet nämlich – wenn man es wirklich ernsthaft betreiben will – schon ein wenig arg aus. Will man pro Grafikkarte wirklich alle vier maximal auftretenden Versorgungsschienen messen, bräuchte man nämlich acht analoge Kanäle am Oszilloskop. Man muss ja für jede der vier einzelnen Schienen sowohl Spannung als auch Stromstärke in Echtzeit parallel messen und auch abspeichern können! Arbeitet man mit vorermittelten Festwerten für die Spannungen, kann man nämlich nicht nur erneut gehörig daneben liegen, sondern tut es auch, wie wir gleich noch sehen werden.

Genau an dieser Stelle habe ich dann ansetzen müssen und gemeinsam mit unserem Messtechnik-Partner nach einer praktikablen Lösung gesucht. Diese wiederum besteht nun darin, mit gleich zwei solchen Oszilloskopen parallel (Master-Slave) zu messen und aufzuzeichnen. Das funktionert mittelweile schon recht perfekt, so dass ich in der Lage bin, nahezu jeden Atemaussetzer oder Hustenanfall der Grafikkarten (und anderer Messobjekte wie z.B. Mainboards) plausibel und belastbar zu erfassen.

Das heißt im Endergebnis: Ich kann damit nun je nach Aufgabenstellung Ströme und Spannungen gleichzeitig in Auflösungen von bis zu einer Mikrosekunde messen. Diese Intervalle sollte man natürlich der konkreten Aufgabe besser anpassen, um nicht in der aufkommenden Datenflut zu ertrinken. Wenn ich beispielsweise bei Grafikkarten in den 1-Minuten-Diagrammen mit einer Millisekunde auflöse, werden die dazwischen im Mikrosekundenbereich anfallenden Messwerte bereits als brauchbarer Mittelwert im Oszilloskop zusammengefasst.

Das aktuelle System für die Leistungsaunahmemessung und Grafikkarten-Analyse hatte ich ja auf Seite 1 bereits als weiteres Bild mit den Oszilligrafengezeigt, hier ist noch einmal die Beschreibung der Komponenten in Tabelleform

| Power Consumption: |

Scope measuring: MCU-based measuring |

|---|---|

| Thermal Imager: |

1x Optris PI640 + 2x Xi400 Thermal Imagers Pix Connect Software Type K Class 1 thermal sensors (up to 4 channels) |

| Acoustics: |

NTI Audio M2211 (with calibration file) Steinberg UR12 (with phantom power for the microphones) Creative X7, Smaart v.7 Own anechoic chamber, 3.5 x 1.8 x 2.2 m (LxTxH) Axial measurements, perpendicular to the centre of the sound source(s), measuring distance 50 cm Noise emission in dBA (slow) as RTA measurement Frequency spectrum as graphic |

Wie dies alles im Detail aussieht und was man aus solchen Werten noch so alles ableiten kann, das sehen wir nun auf der nächsten Seite. Durchhalten Freunde, denn jetzt wird es erstmals richtig spannend!

Was passiert eigentlich am Mainboard-Slot?

Fangen wir bescheiden und klein an. Nicht jede Grafikkarte besitzt ja zusätzliche Versorgungsanschlüsse und es gab sogar Zeiten, wo Grafikkarten überhaupt keine benötigten. Je nach Gesamtleistungsaufnahme kann eine Grafikkarte nämlich bis zu einer Obergrenze von 75 Watt auch nur über den Slot des Mainboards versorgt werden. Hier handelt es sich um mehrere Spannungsschienen, nämlich 3,3 und 12 Volt. Ich schrieb ja bereits, dass diese Spannungen über das Mainboard durchgeschleift werden, so dass man diese – da es keine von Mainboard mit beeinflussten Ströme sind – auch bequem am 24-Pin-Anschluss messen kann.

Die anfallenden Ströme auf der 3,3- und 12-Volt-Leitung vom Mainboard messe ich dann wieder – so wie es sich gehört – zwischen Grafikkarte und Mainboard und nutze dafür die beiden herausgeführten Loops der Riser-Karte:

Ein wenig eng, aber die Zange passt noch gerade so dazwischen.

Lastspitzen am Mainboard: Gefährlich oder nicht?

Ich habe im Verlauf der letzten Monate unterschiedliche Hersteller-Lösungen bei der Versorgung der Grafikkarten messen können. Zunächst waren es kleinere Karten wie verschiedene Modelle der GeForce GTX 750 Ti, deren Leistungsaufnahme die 60 Watt im Durchschnitt nicht wirklich überscheiten, aber je nach Modell und Takt sehr gehörige Leistungsspitzen erzeugen können. Dann fällt auch schon mal die 75-Watt-Grenze für Sekundenbruchteile recht deutlich, wie es uns die Grafik anschaulich darstellt:

Ich habe für einzelne Karten stellenweise bis zu 120 Watt gemessen, was deutlich über den Spezifikationen liegt! Da es sich nur um kurzzeitige Spitzen handelt, wird dem Mainboard erst einmal physikalisch nichts passieren, denn die Anschlüsse führen ja direkt zum 24-pin-Anschluss des Netzteils am Mainboard mit mindestens zwei 12-Volt-Zuleitungen.

Was aber durchaus kritisch werden kann, ist die Tatsache, dass es sich am Ende schon um echte Hochfrequenz handelt, die zusammen mit anderen Mainboardkomponenten durchaus Probleme bereiten könnte.

Bei preiswerteren Mainboards “hört” man dann auch schon einmal die Grafikkarte über den Onboard-Sound. Das zirpende Scroll-Geräusch dürfte so ziemlich jedem hinlänglich bekannt sein und nun kennen wir auch die Ursache.

Nicht der Onboard-Chip ist demnach gleich Müll oder das Mainboard per se Mist – nein, hier jodeln die Spikes ihr einsames und unerwünschtes Lied und die Grafikkarte ist der wirkliche Täter. Je nach Modell versorgen sich auch Grafikkarten mit höheren Leistungsaufnahmewerten trotz separaten Stromversorgungskabeln noch mit über den Mainboard-Slot. Deshalb besitzen diese Karten auch zwei getrennte Spannungswandlerbereiche und die Lastverteilung zwischen Idle und Last wandert zwischen den 12-Volt-Schienen je nach Bedarf hin und her. Andere Karten – beispielsweise die R9 295X2 und diverse Board-Partner-Designs – nutzen die teilweise Versorgung über das Mainboard hingegen (fast) überhaupt nicht mehr.

Auch hier habe ich natürlich mittlerweile viele neuere Tests veröffentlicht und ich empfehle vor allem diesen hier exemplarisch zur Lektüre:

Nachteile des Onboard-Sounds – Einfluss von Grafikkarte, Kopfhörerempfindlichkeit und Motherboardlayout

Dauer-Power und Achterbahn am PCI-Express-Stecker

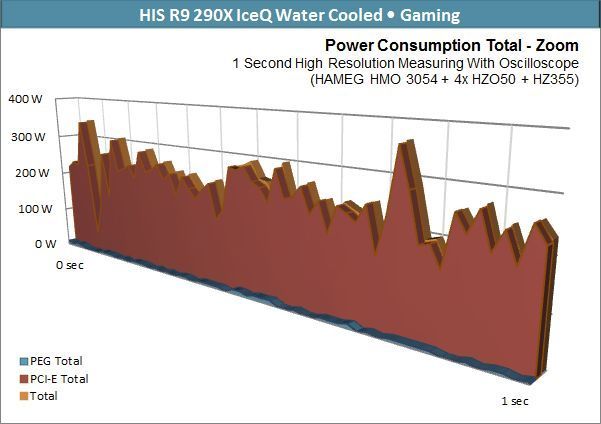

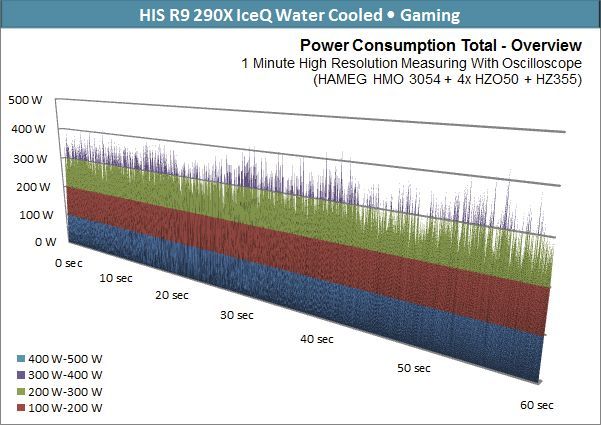

Kommen wir nun abschließend zum Schaulaufen, denn jetzt kann es schon mal so richtig heftig werden. Die hier gemessene Karte ist so eine Kandidatin, die das Mainboard kaum noch nutzt, dafür aber in den Spitzen bis weit über 400 Watt aufnimmt, um gleich darauf auch mal auf unter 40 Watt zu fallen:

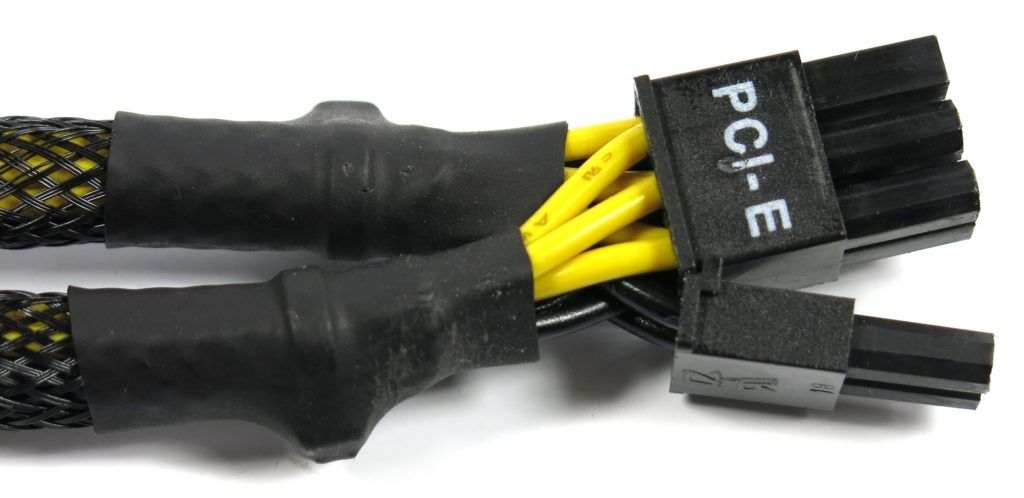

Wir messen fair und sauber wie es sich gehört jeden PCIe-Stromanschluss getrennt. Die Gründe kennen wir ja bereits und vor allem bei Karten wie der Radeon R9 295X2, auf die wir im nächsten Kapitel mit Freude zurückkommen werden, ist es schlichtweg unvermeidbar, da jeder Anschluss jeweils eine der beiden GPUs getrennt versorgen muss.

Doch zurück zur wassergekühlten Radeon R9 290X aus dem Diagramm. Deren TDP ist auf 250 Watt festgelegt, die aber selbst beim Stresstest nicht ganz erreicht werden. Werfen wir zum Abschluss noch einmal einen Blick auf die Tabelle mit dem Soll- und Haben-Konto fürs Gaming und sehen auch, dass die zwei PCIe-Anschlüsse sehr wohl unterschiedliche Lasten stemmen müssen.

| Minimum | Maximum | Average | |

|---|---|---|---|

| PCIe Total: | 38 Watt (17 + 21 Watt) |

428 Watt (205 + 223 Watt) |

239 Watt (109 + 118 Watt) |

| Mainboard 3,3V: | 0 Watt | 3 Watt | 0 Watt |

| Mainboard 12V: | 0 Watt | 20 Watt | 4 Watt |

| Mainboard Total: | 0 Watt | 20 Watt | 4 Watt |

| VGA Card Total: | 40 Watt | 433 Watt | 243 Watt |

Eindrucksvoll, nicht wahr? Doch es gibt auch noch viel schlimmere Extremfälle, wie wir auf der nächsten Seite gleich sehen werden.

Erkenne die Grenzen: Wo liegt die Tolerenzgrenze?

Nachdem wir nun wissen, warum bei aktuellen Grafikkarten so extreme Lastspitzen entstehen, wollen wir uns mit den möglichen Folgen beschäftigen. Wer erinnert sich nicht an die ganzen Diskussionen parallel zum Launch der R9 295X2, welches Kabel an welche Rail des Netzteils anzuschließen wäre, wie haltbar Stecker und Kabel sind sowie der Frage, wo die wirklichen Grenzen liegen? Stecker, Kabel, Netzteil – wer ist eigentlich Schuld, wenn es doch mal mit einem Knall oder Zischen dunkel wird?

Dass AMD mit dieser Karte den Killer jeglicher Standards schlechthin geschaffen habe, wurde gern und ausgiebig kolportiert und auch Nvidias Titan Z bekam später gehörig was auf die Nüsse – nur dass sie nicht sonderlich viele Redakteure im Selbstversuch testen konnten. Genau hier wollen wir ansetzen und zunächst die Frage beantworten, ob diese ganze Aufregung nicht vielleicht viel zu übertrieben war, nur weil die meisten von den Umständen überrascht wurden.

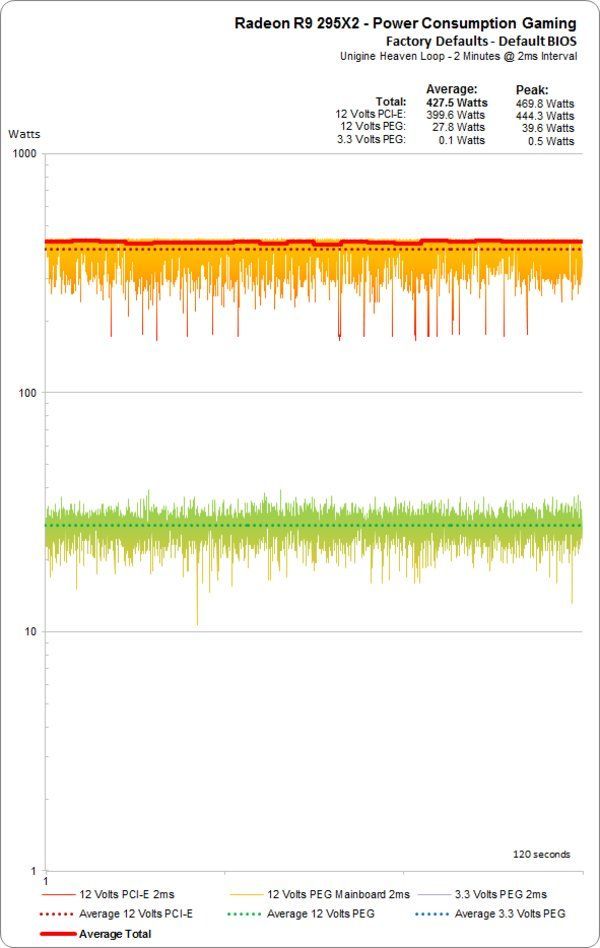

Wie AMD uns mitteilte, ist die TDP der Karte mit maximal 450 Watt spezifiziert – und wenn wir uns die zweite Seite mit Power Tune und der Theorie Erinnerung rufen, dann wissen wir auch, dass diese Angabe nicht nur ein schnöder Schätzwert ist, sondern eine echte Grenze. Beim Gaming messen wir noch knapp unter 430 Watt, so wie von AMD kommuniziert und nicht über 500, wie oft verbreitet:

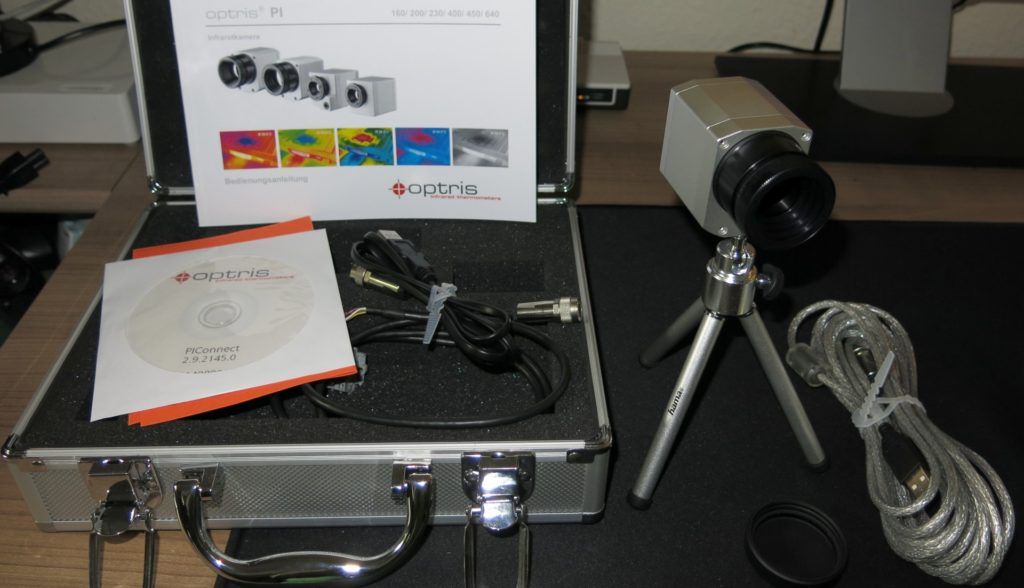

Beim Stresstest, den wir als Nächstes auch mit einer guten Infrarotkamera (Optris PI450) dokumentieren werden, sind es ebenfalls nur knapp unter 450 Watt. Das beweist, dass man nur schnell genug messen muss, um sich bei der Wertermittlung nicht meilenweit vom tatsächlichen Durchschnittswert zu entfernen.

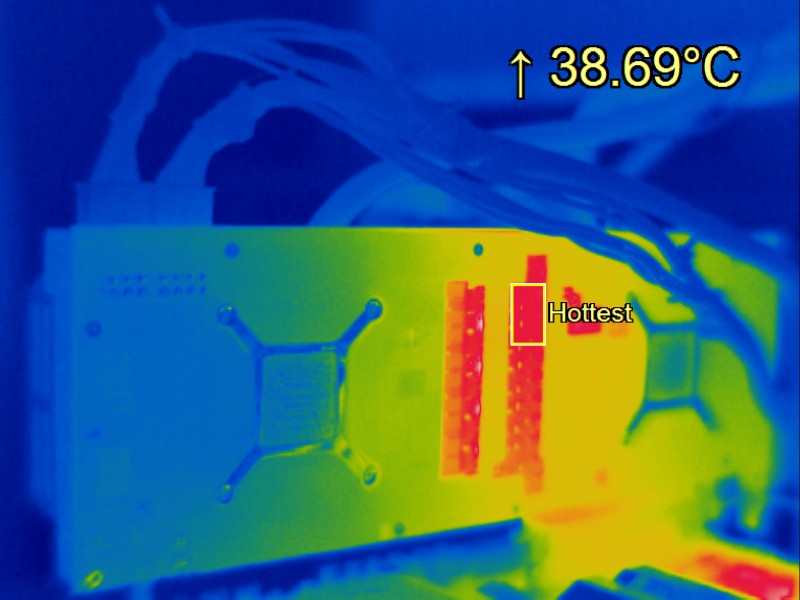

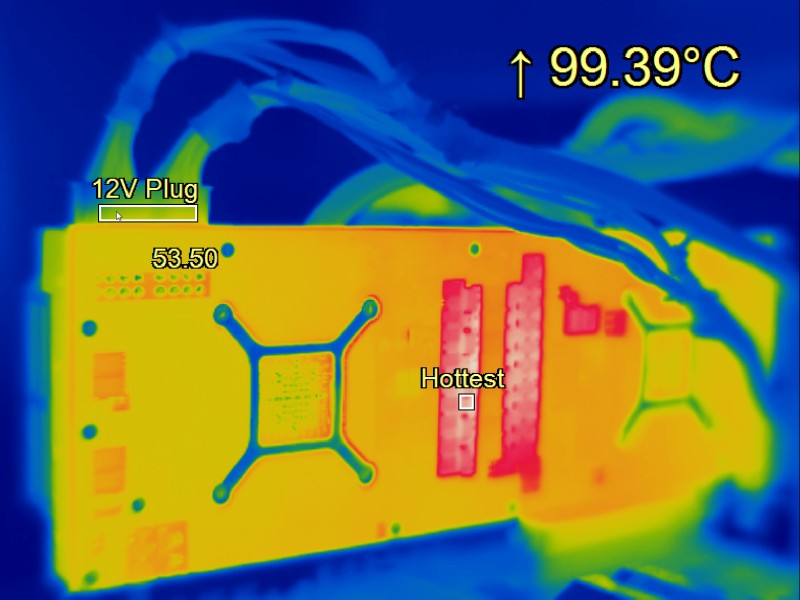

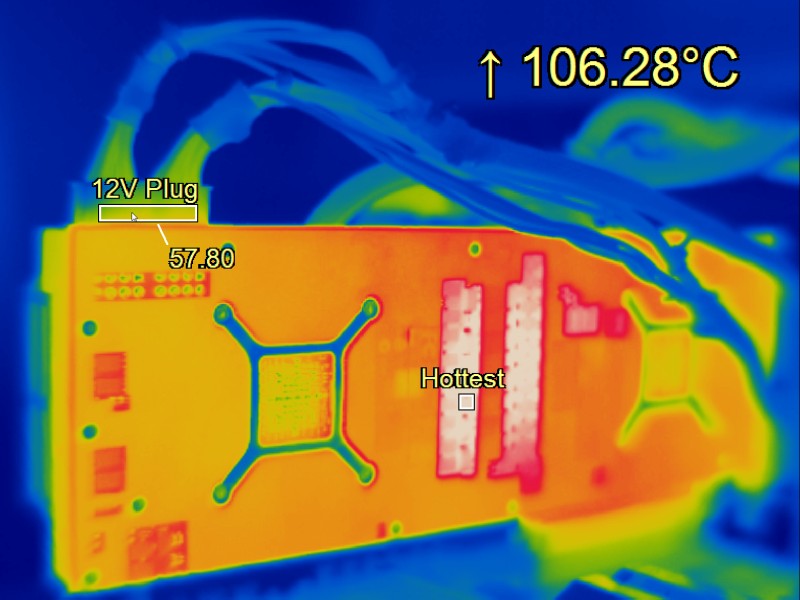

Infrarot-Video der R9 295X2 unter Maximallast

Ih abe bereits 2014 für die möglichst perfekte und übersichtliche Aunahme eine PI450 von Optris genutzt, die für diese Belange bestens geeignet ist und den gesamten Prozess als Video in Echtzeit aufzeichnen und auswerten kann, wobei ich mittlerweile über noch höher auflösende Kameras mit diversen Optiken verfügen kann:

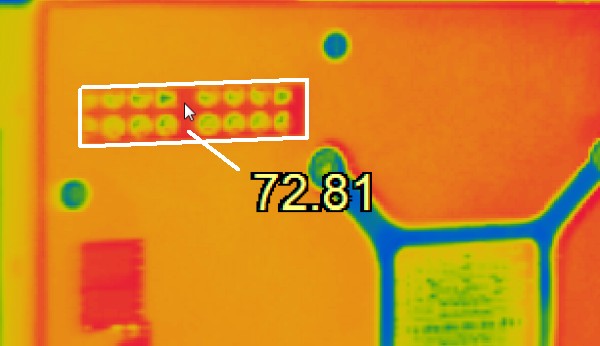

Wir wollen uns in diesem Artikel nun endlich der Frage annehmen, ob denn die Kabel unseres Netzteils sowie die Stecker und Buchsen des PCIe-Anschlusses die Geschichte schadlos überstehen können und wo die Wärme eigentlich herkommt. Übergangswiderstand, schlechte Kontakte, miese Kabel? Kann man alles getrost in die vielzitierte Tonne befördern, denn es kommt völlig anders. Wir lassen die ersten 10 Minuten im Zeitraffer laufen und fassen alles in fünf Minuten zusammen:

Ausgangspunkt und Mutter aller Temperaturkollapse ist also die Platine! Wie das Video eindrucksvoll beweist, heizt sich zunächst die Platine ordentlich auf. Die Temperaturen der Spannungswandler sind dafür, dass sie aktiv belüftete Kühlkürper besitzen, jenseits aller Akzeptanz. Dies trägt, zusammen mit den zwei GPUs, zur kontinuierlichen Erwärmung der Platine bei, der auch die Backplate nicht mehr helfen kann. Wobei es ohne diese Plate sogar kühler lief, da die Luft frei zirkulieren konnte!

|

|

|

Letztendlich breitet sich die Wärme über die verlöteten Anschlussstifte in die PCI-Express-Anschlussbuchsen (die später auch bis zu 59°C warm wurden) und dann erst über die Steckkontakte in die Kabel aus.

Man darf also beruhigt sein, denn die Kabel und Anschlüsse der Stromversorgung leiden durch diese Karte nicht, solange sie den üblichen Qualitätsstandards entsprechen! Was aber ist nun mit dem Netzteil?

Versorgungsengpässe? Nicht wirklich, wenn…

Um das Ganze noch etwas spannender zu machen, testen wir zunächst eine und später dann sogar zwei solcher Karten im Quad-Crossfire bei brütender Hitze (knapp 30°C Raumtemperatur). Zunächst benutzen wir ein ordentliches 500-Watt-Netzteil (be quiet! Straight Power E10), das erst bei ca. 20 Prozent Überlast sauber abschaltet. Stimmen unsere Messwerte für die R9 295X2 aus dem Launch-Artikel von durchschnittlich 430 Watt im Gaming-Loop, dann sollten die damit maximal verfügbaren 600 Watt auch für die Grafikkarte, ein Mittelklasse-Mainboard und einen nicht übertakteten Core i7-4770K sowie acht GByte RAM und eine SSD locker ausreichen.

Und das tun sie auch, denn die Chroma zeigt primärseitig im Maximum nie mehr als 610 Watt an, sondern meist deutlich weniger – und so gehen wir sogar gemütlich zwischendurch eine Pizza essen. Der Loop läuft stabil und wir wundern uns das erste Mal über die Ausfälle der großen Boliden bei den Launch-Artikeln. Aber warum sollten wir nur kleckern? Einmal mutig geworden, hängen wir nun sogar zwei R9 295X2 an ein nicht mehr ganz taufrisches 1000-Watt-Netzteil (be quiet! Power Zone), das lediglich mit 80+ Bronze zertifiziert ist. Jetzt sollten die Leistungsaufnahme beider Karten und die des Testsystems zusammen bei ca. 1000 Watt auf der Sekundärseite liegen und das Netzteil müsste diese Last seinerseits locker stemmen können.

Beim erneuten, einstündigen Gaming-Loop und nahezu 100-prozentiger Auslastung messen wir an der Chroma primärseitig eine Leistungsaufnahme von bis zu 1100 Watt. Damit liegt unser Gesamtsystem in jedem Fall deutlich unter 1000 Watt, was zunächst erst einmal beweist, das unsere Messungen der Leistungsaufnahme exakt der Realität entsprechen. Warum aber schalten deutlich großzügiger bemessene Systeme trotzdem ab? Schauen wir uns auch diese Belastungsprobe im Video an. Zur Information: Die Lautstärke setzt sich aus den röhrenden Chromas und den zwei Grafikkarten zusammen; das Netzteil ging in diesem akustischen Inferno glatt unter:

Netzteil und Grafikkarte sollten zueinander passen. Nicht die pure Wattangabe der Gesamtleistung ist für ein Gelingen entscheidend, sondern Faktoren wie Single- oder Multi-Rail und die verfügbaren und wirklich erreichbaren Stromstärken, die auch bei sehr kurzen, heftigen Lastpitzen (“Spikes”) konstant geliefert werden können, ohne dass die Spannungswerte kurzfristig einknicken. Die Frage beantwortet am Ende das Netzteil.

Etwas Überlegung statt Panik hilft immer

Zwischen Grafikkarte und Netzteil sorgen mehr oder weniger zweckmäßig ausgeführte und angeschlossene Kabel für eine hoffentlich gute Verbindung. Doch wo liegen die Grenzen und wie sieht eine optimale Verkabelung aus? Natürlich wird diese Frage erst ab Leistungsaufnahmen oberhalb von 200 Watt pro Grafikkarte so richtig interessant. Und auch hier erinnern wir uns wieder an die Diskussionen um die zwei 8-Pin-Anschlüsse der R9 295X2, die ja weitab jeglicher Normen liegen. Aber sind diese Normen wirklich so eng gefasst, dass ein Überschreiten gleich zum Gefahrenherd wird?

AWG was?

Spätestens seit AMDs Radeon R9 295X2 ist der Begriff AWG ja in aller Munde. Doch was verbirgt sich dahinter? Sepp Moser erfand am Rosenmontag des Jahres 1857 rein zufällig in München die Weißwurst, im gleichen Jahre explodiert der Pulverturm in der Festung Mainz – und die AWG wird Nordamerika ins Leben gerufen. AWG steht für American Wire Gauge und ist eine Kodierung für Drahtdurchmesser. Auch wenn diese Norm überwiegend in Nordamerika verwandt wird, unflexibel ist und ewig nicht angepasst wurde – es ist nun mal eine Art Quasi-Standard, an dem man bei solchen Kabeln kaum vorbei kommt. Für die ganz Neugierigen und Selberrechner noch einmal schnell die Tabelle mit den jeweiligen AWG-Standards, die bei Netzteilen für uns relevant sind:

| AWG-Nummer | Durchmesser (Ø) in mm | Querschnitt in mm2 | Äquivalent mm² (metrisch) |

|---|---|---|---|

| 16 | 1,29 | 1,305 | 1,5 |

| 18 | 1,02 | 0,79 | 0,75 |

| 20 | 0,81 | 0,51 | 0,5 |

Ergibt AWG 20 überhaupt einen Sinn?

Beginnen wir mit den dünnsten Leitungen. Wenn die Raumtemperatur beispielsweise 25 °C beträgt und man bei durchschnittlichen Kabellängen von 55 cm mit maximal 50 °C Kabeltemperatur leben wollte, dann wären selbst bei den dünneren AWG-20-Kabeln noch ca. 10 Ampère pro Leitung machbar. Das ergäbe bei drei zuführenden Leitungen immehrin 360 Watt, was sogar für einen 8-poligen Anschluss reichen könnte. Nur liegen der Teufel immer im Detail und bereits diese Temperatur ist eindeutig zu hoch. Deshalb sollte man AWG-20-Kabel beim PCI-Express-Anschluss nur für Leistungen bis circa 150 Watt in Betracht ziehen. Ein einzelnes 6-Pin- oder 8-Pin-Kabel für die Stromversorgung einer Grafikkarte ginge also völlig in Ordnung.

AWG 18: Eins für alles

Theoretisch könnte man mit AWG 18 bereits alles abdecken, was an Verkabelungen zwischen Netzteil und Grafikkarte notwenig ist. Deshalb ist diese Größe auch die meistverwendete. Ein probeweise an die R9 295X2 angeschlossenes, einzelnes AWG-18-Kabel eines Markennetzteils mit zwei 8-Pin-Steckern hat diesen Test mit Bravour absolviert. Hier muss man am Ende nur auf die genaue Ausführung achten, denn es gibt zwischen den Netzteilherstellern und deren Modellen größere Unterschiede und leider auch unzweckmäßige Lösungen, wie wir gleich sehen werden. Außerdem tricksen manche Billigstanbieter auch mit besonders dicken Isolierungen, die dann die dicken Leitungen nur vorspiegeln – man kann also auch reinfallen.

AWG 16: Die Königsklasse

Nur wenige Netzteile bieten AWG 16, weil hierbei auch der finanzielle Einsatz des Anbieters am höchsten ist. Zwingend notwendig ist die Verwendung von AWG-16-Kabel nicht, aber es senkt in High-End-Systemen die Kabeltemperaturen deutlich und hilft auch, die Effizienz zu erhöhen. Allerdings lohnt AWG 16 nur dann, wenn wirklich hohe Ströme fließen sollen. Wer Wert auf Optik legt und sich bei Grafikkarten mit zwei Stromanschlüssen das zweite Kabel sparen möchte, ist mit AWG 16 natürlich immer noch auf der Sonnenseite.

Was so alles schief gehen kann

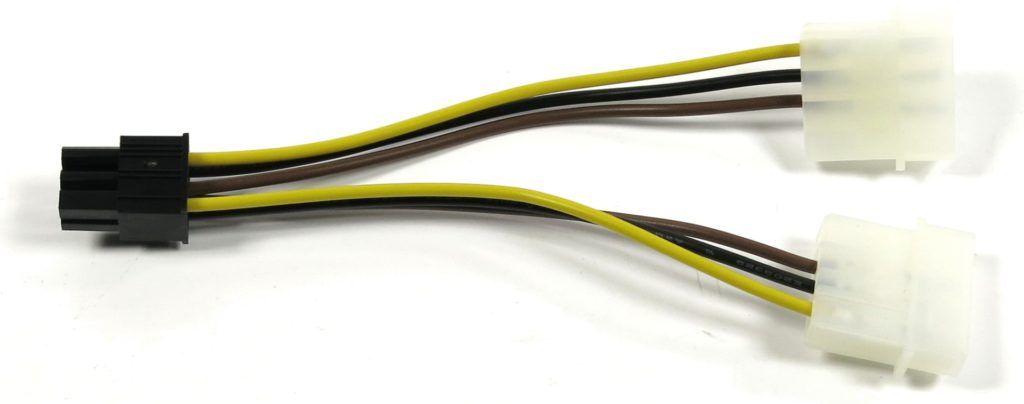

Betrachten wir einmal das 2x 8-Pin-Kabel eines nicht mehr erhältlichen Netzteils, welches ja laut ATX-Spezifikation mit 300 Watt (2x 150 Watt) belastbar sein sollte:

Die zwei zuätzlichen Masseleitungen holt man jedoch hier aus dem Stecker selbst und auch der zweite Stecker ist nur eine Art Verlängerung, nutzt also keine eigenen Leitungen. Somit besteht dieses Anschlusskabel nur aus jeweils drei Leitungen für 12 Volt und Masse. Theoretisch schafft man es zwar beim Leitungsquerschnitt, der dafür reichen sollte, jedoch sind die lediglich zusammengedrillten Doppelkabel in den Steckern bereits ein fieser Fehlerteufel.

Noch interessanter wird bei diesem Kabel der Anschluss am Netzteil selbst, denn hier mündet ja alles in einen einzigen 6-Pin-Stecker. Obwohl das Netzteil diesen Anschluß im Datenbatt mit 20 Ampère (240 Watt) ausweist (und darüber hinaus auch brav abschaltet), suggerieren die zwei 8-Pin-Anschlüsse 300 Watt. Dies kann schon auf Grund der OCP des Multi-Rail-Netzteils gar nicht funktionieren. Voll der Blender.

Von solchen Netzteilen und Kabeln sollte man also besser Abstand nehmen und die hier gezeigte Fehlleistung sieht man in vielen Variationen immer wieder.

Gute und bessere Lösungen

Normalerweise sollten diese kombinierten Kabel mindestens einen soliden 8-Pin-Stecker am Netzteil besitzen. Ein gutes Beispiel zeigt die nachfolgende Abbildung, bei der man aber aus optischen Gründen auf komplett schwarze Leitungen gesetzt hat (was für den Endkunden nicht von Belang ist, aber schon beim Hersteller mangels Übersichtlichkeit zu höheren Ausschussraten führt):

Der Idealzustand wären eigentlich getrennte Kabel, also für jeden PCI-Express-Anschluss jeweils ein eigenes, separates Kabel. Damit umgeht man ziemlich elegant auch alle Ärgernisse, die bei so hohen Stromstärken und schnellen Lastwechseln auftreten können. In die gleiche Kategorie fallen dann auch kombinierte AWG-16-Kabel mit 2x 8-Pin und mindestens 8-poligen Netzteilsteckern, die sehr gut zu gebrauchen sind.

Und wenn das Kabel dann doch mal warm wird?

Dann hat der Hersteller ein wenig geschummelt und spielt mit verunreinigtem Kupfer sowie der Sicherheit der Kunden. Das meiste Kupfer für solche Kabel kommt aus recycelten Rohstoffen, was an sich erst einmal nichts Schlechtes ist – im Gegenteil. Interne Test bei Netzteilanbietern haben aber ergeben, dass es bei so manchen Preisdrückern zum Teil auch ganz gern mal Legierungen verwendet werden, die einen gewissen Aluminium-, Magnesium- oder Zink-Anteil besitzen. Die Litzen sind dann zum Teil sehr spröde und die Kabel nicht besonders flexibel. In solchen Fällen reicht dann auch die eigentlich vorhandene Sicherheitsreserve von AWG 20 nicht mehr aus und es wird zum reinen Glücksspiel.

Bitte nicht mehr nutzen: Adapter-Murks

Auch wenn die Grafikkartenhersteller immer wieder solch unsägliche Adapter beilegen – ihre Verwendung ist im Zeitalter moderner Grafikkarten mit Boost oder Power Tune einfach nicht mehr zeitgemäß, zumal gute und ausreichende Netzteile auch günstig zu erwerben sind.

Im Gegenteil lassen nämlich die Netzteilanbieter meist immer dann das zweite oder dritte PCI-Express-Kabel weg, wenn das Netzteil von Haus aus damit leistungsmäßig nicht klar käme. Fehlende Anschlüsse sind also immer auch ein direkter Warnhinweis auf mangelndes Leistungsvermögen, selbst wenn auf dem Label eine tolle Leistungsangabe steht!

Solche Doppeladapter sind Unfug, da am Ende alles doch nur auf eine einzige 12-Volt-Quelle hinausläuft. Was das Netzteil nicht kann, sollte man auch nicht hintenherum erzwingen. Einzige Ausnahme sind Systembuilder-Netzteile aus OEM-Rechnern, wo die Leistung theoretisch da wäre, der Assembler beim Originalgerät aber gespart hat. Hier muss jedoch eine gründliche Überprüfung der Umstände erfolgen, bevor so etwas noch eingesetzt wird.

Die Netzteilseite hat es vor allem in sich

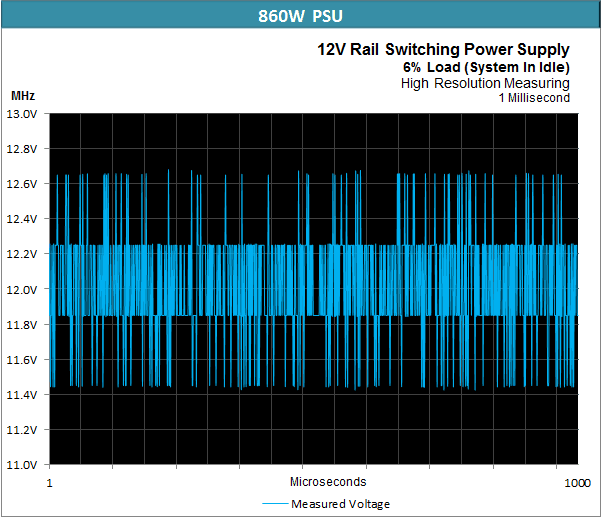

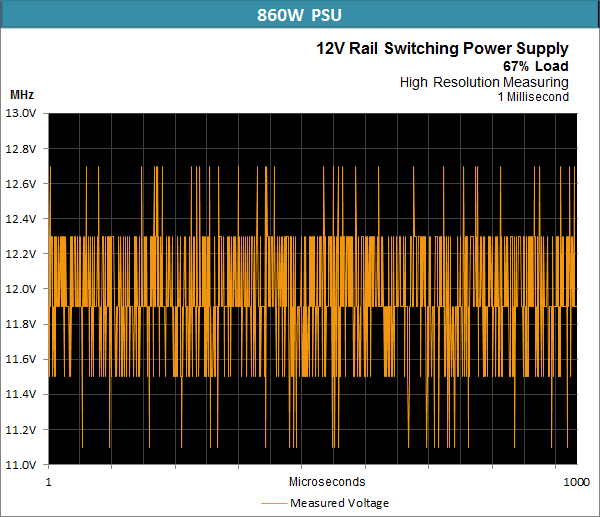

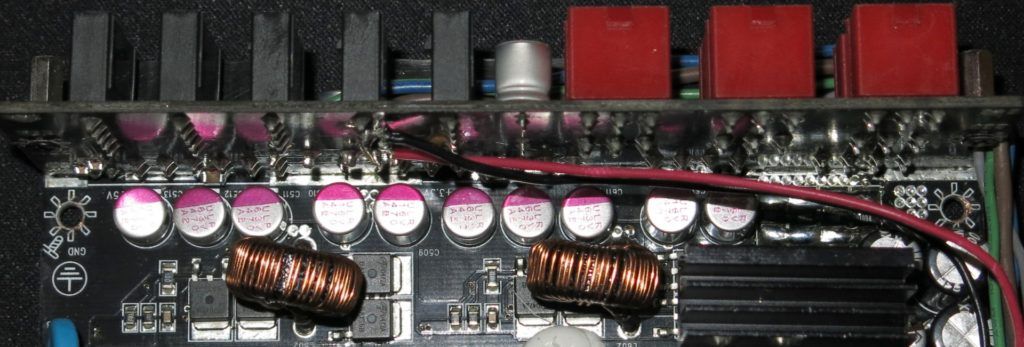

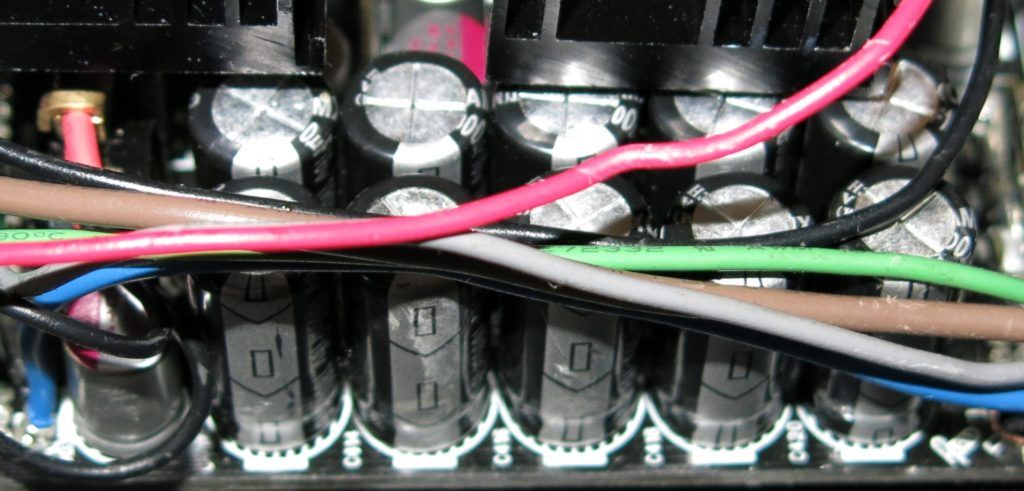

Nun wären wir also am Netzteil angelangt und wollen uns mit den Problemen beschäftigen, die uns auf der Sekundärseite eines modernen Netzteils erwarten können.Da ich aber keinen Netzteil-, sondern einen Grafikkarten-Artikel schreibe, muss ich natürlich inhaltlich zunächst noch ein wenig vorsortieren. Mich interessiert deshalb neben dem eigentlichen Arbeitsprinzip lediglich die Sekundärseite und dort insbesondere die Aufgabe und die Bestückung der sogenannten Sekundär-Kondensatoren und die ewige Diskussion über die Gesaltung der Rails. Dafür nutze ich jetzt – mit gewisser Absicht – ein digitales 860-Watt-Netzteil der oberen Mittelklasse (Corsair AX860i) und habe die gemessenen Spannungswerte leicht gerundet, um die Grafiken etwas übersichtlicher zu halten.

Wie wir ja bereits wissen, produzieren die aktuellen Grafikkarten extreme Stromspitzen, die zwar nur sehr kurz sind (“Spikes”), aber trotzdem auch mehrmals in Sekundenbruchteilen aufeinander folgen können. Ich möchten an dieser Stelle auch nochmals darauf hinweisen, dass das Nachfolgende möglichst allgemeinverständlich abgefasst und zudem etwas vereinfacht bzw. abstrahiert wurde.

12 Volt sind nicht gleich 12 Volt

Ein aktuelles ATX-Netzteil beruht auf dem Prinzip eines Schaltnetzteils, was an sich nichts Schlimmes ist, solange man die in den Schaltvorgängen erzeugte Spannung hinterher wieder ausreichend glättet. Wenn man nämlich die im Netzteil bereitgestellte 12-Volt-Leitung einmal mit einem geeigneten Oszillografen betrachtet, dann wird aus der erwartet konstanten Gleichspannung von 12 Volt eine Art alternierendes Spannungsgemisch, dessen Mittelwert natürlich genau im Rahmen der ATX-Spezifikationen liegt. Aber eben nur der Mittelwert!

Betrachten wir jetzt den fast lastlosen Zustand bei einem digitalen Netzteil, das mit einer etwas niedrigeren Schaltfrequenz arbeitet. Die Glättung ist durchaus akzeptabel, auch wenn wir hier bei höher aufgelöster Messung sehen, dass eben keine konstanten 12 Volt zur Verfügung stehen, auch wenn der Mittelwert für die gesamte Millisekunde bei ziemlich genau 12 Volt liegt.

Was aber passiert, wenn jetzt Lastspitzen auf die ohnehin schon “pulsierende” Sekundärseite treffen? Wir sehen in der nachfolgenden Grafik, dass auch in dieser Situation die ATX-Spezifikationen noch eingehalten werden – zumindest solange es um den Mittelwert geht. Betrachten wir die gemessene Millisekunde, dann landen wir im Mittelwert nämlich bei etwa 11,85 Volt.

Die impulsartig aufgeladenen Kondensatoren der Sekundärseite treffen also auf ziemlich wilde Spikes, deren Frequenz fast doppelt so hoch liegen kann wie die Schaltfrequenz des Netzteils. Oft genug kann es deshalb passieren, dass bereits die nächste Stromspitze auf einen Kondesator trifft, bevor dieser überhaupt wieder vollständig aufgeladen werden konnte! Wir erkennen diese unglückliche Aufeinandertreffen an den kurzen Einbrüchen der Spannung bis hinab auf ca. 11,15 Volt.

Was lernen wir daraus?

Erstens: Nicht allein die Kapazität oder der Herstelleraufdruck entscheiden über die optimale Funktionalität der Sekundär-Kondensatoren, sondern vor allem ein sehr gutes Hochfrequenzverhalten (geringe Impedanz bei ca. 100 KHz), eine hohe Geschwindigkeit beim Aufladen und natürlich auch gute Ripple-Werte. Gerade digitale Netzteile besitzen oft eine langsamere Regelung als analoge Lösungen, so dass dieser Umstand erst recht von Bedeutung sein könnte. Dazu gleich noch mehr.

Zweitens: Als Folge dieser kurzzeitigen Spannungseinbrüche kann es dazu kommen, dass z.B. ein auf dem Mainboard verbauter Chip zur Spannungsüberwachung am entsprechenden Pin das Flag für das PowerGood-Signal auf Low setzt, so dass das Mainboard das Netzteil abschaltet und nicht etwa die im Netzteil verbaute UVP oder OCP/OPP, da die dafür benötigten Auslösewerte ja noch gar nicht erreicht wurden!

Die Supervisor-Chips der Netzteile sind hierfür entweder (bei Billig-Netzteilen) nicht zweckmäßig gewählt worden bzw. man vermeidet schaltungstechnisch ein derartig schnelles Ansprechen. Wir konnten dies durch die Auswertung der Messprotokolle herausfinden, bei denen wir auch das PowerGood-Signal überwacht haben. Bei der von uns gern bemühten Radeon R9 295X2 hat nämlich das mit 1200 Watt ausgewiesene Platimax von Enermax sporadisch versagt (wie später auch das Corsair AX 860i). Der Grund? Das Platimax hat in unserem Fall nicht etwa wegen Überlast der 12-Volt-Leitung abgeschaltet, sondern das Mainboard hat aufgrund kurzzeitiger Spannungseinbrüche das Netzteil abschalten lassen, indem das PowerGood-Signal verloren ging.

Eine Frage der Absicherung: Single- vs. Multi-Rail

Bevor es jetzt wieder das übliche Hauen und Stechen gibt: Bis 40 Ampère auf 12 Volt würden wir ein Single-Rail-Netzteil guten Gewissens tolerieren, was dann auch ein 500-Watt-Netzteil hinaus läuft. Denn einerseits lässt sich das noch flink und relativ schadensfrei absichern und andererseits ist der Anschluss einer leistungsstarken Grafikkarte jederzeit möglich. Wenn man hochrechnet, dass eine R9 290X im Maximum knapp 250 Watt aufnehmen kann, sind wir ja bereits bei über 20 Ampère und für die R9 295X2 bei über 40 Ampère. Da wird es dann schon lustig.

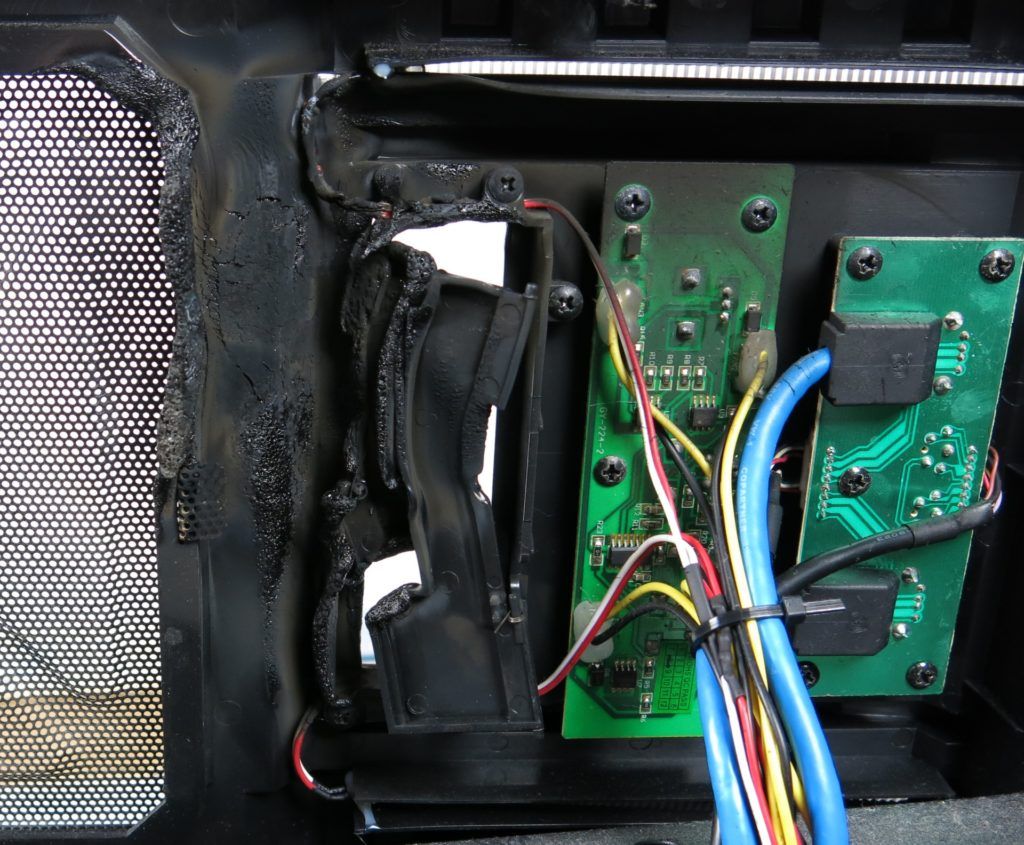

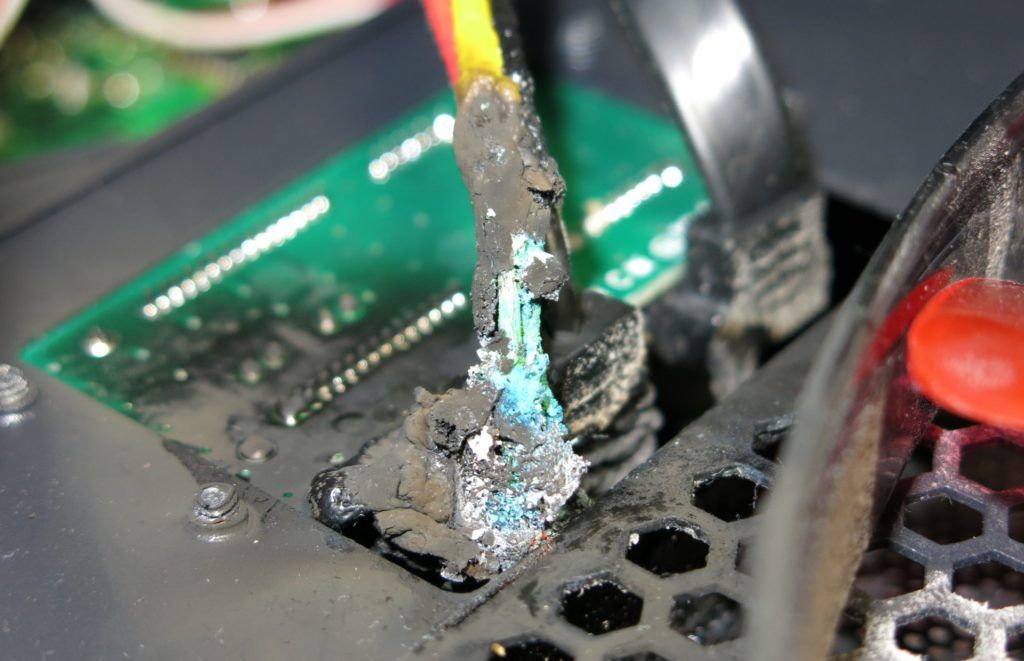

Was passiert, wenn ein Single-Rail-Netzteil kurzgeschlossen wird und die Kabel am SATA-Strang viel zu dünn sind, um die erforderliche Stromstärke für das Ansprechen der Schutzschaltungen durchzulassen, zeigen die nachfolgenen, eigenen Bilder:

Jetzt allein das Heil in Multi-Rail-Schaltungen zu suchen, wäre sicher auch zu kurz gesprungen, da die momentan üblichen Grenzwerte nicht mit den Anforderungen der aktuellen Grafikkarten übereinstimmen. Wir würden auf 25 Ampère für einen PCI-Express-Anschluss plädieren, da man damit ein Kabel mit zwei 8-Pin-Steckern locker versorgen könnte.

Wer trotzdem mehr benötigt (z.B. für Dinge wie die R9 295X2), der muss eben zwei Rails mit jeweils einem 8-Pin-Stecker verwenden. Ungünstig ist aber, dass viele Supervisor-Chips, die in den Netzteilen die OCP (Überstromschutz) realisieren, nur bis zu 4 Kanäle insgesamt dafür absichern können. Das reicht dann wieder hinten und vorne nicht, wenn man CPU und Mainboard, sowie die ganzen Laufwerksanschlüsse separat absichern möchte. Genau hier sollten dann ja die digitalen Netzteile greifen, die eine ziemlich flexible Festlegung der OCP pro Ausgang anbieten. Allerdings ist die dafür benötigte Software meist immer noch fehlerbehaftet und unausgereift, um wirklich ein echtes Gefühl von Sicherheit aufkommen zu lassen. Was also sollte man tun?

Regel Nummer Eins: Netzteile nie sinnlos überdimensionieren! Bei der Entscheidung für ein Single-Rail-Netzteil immer die benötigte Gesamtleistung im Auge behalten! Meistens bieten die Hersteller bis zu 20 Prozent Überlast in den Spitzen, was man zwar nicht ausnutzen sollte, aber beim Verlassen auf die Schutzschaltungen nie aus den Augen lassen darf. Bis 500 Watt Nennleistung ist die Single-Rail-Welt außerdem noch völlig in Ordnung.

Regel Nummer Zwei: Multi-Rail-Netzteile vorher auf die Maximalbelastung der Rails UND die eigenen Anforderungen hin kontrollieren! Wenn man z.B. eine R9 295X2 sicher betreiben möchte, dann muss man zwei getrennt überwachte Rails nutzen, was dann aber auch zwei einzelne PCI-Express-Anschlusskabel erfordert. Mit Doppelsteckern kommt man da nicht weiter. Also auf die Kabelbestückung achten!

Regel Nummer Drei: Digitalnetzteile sind sicher eine Bereicherung des Marktes, aber die Regelung ist fast immer langsamer als die der analogen Lösungen. Dann kommt es vor allem auf eine zweckmäßige Kondensator-Bestückung der Sekundärseite an, um auch alle Lastspitzen ausreichend abfedern zu können. Hier sollte man noch die weitere Entwicklung abwarten, denn es sind noch viele ungeklärte Fragen offen und die Softwareproblematik nicht zu vernachlässigen. Ein solides Netzteil ohne zusätzliche Fehlerquellen wird immer sicherer sein.

Kondensator-Frage

Bewegen wir uns nun nach so vielen Äußerlichkeiten ins Innere und betrachten die Gretchenfrage: Welche Kondesatoren sollten oder dürfen es sein und wo liegen noch viele Missverständnisse und Irrtümer? Und damit hätten wir die Kurve von der GPU, über das PCB, die Anschlüsse und die Versorgungsleitungen bis hin zu den Kondensatoren nun auch ganz gut hinbekommen.

Zwischenfrage: Was bringen Polymer-Kondensatoren?

In einem eigentlich eher aus einer Laune heraus erfolgten Test zweier einfacherer Netzteile mit und ohne Kabelmanagement, die bis auf die KM-Platine eigentlich ziemlich identisch waren, sowie einer ziemlich fiesen HIS R9 290X IceQ, die so richtig viele Spikes erzeugt (Leistungsaufnahme siehe Grafik auf Seite 3), kamen wir zu einem überraschenden Ergebnis: Ich konnte nämlich feststellen, dass die beim modularen Netzteil zusätzlich verwendeten Polymer-Kondensatoren die Spitzen eingangsseitig durchaus recht ordentlich abfedern konnten, wenn sie denn wirklich sinnvoll platziert sind. Zum einen sind die Solids wesentlich flinker als die Elektrolytkondensatoren und zum anderen kann auch die benötigte Kapazität aufgrund der geringen Zeitdauer der extremsten Spitzen sehr viel niedriger sein, um noch Wirkung zu zeigen.

Dies sollte sich mit Sicherheit auch positiv auf die Haltbarkeit der eigentlichen Sekundärkondensatoren (Bild unten) auswirken, auch wenn es meist nur eine indirekte Folge ist. Bei vielen Netzteilen nutzt man diese Polymerkondensatoren in erster Linie, um beispielsweise die bei der Trennung von Haupt- und Kabelmanagement-Platine auftretenden Wechselwirkungen zwischen Haupttrafo und senkrecht stehender Platine zu verhindern.

Dieser von uns beobachtete und sehr nützliche Nebeneffekt wird aber in jedem Falle gern mitgenommen, selbst wenn er mit Sicherheit nicht bei jedem Netzteil so angedacht wurde.Man sieht hier auch ganz gut eine der typischen Mischkalkulationen, wenn es darum geht, die Kosten zu optimieren: Mittelprächtige SamXon auf der Sekundärseite.

Womit auch der Bogen zu dem eigentlichen Elektrolytkondensatoren recht elegant geschlagen wäre, über die immer noch viel zu viel Unklarheit herrscht.

Low ESR, Low Impedance und Ripple

Zunächst machen wir einmal eine Bestandsaufnahme. Also was muss ein guter Sekundärkondesator mindestens können? Er soll sicherstellen, dass das Netzteil kontinuierlich hohe Ströme liefern kann und zudem garantieren, dass Lastschwankungen abgefangen werden können. Soweit, so theoretisch. Doch Elko (Elektrolytkondensator) ist nicht gleich Elko. Und genau an dieser Stelle wird es nämlich interessant, wenn wir über die datenblattbezogene Qualität und die Zweckmäßigkeit der Kondensatorwahl sprechen, die sich nicht zwingend decken müsssen!

Gehen wir jetzt noch einen Schritt weiter und fragen uns, was ein solcher Elko – auch in Hinsicht auf unsere wilden Grafikkarten – nun besonders gut können sollte? Er muss – schon aus Gründen der Haltbarkeit – zunächst erst einmal einen möglichst geringen inneren Verlustwiderstand besitzen (ESR = Equivalent Series Resistance). Deshalb findet man diese sogenannten Low-ESR-Ausführungen auch oft ausgangsseitig in Netzteilen oder auf Mainboards im Bereich der VRM.

Unsere Messungen der Leistungsaufnahme, wo die Intervalle der Lastwechsel sporadisch sogar noch schneller aufeinander folgen als das Schaltnetzteil überhaupt die Kondensatoren wieder aufladen kann, lassen uns hier jedoch etwas ins Grübel kommen. Viele Hersteller wechseln nämlich – mit Sicherheit nicht ohne triftigen Grund – mittlerweile zu ganz speziellen Low-Impedance-Kondensatoren, wo es um geringe Innenwiderstände bei hohen Frequenzen geht, die Standard-Elkos so in Perfektion nicht bieten. So viel zum Thema Zweckmäßigkeit. Doch dazu später noch etwas mehr.

Wir rechnen ein wenig und wundern uns

Wie wir wissen, fließen durch Kondensatoren keine Gleichströme, sondern sogenannte Rippelströme (engl. ripple current), was am Ende nichts anderes ist als der bereits von uns angesprochene pulsierende Gleichstrom. Nehmen wir nun ein Datenblatt von Teapo und vergleichen, welcher Kondensator der zweckmäßigste sein könnte. Um selbst bei einem ausgesprochen langsamen Schaltnetzteil eine ausreichend geringe Restwelligkeit zu garantieren, reichen bei bei Strömen bis 20A (in Bezug auf die erwähnte R9 290X) locker 3300µF pro Schiene, bei 30A sollten es dann 4700µF sein und alles darüber wird durch Parallelschaltung der Elkos erreicht.

Der mittlerweile gern genommene Teapo SY (Low Impedance) mit 3300µF als 16V-Modell besitzt eine Impedanz von 0,02 Ohm bei 100 KHz. Bei 20 Ampère fallen dann inkusive Selbstentladung ca. 0,25 Volt ab, was einer Welligkeit von etwa 2,1 Prozent entspricht und eine Verlustleistung von rund acht Watt ergibt. Laut Datenblatt sind 2,88 Ampère (rms) bei 5000 Stunden vorgesehen. Das passt also bestens, denn man wird solche Maximalwerte im Leben nicht erreichen.

Ein Nippon Chemi-Con der KY-Serie hat exakt die gleichen Daten, verspricht aber doppelte Haltbarkeit von 10.000 Stunden bei den maximalen Rippelströmen. Das liest sich erst einmal wie ein doppelt so guter Elko, aber da diese Belastung bei guten Modellen noch nicht mal ansatzweise erreicht wird, ist auch die Stundenangabe eher theoretischer Natur – denn vorher geht meist der Lüfter oder etwas anderes kaputt.

Selbst die als Billigheimer und “bad cap” verteufelten CapXon können – wenn man denn bereit ist, für Ausführung und Güteklasse zu bezahlen – durchaus noch gute Ergebnisse erzielen. So besitzt ein CapXon GF (Low Impedance) mit 3300µF als 16V-Modell sogar eine Impedanz von nur 0,018 Ohm bei 100 KHz und schafft sehr ordentliche 3,49 Ampère bei 5.000 Stunden. Es geht natürlich auch in Richtung Billigst-Schiene. Der Jun Fu WX mit 3300µF 16V schafft zwar immerhin noch 0,022 Ohm, fällt beim Rippelstrom aber auf 2,1 Ampère zurück. Und dann gibt es noch die wirklich schlechten Modelle, über die wir besser gar nichts mehr schreiben.

Wo liegen bzw. lagen nun die möglichen Qualitätsprobleme?

Die verwendeten Elektrolyte müssen besonders bei Low-ESR- und Low-Impedance Elkos sehr gut leitfähig sein, damit die Rippelströme keinen Schaden anrichten. Um die Leitfähigkeit zu erhöhen, verwendet man diverse Lösungsmittel und Zusatzstoffe, von denen einer meist Wasser ist. Durch das beigemengte Wasser erhöht sich automatisch die Anzahl freier Ionen, was natürlich zu einer wesentlich besseren Leitfähigkeit des Elektrolyten führt. Ohne jetzt den armen Leser mit zu viel Chemie langweilen zu wollen: Selbst nur in Spuren verunreinigtes Wasser greift Aluminium an. In einer exothermischen Reaktion korrodiert dann das Aluminium und es entsteht sowohl ein Hydroxid (AL(OH)3) als auch ein Gas, das dann zu einem Druckanstieg im Kondensator-Gehäuse führt.

Im Bild erkennen wir die Beulen im Becher und die Sollbruchstellen in der Kappe, die sich bei zu viel Druck öffnen soll(t)en. Wenn sie es tun, hat man nach einen Zischen eine feine Sauerei auf der Platine, die auch gern zu Kürzschlüssen führt. Oder sie öffnet sich nicht, dann knallt es und die Sauerei ist spritziger.

Die Hersteller sollten die Aggressivität des Wassers gegenüber dem Aluminium mittlerweile eigentlich voll im Griff haben. Allerdings haben vor allem in der Anfangszeit so manches Herstellers Probleme in der Produktion und Technologie dazu geführt, dass nicht wenige Elkos zur tickenden Zeitbombe wurden. Aus dieser Zeit rühren auch noch viele Vorurteile her, die heutzutage zumindest in großen Teilen so nicht mehr berechtigt sind. Die sogenannte Bad-Caps-Liste ist mittlerweile inhaltlich völlig überholt, da die Fertiger oftmals zwar noch die gleichen Modellreihen produzieren, die Produkte aber nicht mehr die selben sind.

Was sollte man nun kaufen?

Die Frage ist nicht ganz so einfach zu beantworten weil es auf Details ankommt.

Ein zweckmäßig ausgewählter Sekundär-Elko eines taiwanesischen oder chinesischen Herstellers kann – wenn der Netzteilfertiger eine entsprechend hohe Güteklasse verwendet, die auch größere Fertigungstoleranzen ausschließt – durchaus gleichwertig oder sogar besser sein, als ein einfacheres Nippon-Produkt, das zwar schlechtere technische Spezifikationen besitzt, aber im Gegenzug über den Namen des Herstellers punkten soll.

Man erhält also mittlerweile bei fast jedem Hersteller genau das, für das man bereit ist zu zahlen. Nicht mehr, aber fast immer auch nicht weniger. Dies macht die Beurteilung nicht einfacher und einmal mehr sind auch die Netzteiltester gefordert, mit mehr Abstand und Objektivität nicht nur Firmenlabel zu zelibrieren, sondern auch mal einen Blick auf die verbauten Güteklassen zu werfen. Als Grafikkartentester sagt man dann gern auch schon mal: Nicht meine Baustelle, obwohl man eigentlich die Wechselwirkungen nicht aus den Augen lassen dürfte.

Der übliche Gedankengang in Richtung “viel hilft viel” bei Überlegung zur Leistung eines Netzteils kann in unserem Falle nicht aufrecht erhalten werden. Es kommt nämlich wie immer auf eine gute Balance an. Zunächst sollte man die Spikes in der Leistungsaufnahme moderner Grafikkarten genau als das bewerten, was sie sind: Eine Herausforderung an die Qualität eines Netzteils und nicht an dessen maximale Wattzahl. Wenn man sich vor unnötigen Überraschungen und ggf. Langzeitschäden absichern möchte, ist nicht mehr, aber eben auch nicht weniger nötig. Und auch die fallende Effizienz im Leerlauf überdimensionierter Netzteile ist nicht zu vernachlässigen. Was also sollte ein optimales Netzteil für aktuelle, leistungssatarke Grafikkarten können und wie sollte man es bemessen?

Die durchschnittliche Leistungsaufnahme unter Last über einen gewissen Zeitraum ist hier – neben dem Bedarf des restlichen Systems – alleinig ausschlaggebend für die Auswahl der Netzteilleistung, nicht die kurzzeitig auftretenden Spitzenwerte. Wenn man dann in der Summe aller Komponenten bei rund 75 Prozent Auslastung im Stresstest liegt, sollte das optimale Leitungsfenster gut getroffen werden. Hinsichtlich der Qualität der verwendeten Bauteile wird es schon interessanter: Denn wir betonen es noch einmal, dass es im Bezug auf die Grafikkartenproblematik eben nicht (nur) auf Firmennamen ankommt, sondern in erster Linie auf die Zweckmäßigkeit der tatsächlichen Bestückung und die tatsächlichen Eigenschaften der jeweiligen Kondensatoren auf der Sekundärseite.

Die Pauschalaussage, das komplett japanische Kondensatoren verbaut werden würden, ist zwar schön fürs Marketing, hilft aber meist erst einmal gar nicht weiter. Hier kommen nun die von uns gemessenen Spikes ins Spiel, die über die Konstanz der Versorgung und die Haltbarkeit der Komponenten mit entscheiden.

Fazit

Wer viel misst, kann auch viel erfahren. Das bleibt mir als ganz persönliches Fazit nach diesem höchst interessanten Jahr wohl für immer in Erinnerung. Nach vielen direkten Kontakten zu Grafikkarten- und Netzteilherstellern, Gesprächen in den jeweiligen Entwicklungsabteilungen und auch Besuchen in den Fabriken selbst hat sich langsam, aber kontinuierlich ein Bild herauskristallisiert, das mir persönlich geholfen hat, den Blick auf viele Probleme zu schärfen sowie viele Zusammenhänge besser zu erkennen und zu verstehen.

Die Zusammenarbeit mit dem Messgerätehersteller hat dann noch ein Übriges getan, um vor allem auch die Ursachen zu finden. Deshalb möchte ich mich an dieser Stelle öffentlich noch einmal bei allen Beteiligten auf diesem Weg bedanken. Es ist definitiv keine Schande, vom Wissen Dritter zu profitieren – aber sehr wohl, aus falscher Eitelkeit heraus nicht zu fragen.

Es wäre in diesem Zusammenhang sicher auch hilfreich, wenn die Netzteil-Reviews nicht ausschließlich auf Chroma-Protokolle und ohmsche Lasten setzen würden, sondern dort auch die gleichen Spikes erzeugt werden würden, wie es die real existierende Technik nun mal vormacht. Spätestens dann werden auch so rätselhafte und kaum messbare Dinge, wie verlorene PowerGood-Flags vom Mainboard, endlich der Vergangenheit angehören. Denn eines ist auch sicher: viele augenscheinlich unerklärliche Netzteilausfälle oder Systemabschaltungen haben eigentlich eine ganz einfache Ursache: die extrem schnell wechselnden Lastspitzen und deren Nichtberücksichtigung beim Netzteildesign und dessen Bestückung mit zweckmäßigen Bauelementen, sowie der falschen Auswahl des benutzen Netzteilmodells.

Kurzum: Nach nunmehr 6 (!) Jahren bin ich endlich dort angekommen, wo ich eigentlich damals nach wenigen Wochen sein wollte. Dies war natürlich im Nachhinein betrachtet eine gehörige Illusion, aber der mühsame Weg bis dahin war gleichzeitig auch Ansporn und Basis für viele nebenher gesammelte Erkenntnisse über interessante Wechselwirkungen, auf die man sonst nie gekommen wäre.

Wir möchten deshalb Grafikkartenhersteller, Netzteilanbieter und auch die Reviewer ein wenig mehr für die aufgezeigte Problematik sensibilisieren – der Endverbraucher und Leser wir es sicher danken.

- 1 - Einführung und Projektvorhaben

- 2 - Grafikkarten und die Tricks mit der Leistungsaufnahme

- 3 - Leistungsaufnahme-Messung: Benötigte Technik

- 4 - Leistungsaufnahme-Messung: Praktische Umsetzung

- 5 - Radeon R9 295X als Netzteil-Killer? Myth busted!

- 6 - AWG was? Kabelsalat und Gegrilltes vom Chefkoch

- 7 - Schalten und Walten - Wir schauen ins Netzteil

- 8 - Bad caps, good caps? Die Mär vom japanischen Drachen.

- 9 - Zusammenfassung und Fazit

Kommentieren