With the GeForce RTX 3050, NVIDIA not only counters AMD’s very unfortunate Radeon RX 6500XT, but also rounds off its own portfolio even further downwards. The performance data has been cleverly chosen so that it is quite sufficient for Full HD in contrast to the AMD card, even though FPS junkies will certainly have to bake somewhat smaller rolls here. At least you don’t have to push all quality controls to the minimum like in AMD’s RX 6500XT to still get playable frame rates. That’s a small spolier in advance, the rest can be found in the review, of course.

The larger memory capacity also allows the card to perform well in WQHD with a balanced and well-considered mixture of medium settings in picture and DLSS quality. Of course, this presupposes a certain willingness to compromise visually, so you have to be honest about that. And since I meanwhile managed to borrow an AMD Radeon RX 6500XT in the form of Gigabyte’s Eagle 4GB, I’m making up for the failed launch test by also including this card in the charts. However, I decided against an extra review due to the rather measly results of the AMD card, since this would have ended in an explicit purchase warning and a flogging with an announcement wouldn’t help anyone. But more on that later, too.

Once again, there is no Founders Edition, but NVIDIA actually wanted to send a card from Gigabyte. This in turn stuck for what felt like eternities in the over-motivated customs and has not yet arrived here in the lab until today (Monday morning). Again, some creativity was needed over the weekend, so I’m testing with a retail card from Palit. As an OC card, it will already exceed the 279 Euro RRP, but the prices are just like vanilla ice cream at noon in Dubai. The almost identical Palit RTX 3060 Dual OC is currently already far above 700 Euros street price, pointless.

Unfortunately, the half-life of such prices is shorter than the melt-in-the-mouth of sweet delicacies and probably ends up being extremely sour once again. But be that as it may, today we are simply fulfilling our information and education mandate without emotion. The time window, which was once again extremely tight, also meant that a few little things had to fall by the wayside. But anyway, there is enough to read and the day has only 24 hours. The other maps will be reviewed a little later.

The trimmed GA106-150 on the GeForce RTX 3050

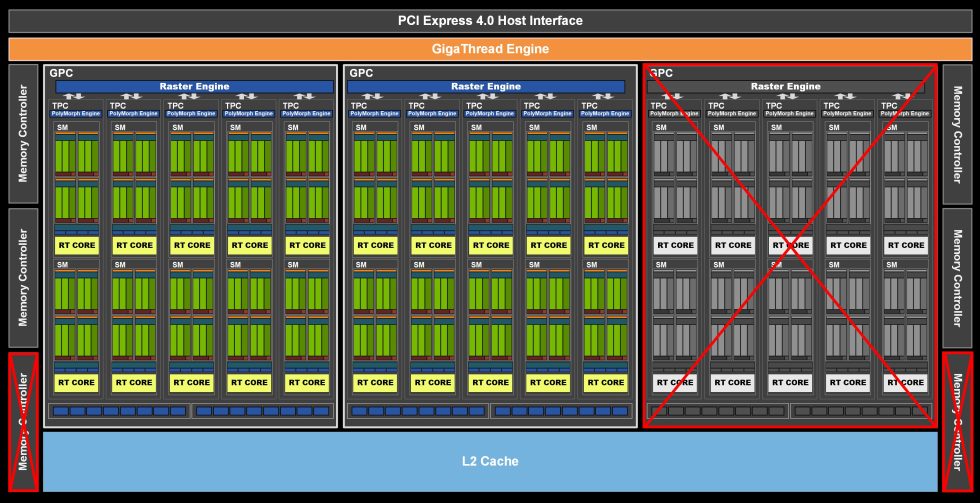

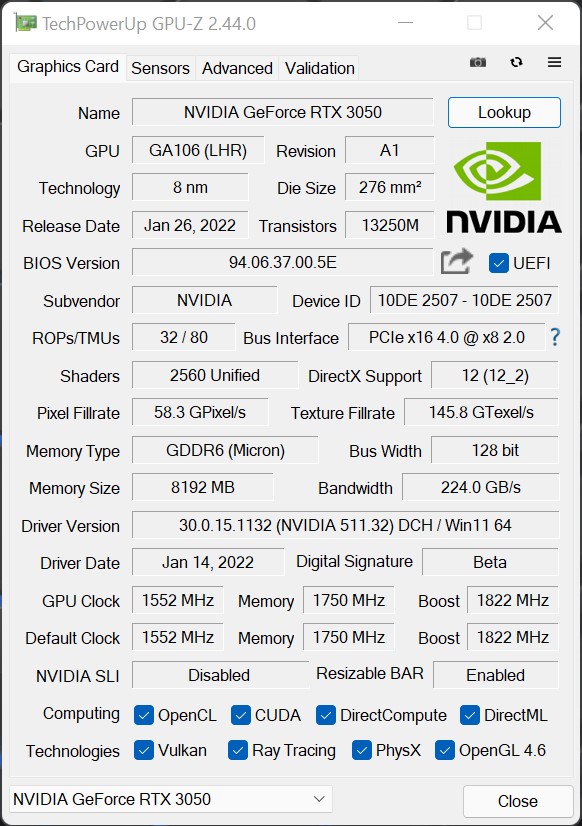

The chip of the NVIDIA GeForce RTX 3050 is also based on the GA106 and has been shortened a bit more. The positioning with an MSRP of 279 Euros for the non-overclocked cards is 50 Euros below the 329 Euros of the GeForce RTX 3060 and 120 Euros below that of the RTX 3060 Ti here. In relation, this is almost right and the lack of plausibility is covered by the general lack of chips anyway. For the GeForce RTX 3050, NVIDIA uses a total of 20 SM (28 for the RTX 3060) of the maximum 30 units of the GA106 (see schematic below), resulting in a total of 2560 (3584 for the RTX 3060) CUDA cores. It is therefore a true 2/3 card. Hooray!

In addition to the CUDA cores, NVIDIA’s GeForce RTX 3060 is also equipped with 20 next-generation RT (ray tracing) cores, 80 Tensor cores, 32 ROPs, and 80 TMUs. As for memory, the GeForce RTX 3050 still has 8 GB of GDDR6 memory with a speed of 14 Gbps, which has a cumulative bandwidth of 224 Gbps on the 128-bit interface of the 4 memory controllers.

If you now extrapolate the remaining 20 SM, the already mentioned 2560 CUDA cores result. Ideally, and only if all units are allowed to work with FP32. The gap to the GeForce RTX 3060 is predictable and less than 2/3 of the full configuration with 30 SM would probably not make sense in the end. At the end of the day, this allows NVIDIA to increase the yield of the GA106, which is not such a bad decision considering the extremely hungry market. Of course, the missing 10 SM (8 less than the RTX 3060) will be noticed, but you simply clock a bit higher and that’s it. Whereby this should depress the efficiency a bit, as we will see later.

Resizeable BAR is already implemented on the hardware side, but this implementation currently works rather so-so. So it is really exciting to see what NVIDIA now offers as a new entry-level RTX package, because cards are generally scarce at the moment and the target group of less well-heeled Full HD gamers really exists. It is exactly this suitability that I will examine in more detail today and this test of course still includes the electrical implementation, the PCB, the power consumption and the cooling. Thus, there is already enough reading material available.

The Palit RTX 3050 Dual OC 8GB

The case of the card follows the familiar Dual design language and is, of course, rather not a real eye-catcher or even an excitement as an entry-level model. The usual mix of black ABS, some light metal and hardware under the hood is thus also nothing that polarizes in any way. There is something positive about this, because the card will probably still look as timeless in a few years as it does now. Radios in the early 1970s with the round sucked corners (Soft Line) didn’t look much different.

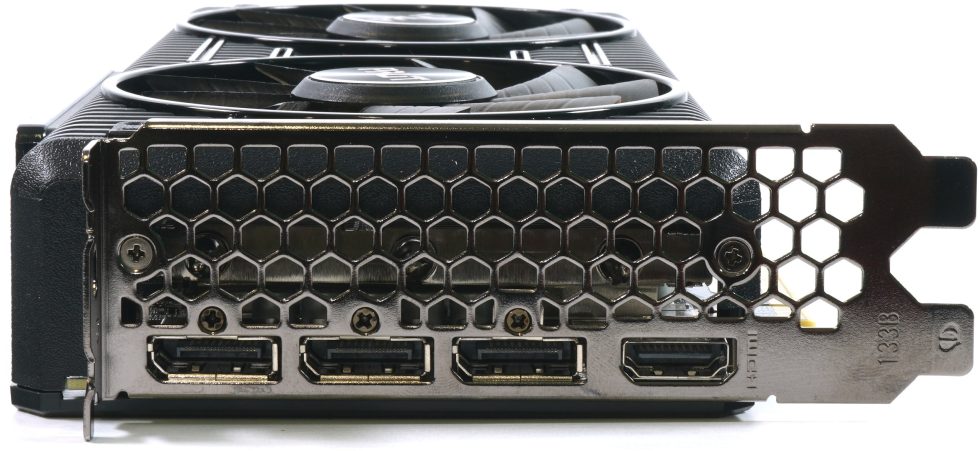

The design with the 3.8 cm installation depth plus the 4 mm for the brushed ABS backplate makes this card a true dual-slot design with all the known advantages and (in this case hardly any) disadvantages. The radiator overhang is trimmed for clearance in the backplate with large honeycomb openings.

With 555 grams, the card is also a real flyweight. The length of 24.4 cm is short (and still much longer than the much shorter PCB) and the installation height of 11.5 cm from the top edge of the PCIe slot with the card installed to the top of the cover is not really lush either.

The single 8-pin connector on the top is completely sufficient and it also visually marks the end of the hidden board. You will see on the next page that the overlong cooler is almost like shooting at a sparrow with a cannon. Of course, there are more details about the cooler design. The NVLINK port has logically been left out, because SLI is dead anyway and not desired here. RGB is found on the upper side as backlight for the GeForce RTX lettering, after all.

The new HDMI 2.1 port should not be missing, nor the three current DisplayPorts, of course. The very large cooling vents show where the wind is (not) blowing from, and that would be the end of the exterior, because the fins are vertical and the honeycomb design has no real function in terms of cooling.

The current GPU-Z screenshot shows us the data of the Palit graphics card once again, the rest I already listed above. The 1552 MHz base clock corresponds to NVIDIA’s reference specification and Palit raises the reference’s 1777 MHz boost clock to 1822 MHz ex-factory. The 1750 MHz memory clock was to be expected and the memory expansion with 8 GB on the 128 bit interface logically as well, when you think of the 4 memory controls with 64 bits each from the schematic shown above.

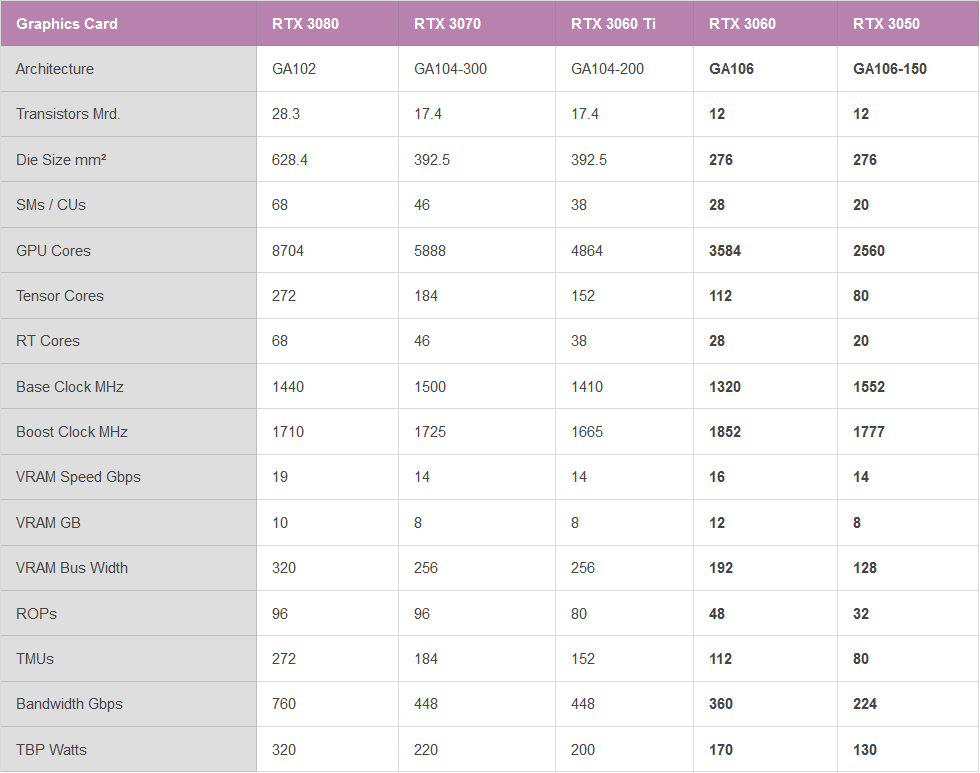

Again, I have a table for all statisticians among you, before it really gets going from the next page on.

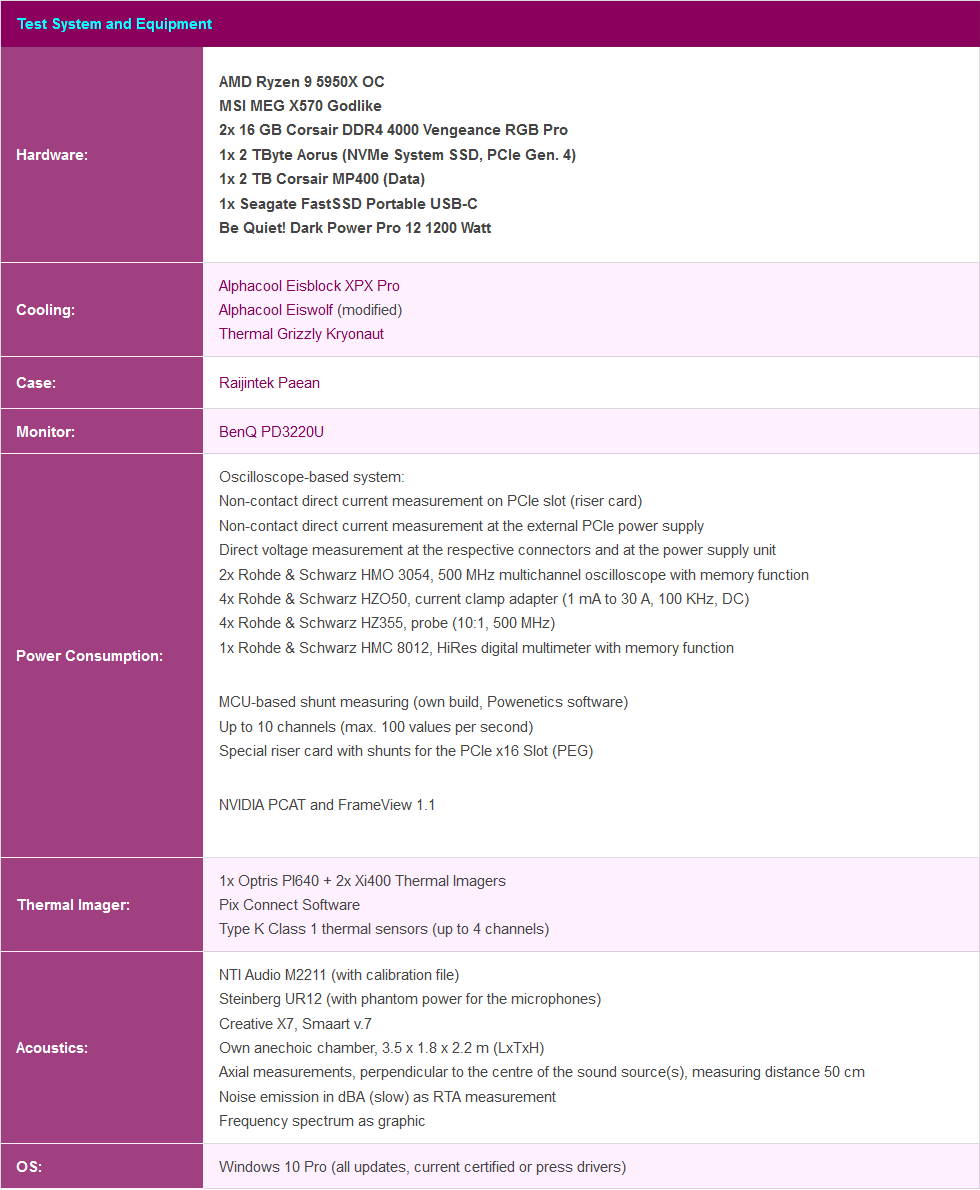

Test system and evaluation software

The benchmark system is new and is no longer in the lab, but in the editorial room again. I now also rely on PCIe 4.0, the matching X570 motherboard in the form of an MSI MEG X570 Godlike, and a select Ryzen 9 5950 X that has been heavily overclocked water-cooled. In addition, there is fast RAM as well as several fast NVMe SSDs. For direct logging during all games and applications, I use NVIDIA’s PCAD, which increases the comfort immensely.

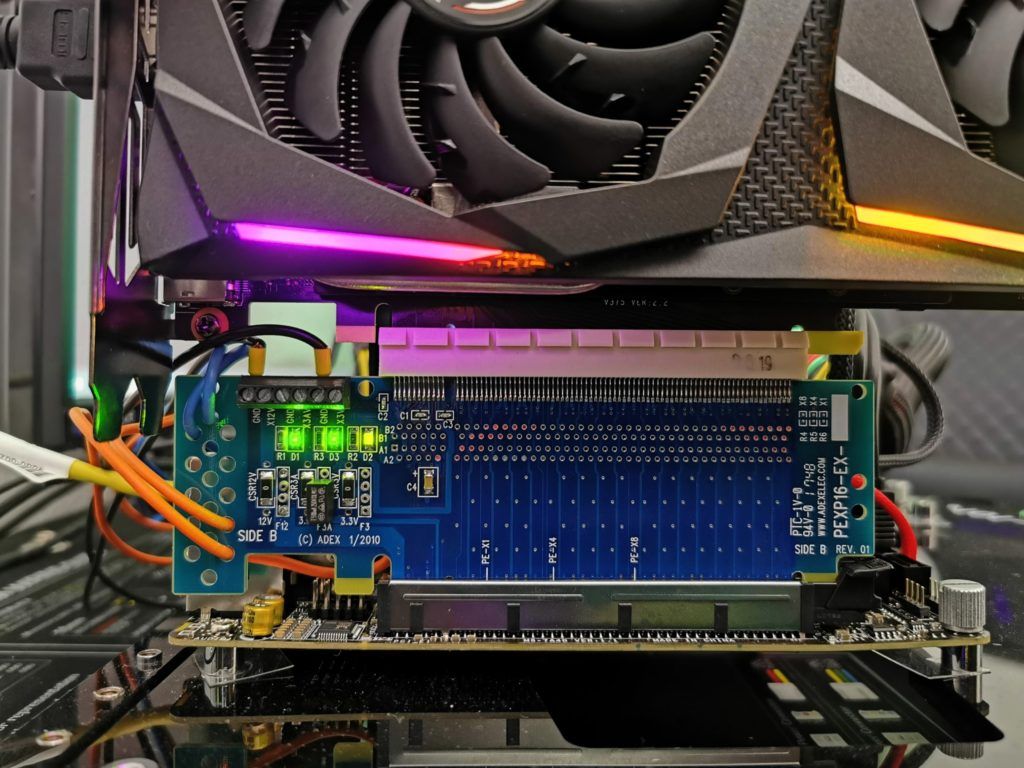

The measurement of power consumption and other things is carried out here in the special laboratory on a redundant test system that is identical down to the last detail, then on two tracks using high-resolution oscillograph technology…

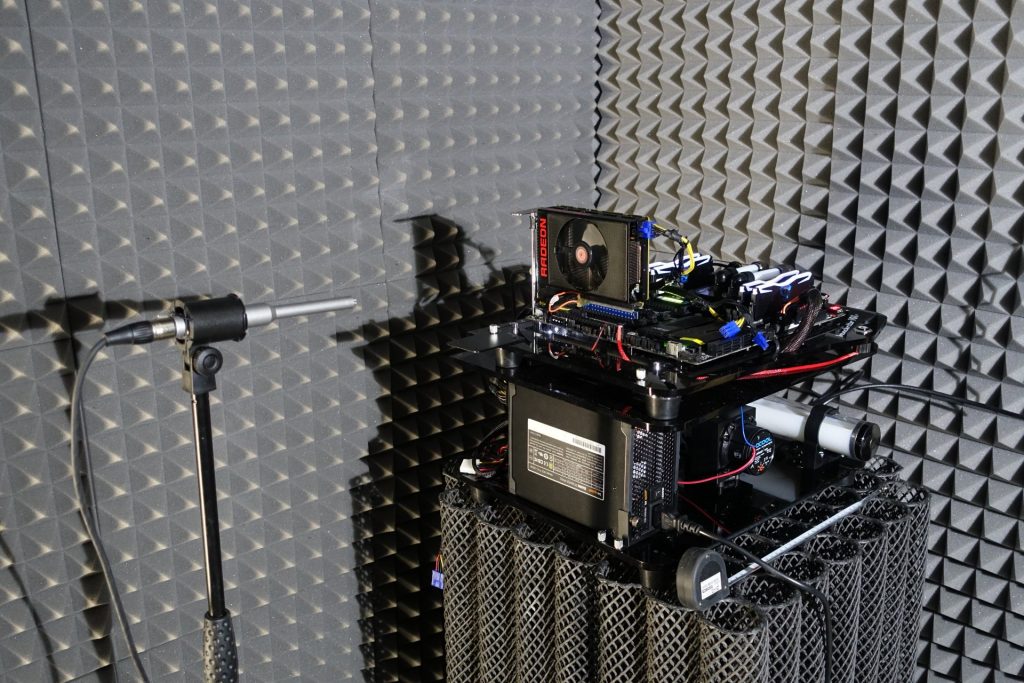

…and the self-created MCU-based measurement setup for motherboards graphics cards (pictures below), where at the end in the air-conditioned room also the thermographic infrared images are created with a high-resolution industrial camera. The audio measurements are done outside in my Chamber.

I have also summarized the individual components of the test system in a table:

- 1 - Intro, Unboxing, Data and Test System

- 2 - Teardown, PCB Analysis and Cooler Details

- 3 - Gaming Performance Full-HD

- 4 - Gaming Performance WQHD

- 5 - Details: Frames per Second (Curve)

- 6 - Details: Percentiles (Curve)

- 7 - Details: Frame Times (Curve)

- 8 - Details: Frame Times (Bar)

- 9 - Details: Variances (Bar)

- 10 - Power Draw of GPU & CPU and Gaming Efficiency

- 11 - Power Consumption, Transients and PSU Recommendation

- 12 - Temperatures, Clock Rate and Infrared Tests

- 13 - Fan Speed, Noise and Frequency Analysis

- 14 - Summary and Conclusion

21 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Veteran

Mitglied

Mitglied

Urgestein

Veteran

Mitglied

Urgestein

Urgestein

Urgestein

Veteran

Mitglied

Veteran

Urgestein

Urgestein

Mitglied

Urgestein

Urgestein

Mitglied

Alle Kommentare lesen unter igor´sLAB Community →