Mit der Revision 456.55 möchte NVIDIA die meisten Probleme der neuen GeForce RTX 3080 und RTX 3090 beheben und hat es auch. Neben den bereits am Anfang immer wieder aufgetretenen Netzteilabschaltungen bei eigentlich nominell ausreichend erscheinenden Stromversorgern waren es vor allem die Crashs bestimmter Karten innerhalb der 3D-Umgebung, die für sehr viel Wirbel sorgten. Zumindest bei der Netzteilproblematik war ich einer der Betroffen, eine crashende Karte ließ sich aber im Nachhinein auch besorgen.

Wichtig: Was wirklich hinter den Abstürzen und Instabilitäten der GeForce RTX 3080 und RTX 3090 stecken könnte

Wichtig: NVIDIA GeForce RTX 3080 und RTX 3090 und die Crashs – Warum die Kondensatoren so wichtig sind…

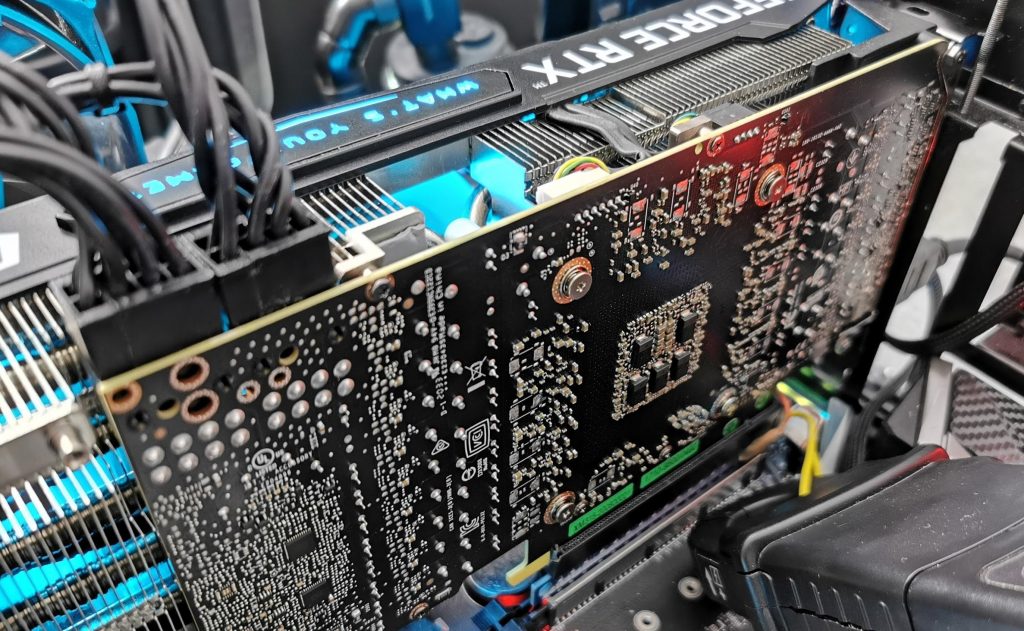

Vor allem die sporadischen CTD-Fehler (Crash to Desktop) waren ja vor einigen Tagen im Fokus meines Interesses, wobei es sich mittweile wohl herausgestellt hat, dass wohl Boost selbst und die doch etwas zu hektisch agierende Spannungsversorgung zu genau den Fehlerbildern geführt hat, die man erkennen konnte und die, wenn man einem logisch nachdenkt, sogar auf eine gemeinsame Ursache zurückzuführen sind. Wenn extreme Spikes auf ein nicht ganz optimales Layout treffen, dann dort für solche Extrem-Szenarien eher unzweckmäßig gewählte Kondensatoren mit ins Spiel kommen und das Ganze dann auch noch mit der Chipgüte und fehlendem Qualitätsmanagement mangels passender Treiber kollidiert, ist das Chaos eigentlich fest vorprogrammiert.

Um die Problematik mit den CTD zu umgehen, konnte man bisher entweder das Power Limit leicht absenken oder den Offset für den Takt etwas zurücknehmen (50 bis 100 MHz), was durchaus als Linderung zu gebrauchen war. NVIDIA hat mit dem aktuellen Treiber einen Eingriff in die Spannungsversorgung vorgenommen, der natürlich dann über die weitere Vernetzung auch die Firmware und den Regelmechanismus betrifft. Interessant ist dabei, dass hier keine Taktabsenkung im herkömmlichen Sinne umgesetztwurde, denn das Bild, das sich unter Volllast und bei den Messungen ergab, ist doch leicht differierend. Sicher, die ganz hohen Taktraten werden, vielleicht, nicht mehr erreicht, aber sie könnten es immer noch, wenn es die Telemetrie aufgrund der äußeren Umstande zuließe (Sensor- und Zustandswerte).

Probleme mit den Lastspitzen am Netzteil

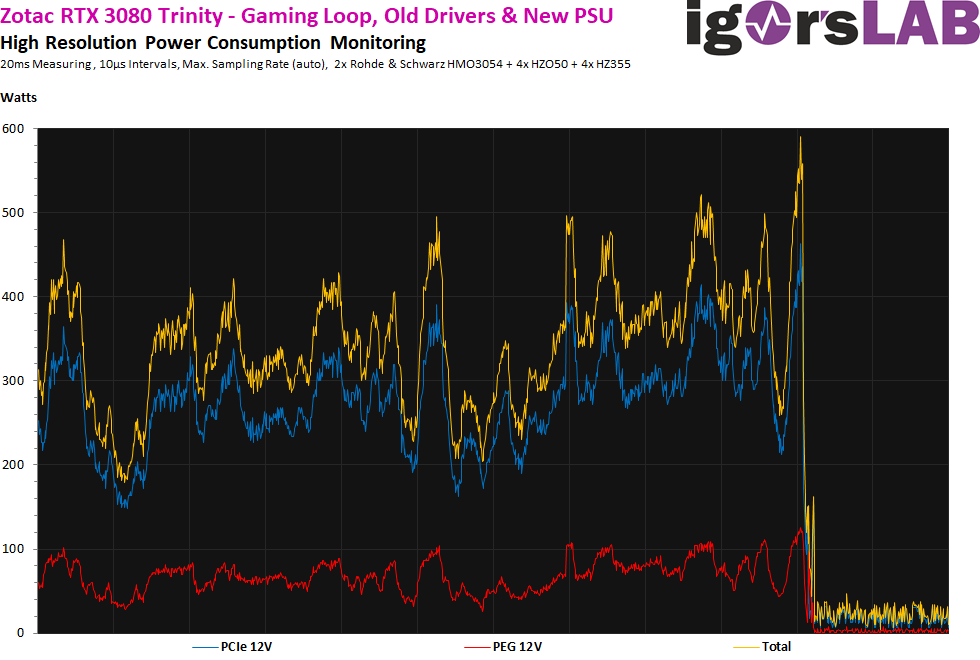

Mit meinem älteren Seasonic-Netzteil konnte ich nämlich eine durchaus interessante Feststellung treffen, die zumindest ab und an auch reproduzierbar war. Denn immer dann, wenn die kurzfristigen Spikes das Netzteil zum Abschalten brachten, war kurz vorher oder zeitgleich auch die GPU am Stabilitätslimit. Der Wechsel auf eine PSU mit etwas später auslösender Schutzschaltung legte dann bei der betroffenen Karte auch das CTD-Problem offen, das mit der alten PSU gar nicht auftrat. Kunststück, denn es wurde ja immer alles abgeschaltet. Ich habe mich genau deshalb noch einmal mit einer Mikrosekunden-genauen Auflösung zwischen Grafikkarte und Netzteil gehängt und versucht, hier einmal den Moment das Grauens zu dokumentieren.

Programme und Hardware wie PCAT oder Auslesesoftware wie GPU-Z sind einfach viel zu langsam, als dass man den eigentichen Zeitpunkt des Zusammenbrechens überhaupt hätte erkennen oder dokumentieren können. Dafür habe ich mir kurzfristig eine der betroffenen Karten besorgen können, war aber deshalb leider nicht in der Lage, physikalisch an dieser nur geliehenen Karte irgendwelche Änderungen vornehmen zu können. Aber es reicht auch so, um den Moment des Crashs zu erfassen. Laut dem Protokoll von GPU-Z war in diesem Moment NICHT der höchste Takt anliegend, sondern man befand sich wohl schon im Step darunter. Genau nachprüfen lässt sich das nicht, denn GPU-Z ist dafür leider einfach zu langsam, selbst wenn man den Sensor-Loop in den Settings beim Intervall auf maximale Kürze setzt.

Also genau in dem Moment, als die maximale Spitze von ca. 600 Watt auftrat, schaltete früher die PSU ab, jetzt war plötzlich die Grafikkarte die Leidtragende der kompletten Überpowerung. Man könnte also geneigt sein und hier einen kausalen Zusammenhang zu sehen. Das wurde mir eigentlich durch den Einsatz des neuen Treibers einmal mehr bestätigt, so dass ich mittlerweile das zum Teil absurde Boostverhalten als eigentlichen Auslöser sehe. Der Rest war dann die Auswertung der Umstände samt deren Folgen.

Das Lastwechselverhalten mit altem und neuem Treiber

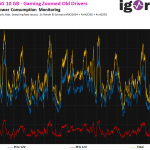

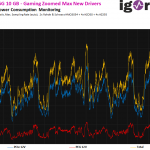

Um nicht abzustürzen, mache ich jetzt alle Tests mit einer stabil laufenden KFA2 RTX 3080 SG 10GB, wobei die Trinity mit den neuen Treibern dann auch (fast) durchgängig lief. Zunächst habe ich die Leistungsaufnahme beim Gaming Loop verglichen. Das Power Limit der Grafikkarte liegt bei 320 Watt, erreicht habe ich beim alten Treiber 318 Watt. Beim neuen Treiber waren es mit 314 Watt dann 4 Watt weniger. Das ist als Differenz weniger als vermutet, setzt aber wirklich ein ordentliches Equipment voraus, das wirklich fast alle Lastwerte erfasst. Je gröber die Auflösung, um so schwankender waren dann sogar die Messungen mit der selben Karte im selben Savegame. Alles ab ca. 10 ms als Intervallgrenze war einfach nicht mehr sauber zu gebrauchen, um überhaupt von ordentlichen Toleranzbereichen sprechen zu können.

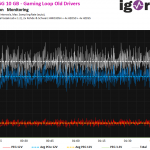

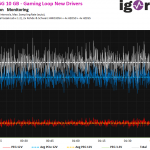

Das Problem dieser Auflösung mit 20 ms ist allerdings, dass man die richtigen Spikes auch nicht sieht, weil sie in der gemittelten Erfassung untergehen und schlichtweg kaputt kumuliert werden. Wechseln wir deshalb einmal in den Mikrosekundenbreich, wo ja auch NVIDIAS Boost agiert. Und siehe da, die Spikes sind jetzt auch deutlich sichtbar. Genau hier sehen wir nun auch den eigentlichen Unterschied bei den Spikes! Waren es mit dem alten Treiber öfters mal zwischen 580 und 600 Watt, sind es nun plötzlich mindestens 70 Watt weniger und auch die Ausprägung und Häufigkeit nehmen stark ab! Wir sehen also sehr gut, wo die fehlenden 4 Watt geblieben sind. Nicht im Durchschnitt, nein, sondern überwiegend in den maximalen Spitzen! Das ist auch einer der Gründe, warum die Performance-Einbuße am Ende wohl doch überschaubar klein ausfallen dürfte. Regelwut eingebremst, sichtbar.

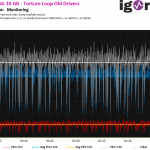

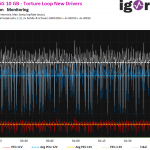

Beim Stresstest sieht man die Unterschiede auf eine andere Art und Weise, denn da helfen uns interessanterweise die 20 ms Intervalle rein optisch sogar besser weiter. Wir sehen im direkten Vergleich, dass die Intervalle der Leistungsbegrenzung deutlich kleiner geworden sind, die Karte also viel schneller auf vermeintliche oder reale Überlasten reagiert. Vergleichen wir zunächst die großen Intervalle und achten einmal auf die Abstände und Form der Einbrüche:

Wo diese Einbrüche herkommen, zeigt und die analog zum Boost mitlaufende Messung im Mikrosekundenbereich, wo man auch den Selbstschutz sehr schön sehen kann:

Und was kostet uns dieser Einschnitt nun an tatsächlicher Performance? genau das erfahrt Ihr auf der nächsten Seite!

Kommentieren