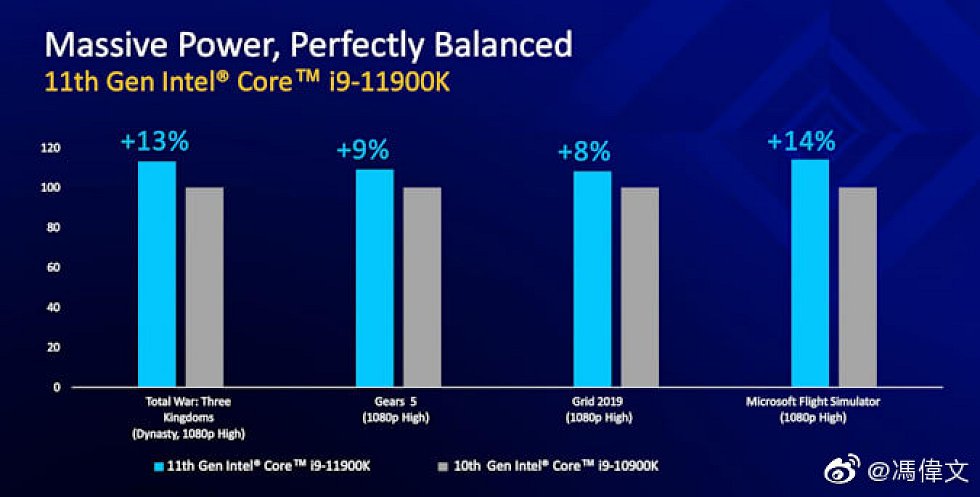

The official slides of Intel’s Rocket Lake, the 11th generation of Intels desktop CPU family was leaked now and at the same time the specifications and the lineup were confirmed, which I already published a few days ago. These new slides are meant to show the gaming potential of the Core i9 CPU compared to the last-gen flagship. According to Intel, the Core i9-11900K is up to 14% faster than the Core i9-10900K CPU – in games mind you.

Massive Power,Perfectly Balanced🤪https://t.co/I5IIqtrWjW pic.twitter.com/uNC3uqcIjj

— HXL (@9550pro) March 10, 2021

The following information comes from XHL and I allow myself now at this point a small, personal side note to the German Intel PR. The argument to exclude editorial offices from sampling because they might leak information in advance is completely illogical and also a contradiction in terms. Anyone who is officially supplied with information must first agree to an embargo/NDA. That would be an elegant solution to this problem.

Nevertheless, I will provide my readers also this time with the usual deeper measurements, especially also to clock, power consumption, cooling and of course to the performance, because the CPUs are long here. The fact that I have not published any of my own content to date and will not do so until March 30, 2021 is thus not even due to a signed embargo against Intel, but simply due to respect for the work of my colleagues who are bound by this NDA. You don’t just charge ahead, even if the odds are in your favor.

The now leaked performance slides show the Intel Core i9-11900K as the new 8-core flagship compared to the previous generation Intel Core i9-10900K with 10 cores. Both CPUs use the same maximum boost clock of 5.30 GHz, but the Core i9-11900K boasts the brand new Cypress Cove cores, which should deliver double-digit performance gains, at least on paper.

All of the games Intel selected were tested at 1080p with the “High Settings” preset. Intel’s own benchmarks show that the Core i9-11900K is up to 14% faster than the Core i9-10900K. The average performance gain over these four games compared to the previous generation is around 11% and that’s quite a decent increase over the last generation, but at the cost of much higher power consumption and power consumption, which of course piques my curiosity and will definitely be part of my own test (spikes and power supply relevance!).

On the topic: Intel Rocket Lake Core i7, Core i9 – The complete CPU lineup including specifications and final boost

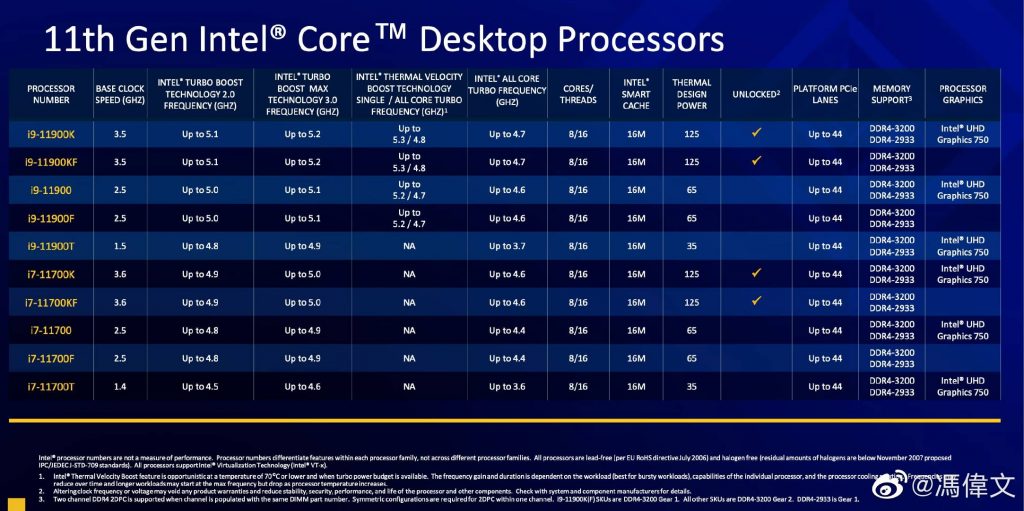

The official slide from Intel confirms the specifications already published recently also here and you even more detailed information about the respective CPUs of the “K” series:

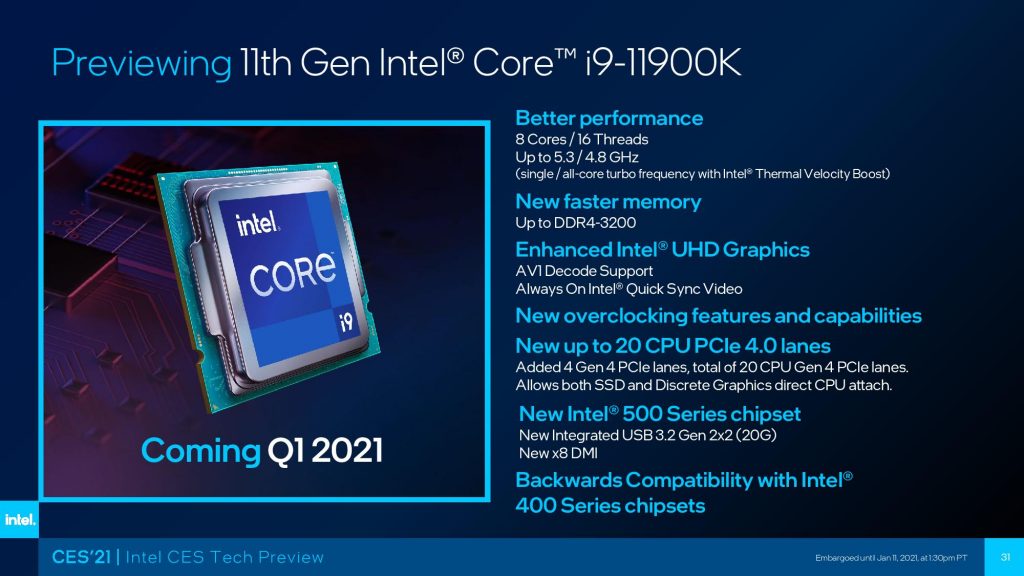

The Intel Core i9-11900K will be the flagship of the 11th generation. Generation with 8 cores and 16 threads. This results in 16 MB L3 cache (2 MB per core) and 4 MB L2 cache (512 KB per core). The base clock of the CPU will be 3.5 GHz and as far as the boost clock is concerned, it will have a clock speed of 5.2 GHz (1-core) while the boost frequency for all cores is expected to be kept at 4.8 GHz. The chip will also feature Thermal Velocity Boost, which should bring another 100 MHz jump in maximum clock speed.

This trick should result in a single-core boost clock of 5.3 GHz maximum on a busy core, which also makes the Core i9-11900K the first CPU to ever reach such a high frequency right out of the box, but it’s also important to remember that regardless of the use of the Cypress Cove cores ,the Core i9-11900K will have fewer cores and threads than the Intel Core i9-10900K. This is partly due to Cypress Cove’s backporting to the more refined 14nm process, and the otherwise exploding power consumption.

The CPU is said to have a power consumption of 125 W, which is currently standard for an Intel flagship, while the power limit of the second stage (PL2) is designed for a whopping 250 W. This means that when the CPU reaches its maximum clock speeds, it could actually pull the aforementioned amount of power from the PSU, making it one of the most power-hungry 8-core chips ever produced. This could also explain why Intel is not a major player in the 11. It’s a good thing that the 3rd generation didn’t go for 10 cores and 20 threads, as that would have been a power-hungry monster of a chip that would have easily surpassed even the 250-watt limit.

With the Core i7, you can see that Intel doesn’t position the core/thread count to a step below the Core i9. The Core i7-11700K thus has the same core configuration as the Core i9-11900K, but comes with slightly reduced clock rates. The chip is said to have a maximum boost clock of 5.0 GHz on a single core and 4.6 GHz across all of its 8 cores. The CPU will even carry the same amount of cache, but the main difference should come from the clocks and performance limits. This lower clocked chip will be around 225-250 W for the PL2 limit, while 125 W for PL1 remains standard. It will also be interesting to see how the Rocket Lake CPUs can be overclocked, as the tiny difference between the Core i9 and Core i7 chips could be overcome with a little overclocking.

The Core i5-11600K is a 6-core chip with 12 threads and should compete against the AMD Ryzen 5 5600X, boasting a clock speed of 4.9 GHz on a single core and 4.6 GHz across all cores, with 12 MB of L3 cache and 3 MB of L2 cache. Thus, this chip will have to prove itself against the AMD Ryzen 5 5600X mainly through its price-performance ratio. Here, of course, the development of street prices and availability must also be taken into account for an evaluation.

45 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Urgestein

Urgestein

Mitglied

Urgestein

Veteran

Urgestein

Veteran

Urgestein

Veteran

Urgestein

Urgestein

Veteran

Urgestein

Urgestein

Urgestein

Veteran

Urgestein

Veteran

Alle Kommentare lesen unter igor´sLAB Community →