Die offiziellen Folien zu Intels Intel Rocket Lake, also der 11. Generation der Desktop-CPU-Familie, wurden jetzt geleakt und gleichzeitig auch die Spezifikationen und das Lineup bestätigt, das ich ja bereits vor einigen Tagen ebenfalls veröffentlicht habe. Diese neuen Folien sollen das Gaming-Potenzial der Core-i9-CPU im Vergleich zum Flaggschiff der letzten Generation zeigen. laut Intel ist der Intel Core i9-11900K bis zu 14% schneller als Core i9-10900K CPU – in Spielen wohlgemerkt.

Massive Power,Perfectly Balanced🤪https://t.co/I5IIqtrWjW pic.twitter.com/uNC3uqcIjj

— HXL (@9550pro) March 10, 2021

Die nachfolgenden Informationen stammen von XHL und ich gestatte mir jetzt an dieser Stelle noch eine kleine, persönliche Randbemerkung an die deutsche Intel-PR. Das Argument, Redaktionen vom Sampling auszuschließen, weil diese ja vielleicht Informationen vorab leaken könnten, ist komplett unlogisch und zudem ein Widerspruch in sich. Wer offiziell mit Informationen versorgt wird, muss vorher einem Embargo/NDA zustimmen. Damit ließe sich dieses Problem ja elegant lösen.

Trotzdem werde ich meine Leser auch dieses Mal mit den gewohnten tiefergehenden Messungen, vor allem auch zu Takt, Leistungsaufnahme, Kühlung und natürlich auch zur Performance versorgen, denn die CPUs liegen längst hier. Dass ich bisher keine eigenen Inhalte veröffentlicht habe und dies bis zum 30.03.2021 auch nicht tun werde, liegt somit noch nicht einmal an einem unterzeichneten Embargo gegenüber Intel, sondern einfach nur an der Achtung vor der Arbeit meiner Kollegen, die an dieses NDA gebunden sind. Da prescht man nicht einfach vor, auch wenn die Quote winkt.

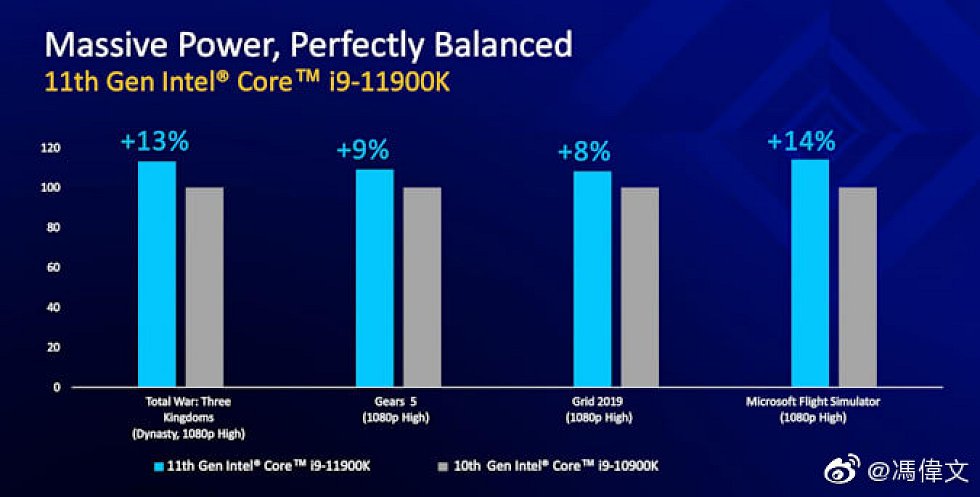

Die nun geleakten Performance-Folien zeigen den Intel Core i9-11900K als neues 8-Kern-Flaggschiff im Vergleich zum Intel Core i9-10900K mit 10 Kernen der vorhergehenden Generation. Beide CPUs nutzen den gleichen, maximalen Boost-Takt von 5,30 GHz, jedoch kann der Core i9-11900K mit den brandneuen Cypress-Cove-Kernen aufwarten, die zumindest auf dem Papier zweistellige Leistungssteigerungen liefern sollen.

Alle von Intel ausgewählten Spiele Spiele wurden bei 1080p mit der Voreinstellung “High Settings” getestet. Intels eigene Benchmarks zeigen, dass der Core i9-11900K bis zu 14 % schneller ist als der Core i9-10900K. Der durchschnittliche Leistungszuwachs über diese vier Spiele gegenüber der vorherigen Generation liegt bei etwa 11 % und das ist durchaus eine ordentliche Steigerung gegenüber der letzten Generation, allerdings auf Kosten einer viel höheren Leistungsaufnahme und eines höheren Stromverbrauchs, was natürlich meine Neugier weckt und garantiert Bestandteil meines eigenen Tests sein wird (Spikes und Netzteil-Relevanz!).

Zum Thema: Intel Rocket Lake Core i7, Core i9 – Das komplette CPU-Lineup samt Spezifikationen und finalem Boost

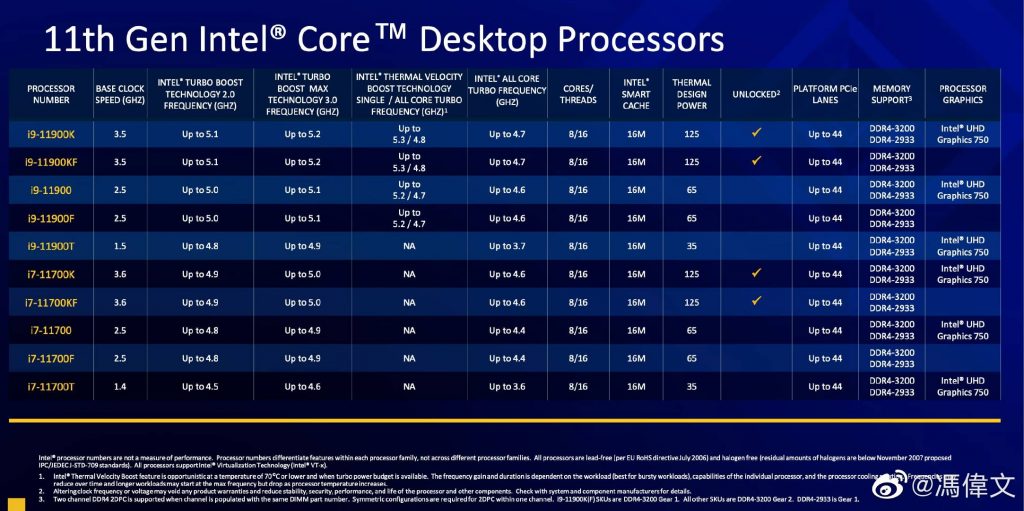

Die offizielle Folie von Intel bestätigt die bereits vor kurzem auch hier veröffentlichten Spezifikationen und Sie noch weitere detaillierte Informationen zu den jeweiligen CPUs der “K”-Serie:

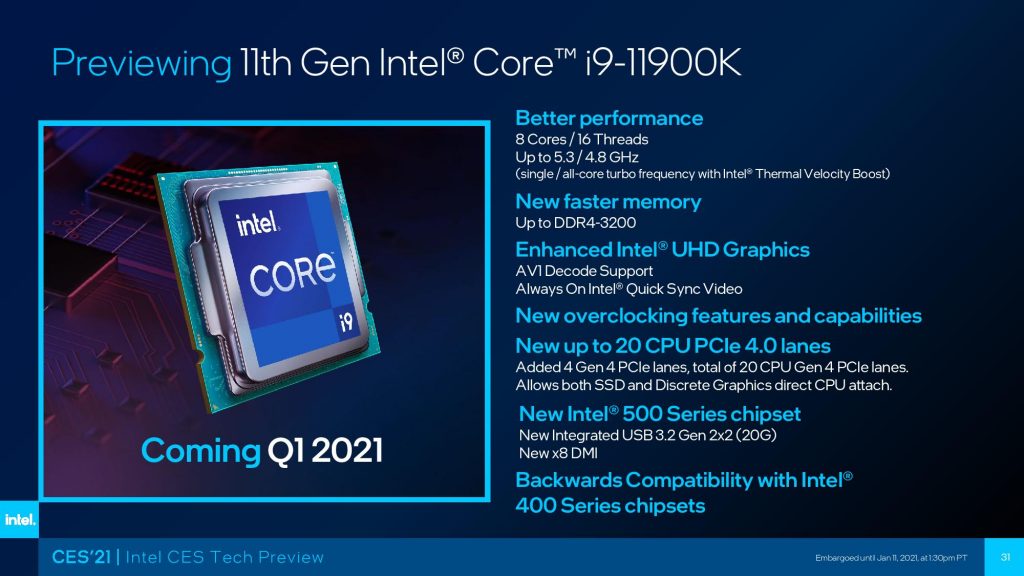

Der Intel Core i9-11900K wird das Flaggschiff der 11. Generation mit 8 Kernen und 16 Threads. Daraus resultieren 16 MB L3-Cache (2 MB pro Kern) und 4 MB L2-Cache (512 KB pro Kern). Der Basistakt der CPU wird bei 3.5 GHz liegen und was den Boost-Takt angeht, so wird sie einen Takt von 5,2 GHz (1-Kern) aufweisen, während die Boost-Frequenz für alle Kerne bei 4,8 GHz gehalten werden soll. Der Chip wird außerdem über Thermal Velocity Boost verfügen, was einen weiteren Sprung von 100 MHz in der maximalen Taktfrequenz bringen soll.

Dieser Trick sollte zu einem Single-Core-Boost-Takt von maximal 5,3 GHz bei einem ausgelasteten Kern führen, was den Core i9-11900K auch zur ersten CPU macht, die jemals eine so hohe Frequenz direkt out of the box erreicht hat. Man darf aber auch nicht vergessen, dass der Core i9-11900K, unabhängig von der Verwendung der Cypress Cove-Kerne ,weniger Kerne und Threads als der Intel Core i9-10900K aufweisen wird. Dies ist teilweise auf die Rückportierung von Cypress Cove auf den verfeinerten 14-nm-Prozess zurückzuführen und die sonst explodierende Leistungsaufnahme.

Die CPU soll eine Leistungsaufnahme von 125 W aufweisen, was aktuell ja Standard für ein Intel-Flaggschiff ist, während die Leistungsbegrenzung der zweiten Stufe (PL2) auf satte 250 W ausgelegt ist. Das bedeutet, dass die CPU beim Erreichen ihrer maximalen Taktraten tatsächlich die genannte Menge an Energie aus dem Netzteil ziehen könnte, was sie zu einem der stromhungrigsten 8-Kern-Chips macht, die je produziert wurden. Dies könnte auch erklären, warum Intel bei der 11. Generation nicht auf 10 Kerne und 20 Threads gesetzt hat, da dies ein stromhungriges Monster von einem Chip geworden wäre, der sogar die 250-Watt-Grenze locker übersprungen hätte.

Beim Core i7 ist zu erkennen, dass Intel die Kern-/Thread-Anzahl nicht auf eine Stufe unterhalb des Core i9 positioniert. Der Core i7-11700K verfügt somit über die gleiche Kernkonfiguration wie der Core i9-11900K, kommt aber mit leicht reduzierten Taktraten in den Handel. Der Chip soll einen Boost-Takt von maximal 5,0 GHz auf einem einzelnen und 4,6 GHz über alle seine 8 Kerne aufweisen. Die CPU wird sogar die gleiche Menge an Cache tragen, aber der Hauptunterschied sollte von den Takten und Leistungsgrenzen kommen. Dieser niedriger getaktete Chip wird bei etwa 225-250 W für das PL2-Limit liegen, während 125 W für PL1 Standard bleibt. Es wird zudem interessant sein zu sehen, wie sich die Rocket Lake CPUs übertakten lassen, da der winzige Unterschied zwischen den Core i9 und Core i7 Chips durch eine kleine Übertaktung überwunden werden könnten.

Der Core i5-11600K ist ein 6-Kern-Chip mit 12 Threads und sollte gegen den AMD Ryzen 5 5600X antreten und eine Taktrate von 4,9 GHz auf einem einzelnen und 4,6 GHz über alle Kerne aufweisen und über 12 MB L3-Cache und 3 MB L2-Cache verfügen. Damit wird sich dieser Chip gegenüber dem AMD Ryzen 5 5600X vor allem durch sein Preis-Leistungs-Verhältnis beweisen müssen. Hier müssen für eine Bewertung natürlich auch die Entwicklung der Straßenpreise und die Verfügbarkeit mit einbezogen werden.

45 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Urgestein

Urgestein

Mitglied

Urgestein

Veteran

Urgestein

Veteran

Urgestein

Veteran

Urgestein

Urgestein

Veteran

Urgestein

Urgestein

Urgestein

Veteran

Urgestein

Veteran

Alle Kommentare lesen unter igor´sLAB Community →