Um einerseits den Spekulations-Faktor möglichst niedrig zu halten und andererseits nicht gleichzeitig eines der NDAs zu verletzen, musste ich diesmal etwas weiter ausholen. Das eigentliche Problem waren aber die extrem verschiedenen Puzzlestücke beider Hersteller in diversen Verlautbarungen, was eine Vorschau auf Rasterleistung beider Karten nicht gerade vereinfacht. Unterschiedlichste Settings oder Spiele, fehlende Details und vieles mehr sind nicht gerade eine seriöse Einladung, um solche Spekulationen ohne faden Beigeschmack zu veröffentlichen. Zumal ich bei der RTX 4080 ja bereits unter NDA stehe und bei der RX 7900XTX nicht. Und so ist der gesamte Artikel natürlich trotzdem noch hochspekulativ, weil es ja im letzten Moment auch noch völlig anders kommen könnte. Aber so ganz falsch dürfte die heute Rechnung trotzdem nicht sein. Lassen wir uns später dann einfach überraschen.

Wir schätzen eine Radeon RX 7900XTX im “Best Case” von AMD

AMD hat beim Ankündigungs-Event am 03.11.2022 in seinen Folien leider nur sehr wenige, handverlesene Spieletitel aufgeführt und das Meiste zudem mit “Up to” deklariert. Da die Raytracing-Leistung der GeForce RTX 4080 16 GB als von AMD erklärter Gegnerin nur schwer mit dem Taschenrechner hochzurechnen ist, beschränke ich mich heute auf die reine Raster-Leistung der neuen Karte und werde erst am Schluss noch eine Art Prognose zu DXR wagen. Der “Best Case” in Ultra-HD war übrigens Cyberpunk 2077 mit dem Faktor 1.7 gegenüber der Radeon RX 6950XT, von der ich ausgehe, dass es eine Referenzkarte gewesen sein soll.

Deshalb habe ich mangels Referenzkarte meine werksübertaktete MSI RX 6950XT Gaming X Trio zunächst im Auslieferungszustand mit deutlich höherem Power Limit und Takt gemessen. Danach habe ich die Daten des Referenz-BIOS mittels MorePowerTool in die PowerPlayTables geschrieben und zusammen mit Boardpartner-Karte genutzt, um diese werksübertaktete Karte wieder dem Referenz-Niveau anzugleichen. Danach habe ich die zweiten Benchmarks erstellt, die mir nun als Basis für die Radeon RX 6950XT dienen, wie auch AMD sie genutzt haben dürfte. Mit den FPS-Werten der sehr unterschiedlichen Settings kann man relativ einfach auch die gesteigerte Leistungsaufnahme der CPU (gemessen) ins Verhältnis setzen und für die neue Karte hochrechnen. Ein Plausibilitätstest mit den Messwerten für die GeForce RTX 4090 FE bestätigte das dann recht genau.

AMD nennt für Cyberpunk 2077, Ultra-HD und Ultra-Preset den Faktor 1.7, um den die RX 7900XTX im gewählten Setting schneller sein soll. Diesen Multiplikator habe ich nun genutzt, um alle aufgezeichneten, einzelnen Frames der RX 6950XT entsprechend zu modifizieren und die Frame Time passend herunterzurechnen. Das ist bei den Perzentilen allerdings sehr spekulativ, denn dazu fehlt von AMD leider jegliche Angabe. Aber ich gehe mal davon aus, dass sich hier gar nicht nicht so viel geändert haben dürfte. Es könnte maximal etwas besser ausfallen. Immer vorausgesetzt, der von AMD angegebene Wert mit dem 1.7 stimmt auch.

Übertaktung der Referenzkarte? Das wird knapp!

AMD setzt die Radeon RX 7900XTX auf eine TBP von 355 Watt. Da beide externen 8-pin Buchsen in der Summe 300 Watt zulassen, entfallen auf den PCIe-Slot maximal 66 Watt, von denen 55 Watt bereits veranschlagt wurden. Damit bliebe ein Spielraum von nur 11 Watt für eine mögliche und normgerechte Übertaktung mit Anhebung des Power Limits, was aber eher symbolisch ist, weil es sehr mager ausfällt. Alles, was darüber hinaus geht, würde bereits gegen die geltenden Normen der PCI SIG verstoßen. Man kann natürlich vermuten, dass die TBP ursprünglich deutlich niedriger lag und man bei AMD erst später die TBP noch aufgebohrt und den möglichen Übertaktungsspielraum des Kunden bereits in den Werkstakt übernommen hat.

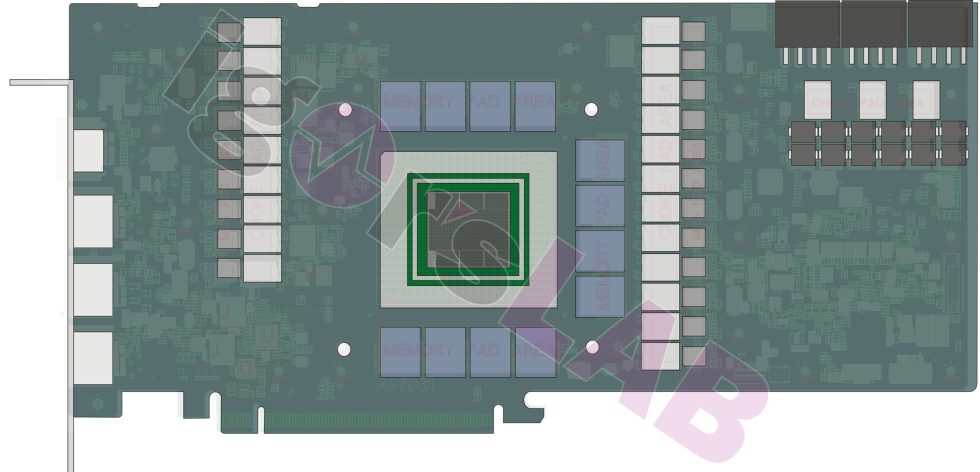

Die 11 Watt bis zur Normgrenze dienen dann eher als Puffer für die Messungen, weil die aufgeheizten Spannungswandler in der Regel ineffizienter arbeiten. Zumindest hat AMD diesmal aufgepasst und den Fehler der Radeon RX 480 nicht wiederholt. Die Symbolgrafik einer Boardpartner-Karte mit drei 8-Pin-Buchsen hatte ich ja bereits schon so ähnlich gezeigt (sowie heute um eine echtes AIB-Overlay ergänzt, das beweist, wie richtig meine Schätzung war). Die bereits veröffentlichten Rendergrafiken der Boardpartnerkarten (z.B. Asus) bestätigen meine Grafik in vollem Umfang, auch was die Ausstattung der Karte und das (theoretisch) maximal mögliche Power Limit von nunmehr 516 Watt betrifft. Das wird in der Praxis wohl eher ein lüsternes Gedankenspiel bleiben, denn es wird sich kaum realistisch und noch vertretbar in Performance umsetzen lassen.

Eine kleine Randnotiz kann ich ja noch mit einbinden: die AIB-Karten werden für die Radeon RX 7900XTX und RX 7900XT die gleichen Platinen verwenden. Je nach AIB muss die kleinere Karte vielleicht auf den einen oder anderen Spannungswandler verzichten, bei manchen AIB aber auch nicht. Das macht die Verfügbarkeit passender Wasserblöcke für die Hersteller der Zubehörkühler deutlich einfacher. Und wie setzen sich die 355 Watt nun genau zusammen? Auch das kann man in etwa hochrechnen, wenn man die üblichen (und damit bekannten Komponenten) zugrunde legt und auch die Spannungswandler analog zur Verlustleistung der Karte mit einpreist. Auch diese Werte sind rein hypothetisch und nicht in Stein gemeißelt, bieten aber schon einmal einen gewissen Überblick:

| GPU (einschl. Speichercontroller) | 240 Watt |

| 24 GB GDDR6 (12 Module á 2 GB) | 30 Watt |

| Spannungswandlerverluste GPU (DRMOS, Spulen) | 30 Watt |

| Spannungswandlerverluste Speicher (DRMOS, Spulen) | 10 Watt |

| Platinenverluste | 17 Watt |

| Sonstiges (Kleinspannungen, Lüfter, MCU, LED usw.) | 28 Watt |

| Total Board Power (TBP) | 355 Watt |

Die GeForce RTX 4080 FE 16 GB bräuchte eine andere Betrachtung…

Hier liegt die Sache leider komplett anders. Ich schrieb ja schon: NDA. Aus den bereits von NVIDIA selbst veröffentlichten Benchmarks kann man aber ableiten, dass die Rasterleistung in Cyberpunk 2077 ca. 15% bis 20% über der NVIDIA GeForce RTX 3090 Ti FE und noch ca. 10% über der hier getesteten und sehr hoch übertakteten Boardpartnerkarte in Form der MSI GeForce RTX 3090 Ti SUPRIM X liegen dürfte. Das ist der einzige Anhaltspunkt, der bereits aus den im Netz befindlichen Daten abgeleitet werden kann. Deshalb steht die somit mutmaßlich ca. 10% langsamere RTX 3090 Ti in meinen Charts stellvertretend für die GeForce RTX 4080, die ja am 16.11.2022 gelauncht wird. Den Rest müsst Ihr Euch einfach selbst dazu denken. Oder warten, auch wenn es schwer fällt. Dummerweise war meine Schätzung der RTX 4080 einfach zu genau, um nicht als mutmaßliche NDA-Verletzung durchzugehen.

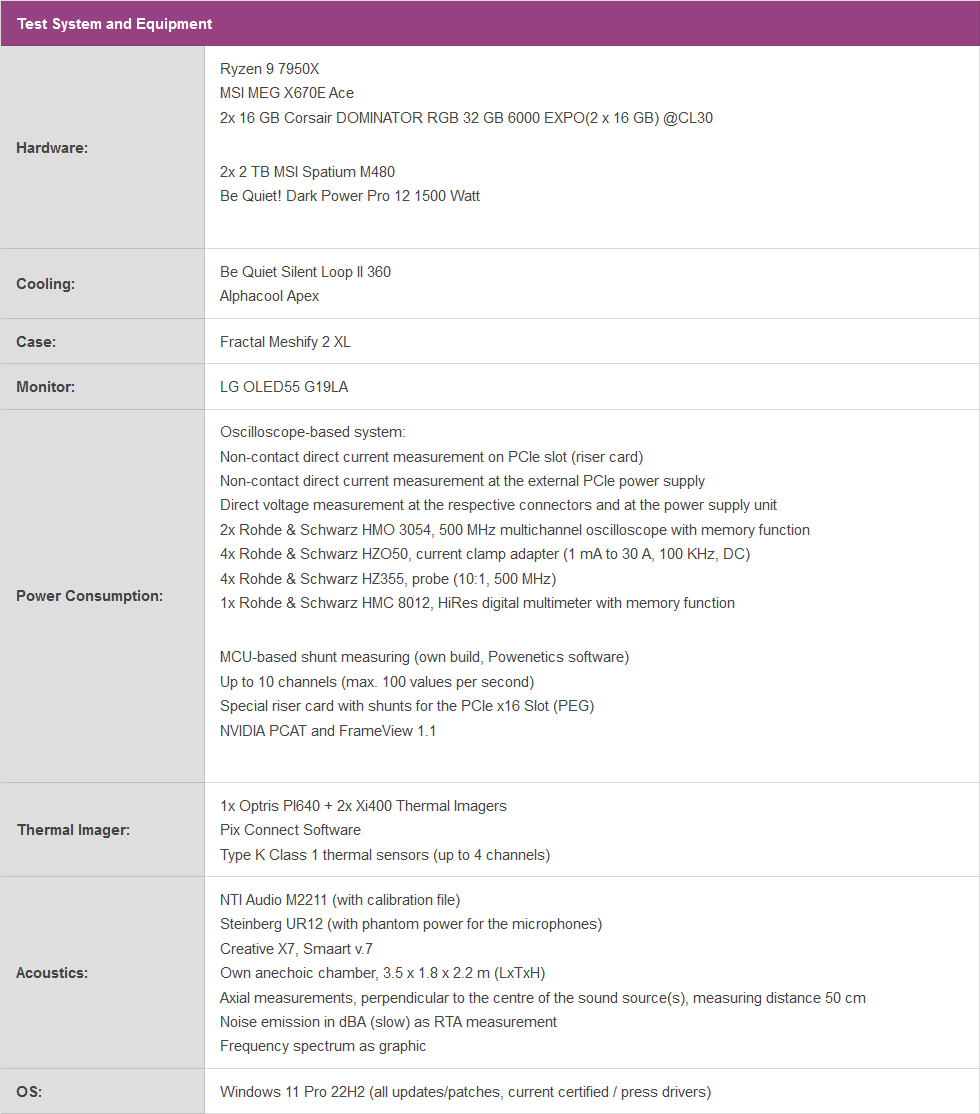

Test-Setup

Auf vielfachen Wunsch hin setze ich auf ein geschlossenes System, das in Form eines für igor’sLAB speziell von MIFCOM zusammengestellten PCs (exemplarischer Produktlink, kein Affiliate) diesmal eine praxisbezogene Basis bietet. Das verwendete Gehäuse ist richtig gut, besitzt genügend Innenvolumen und dazu auch noch einen vorzüglichen Airflow. Die verwendete AiO-Kompaktwasserkühlung in Form der Silen Loop II von Be Quiet passt optisch zur GeForce RTX 4090 FE und die RGB-Akzente von RAM und Motherboard lassen sich im Zweifelsfall entweder auf schlichtes Weiß setzen oder gleich ganz ausschalten. Wenn es einem mal wieder zu bunt werden sollte.

Ich habe bei meiner Zusammenstellung bewusst auf das ganze Bling-Bling verzichtet, nutze aber eine aktuelle AMD-CPU und ein solides Motherboard für den potenten Unterbau. Hier habe ich für Euch noch ein paar Bilder meines Testsystems aus dem Labor samt der mitgetesteten NVIDIA RTX 4090 Founders Edition 24GB. Der PC wurde von MIFCOM schön ordentlich zusammengebaut (ich habe es ja immer so mit den Kabeln) und kann in dieser Konfiguration (siehe weiter unten) genau so oder auch modifiziert beim Händler erworben werden. Mir war es hier einfach wichtig, eine marktübliche Lösung zu nutzen und nicht meine extrem gechillte Labor-Hardware in der Klima-Oase.

Zwischen Seitenwand (Glas) und Grafikkarte bleibt genügend Platz und der Stauraum des XL-Gehäuses wurde nicht einmal annähernd genutzt. Somit haben sogar auch alle anderen getesteten Karten noch genügend Platz zum Atmen. Das sollte also passen. In der Front brauche ich zudem nur zwei Lüfter.

Die einzelnen Komponenten des Testsystems habe ich auch noch einmal tabellarisch zusammengefasst:

101 Antworten

Kommentar

Lade neue Kommentare

Veteran

Veteran

Urgestein

1

Urgestein

Mitglied

Urgestein

Urgestein

Urgestein

Neuling

1

Urgestein

Urgestein

1

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →