Auch wenn die Übertaktung des Arbeitsspeichers im Vergleich zu CPU und GPU wahrscheinlich den geringsten Einfluss auf dein tägliches Computererlebnis hat, können bestimmte speicherempfindliche Anwendungen einen großen Schub durch die Optimierung des Arbeitsspeichers deines PCs erfahren, wie wir in unserem Cyberpunk 2077 Speicher-Roundup behandelt haben. Deshalb wollen wir heute zeigen, wie wir RAM-Kits übertakten und – ebenso wichtig – Stabilitätstests durchführen, und wie du das auch tun kannst. Dies soll ein allgemeiner Leitfaden und Überblick über die Faktoren sein, die du bei der Übertaktung deines Systemspeichers beachten solltest.

Da diese viele Variablen beinhalten, die oft Plattform-, Mainboard- oder manchmal sogar BIOS-spezifisch sind, ist es schwer, in diesem Rahmen genaue Empfehlungen zu geben. Wir versuchen jedoch, ein vollständiges Bild zu vermitteln und werden den Guide aktualisieren, sollten uns neue Fakten zu Ohren kommen. Wenn ihr die meisten Grundlagen wie Takte, Timings etc. bereits kennt und keine Lust auf Faktencheck habt, könnt ihr die jeweiligen Seiten natürlich auch überspringen. Dieser Leitfaden ist keineswegs das perfekte Tutorial, sondern soll viel mehr eher eine Sammlung von Best Practices und Dingen, auf die man achten sollte, erstellt von der Community, für die Community.

Hier noch einmal die Erinnerung zu Cyberpunk 2077:

Mögliche Datenkorruption – Ein wichtiger Disclaimer, den jeder unbedingt vorher lesen sollte

Zuallererst müssen wir mit einem wichtigen Disclaimer beginnen. Wenn man seine CPU oder GPU übertaktest, stürzt das System im schlimmsten Fall ab oder hat einen Bluescreen, startet dann neu und man ist wieder auf einem sauberen Blatt OC-Papier. Aber wenn ein RAM-OC instabil ist, kann es sein, dass man es erstens nicht sofort bemerkt und dies zweitens schwerwiegende Folgen hat, in Form von Datenkorruption oder komplett irreparablen Schäden am Betriebssystem.

Wenn ein PC ein Gehirn ist, das ständig Daten verarbeitet, ist eine instabile Speicher-Übertaktung im Grunde so, als würde dieses Gehirn Alzheimer bekommen. Erinnerungen können korrumpiert, verändert oder ganz verloren werden. Natürlich sollte man in diesem Zustand keine wichtigen Arbeiten erledigen oder gar Dateisystemreparaturen durchführen willst, wie sie bei Systemabstürzen oft automatisch beim nächsten Start ausgelöst werden, da diese “Reparaturen” in einem instabilen Zustand oft noch größeren Schaden anrichten können.

Daher ist die Überprüfung der Stabilität der RAM-Übertaktung eines Systems unerlässlich, um sicherzustellen dass Daten intakt bleiben und sich das Betriebssystem nicht langsam selbst kaputt repariert. Wie stellt man aber die Stabilität sicher, während das System läuft, wenn man gleichzeitig aber nicht sein normales Betriebssystem hierfür verwenden möchte?

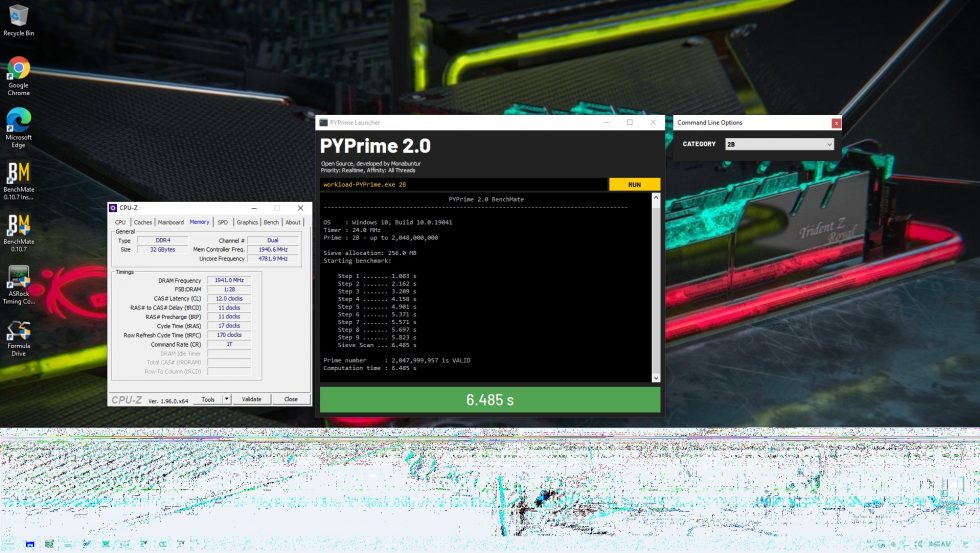

Im Grunde läuft es immer darauf hinaus, ein separates Bootmedium zu haben, mit dem man die Stabilitätsprüfung durchführt, bevor man auf das eigentliche Bootmedium, also das eigentliche OS, zurück wechselt. Ein sehr bekanntes Tool dafür ist Memtest86, das es schon lange gibt und in Form von ISO-Images zum Booten von USB-Sticks erhältlich ist. Damit kann man seinen RAM auf Stabilität testen und sonst nichts. Auch einige Mainboard-BIOS haben Memtest86 mittlerweile bereits integriert, so dass man sich nicht einmal mit separaten Medien herumschlagen muss.

Für schnelle Tests ist dieser Ansatz gut geeignet, z.B. um zu überprüfen, ob ein RAM-Kit tatsächlich stabil ist und die XMP-Spezifikationen des Herstellers erfüllt oder ob ein einzelnes Modul vielleicht sogar defekt ist. Für die manuelle Übertaktung und das Tuning des Arbeitsspeichers für die beste Performance würde ich jedoch immer eine separate und vollständige Windows-Installation empfehlen. Der Grund dafür ist einfach, dass man von dort aus mehrere verschiedene Stabilitätstest-Programme laufen lassen kann, zu denen wir später noch kommen werden. Zudem kann man so auch überprüfen, ob sich die Leistung tatsächlich verbessert und nicht verschlechtert hat, was vor allem dann passieren kann, wenn man nur einen Teil der Speichertimings manuell tunet.

Ich empfehle daher sich eine kleine SSD zu besorgen, etwa 120 GB, die man heutzutage ja relativ günstig bekommen kann. Darauf kommt dann eine separate Windows-Installation mit den Apps, die du zum Testen von Stabilität und Leistung des RAM-OCs verwendet. Bevor man dann mit dem Übertakten deines Arbeitsspeichers beginnt, entfernt man alle Medien wie SSDs oder HDDs, die wichtige Daten tragen, vom System. Jetzt schließt man nur die dedizierte Windows-Installations-SSD für die RAM-Tests an und beginnt erst dann mit dem Tuning deines Speichers. Und erst wenn man das System erfolgreich auf vollständige Stabilität geprüft hat, schließt man wieder seine regulären Medien an und starte das tägliche Betriebssystem.

Das hört sich wahrscheinlich nach Overkill an, aber vertraut mir, wenn man einmal sensible Daten durch einen nur geringfügig instabilen RAM-OC verloren hat, ist es das nicht mehr. Vorsicht ist bekanntlich besser als Nachsicht.

Plattformgrenzen und Leistungsüberprüfung

Ein weiterer Aspekt, über den man sich bewusst sein sollte, bevor man mit dem Übertakten beginnt, sind die Grenzen der Plattform, mit der man arbeitet. Ein Paradebeispiel dafür ist das Infinity Fabric-Taktlimit bei modernen AMD Ryzen CPUs, bei dem man den Speichertakt nicht über den höchsten stabilen Wert für den 1:1-Synchronbetrieb mit dem Speichercontroller und dem Cache hinaus überschreiten will, um Leistungseinbrüche zu vermeiden.

In einem Fall, in dem das maximale stabile IF Clock Limit einer gegebenen CPU bei 1900 MHz liegt, will man also in 99% der Fälle den RAM mit DDR4-3800 und nicht darüber betreiben. Das bedeutet jedoch nicht, dass man den RAM nicht über diesen Punkt hinaus “übertakten” kann, da die Timings ebenso wichtig für die Leistung des Speichers sind. Die Timings zu straffen, während der Speichertakt gleich bleibt, kann nämlich auch einen großen Leistungszuwachs bringen.

Auch die Anzahl der Speicherkanäle und Ranks pro Kanal und damit die Belastung des integrierten Speichercontrollers (IMC) deiner CPU, die Speichertopologie deines Mainboards, die Speicher-ICs auf deinen RAM-Modulen und sogar der Aufbau des PCBs der RAM-Module können Limitierungen sein. Meistens wird man sich dieser gar nicht bewusst sein, bis man dann auf sie stößt. Aber man sollte in jedem Fall wissen, dass es beim RAM-OC Faktoren gibt, die man nicht oder nur indirekt kontrollieren kann.

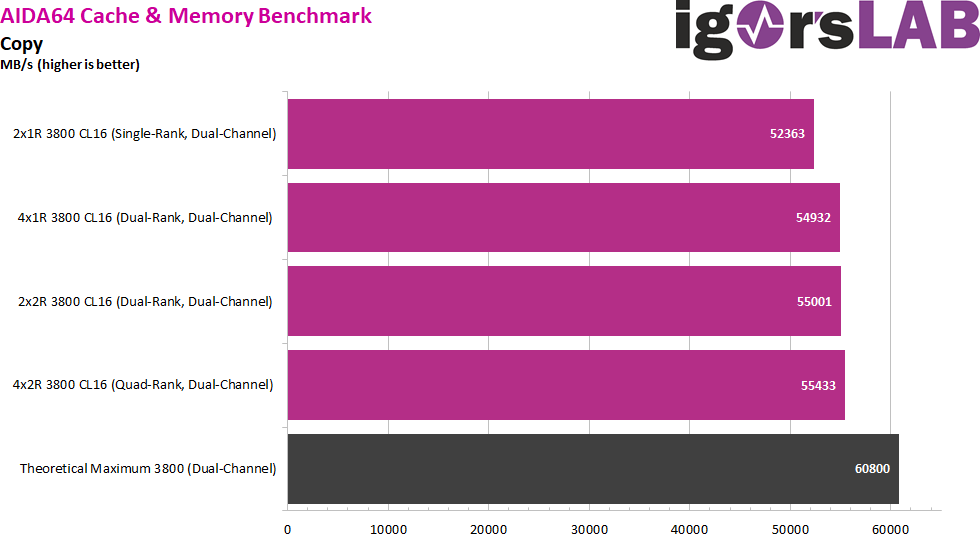

Genauso wichtig ist der wirkliche Anwendungsfall, für den man die Speicher-Übertaktung durchführt. Also im Grunde genommen, was will man damit erreichen? Da sich alle Anwendungen unterscheiden, wie sie CPU-Befehle und damit auch den Systemspeicher nutzen, reagieren einige empfindlicher auf eine Erhöhung der Bandbreite, während andere eher niedrigere Latenzen für eine bessere Leistung bevorzugen.

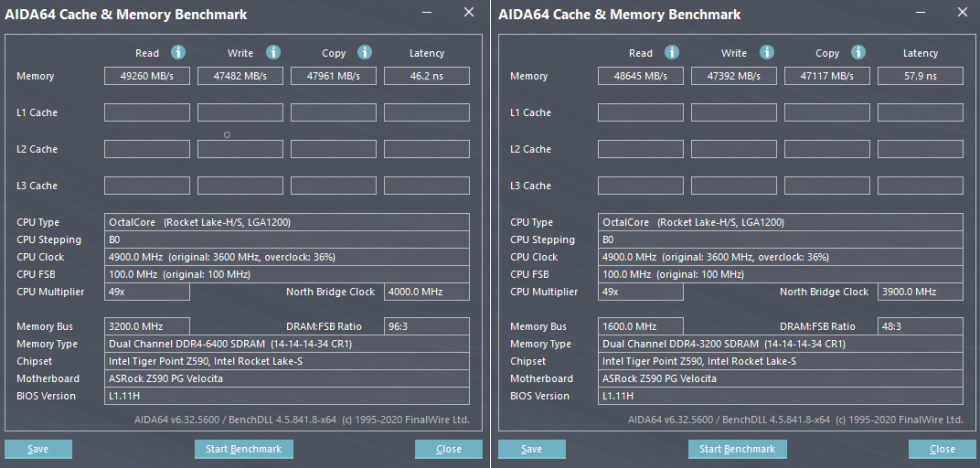

Synthetische Benchmarks, wie der AIDA64 Cache & Memory Benchmark oder der Geekbench 3 Multi-Core Memory Performance Score, den wir in unseren RAM-Kit-Tests verwenden, liefern lediglich einen groben Leistungsindikator. Man sollte daher auch immer die tatsächliche(n) Anwendung(en) testen, die man beschleunigen möchte. Das könnte bedeuten, dass man ein bestimmtes Projekt in Adobe Premiere oder Cinema 4D rendert oder einen bestimmten Teil eines Spiels spielt und dabei die FPS mit einem Tool wie FrameView aufzeichnet, um effektiv einen Benchmark zu haben, den man für Vorher/Nachher-Vergleiche nutzen kann.

Wie bereits erwähnt, skaliert die Leistung einiger Anwendungen nur mit der Bandbreite oder der Latenz, oder beidem. Und in anderen Fällen kann eine Erhöhung des Speichertaktes, während man einige Timings auf Auto belässt, dazu führen, dass diese Auto-Timings vom Mainboard viel zu locker eingestellt werden. Das wiederum kann dazu führen, dass man mit einer Übertaktung tatsächlich Bandbreiten- oder Latenz-Einbußen bewirkt. Daher sollte man, wie auch bei CPU- und GPU-Übertaktungen, immer einen Vorher-Testlauf in den Benchmarks durchführen, den gleichen Benchmark nach der Übertaktung laufen lassen und dann die beiden Ergebnisse vergleichen, um sicherzustellen, dass man nicht tatsächlich einen Rückschritt bei der Leistung gemacht hat.

63 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Veteran

Urgestein

Mitglied

Urgestein

Urgestein

Urgestein

Mitglied

Veteran

Urgestein

Mitglied

Urgestein

Mitglied

Urgestein

Urgestein

Urgestein

Urgestein

Mitglied

Veteran

Alle Kommentare lesen unter igor´sLAB Community →